Central limit theorem

확률 이론(probability theory)에서, 중심 극한 정리(central limit theorem 줄여서, CLT)는, 어떤 상황에서, 독립 확률 변수(independent random variables)가 더해질 때, 그들의 적절하게 정규화된 합은, 비록 원래 변수 자체는 정규적으로 분포되지 않더라도, 정규 분포(normal distribution) (비공식적으로 종 곡선(bell curve))로 향하는 경향임을 확증합니다. 그 이론은 확률 이론에서 핵심 개념인데 왜냐하면 그것은 정규 분포에 대해 작동하는 확률론적 및 통계론적 방법들이 분포의 다른 유형를 포함하는 많은 문제에 적용가능일 수 있음을 의미하기 때문입니다.

수학적으로, 만약 이 평균 과 유한 분산 을 갖는 모집단에서 취해진 크기 의 확률 표본(random sample)이면 및 만약 가 표본 평균이면, 의 분포의 극한하는 형식은, 일 때, 표준 정규 분포입니다.[1]

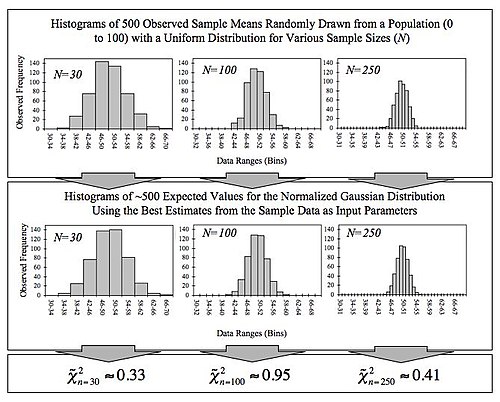

예를 들어, 표본(sample)이 많은 관측(observations)을 포함하는 것으로 얻어지고, 각 관측은 다른 관측의 값에 의존하지 않는 방법에서 무작위로 생성되고, 관측된 값의 산술 평균(arithmetic mean)이 계산된다고 가정합니다. 만약 이 과정이 여러 번 수행되면, 중앙 극한 정리는 평균의 확률 분포가 정규 분포(normal distribution)에 밀접하게 근사될 것임을 말합니다. 분포될 것이라고 말합니다. 이것의 간단한 예제는 만약 우리가 동전을 여러 번 던지면, 앞면의 주어진 숫자를 얻을 확률은, 던짐의 전체 숫자의 절반과 같은 평균을 갖는, 정규 분포로 접근할 것이라는 것입니다. 던짐의 무한 숫자의 극한에서, 그것은 정규 분포와 같을 것입니다.

중심 극한 정리는 여러 가지 변형을 가집니다. 그의 공통적인 형식에서, 확률 변수는 반드시 동일하게 분포되어야 합니다. 변이에서, 평균의 정규 분포로의 수렴은, 만약 그들이 특정 조건을 따르면, 비-동일 분포 또는 비-독립 관측에 대해 역시 발생합니다.

이 정리의 가장 초기 버전, 정규 분포(normal distribution)가 이항 분포(binomial distribution)에 대한 근사로 사용될 수 있는 것은 드 무아브르–라플라스 정리(de Moivre–Laplace theorem)입니다.

Independent sequences

Classical CLT

을 크기 의 확률 표본(random sample)—즉, 에 의해 주어진 기댓값(expected value)과 에 의해 주어진 유한 분산(variance)의 분포로부터 추출된 독립이고 동일하게 분포된(independent and identically distributed, 줄여서 i.i.d) 확률 변수의 수열로로 놓습니다. 우리는 이들 확률 변수의 다음 표본 평균(sample average)에 관심을 둡니다:

큰 숫자의 법칙(law of large numbers)에 의해, 표본 평균은 확률에서 수렴(converge in probability)하고 거의 확실하게(almost surely) 일 때 기댓값 로 수렴합니다. 고전적인 중심 극한 정리는 이 수렴 동안 결정론적 숫자 주위의 확률론적 변동의 크기와 분포 형식을 설명합니다. 보다 정확하게, 이 커져 갈수록, 표본 평균 과 그것의 극한 사이의 차이의 분포가, 인수 에 의해 곱해질 때 (즉 ), 평균 0과 분산 를 갖는 정규 분포(normal distribution)를 근사합니다. 충분하게 큰 n에 대해, 의 분포는 평균 및 분산 을 갖는 정규 분포에 접근합니다. 정리의 유용성은 의 분포가 개별 의 분포의 모양에 관계없이 정규성에 접근한다는 것입니다. 공식적으로, 그 정리는 다음과 같이 말할 수 있습니다:

린데베르그–리비(Lindeberg–Lévy) CLT. 가 와 를 갖는 i.i.d. 확률 변수의 수열로 가정합니다. 그런-다음 가 무한대로 접근할 때, 확률 변수 는 정규(normal) 로 분포에서 수렴(converge in distribution)합니다:[3]

경우 에서, 분포에서 수렴은 의 누적 분포 함수(cumulative distribution function)는 분포의 cdf로 점별 수렴함을 의미합니다: 모든 각 실수 에 대해,

여기서 는 에서 평가된 표준 정규 cdf입니다. 수렴은 다음인 의미에서 에서 균등입니다:

여기서 는 집합의 최소 위쪽 경계 (또는 상한(supremum))을 나타냅니다.[4]

Lyapunov CLT

그 정리는 러시아 수학자 알렉산드르 랴푸노프(Aleksandr Lyapunov)의 이름을 따서 지어졌습니다. 중심 극한 정리의 이 변형에서, 확률 변수 는 반드시 독립이어야 하지만 필연적으로 동일하게 분포될 필요는 없습니다. 그 정리는 역시 확률 변수 는 일부 차수 의 모멘트(moment)를 가지는 것, 및 이들 모멘트의 증가율은 아래에 주어진 랴푸노프 조건에 의해 제한되는 것이 요구합니다.

랴푸노프 CLT.[5] 가 독립 확률 변수이며, 각각은 유한 기댓값 과 분산 을 가지는 것으로 가정합니다. 다음을 정의합니다:

만약 일부 에 대해, 랴푸노프의 조건

은 만족시켜지면, 의 합은 가 무한대로 갈 때 분포에서 표준 정규 확률 변수로 수렴합니다:

실제에서, 에 대해 랴루노프의 조건을 확인하는 것이 보통 가장 쉽습니다.

만약 확률 변수의 수열이 랴푸노프의 조건을 만족시키면, 그것은 역시 린데베르그의 조건을 만족시킵니다. 역 의미는, 어쨌든, 유지되지 않습니다.

Lindeberg CLT

위에서 처럼 같은 설정에서 및 같은 표기법과 함께, 랴푸노프 조건은 (1920년 린데베르그(Lindeberg)로부터) 다음의 더 약한 조건으로 대체될 수 있습니다.

모든 각 에 대해 다음임을 가정합니다:

여기서 는 지시 함수(indicator function)입니다. 그런-다음 표준화된 합

의 분포는 표준 정규 분포 를 향해 수렴합니다.

Multidimensional CLT

특성 함수를 사용하는 증명은 각 개별 가 평균 벡터 과 (벡터의 성분 사이의) 공분산 행렬(covariance matrix) 을 갖는 에서 확률 벡터(random vector)이고, 이들 확률 벡터가 독립이고 동일하게 분포되는 경우로 확장될 수 있습니다. 이들 벡터의 합은 성분-별로 행해집니다. 다차원 중심 극한 정리는 스케일될 때, 합이 다변수 정규 분포(multivariate normal distribution)로 수렴한다고 말합니다.[6]

다음을 k-벡터로 놓습니다:

- .

에서 굵은 글씨는 그것이 확률 벡터이지만, (일변수) 확률 변수가 아님을 의미합니다. 그런-다음 확률 벡터의 합(sum)은 다음일 것입니다:

그리고 평균은 다음입니다:

따라서

다변수 중심 극한 정리는 다음임을 말합니다:

여기서 공분산 행렬(covariance matrix) 은 다음과 같습니다:

수렴의 율은 다음 베리–에센(Berry–Esseen) 유형 결과에 의해 제공됩니다:

정리.[7] 를, 각각이 평균 영을 가지는, 독립 -값 확률 벡터로 놓습니다. 로 쓰고 가 역-가능임을 가정합니다. 를 같은 평균 로 공분산을 갖는 -차원 가우시안으로 놓습니다. 그런-다음 모든 볼록 집합 에 대해,

여기서 는 범용 상수, 이고, 는 위에 유클리드 노름을 나타냅니다.

인수 가 필요한지 여부는 알 수 없습니다. [8]

Generalized theorem

중심 극한 정리는 유한 분산을 갖는 다수의 독립이고 동일하게 분포된 확률 변수의 합은 변수의 숫자가 증가할 때 정규 분포(normal distribution)를 따르는 경향임을 말합니다. 그네덴코(Gnedenko) 및 콜모고로프(Kolmogorov)로 인한 일반화는 로 감소하는 거듭제곱-법칙 꼬리 (파레티안 꼬리(Paretian tail)) 분포를 갖는 여러 확률 변수의 합은, 여기서 (및 따라서 무한 분산을 가지는), 피합수의 숫자가 증가함에 따라 안정 분포 로 경향일 것이라고 말합니다.[9][10] 만약 이면, 합은 2와 같은 안정성 매개-변수를 갖는 안정 분포(stable distribution), 즉 가우시안 분포로 수렴합니다.[11]

Dependent processes

CLT under weak dependence

독립, 동일하게 분포된 확률 변수의 수열의 유용한 일반화는 이산 시간에서 확률 과정을 혼합(mixing)하는 것입니다. "혼합"은, 대략, 일시적으로 서로 멀리 떨어진 확률 변수가 거의 독립이라는 것을 의미합니다. 혼합의 여러 종류는 인체-공학적 이론과 확률 이론에서 사용됩니다. 에 의해 정의된 (α-혼합이라고 불리는) 강한 혼합(strong mixing)을 참조하십시오. 여기서 은 소위 강한 혼합 계수(strong mixing coefficient)입니다.

강한 혼합 아래에서 중심 극한 정리의 단순화된 공식화는 다음입니다:[12]

정리. 가 정류적이고 을 갖는 -혼합 및 과 임을 가정합니다. 로 나타내면, 극한

이 존재하고, 만약 이면 는 분포에서 로 수렴합니다.

사실,

여기서 급수는 절대적으로 수렴합니다.

가정 는 절대 생략될 수 없는데, 왜냐하면 점근적 정규성은 에 대해 실패하며 여기서 는 또 다른 정류 수열(stationary sequence)이기 때문입니다.

그 정리의 더 강한 버전이 있습니다:[13] 가정 은 로 대체되고, 가정 은 다음으로 대체됩니다:

그러한 의 존재는 결론을 보장합니다. 혼합 조건 아래에서 극한 정리의 백과-사전적 처리에 대해 (Bradley 2007)을 참조하십시오.

Martingale difference CLT

정리. 마팅게일(martingale) 이 다음을 만족시키는 것으로 놓습니다:

- 분포에서 n → ∞일 때, ,

- 모든 각 ε > 0에 대해, n → ∞일 때, ,

주의: 제한된 기대(restricted expectation) 는 조건부 기대 와 절대 혼동해서는 안됩니다.

Remarks

Proof of classical CLT

중심 극한 정리는 특성 함수(characteristic functions)를 사용하여 간단한 증명을 가집니다.[16] 그것은 (약한) 큰 숫자의 법칙(law of large numbers)의 증명과 유사합니다.

가, 각각이 평균 및 유한 분산 을 갖는, 독립이고 동일하게 분포된 확률 변수로 가정합니다. 합 은 평균(mean) 및 분산(variance) 을 가집니다. 다음 확률 변수를 생각해 보십시오:

여기서 마지막 단계에서 우리는, 각각이 영 평균과 단위 분산 ()을 갖는, 새로운 확률 변수 를 정의했었습니다. 의 특성 함수(characteristic function)가 다음에 의해 제공됩니다:

여기서 마지막 단계에서 우리는 의 모두는 동일하게 분포된 것이라는 사실을 사용했었습니다. 의 특성 함수는, 테일러의 정리(Taylor's theorem)에 의해, 다음입니다:

여기서 는 보다 더 빠르게 영으로 가는 의 일부 함수에 대해 "작은 o 표기법(little o notation)"입니다. 지수 함수(exponential function)의 극한 ()에 대해, 의 특성 함수는 다음과 같습니다:

더 높은 차수 항의 모두는 극한 에서 사라집니다. 오른쪽 변은 표준 정규 분포 의 특성 함수와 같으며, 이것은 리비의 연속성 정리(Lévy's continuity theorem)를 통해 의 분포가 일 때 로 접근할 것임을 의미합니다. 그러므로, 합 은 정규 분포의 그것으로 접근할 것이고, 표본 평균(sample average)

은 정규 분포 로 수렴하며, 이것으로부터 중심 극한 정리가 따릅니다.

Convergence to the limit

중심 극한 정리는 오직 점근적 분포(asymptotic distribution)를 제공합니다. 관측의 유한 숫자에 대해 근사로써, 정규 분포의 피크에 가까울 때 오직 합리적인 근사를 제공합니다; 그것은 꼬리까지 확장하기 위한 관측의 매우 큰 숫자가 요구됩니다.[citation needed]

중심 극한 정리에서 수렴은 균등(uniform)인데 왜냐하면 극한하는 누적 분포 함수가 연속이기 때문입니다. 만약 세 번째 중심 모멘트(moment) 는 존재하고 유한하면, 수렴의 속력은 적어도 의 차수 위에 있습니다 (베리–에센 정리(Berry–Esseen theorem)를 참조하십시오). 스타인의 방법(Stein's method)은[17] 중심 극한 정리를 입증하기 위해서 뿐만 아니라, 선택된 메트릭에 대해 수렴의 율에 대한 경계를 제공하기 위해 사용될 수 있습니다.[18]

정규 분포에 대한 수렴은, 의 엔트로피(entropy)가 정규 분포의 엔트로피에 단조적으로(monotonically) 증가한다는 의미에서, 단조적입니다.[19]

중심 극한 정리는 특히 독립이고 동일하게 분포된 이산 확률 변수(discrete random variable)에 적용됩니다. 이산 확률 변수(discrete random variable)의 합은 여전히 이산 확률 변수(discrete random variable)이므로, 우리는 그의 누적 확률 분포 함수가 연속 변수 (즉, 정규 분포(normal distribution)의 그것)에 해당하는 누적 확률 분포 함수로 향해 수렴하는 이산 확률 변수(discrete random variable)의 수열에 직면합니다. 이것은 만약 우리가 n 독립적 동일한 이산 변수의 합의 실현의 히스토그램(histogram)을 구축하면, 히스토그램을 형성하는 직사각형의 위쪽 면의 중심을 연결하는 곡선이 n이 무한대에 접근함에 따라 가우시안 곡선을 향해 수렴한다는 것을 의미하며, 이 관계는 드 무아브르–라플라스 정리(de Moivre–Laplace theorem)로 알려져 있습니다. 이항 분포(binomial distribution) 기사는 오직 두 가능한 값을 취하는 이산 변수의 간단한 경우에서 중심 극한 정리의 그러한 적용을 자세히 설명합니다.

Relation to the law of large numbers

큰 숫자의 법칙(The law of large numbers)과 마찬가지로 중심 극한 정리는 일반적인 문제: "n이 무한대에 접근할 때, Sn의 극한하는 동작은 무엇입니까?"에 대한 부분 해입니다. 수학적 해석학에서, 점근적 급수(asymptotic series)는 그러한 질문에 접근하기 위해 사용된 가장 인기-있는 도구 중 하나입니다.

우리는 의 점근적 전개를 가짐을 가정합니다:

양쪽 부분을 φ1(n)으로 나누고 극한을 취하면 a1, 전개에서 최고-차수 항의 계수를 생성할 것이며, 이것은 f(n)이 그것의 선행 항에서 변화 율을 나타냅니다.

비공식적으로, 우리는 말할 수 있습니다: "f(n)는 근사적으로 a1φ1(n)로 성장합니다". f(n)와 그것의 근사 사이의 차이를 취하고 그런-다음 전개에서 그 다음 항으로 나누면, 우리는 f(n)에 대한 보다 정제된 명제에 도달합니다:

여기서 우리는 함수와 그것의 근사 사이의 차이가 근사적으로 a2φ2(n)로 성장한다고 말할 수 있습니다. 그 아이디어는 적절한 정규화하는 함수에 의해 함수를 나누고, 결과의 극한하는 동작을 살펴보면, 원래 함수 자체의 극한하는 동작에 대한 많은 것을 우리에게 말할 수 있는 것입니다.

비공식적으로, 어떤-것이 이들 직선들을 따라 독립적 동일하게 분포된 확률 변수 X1, …, Xn의 합 Sn이 고전적인 확률 이론에서 연구될 때 발생합니다.[citation needed] 만약 각 Xi가 유한 평균 μ를 가지면, 큰 숫자의 법칙에 의해, 입니다.[20] 만약 게다가 각 Xi가 유한 분산 σ2를 가지면, 중심 극한 정리에 의해,

여기서 ξ는 N(0,σ2)으로 분포됩니다. 이것은 비공식 전개에서 처음 두 상수의 값을 제공합니다:

Xi가 유한 평균 또는 분산을 가지지 않는 경우에서, 이동된 및 다시-스케일된 합의 수렴은 다른 중심화 및 스케일링 인수로 역시 발생할 수 있습니다:

또는 비공식적으로

이 방법에서 발생할 수 있는 분포 Ξ가 안정(stable)으로 불립니다.[21] 분명하게, 정규 분포는 안정이지만, 평균 또는 분산이 정의되지 않은 것에 대해, 코시 분포(Cauchy distribution)와 같은, 다른 안정 분포가 역시 있습니다. 스케일링 인수 bn은, 임의의 c ≥ 1/2에 대해, nc에 비례될 수 있습니다; 그것은 n의 천천히 변하는 함수(slowly varying function)를 역시 곱할 수 있습니다.[11][22]

반복 로그의 법칙(law of the iterated logarithm)은 큰 숫자의 법칙(law of large numbers)과 중심 극한 정리 "사이에서" 발생하는 것을 지정합니다. 구체적으로 특별히, 정규화하는 함수 √n log log n, 큰 숫자의 법칙의 n과 중심 극한 정리의 √n 사이의 크기에서 중간은 비-자명한 극한하는 동작을 제공한다고 말합니다.

Alternative statements of the theorem

Density functions

둘 이상의 독립 변수의 합의 밀도(density)는 (만약 이들 밀도가 존재하면) 그들의 밀도의 합성곱(convolution)입니다. 따라서 중심 극한 정리는 합성곱 아래에서 밀도 함수의 속성에 대한 명제로 해석될 수 있습니다: 밀도 함수의 숫자의 합성곱은 밀도 함수의 숫자가 경계없이 증가함에 따라 정규 밀도로 경향입니다. 이들 정리는 위에 주어진 중심 극한 정리의 형식보다 더 강한 가설을 요구합니다. 이 유형의 정리는 종종 지역 극한 정리로 불립니다. 독립이고 동일하게 분포된 확률 변수(independent and identically distributed random variables)의 합에 대해 특정 지역 극한 정리에 대해 페트로프(Petrov)를 참조하십시오.[23]

Characteristic functions

합성곱의 특성 함수(characteristic function)는 포함된 밀도의 특성 함수의 곱이므로, 중심 극한 정리는 또 다른 다시-설명을 여전히 가집니다: 밀도 함수의 숫자의 특성 함수의 곱은 밀도 함수의 숫자가 위에서 말했된 조건 아래에서 경계없이 증가함에 따라 정규 밀도의 특성 함수로 가깝게 됩니다. 구체적으로, 적절한 스케일링 인수는 특성 함수의 인수에 적용될 필요가 있습니다.

동등한 명제는 푸리에 변환(Fourier transform)에 대한 마들어질 수 있는데, 왜냐하면 특성 함수는 본질적으로 푸리에 변환이기 때문입니다.

Calculating the variance

Sn을 n 확률 변수의 합으로 놓습니다. 많은 중심 극한 정리는 Sn/√Var(Sn)이 n→ ∞일 때 분포에서 N(0,1) (평균 0, 분산 1을 갖는 정규 분포)로 수렴하는 것을 만족하는 조건을 제공합니다. 입부 경우에서, Sn/(σ√n⋅f(n))이 n→ ∞일 때 분포에서 N(0,1)로 수렴하는 것을 만족하는 상수 σ2와 함수 f(n)을 찾을 수 있습니다.

보조-정리.[24] 가 실수-값 및 모든 에 대해 를 갖는 엄격하게 정류 확률 변수의 수열이고, , 및 을 가정합니다. 다음을 구성합니다:

- 만약 가 절대적으로 수렴이고, , 및 이면, 일 때 이며 여기서 입니다.

- 만약 게다가 및 가 일 때 분포에서 로 수렴하면 는 일 때 분포에서 로 역시 수렴합니다.

Extensions

Products of positive random variables

곱의 로그(logarithm)는 인수의 로그의 단순한 합입니다. 그러므로, 오직 양수 값을 취하는 확률 변수의 곱의 로그가 정규 분포에 접근할 때, 곱 자체는 로그-정규 분포(log-normal distribution)에 접근합니다. 많은 물리량 (특히 질량 또는 길이, 이것은 규모의 문제이고 음수가 될 수 없음)은 다른 무작위(random) 인수의 곱이므로, 그들은 로그-정규 분포를 따릅니다. 중심 극한 정리의 이 곱셈 버전은 때때로 지브랏의 법칙(Gibrat's law)으로 불립니다.

확률 변수의 합에 대해 중심 극한 정리는 유한 분산의 조건을 요구하는 반면에, 곱에 대해 해당 정리는 밀도 함수가 제곱-적분가능이 되어야 하는 해당 조건을 요구합니다.[25]

Beyond the classical framework

점근적 정규성, 즉 적절한 이동 및 다시-스케일링 후 정규 분포에 수렴(convergence)은 위에서 다루어진 고전적 프레임워크, 즉, 독립 확률 변수 (또는 벡터)의 합보다 훨씬 더 일반적인 현상입니다. 새로운 프레임워크가 때때로 드러납니다; 단일 통합 프레임워크는 지금 유용하지 않습니다.

Convex body

정리. 수열 εn ↓ 0이 존재하며 이것에 대해 다음이 유지됩니다. n ≥ 1을 놓고, 확률 변수 X1, …, Xn이 모든 x1, …, xn에 대해 f(x1, …, xn) = f(|x1|, …, |xn|), 및 모든 k = 1, …, n에 대해 E(X2

k) = 1임을 만족하는 로그-오목(log-concave) 결합 밀도(joint density) f를 가지는 것으로 놓습니다. 그런-다음, 다음의 분포

는 전체 변화 거리(total variation distance)에서 N(0,1)에 εn-가깝습니다.[26]

이들 두 εn-가까운 분포는 밀도 (사실, 로그-오목 밀도)를 가지며, 따라서, 그들 사이의 전체 변화 거리는 밀도 사이의 차이의 절댓값의 적분입니다. 전체 변화에서 수렴은 약한 수렴보다 더 강합니다.

로그-오목 밀도의 중요한 예제는 주어진 볼록 몸체 안에서 상수이고 밖에서 사라지는 함수입니다; 그것은 볼록 몸체 위에 균등 분포에 해당하며, 이것은 용어 "복록 몸체에 대해 중심 극한 정리"를 설명합니다.

또 다른 예제: f(x1, …, xn) = const · exp( − (|x1|α + … + |xn|α)β)이며, 여기서 α > 1이고 αβ > 1입니다. 만약 β = 1이면, f(x1, …, xn)는 const · exp (−|x1|α) … exp(−|xn|α)로 인수화되며, 이것은 X1, …, Xn가 독립임을 의미합니다. 일반적으로, 어쨌든, 그들은 종속입니다.

조건 f(x1, …, xn) = f(|x1|, …, |xn|)은, X1, …, Xn가 영의 평균과 비-상관(uncorrelated);[citation needed] 여전히, 그들은 독립이 필요가 없거나, 심지어 쌍별 독립(pairwise independent)이 필요도 없음을 보장합니다.[citation needed] 그 방법에 의해, 쌍별 독립은 고전적 중심 극한 정리에서 독립을 절대 대체하지 못합니다.[27]

여기서 하나의 베리–에센(Berry–Esseen)유형 결과입니다.

정리. X1, …, Xn는 이전 정리의 가정을 만족시키는 것으로 놓습니다. 그런-다음, 모든 a < b에 대해, [28]

여기서 C는 보편 (절대) 상수입니다. 게다가, 모든 각 c1, …, cn ∈ ℝ에 대해, c2

1 + … + c2

n = 1을 만족하는,

X1 + … + Xn/√n의 분포는 근사적으로 정규일 필요는 없습니다 (사실, 그것은 균등일 수 있습니다).[29] 어쨌든, c1X1 + … + cnXn의 분포는 구 c2

1 + … + c2

n = 1 위에 균등 분포를 따르는 최대 벡터 (c1, …, cn)에 대해 (전체 변화 거리에서) N(0,1)에 가까워집니다.

Lacunary trigonometric series

정리 (살렘(Salem)–지그문트(Zygmund)): U를 (0,2π) 위에 균등하게 분포된 확률 변수로 놓고, Xk = rk cos(nkU + ak), 여기서

- nk는 라쿠내러티 조건을 만족시킵니다: 모든 k에 대해 nk + 1 ≥ qnk을 만족하는 q > 1가 존재합니다,

- rk가 다음을 만족합니다:

- 0 ≤ ak < 2π.

는 분포에서 N(0, 1/2)로 수렴합니다.

Gaussian polytopes

정리: A1, …, An를 각각 이-차원 표준 정규 분포를 갖는 평면 ℝ2 위의 독립 확률 점으로 놓습니다. Kn을 이들 점의 볼록 껍질(convex hull)로 놓고, Xn을 Kn의 넓이로 놓습니다. 그런-다음[32]

는 n이 무한대로 경향일 때 분포에서 N(0,1)으로 수렴합니다.

같은 것은 2보다 큰 모든 차원에서 역시 유지됩니다.

폴리토프(polytope) Kn는 가우시안 확률 폴리토프라고 불립니다.

비슷한 결과는 (가우시안 폴리토프의) 꼭짓점의 숫자, 가장자리의 숫자, 및 사실, 모든 차원의 면의 숫자에 대해 유지됩니다.[33]

Linear functions of orthogonal matrices

행렬 M의 선형 함수는 (주어진 계수를 가진) 그의 원소의 선형 조합, M ↦ tr(AM)이며 여기서 A는 계수의 행렬입니다; 안의 곱(inner product)을 참조하십시오.

확률 직교 행렬(orthogonal matrix)은, 만약 그의 분포가 직교 그룹(orthogonal group) O(n,ℝ) 위의 정규화된 하르 측정(Haar measure)이면, 균등하게 분포된 것이라고 말합니다; 균등 확률 회전 행렬을 참조하십시오.

정리. M를 균등하게 분포된 확률 직교 n × n 행렬, 및 A를 tr(AA*) = n를 만족하는 고정된 n × n 행렬로 놓고, 및 X = tr(AM)를 놓습니다. 그런-다음[34] X의 분포는 전체 변화 메트릭에서 2√3/n − 1까지[clarification needed] N(0,1)로 가까워집니다.

Subsequences

정리. 확률 변수 X1, X2, … ∈ L2(Ω)를 L2(Ω)에서 약하게(weakly) Xn → 0 및 L1(Ω)에서 약하게 X

n → 1를 만족하는 것으로 놓습니다. 그런-다음

가 k가 무한대로 경향일 때 분포에서 N(0,1)로 수렴하는 것을 만족하는 정수 n1 < n2 < …이 존재합니다.[35]

Random walk on a crystal lattice

중심 극한 정리는 결정 격자 (유한 그래프에 걸쳐 무한-겹 아벨 덮는 그래프) 위에 간단한 무작위 걸음(random walk)에 대해 확립될 수 있고, 결정 구조의 설계에 대해 사용됩니다. [36][37]

Applications and examples

Simple example

중심 극한 정리의 간단한 예제는 많은 동일하고, 불-편향 주사위를 굴리는 것입니다. 굴려진 숫자의 합 (또는 평균)의 분포는 정규 분포에 의해 잘 근사화될 것입니다. 실-세계 양은 종종 많은 비-관찰된 확률 사건의 균형-잡힌 합이므로, 중심 극한 정리는 정규 확률 분포의 널리-퍼짐에 대해 부분적인 설명을 역시 제공합니다. 또한 제어된 실험에서 큰-표본 통계량(statistic)의 정규 분포에 대한 근사를 정당화합니다.

Real applications

출판된 문헌은 중심 극한 정리와 관련된 많은 유용하고 흥미로운 예제와 응용을 포함합니다.[38] 한 출처는[39] 다음 예제를 말합니다:

- (편향된 또는 불-편향된) 무작위 걸음(random walk)에서 전체 거리에 대해 확률 분포는 정규 분포(normal distribution)로 향햐는 경향일 것입니다.

- 많은 동전을 던지면 앞면의 전체 숫자 (또는 동등하게 뒷면의 전체 숫자)에 대해 정규 분포를 초래합니다.

또 다른 관점에서, 중심 극한 정리는 실-세계 데이터에 적용된 밀도 추정(density estimates)에서 "종 곡선"의 공통 모양을 설명합니다. 전자 노이즈, 시험 등급, 등과 같은 경우에서, 우리는 단일 측정된 값을 많은 작은 효과의 가중된 평균으로 종종 여길 수 있습니다. 중심 극한 정리의 일반화를 사용하면, 우리는 그런-다음 이것이 종종 (항상 그런 것은 아니지만) 근사적으로 정규인 분포를 생성한다는 것을 알 수 있습니다.

일반적으로, 더 많은 측정이 결과에 같은 영향을 미치는 독립 변수의 합과 같을수록, 더 많은 정규성이 나타납니다. 이것은 선형 모델(linear model)과 같은 모형에서 비-관측된 변수의 효과에 대해 나타내기 위해 이 분포의 공통 사용을 정당화합니다.

Regression

회귀 분석(regression analysis) 및 특히 보통 최소 제곱(ordinary least squares)은 종속 변수(dependent variable)가 일부 함수에 따라 추가적인 오차 항(error term)과 함께 하나 이상의 독립 변수(independent variable)에 의존 함을 지정합니다. 회귀에 대한 통계적 추론의 다양한 유형은 오차 항이 정규적으로 분포됨을 가정합니다. 이 가정은 오차 항이 실제로 많은 독립된 오차 항의 합이라고 가정함으로써 정당화될 수 있습니다; 심지어 개별적인 오차 항이 정규적으로 분포되지 않을지라도, 중심 극한 정리에 의해 그들의 합은 정규 분포에 의해 잘 근사화될 수 있습니다.

Other illustrations

통계에 대한 중요성이 주어지면, 여러 논문과 컴퓨터 패키지가 중심 극한 정리에서 수렴을 시연하는 것에 유효합니다.[40]

History

네덜란드 수학자 행크 쟁스(Henk Tijms)는 씁니다:[41]

중심 극한 정리는 흥미로운 역사를 가집니다. 이 정리의 첫 번째 버전은 프랑스-태어난 수학자 아브라암 드 무아브르(Abraham de Moivre)에 의해 추정되었으며, 그는, 1733년에 출판된 주목할 만한 기사에서, 공정한 동전의 많은 던짐으로부터 발생한 앞면의 숫자의 분포를 근사하기 위해 정규 분포를 사용했습니다. 이 발견은 그 시대보다 훨씬 앞서 있었고, 유명한 프랑스의 수학자 피에르-시몽 라플라스(Pierre-Simon Laplace)가 1812년에 출판된 그의 기념비적 연구 Théorie analytique des probabilités에서 그것을 모호서으로부터 구제하기 전까지 거의 잊혀졌습니다. 라플라스는 정규 분포를 갖는 이항 분포를 근사화함으로써 드 무아브로의 발견을 확장했습니다. 그러나 드 무아브로와 마찬가지로, 라플라스의 발견은 그 당시 거의 주목받지 못했습니다. 1901년에 러시아 수학자 알렉산드르 랴푸노프(Aleksandr Lyapunov)가 그것을 일반 용어로 정의했고 그것이 수학적으로 어떻게 작용했는지를 정확히 입증했을 때, 19세기가 되어서야 중심 극한 정리의 중요성이 분별되었습니다. 요즘, 중심 극한 정리는 확률 이론의 비공식적 통치자인 것으로 여겨집니다.

프랜시스 골턴(Francis Galton) 경은 이 방법에서 중심 극한 정리를 설명했습니다:[42]

나는 "오차의 빈도의 법칙(Law of Frequency of Error)"에 의해 표현된 훌륭한 형태의 우주 질서로서 상상력에 깊은 인상을 줄만한 것이 거의 없다는 것을 알고 있습니다. 그 법칙은 그리스인에 의해 의인화되어 왔고, 만약 그들이 그것을 알고 있었다면, 신격화되었을 것입니다. 그것은 가장 혼란스러운 가운데, 평온과 완전한 자기-말소로 통치합니다. 폭도가 클수록, 및 명백한 무정부 상태가 클수록, 그것의 흔들림이 점점 완벽해집니다. 그것은 불합리한 최고의 법칙입니다. 혼란스러운 원소의 큰 표본이 손으로 취해지고 그들의 크기의 순서대로 정렬될 때마다, 규칙성의 의심스럽지 않고 가장 아름다운 형식은 모두 함께 잠복되어 온 것으로 입증됩니다.

실제 용어 "중심 극한 정리" (독일어: "zentraler Grenzwertsatz")는 논문의 제목에서 1920년에 조지 폴리아(George Pólya)에 의해 처음 사용되었습니다.[43][44] 폴리아는 확률 이론에서 그것의 중요성으로 인해 정리를 "중심"으로 참조했습니다. 르 캠(Le Cam)에 따르면, 프랑스 확률 학교는 단어 중심을 "그것이 꼬리와 반대로 분포의 중심의 동작을 설명합니다"는 의미에서 해석합니다.[44] 논문 On the central limit theorem of calculus of probability and the problem of moments의 개요는 1920년에 폴리아에 의해 다음과 같이 번역됩니다.[43]

반복된 실험에서 가우시안 확률 밀도 1 = e−x2의 발생은, 측정의 오차에서, 이것은 매우 많고 매우 작은 원소 오차의 조합을 초래하며, 확산 과정 등에서, 확률의 미적분학에서 중심 역할을 하는, 매우 같은 극한의 정리에 의해, 잘-알려졌던 것처럼, 설명될 수 있습니다. 이 한계 정리의 실제 발견자는 라플라스입니다; 엄격한 증명은 체이비셰프(Tschebyscheff)에 의해 처음 제공되었고, 그것의 가장 날카로운 공시고하는, 내가 아는 한, 리아비나프(Liapounoff)의 기사에서 찾아질 수 있다는 가능성이 높습니다. ...

라플라스의 기본 연구뿐만 아니라, 코시(Cauchy), 베셀(Bessel) 및 푸아송(Poisson)의 공헌의 세부-묘사하는, 정리의 역사에 대한 철저한 설명은 헬(Hald)에 의해 제공됩니다.[45] 두 역사적 평가, 라플라스에서 코시로의 발전을 다루는 하나, 1920년대 동안 폰 미제스(von Mises), 폴리아(Pólya), 린데베르그(Lindeberg), 리비(Lévy), 크라메르(Cramér)에 의한 기여의 두 번째는 한스 피셔(Hans Fischer)에 의해 제공됩니다.[46] 르 캠(Le Cam)은 1935년경의 기간을 설명합니다.[44] 베른슈타인(Bernstein)은[47] 일반적인 설정에서 CLT의 첫 번째 증명으로 이어졌던, 패스너리 체비쇼프(Pafnuty Chebyshev)와 그의 학생 안드레이 마르코프(Andrey Markov)와 알렉산드르 랴푸노프(Aleksandr Lyapunov)의 연구에 중점을 둔 역사적 토론을 제시합니다.

1930년대를 통해, 점진적으로 중심 극한 정리의 보다 일반적인 증명이 제시되었습니다. 많은 자연스러운 시스템이 가우시안 분포(Gaussian distributions)를 나타내는 것으로 밝혀졌습니다—전형적인 예제는 인간에 대해 키 분포입니다. 분산의 해석과 같은 통계적 방법이 1900년대 초에 확립되었을 때, 놓여-있는 가우시안 분포를 가정하는 것이 점차 보편화되었습니다.[48]

중심 극한 정리의 역사에 대한 흥미로운 각주는 1922년에 린데베르그 CLT와 비슷한 결과의 증명은 케임브리지 대학교(University of Cambridge)에서 킹스 칼리지(King's College)에 대해 앨런 튜링(Alan Turing)의 1934 Fellowship Dissertation의 주제였었다는 것입니다. 단지 연구를 제출한 후에야 튜링은 그것이 이미 입증되었음을 알게 되었습니다. 결과적으로, 튜링의 논문은 출판되지 않았습니다.[49][50][51]

See also

- Asymptotic equipartition property

- Asymptotic distribution

- Bates distribution

- Benford's law – Result of extension of CLT to product of random variables.

- Berry–Esseen theorem

- Central limit theorem for directional statistics – Central limit theorem applied to the case of directional statistics

- Delta method – to compute the limit distribution of a function of a random variable.

- Erdős–Kac theorem – connects the number of prime factors of an integer with the normal probability distribution

- Fisher–Tippett–Gnedenko theorem – limit theorem for extremum values (such as max{Xn})

- Irwin–Hall distribution

- Markov chain central limit theorem

- Normal distribution

- Tweedie convergence theorem – A theorem that can be considered to bridge between the central limit theorem and the Poisson convergence theorem[52]

Notes

- ^ Montgomery, Douglas C.; Runger, George C. (2014). Applied Statistics and Probability for Engineers (6th ed.). Wiley. p. 241. ISBN 9781118539712.

- ^ Rouaud, Mathieu (2013). Probability, Statistics and Estimation (PDF). p. 10.

- ^ Billingsley (1995, p. 357)

- ^ Bauer (2001, Theorem 30.13, p.199)

- ^ Billingsley (1995, p.362)

- ^ Van der Vaart, A. W. (1998). Asymptotic statistics. New York: Cambridge University Press. ISBN 978-0-521-49603-2. LCCN 98015176.

- ^ Ryan O’Donnell (2014, Theorem 5.38) http://www.contrib.andrew.cmu.edu/~ryanod/?p=866

- ^ Bentkus, V. (2005). "A Lyapunov-type Bound in ". Theory Probab. Appl. 49 (2): 311–323. doi:10.1137/S0040585X97981123.

- ^ Voit, Johannes (2003). "Section 5.4.3". The Statistical Mechanics of Financial Markets. Texts and Monographs in Physics. Springer-Verlag. ISBN 3-540-00978-7.

{{cite book}}: External link in|chapterurl=|chapterurl=ignored (|chapter-url=suggested) (help) - ^ Gnedenko, B. V.; Kolmogorov, A. N. (1954). Limit distributions for sums of independent random variables. Cambridge: Addison-Wesley.

- ^ a b Uchaikin, Vladimir V.; Zolotarev, V. M. (1999). Chance and stability: stable distributions and their applications. VSP. pp. 61–62. ISBN 90-6764-301-7.

- ^ Billingsley (1995, Theorem 27.5)

- ^ Durrett (2004, Sect. 7.7(c), Theorem 7.8)

- ^ Durrett (2004, Sect. 7.7, Theorem 7.4)

- ^ Billingsley (1995, Theorem 35.12)

- ^ "An Introduction to Stochastic Processes in Physics". jhupbooks.press.jhu.edu. Retrieved 2016-08-11.

- ^ Stein, C. (1972). "A bound for the error in the normal approximation to the distribution of a sum of dependent random variables". Proceedings of the Sixth Berkeley Symposium on Mathematical Statistics and Probability: 583–602. MR 0402873. Zbl 0278.60026.

- ^ Chen, L. H. Y.; Goldstein, L.; Shao, Q. M. (2011). Normal approximation by Stein's method. Springer. ISBN 978-3-642-15006-7.

- ^ Artstein, S.; Ball, K.; Barthe, F.; Naor, A. (2004), "Solution of Shannon's Problem on the Monotonicity of Entropy", Journal of the American Mathematical Society, 17 (4): 975–982, doi:10.1090/S0894-0347-04-00459-X

- ^ Rosenthal, Jeffrey Seth (2000). A First Look at Rigorous Probability Theory. World Scientific. Theorem 5.3.4, p. 47. ISBN 981-02-4322-7.

- ^ Johnson, Oliver Thomas (2004). Information Theory and the Central Limit Theorem. Imperial College Press. p. 88. ISBN 1-86094-473-6.

- ^ Borodin, A. N.; Ibragimov, I. A.; Sudakov, V. N. (1995). Limit Theorems for Functionals of Random Walks. AMS Bookstore. Theorem 1.1, p. 8. ISBN 0-8218-0438-3.

- ^ Petrov, V. V. (1976). Sums of Independent Random Variables. New York-Heidelberg: Springer-Verlag. ch. 7. ISBN 9783642658099.

- ^ Hew, Patrick Chisan (2017). "Asymptotic distribution of rewards accumulated by alternating renewal processes". Statistics and Probability Letters. 129: 355–359. doi:10.1016/j.spl.2017.06.027.

- ^ Rempala, G.; Wesolowski, J. (2002). "Asymptotics of products of sums and U-statistics" (PDF). Electronic Communications in Probability. 7: 47–54. doi:10.1214/ecp.v7-1046.

- ^ Klartag (2007, Theorem 1.2)

- ^ Durrett (2004, Section 2.4, Example 4.5)

- ^ Klartag (2008, Theorem 1)

- ^ Klartag (2007, Theorem 1.1)

- ^ Zygmund, Antoni (2003) [1959]. Trigonometric Series. Cambridge University Press. vol. II, sect. XVI.5, Theorem 5-5. ISBN 0-521-89053-5.

- ^ Gaposhkin (1966, Theorem 2.1.13)

- ^ Bárány & Vu (2007, Theorem 1.1)

- ^ Bárány & Vu (2007, Theorem 1.2)

- ^ Meckes, Elizabeth (2008). "Linear functions on the classical matrix groups". Transactions of the American Mathematical Society. 360 (10): 5355–5366. arXiv:math/0509441. doi:10.1090/S0002-9947-08-04444-9.

- ^ Gaposhkin (1966, Sect. 1.5)

- ^ Kotani, M.; Sunada, Toshikazu (2003). Spectral geometry of crystal lattices. Vol. 338. Contemporary Math. pp. 271–305. ISBN 978-0-8218-4269-0.

- ^ Sunada, Toshikazu (2012). Topological Crystallography – With a View Towards Discrete Geometric Analysis. Surveys and Tutorials in the Applied Mathematical Sciences. Vol. 6. Springer. ISBN 978-4-431-54177-6.

- ^ Dinov, Christou & Sánchez (2008)

- ^ "SOCR EduMaterials Activities GCLT Applications - Socr". Wiki.stat.ucla.edu. 2010-05-24. Retrieved 2017-01-23.

- ^ Marasinghe, M.; Meeker, W.; Cook, D.; Shin, T. S. (Aug 1994). "Using graphics and simulation to teach statistical concepts". Paper presented at the Annual meeting of the American Statistician Association, Toronto, Canada.

{{cite journal}}: Cite journal requires|journal=(help) - ^ Henk, Tijms (2004). Understanding Probability: Chance Rules in Everyday Life. Cambridge: Cambridge University Press. p. 169. ISBN 0-521-54036-4.

- ^ Galton, F. (1889). Natural Inheritance. p. 66.

- ^ a b Pólya, George (1920). "Über den zentralen Grenzwertsatz der Wahrscheinlichkeitsrechnung und das Momentenproblem" [On the central limit theorem of probability calculation and the problem of moments]. Mathematische Zeitschrift (in German). 8 (3–4): 171–181. doi:10.1007/BF01206525.

- ^ a b c Le Cam, Lucien (1986). "The central limit theorem around 1935". Statistical Science. 1 (1): 78–91. doi:10.1214/ss/1177013818.

- ^ Hald, Andreas (22 April 1998). A History of Mathematical Statistics from 1750 to 1930 (PDF). chapter 17. ISBN 978-0471179122.

{{cite book}}:|website=ignored (help) - ^ Fischer, Hans (2011). A History of the Central Limit Theorem: From Classical to Modern Probability Theory. Sources and Studies in the History of Mathematics and Physical Sciences. New York: Springer. doi:10.1007/978-0-387-87857-7. ISBN 978-0-387-87856-0. MR 2743162. Zbl 1226.60004. (Chapter 2: The Central Limit Theorem from Laplace to Cauchy: Changes in Stochastic Objectives and in Analytical Methods, Chapter 5.2: The Central Limit Theorem in the Twenties)

- ^ Bernstein, S. N. (1945). "On the work of P. L. Chebyshev in Probability Theory". In Bernstein., S. N. (ed.). Nauchnoe Nasledie P. L. Chebysheva. Vypusk Pervyi: Matematika [The Scientific Legacy of P. L. Chebyshev. Part I: Mathematics] (in Russian). Moscow & Leningrad: Academiya Nauk SSSR. p. 174.

- ^ Wolfram, Stephen (2002). A New Kind of Science. Wolfram Media, Inc. p. 977. ISBN 1-57955-008-8.

- ^ Hodges, Andrew (1983). Alan Turing: The Enigma. London: Burnett Books. pp. 87–88. ISBN 0091521300.

- ^ Zabell, S. L. (2005). Symmetry and Its Discontents: Essays on the History of Inductive Probability. Cambridge University Press. p. 199. ISBN 0-521-44470-5.

- ^ Aldrich, John (2009). "England and Continental Probability in the Inter-War Years". Electronic Journ@l for History of Probability and Statistics. 5 (2). Section 3.

- ^ Jørgensen, Bent (1997). The Theory of Dispersion Models. Chapman & Hall. ISBN 978-0412997112.

References

- Bárány, Imre; Vu, Van (2007). "Central limit theorems for Gaussian polytopes". Annals of Probability. 35 (4). Institute of Mathematical Statistics: 1593–1621. arXiv:math/0610192. doi:10.1214/009117906000000791.

- Bauer, Heinz (2001). Measure and Integration Theory. Berlin: de Gruyter. ISBN 3110167190.

- Billingsley, Patrick (1995). Probability and Measure (3rd ed.). John Wiley & Sons. ISBN 0-471-00710-2.

- Bradley, Richard (2007). Introduction to Strong Mixing Conditions (1st ed.). Heber City, UT: Kendrick Press. ISBN 978-0-9740427-9-4.

- Bradley, Richard (2005). "Basic Properties of Strong Mixing Conditions. A Survey and Some Open Questions". Probability Surveys. 2: 107–144. arXiv:math/0511078v1. Bibcode:2005math.....11078B. doi:10.1214/154957805100000104.

- Dinov, Ivo; Christou, Nicolas; Sanchez, Juana (2008). "Central Limit Theorem: New SOCR Applet and Demonstration Activity". Journal of Statistics Education. 16 (2). ASA: 1–15. doi:10.1080/10691898.2008.11889560. PMC 3152447. PMID 21833159.

- Durrett, Richard (2004). Probability: theory and examples (3rd ed.). Cambridge University Press. ISBN 0521765390.

- Gaposhkin, V. F. (1966). "Lacunary series and independent functions". Russian Mathematical Surveys. 21 (6): 1–82. Bibcode:1966RuMaS..21....1G. doi:10.1070/RM1966v021n06ABEH001196..

- Klartag, Bo'az (2007). "A central limit theorem for convex sets". Inventiones Mathematicae. 168 (1): 91–131. arXiv:math/0605014. Bibcode:2007InMat.168...91K. doi:10.1007/s00222-006-0028-8.

- Klartag, Bo'az (2008). "A Berry–Esseen type inequality for convex bodies with an unconditional basis". Probability Theory and Related Fields. 145 (1–2): 1–33. arXiv:0705.0832. doi:10.1007/s00440-008-0158-6.

External links

- Simplified, step-by-step explanation of the classical Central Limit Theorem. with histograms at every step.

- Hands-on explanation of the Central Limit Theorem in tutorial videos from Khan Academy, with many examples

- interactive HTML5 simulation of coin flips (random walk)

- "Central limit theorem", Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- Animated examples of the CLT

- Central Limit Theorem interactive simulation to experiment with various parameters

- CLT in NetLogo (Connected Probability — ProbLab) interactive simulation with a variety of modifiable parameters

- General Central Limit Theorem Activity & corresponding SOCR CLT Applet (Select the Sampling Distribution CLT Experiment from the drop-down list of SOCR Experiments)

- Generate sampling distributions in Excel Specify arbitrary population, sample size, and sample statistic.

- MIT OpenCourseWare Lecture 18.440 Probability and Random Variables, Spring 2011, Scott Sheffield Another proof. Retrieved 2012-04-08.

- CAUSEweb.org is a site with many resources for teaching statistics including the Central Limit Theorem

- The Central Limit Theorem by Chris Boucher, Wolfram Demonstrations Project.

- Weisstein, Eric W. "Central Limit Theorem". MathWorld.

- Animations for the Central Limit Theorem by Yihui Xie using the R package animation

- Teaching demonstrations of the CLT: clt.examp function in Greg Snow (2012). TeachingDemos: Demonstrations for teaching and learning. R package version 2.8.

{{cite book}}: Invalid|ref=harv(help)

![{\textstyle \operatorname {E} [X_{i}]=\mu }](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/d082ebbd867f0f4ce516f94ed63380cf91ab8133)

![{\textstyle \operatorname {Var} [X_{i}]=\sigma ^{2}<\infty }](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/448bb57a7caae2db8c4c5bf94d9672bfe71fb9b2)

![{\displaystyle \lim _{n\to \infty }\Pr \left[{\sqrt {n}}(S_{n}-\mu )\leq z\right]=\lim _{n\to \infty }\Pr \left[{\frac {{\sqrt {n}}(S_{n}-\mu )}{\sigma }}\leq {\frac {z}{\sigma }}\right]=\Phi \left({\frac {z}{\sigma }}\right),}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/83a801cf702964b95eddee02bcaa145f87d15f55)

![{\displaystyle \lim _{n\to \infty }\sup _{z\in \mathbb {R} }\left|\Pr \left[{\sqrt {n}}(S_{n}-\mu )\leq z\right]-\Phi \left({\frac {z}{\sigma }}\right)\right|=0,}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/02364627f20fa84d3eba4b485f22882fc213429d)

![{\displaystyle \lim _{n\to \infty }{\frac {1}{s_{n}^{2+\delta }}}\sum _{i=1}^{n}\operatorname {E} \left[|X_{i}-\mu _{i}|^{2+\delta }\right]=0}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/64a80682a2f914ca295442b230135678d17e6e85)

![{\displaystyle \lim _{n\to \infty }{\frac {1}{s_{n}^{2}}}\sum _{i=1}^{n}\operatorname {E} \left[(X_{i}-\mu _{i})^{2}\cdot \mathbf {1} _{\{|X_{i}-\mu _{i}|>\varepsilon s_{n}\}}\right]=0}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/81bdf0b807c0c79e7b42654e68b7ea059da0138a)

![{\textstyle \mu =\operatorname {E} [\mathbf {X} _{i}]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/784662418f2656cda4e51b53d3914e71e439984d)

![{\displaystyle {\begin{bmatrix}X_{1(1)}\\\vdots \\X_{1(k)}\end{bmatrix}}+{\begin{bmatrix}X_{2(1)}\\\vdots \\X_{2(k)}\end{bmatrix}}+\cdots +{\begin{bmatrix}X_{n(1)}\\\vdots \\X_{n(k)}\end{bmatrix}}={\begin{bmatrix}\sum _{i=1}^{n}\left[X_{i(1)}\right]\\\vdots \\\sum _{i=1}^{n}\left[X_{i(k)}\right]\end{bmatrix}}=\sum _{i=1}^{n}\mathbf {X} _{i}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/e0aec2e3895f5d517973d01b48f22a9ae94296cc)

![{\displaystyle {\frac {1}{\sqrt {n}}}\sum _{i=1}^{n}\left[\mathbf {X} _{i}-\operatorname {E} \left(X_{i}\right)\right]={\frac {1}{\sqrt {n}}}\sum _{i=1}^{n}(\mathbf {X} _{i}-{\boldsymbol {\mu }})={\sqrt {n}}\left({\overline {\mathbf {X} }}_{n}-{\boldsymbol {\mu }}\right).}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/2b067e19df49fc0ddd515403c26c067497427ae9)

![{\displaystyle \Sigma =\operatorname {Cov} [S]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/6bbdd46ff8928b02fc4e37a7fc14c51ceaf58b40)

![{\displaystyle |\Pr[S\in U]-\Pr[Z\in U]|\leq Cd^{1/4}\gamma ,}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/48a6517ee5c99419e50d573239a44d9953794c93)

![{\displaystyle \gamma =\sum _{i=1}^{n}\operatorname {E} [\|\Sigma ^{-1/2}X_{i}\|_{2}^{3}]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/d40f0fd02779da5c01af151f10da7ad18ed35b56)

![{\textstyle \operatorname {E} [X_{n}]=0}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/d12315de3945900a1cdcca84088a0f562e93d042)

![{\textstyle \operatorname {E} [{X_{n}}^{12}]<\infty }](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/b290a0d05d376ff21698340af4db22488236db19)

![{\textstyle \operatorname {E} [{\vert X_{n}\vert }^{2+\delta }]<\infty }](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/c259aed523895ea246521aa770b370825933d68b)

![{\textstyle \operatorname {E} [X;A]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/30535e6a5e00b31c839efa1f45ff668158c594c2)

![{\textstyle \operatorname {E} [X\mid A]={\frac {\operatorname {E} [X;A]}{\mathbf {P} (A)}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/607dab14b454b0c333c4f1fb7b710d9a6c018581)

![{\displaystyle \varphi _{Z_{n}}\!(t)\ =\ \varphi _{\sum _{i=1}^{n}{{\frac {1}{\sqrt {n}}}Y_{i}}}\!(t)\ =\ \varphi _{Y_{1}}\!\!\left({\frac {t}{\sqrt {n}}}\right)\varphi _{Y_{2}}\!\!\left({\frac {t}{\sqrt {n}}}\right)\cdots \varphi _{Y_{n}}\!\!\left({\frac {t}{\sqrt {n}}}\right)\ =\ \left[\varphi _{Y_{1}}\!\!\left({\frac {t}{\sqrt {n}}}\right)\right]^{n},}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/eb5414e4f2854c6513fe3f54ea1987075e4d3cbf)

![{\textstyle \operatorname {E} [(X_{1}-\mu )^{3}]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/3e348083758a31fcc591bb580f1cef19d7de44c7)

![{\displaystyle g:[0,1]\rightarrow \mathbb {R} }](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/837ea8d988b7bec8098c295a80e2ce60721574c8)