Example of samples from two populations with the same mean but different variances. The red population has mean 100 and variance 100 (SD=10) while the blue population has mean 100 and variance 2500 (SD=50). 확률 이론(probability theory) 과 통계학(statistics) 에서, 분산 (variance )은 그의 평균(mean) 으로부터 확률 변수 의 제곱된 편차(deviation) 의 기대(expectation) 입니다. 비공식적으로, 그것은 (무작위) 숫자의 집합이 그들의 평균값으로부터 얼마나 멀리 퍼져 나가는지를 측정합니다. 분산은 통계에 중추적인 역할을 가지며, 여기서 그것을 사용하는 일부 아이디어는 기술 통계학(descriptive statistics) , 통계적 추론(statistical inference) , 가설 테스팅(hypothesis testing) , 적합성(goodness of fit) , 및 몬테 카를로 표본화(Monte Carlo sampling) 를 포함합니다. 분산은 과학에서 중요한 도구이며, 여기서 데이터의 통계적 해석이 공통적입니다. 분산은 표준 편차(standard deviation) , 분포의 두 번째 중심 모멘트(central moment) , 및 그 자체를 가진 확률 변수의 공분산(covariance) 의 제곱이고, 그것은

σ

2

{\displaystyle \sigma ^{2}}

s

2

{\displaystyle s^{2}}

Var

(

X

)

{\displaystyle \operatorname {Var} (X)}

Definition 확률 변수

X

{\displaystyle X}

X

{\displaystyle X}

평균(mean) ,

μ

=

E

[

X

]

{\displaystyle \mu =\operatorname {E} [X]}

기댓값(expected value) 입니다:

Var

(

X

)

=

E

[

(

X

−

μ

)

2

]

.

{\displaystyle \operatorname {Var} (X)=\operatorname {E} \left[(X-\mu )^{2}\right].}

이 정의는 이산(discrete) , 연속(continuous) , 둘 다 아닌 것(neither) , 혼합인 프로세스에 의해 생성되는 확률 변수를 포함합니다. 분산은 역시 그 자체를 가진 확률 변수의 공분산으로 생각될 수 있습니다:

Var

(

X

)

=

Cov

(

X

,

X

)

.

{\displaystyle \operatorname {Var} (X)=\operatorname {Cov} (X,X).}

분산은

X

{\displaystyle X}

누적(cumulant) 과 역시 동등합니다. 분산은 전형적으로

Var

(

X

)

{\displaystyle \operatorname {Var} (X)}

σ

X

2

{\displaystyle \sigma _{X}^{2}}

σ

2

{\displaystyle \sigma ^{2}}

시그마(sigma) 제곱"으로 발음함)으로 지정됩니다. 분산에 대해 표현은 다음으로 확장될 수 있습니다:

Var

(

X

)

=

E

[

(

X

−

E

[

X

]

)

2

]

=

E

[

X

2

−

2

X

E

[

X

]

+

E

[

X

]

2

]

=

E

[

X

2

]

−

2

E

[

X

]

E

[

X

]

+

E

[

X

]

2

=

E

[

X

2

]

−

E

[

X

]

2

{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} \left[(X-\operatorname {E} [X])^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}-2X\operatorname {E} [X]+\operatorname {E} [X]^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}\right]-2\operatorname {E} [X]\operatorname {E} [X]+\operatorname {E} [X]^{2}\\[4pt]&=\operatorname {E} \left[X^{2}\right]-\operatorname {E} [X]^{2}\end{aligned}}}

달리 말해서, X 의 분산은 X 의 제곱의 평균에서 X 의 평균의 제곱을 뺀 값과 같습니다. 이 방정식은 부동 소수점 산술(floating point arithmetic) 을 사용하여 계산에 절대 사용되어서는 안되는데, 왜냐하면 만약 방정식의 두 성분이 크기에서 비슷하면 치명적 취소(catastrophic cancellation) 를 겪기 때문입니다. 수치적으로 안정적인 대안들(numerically stable alternatives) 이 존재합니다.

Discrete random variable 만약

X

{\displaystyle X}

확률 질량 함수(probability mass function)

x

1

↦

p

1

,

x

2

↦

p

2

,

…

,

x

n

↦

p

n

{\displaystyle x_{1}\mapsto p_{1},x_{2}\mapsto p_{2},\ldots ,x_{n}\mapsto p_{n}}

이산(discrete) 이면

Var

(

X

)

=

∑

i

=

1

n

p

i

⋅

(

x

i

−

μ

)

2

,

{\displaystyle \operatorname {Var} (X)=\sum _{i=1}^{n}p_{i}\cdot (x_{i}-\mu )^{2},}

또는 동등하게

Var

(

X

)

=

(

∑

i

=

1

n

p

i

x

i

2

)

−

μ

2

,

{\displaystyle \operatorname {Var} (X)=\left(\sum _{i=1}^{n}p_{i}x_{i}^{2}\right)-\mu ^{2},}

여기서

μ

{\displaystyle \mu }

μ

=

∑

i

=

1

n

p

i

x

i

.

{\displaystyle \mu =\sum _{i=1}^{n}p_{i}x_{i}.}

(그러한 이산 가중된 분산(weighted variance) 이 그의 합이 1이 아닌 가중값에 의해 지정될 때, 우리는 가중값의 합으로 나눕니다.)

n

{\displaystyle n}

Var

(

X

)

=

1

n

∑

i

=

1

n

(

x

i

−

μ

)

2

,

{\displaystyle \operatorname {Var} (X)={\frac {1}{n}}\sum _{i=1}^{n}(x_{i}-\mu )^{2},}

여기서

μ

{\displaystyle \mu }

μ

=

1

n

∑

i

=

1

n

x

i

.

{\displaystyle \mu ={\frac {1}{n}}\sum _{i=1}^{n}x_{i}.}

n

{\displaystyle n}

[1]

Var

(

X

)

=

1

n

2

∑

i

=

1

n

∑

j

=

1

n

1

2

(

x

i

−

x

j

)

2

=

1

n

2

∑

i

∑

j

>

i

(

x

i

−

x

j

)

2

.

{\displaystyle \operatorname {Var} (X)={\frac {1}{n^{2}}}\sum _{i=1}^{n}\sum _{j=1}^{n}{\frac {1}{2}}(x_{i}-x_{j})^{2}={\frac {1}{n^{2}}}\sum _{i}\sum _{j>i}(x_{i}-x_{j})^{2}.}

Absolutely continuous random variable 만약 확률 변수

X

{\displaystyle X}

확률 밀도 함수(probability density function)

f

(

x

)

{\displaystyle f(x)}

F

(

x

)

{\displaystyle F(x)}

누적 분포 함수(cumulative distribution function) 이면,

Var

(

X

)

=

σ

2

=

∫

R

(

x

−

μ

)

2

f

(

x

)

d

x

=

∫

R

x

2

f

(

x

)

d

x

−

2

μ

∫

R

x

f

(

x

)

d

x

+

∫

R

μ

2

f

(

x

)

d

x

=

∫

R

x

2

d

F

(

x

)

−

2

μ

∫

R

x

d

F

(

x

)

+

μ

2

∫

R

d

F

(

x

)

=

∫

R

x

2

d

F

(

x

)

−

2

μ

⋅

μ

+

μ

2

⋅

1

=

∫

R

x

2

d

F

(

x

)

−

μ

2

,

{\displaystyle {\begin{aligned}\operatorname {Var} (X)=\sigma ^{2}&=\int _{\mathbb {R} }(x-\mu )^{2}f(x)\,dx\\[4pt]&=\int _{\mathbb {R} }x^{2}f(x)\,dx-2\mu \int _{\mathbb {R} }xf(x)\,dx+\int _{\mathbb {R} }\mu ^{2}f(x)\,dx\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-2\mu \int _{\mathbb {R} }x\,dF(x)+\mu ^{2}\int _{\mathbb {R} }\,dF(x)\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-2\mu \cdot \mu +\mu ^{2}\cdot 1\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-\mu ^{2},\end{aligned}}}

또는 동등하게,

Var

(

X

)

=

∫

R

x

2

f

(

x

)

d

x

−

μ

2

,

{\displaystyle \operatorname {Var} (X)=\int _{\mathbb {R} }x^{2}f(x)\,dx-\mu ^{2},}

여기서

μ

{\displaystyle \mu }

X

{\displaystyle X}

μ

=

∫

R

x

f

(

x

)

d

x

=

∫

R

x

d

F

(

x

)

.

{\displaystyle \mu =\int _{\mathbb {R} }xf(x)\,dx=\int _{\mathbb {R} }x\,dF(x).}

이들 공식에서,

d

x

{\displaystyle dx}

d

F

(

x

)

{\displaystyle dF(x)}

르베그(Lebesgue) 및 르베그–스틸티어스(Lebesgue–Stieltjes) 적분입니다.

만약 함수

x

2

f

(

x

)

{\displaystyle x^{2}f(x)}

[

a

,

b

]

⊂

R

{\displaystyle [a,b]\subset \mathbb {R} }

리만-적분가능(Riemann-integrable) 이면,

Var

(

X

)

=

∫

−

∞

+

∞

x

2

f

(

x

)

d

x

−

μ

2

,

{\displaystyle \operatorname {Var} (X)=\int _{-\infty }^{+\infty }x^{2}f(x)\,dx-\mu ^{2},}

여기서 적분은 부적절한 리만 적분(improper Riemann integral) 입니다.

Examples Exponential distribution 매개변수 λ 를 가진 지수 분포(exponential distribution) 는 그의 확률 밀도 함수(probability density function) 가 구간 [0, ∞) 위에서 다음으로 제공되는 연속 분포입니다:

f

(

x

)

=

λ

e

−

λ

x

{\displaystyle f(x)=\lambda e^{-\lambda x}}

그의 평균은 다음으로 표현될 수 있습니다:

E

[

X

]

=

∫

0

∞

λ

x

e

−

λ

x

d

x

=

1

λ

.

{\displaystyle \operatorname {E} [X]=\int _{0}^{\infty }\lambda xe^{-\lambda x}\,dx={\frac {1}{\lambda }}.}

부분에 의한 적분(integration by parts) 을 사용하고 이미 계산된 기댓값을 사용함으로써:

E

[

X

2

]

=

∫

0

∞

λ

x

2

e

−

λ

x

d

x

=

[

−

x

2

e

−

λ

x

]

0

∞

+

∫

0

∞

2

x

e

−

λ

x

d

x

=

0

+

2

λ

E

[

X

]

=

2

λ

2

.

{\displaystyle {\begin{aligned}\operatorname {E} [X^{2}]&=\int _{0}^{\infty }\lambda x^{2}e^{-\lambda x}\,dx\\&=\left[-x^{2}e^{-\lambda x}\right]_{0}^{\infty }+\int _{0}^{\infty }2xe^{-\lambda x}\,dx\\&=0+{\frac {2}{\lambda }}\operatorname {E} [X]\\&={\frac {2}{\lambda ^{2}}}.\end{aligned}}}

따라서, X 의 적분은 다음으로 제공됩니다:

Var

(

X

)

=

E

[

X

2

]

−

E

[

X

]

2

=

2

λ

2

−

(

1

λ

)

2

=

1

λ

2

.

{\displaystyle \operatorname {Var} (X)=\operatorname {E} [X^{2}]-\operatorname {E} [X]^{2}={\frac {2}{\lambda ^{2}}}-\left({\frac {1}{\lambda }}\right)^{2}={\frac {1}{\lambda ^{2}}}.}

Fair die 공정한 육-면체 주사위 는, 각각 같은 확률 1/6을 가진, 1에서 6까지의 결과를 가진, 이산 확률 변수, X 로 모델링될 수 있습니다. X 의 기댓값은

(

1

+

2

+

3

+

4

+

5

+

6

)

/

6

=

7

/

2

{\displaystyle (1+2+3+4+5+6)/6=7/2}

X 의 분산은 다음입니다:

Var

(

X

)

=

∑

i

=

1

6

1

6

(

i

−

7

2

)

2

=

1

6

(

(

−

5

/

2

)

2

+

(

−

3

/

2

)

2

+

(

−

1

/

2

)

2

+

(

1

/

2

)

2

+

(

3

/

2

)

2

+

(

5

/

2

)

2

)

=

35

12

≈

2.92.

{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\sum _{i=1}^{6}{\frac {1}{6}}\left(i-{\frac {7}{2}}\right)^{2}\\[5pt]&={\frac {1}{6}}\left((-5/2)^{2}+(-3/2)^{2}+(-1/2)^{2}+(1/2)^{2}+(3/2)^{2}+(5/2)^{2}\right)\\[5pt]&={\frac {35}{12}}\approx 2.92.\end{aligned}}}

n -면체X 의 분산에 대해 일반적인 공식은 다음입니다:

Var

(

X

)

=

E

(

X

2

)

−

(

E

(

X

)

)

2

=

1

n

∑

i

=

1

n

i

2

−

(

1

n

∑

i

=

1

n

i

)

2

=

(

n

+

1

)

(

2

n

+

1

)

6

−

(

n

+

1

2

)

2

=

n

2

−

1

12

.

{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} (X^{2})-(\operatorname {E} (X))^{2}\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}i^{2}-\left({\frac {1}{n}}\sum _{i=1}^{n}i\right)^{2}\\[5pt]&={\frac {(n+1)(2n+1)}{6}}-\left({\frac {n+1}{2}}\right)^{2}\\[4pt]&={\frac {n^{2}-1}{12}}.\end{aligned}}}

Commonly used probability distributions 다음 테이블은 일부 공통적으로 사용되는 확률 분포에 대해 분산을 목록화한 것입니다.

확률 분포의 이름

확률 분포 함수

평균

분산

이항 분포(Binomial distribution)

Pr

(

X

=

k

)

=

(

n

k

)

p

k

(

1

−

p

)

n

−

k

{\displaystyle \Pr \,(X=k)={\binom {n}{k}}p^{k}(1-p)^{n-k}}

n

p

{\displaystyle np}

n

p

(

1

−

p

)

{\displaystyle np(1-p)}

기하 분포(Geometric distribution)

Pr

(

X

=

k

)

=

(

1

−

p

)

k

−

1

p

{\displaystyle \Pr \,(X=k)=(1-p)^{k-1}p}

1

p

{\displaystyle {\frac {1}{p}}}

(

1

−

p

)

p

2

{\displaystyle {\frac {(1-p)}{p^{2}}}}

정규 분포(Normal distribution)

f

(

x

∣

μ

,

σ

2

)

=

1

2

π

σ

2

e

−

(

x

−

μ

)

2

2

σ

2

{\displaystyle f(x\mid \mu ,\sigma ^{2})={\frac {1}{\sqrt {2\pi \sigma ^{2}}}}e^{-{\frac {(x-\mu )^{2}}{2\sigma ^{2}}}}}

μ

{\displaystyle \mu }

σ

2

{\displaystyle \sigma ^{2}}

균등 분포(uniform distribution)

f

(

x

∣

a

,

b

)

=

{

1

b

−

a

f

o

r

a

≤

x

≤

b

,

0

f

o

r

x

<

a

o

r

x

>

b

{\displaystyle f(x\mid a,b)={\begin{cases}{\frac {1}{b-a}}&\mathrm {for} \ a\leq x\leq b,\\[8pt]0&\mathrm {for} \ x<a\ \mathrm {or} \ x>b\end{cases}}}

a

+

b

2

{\displaystyle {\frac {a+b}{2}}}

(

b

−

a

)

2

12

{\displaystyle {\frac {(b-a)^{2}}{12}}}

지수 분포(Exponential distribution)

f

(

x

∣

λ

)

=

λ

e

−

λ

x

{\displaystyle f(x\mid \lambda )=\lambda e^{-\lambda x}}

1

λ

{\displaystyle {\frac {1}{\lambda }}}

1

λ

2

{\displaystyle {\frac {1}{\lambda ^{2}}}}

Properties Basic properties 분산은 비-음수인데 왜냐하면 제곱은 양수 또는 영이기 때문입니다:

Var

(

X

)

≥

0.

{\displaystyle \operatorname {Var} (X)\geq 0.}

상수의 분산은 영입니다:

Var

(

a

)

=

0.

{\displaystyle \operatorname {Var} (a)=0.}

만약 확률 변수의 분산이 영이면, 그것은 상수입니다. 즉, 그것은 항상 같은 값을 가집니다:

Var

(

X

)

=

0

⟺

∃

a

:

P

(

X

=

a

)

=

1.

{\displaystyle \operatorname {Var} (X)=0\iff \exists a:P(X=a)=1.}

분산은 위치 매개변수(location parameter) 에서 변화의 관점에서 불변(invariant) 입니다. 즉, 만약 상수가 변수의 모든 값에 더해지면, 분산은 변경되지 않습니다:

Var

(

X

+

a

)

=

Var

(

X

)

.

{\displaystyle \operatorname {Var} (X+a)=\operatorname {Var} (X).}

만약 모든 값이 상수에 의해 스케일되면, 분산은 그 상수의 제곱으로 스케일됩니다:

Var

(

a

X

)

=

a

2

Var

(

X

)

.

{\displaystyle \operatorname {Var} (aX)=a^{2}\operatorname {Var} (X).}

두 확률 변수의 합의 분산은 다음으로 제공됩니다:

Var

(

a

X

+

b

Y

)

=

a

2

Var

(

X

)

+

b

2

Var

(

Y

)

+

2

a

b

Cov

(

X

,

Y

)

,

{\displaystyle \operatorname {Var} (aX+bY)=a^{2}\operatorname {Var} (X)+b^{2}\operatorname {Var} (Y)+2ab\,\operatorname {Cov} (X,Y),}

Var

(

a

X

−

b

Y

)

=

a

2

Var

(

X

)

+

b

2

Var

(

Y

)

−

2

a

b

Cov

(

X

,

Y

)

,

{\displaystyle \operatorname {Var} (aX-bY)=a^{2}\operatorname {Var} (X)+b^{2}\operatorname {Var} (Y)-2ab\,\operatorname {Cov} (X,Y),}

여기서

Cov

(

X

,

Y

)

{\displaystyle \operatorname {Cov} (X,Y)}

공분산(covariance) 입니다.

일반적으로 우리는

N

{\displaystyle N}

{

X

1

,

…

,

X

N

}

{\displaystyle \{X_{1},\dots ,X_{N}\}}

Var

(

∑

i

=

1

N

X

i

)

=

∑

i

,

j

=

1

N

Cov

(

X

i

,

X

j

)

=

∑

i

=

1

N

Var

(

X

i

)

+

∑

i

≠

j

Cov

(

X

i

,

X

j

)

.

{\displaystyle \operatorname {Var} \left(\sum _{i=1}^{N}X_{i}\right)=\sum _{i,j=1}^{N}\operatorname {Cov} (X_{i},X_{j})=\sum _{i=1}^{N}\operatorname {Var} (X_{i})+\sum _{i\neq j}\operatorname {Cov} (X_{i},X_{j}).}

이들 결과는 다음으로 선형 조합(linear combination) 의 분산으로 이어집니다:

Var

(

∑

i

=

1

N

a

i

X

i

)

=

∑

i

,

j

=

1

N

a

i

a

j

Cov

(

X

i

,

X

j

)

=

∑

i

=

1

N

a

i

2

Var

(

X

i

)

+

∑

i

≠

j

a

i

a

j

Cov

(

X

i

,

X

j

)

=

∑

i

=

1

N

a

i

2

Var

(

X

i

)

+

2

∑

1

≤

i

<

j

≤

N

a

i

a

j

Cov

(

X

i

,

X

j

)

.

{\displaystyle {\begin{aligned}\operatorname {Var} \left(\sum _{i=1}^{N}a_{i}X_{i}\right)&=\sum _{i,j=1}^{N}a_{i}a_{j}\operatorname {Cov} (X_{i},X_{j})\\&=\sum _{i=1}^{N}a_{i}^{2}\operatorname {Var} (X_{i})+\sum _{i\not =j}a_{i}a_{j}\operatorname {Cov} (X_{i},X_{j})\\&=\sum _{i=1}^{N}a_{i}^{2}\operatorname {Var} (X_{i})+2\sum _{1\leq i<j\leq N}a_{i}a_{j}\operatorname {Cov} (X_{i},X_{j}).\end{aligned}}}

만약 확률 변수

X

1

,

…

,

X

N

{\displaystyle X_{1},\dots ,X_{N}}

Cov

(

X

i

,

X

j

)

=

0

,

∀

(

i

≠

j

)

,

{\displaystyle \operatorname {Cov} (X_{i},X_{j})=0\ ,\ \forall \ (i\neq j),}

그것들은 비-상관(uncorrelated) 이라고 말합니다. 그것은 이전에 제공된 표현으로부터 즉시 따르는데, 만약 확률 변수

X

1

,

…

,

X

N

{\displaystyle X_{1},\dots ,X_{N}}

Var

(

∑

i

=

1

N

X

i

)

=

∑

i

=

1

N

Var

(

X

i

)

.

{\displaystyle \operatorname {Var} \left(\sum _{i=1}^{N}X_{i}\right)=\sum _{i=1}^{N}\operatorname {Var} (X_{i}).}

독립 확률 변수는 항상 비-상관(independent random variables are always uncorrelated) 이므로, 위의 방정식은 특히 확률 변수

X

1

,

…

,

X

n

{\displaystyle X_{1},\dots ,X_{n}}

Issues of finiteness 만약, 분포가, 코시 분포(Cauchy distribution) 에 대해 경우에서 처럼, 유한 기댓값을 가지지 않으면, 분산은 어느 쪽도 절대 유한일 수 없습니다. 어쨌든, 일부 분포는, 그들 기댓값이 유한임에도 불구하고, 유한 분산을 가지지 않을 수 있습니다. 예제는 그의 인덱스(index)

k

{\displaystyle k}

1

<

k

≤

2

{\displaystyle 1<k\leq 2}

파레토 분포(Pareto distribution) 입니다.

Sum of uncorrelated variables (Bienaymé formula) 흩어짐의 다른 측정에 대한 선호에서 분산의 사용에 대해 한 가지 이유는 비-상관(uncorrelated) 확률 변수의 합 (또는 차이)의 분산이 그들 분산의 합이기 때문입니다:

Var

(

∑

i

=

1

n

X

i

)

=

∑

i

=

1

n

Var

(

X

i

)

.

{\displaystyle \operatorname {Var} \left(\sum _{i=1}^{n}X_{i}\right)=\sum _{i=1}^{n}\operatorname {Var} (X_{i}).}

이 명제는 비아내메(Bienaymé) 공식[2] [3] [4] 독립(independent) 이지만, 비-상관에 충분한 것인 더 강한 조건을 종종 만듭니다. 그래서 만약 모든 변수가 같은 분산 σ2 을 가지면, n 에 의한 나눗셈은 선형 변환이며, 이 공식은 바로 그들의 평균의 분산이 다음임을 의미합니다:

Var

(

X

¯

)

=

Var

(

1

n

∑

i

=

1

n

X

i

)

=

1

n

2

∑

i

=

1

n

Var

(

X

i

)

=

1

n

2

n

σ

2

=

σ

2

n

.

{\displaystyle \operatorname {Var} \left({\overline {X}}\right)=\operatorname {Var} \left({\frac {1}{n}}\sum _{i=1}^{n}X_{i}\right)={\frac {1}{n^{2}}}\sum _{i=1}^{n}\operatorname {Var} \left(X_{i}\right)={\frac {1}{n^{2}}}n\sigma ^{2}={\frac {\sigma ^{2}}{n}}.}

즉, 평균의 분산이 n 이 증가할 때 감소합니다. 평균의 분산에 대해 이 공식은 중심 극한 정리(central limit theorem) 에 사용되는 표본 평균의 표준 오차(standard error) 의 정의에 사용됩니다.

초기 명제를 입증하기 위해, 그것은 다음임을 보이는 것으로 충분합니다:

Var

(

X

+

Y

)

=

Var

(

X

)

+

Var

(

Y

)

.

{\displaystyle \operatorname {Var} (X+Y)=\operatorname {Var} (X)+\operatorname {Var} (Y).}

일반적인 결과는 그런-다음 귀납법에 의해 따릅니다. 정의로부터 시작하면,

Var

(

X

+

Y

)

=

E

[

(

X

+

Y

)

2

]

−

(

E

[

X

+

Y

]

)

2

=

E

[

X

2

+

2

X

Y

+

Y

2

]

−

(

E

[

X

]

+

E

[

Y

]

)

2

.

{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} [(X+Y)^{2}]-(\operatorname {E} [X+Y])^{2}\\[5pt]&=\operatorname {E} [X^{2}+2XY+Y^{2}]-(\operatorname {E} [X]+\operatorname {E} [Y])^{2}.\end{aligned}}}

기대 연산자의 선형성과 X 와 Y 의 독립성 (또는 비-상관성)의 가정을 사용하면, 이것은 다음으로 더 단순화됩니다:

Var

(

X

+

Y

)

=

E

[

X

2

]

+

2

E

[

X

Y

]

+

E

[

Y

2

]

−

(

E

[

X

]

2

+

2

E

[

X

]

E

[

Y

]

+

E

[

Y

]

2

)

=

E

[

X

2

]

+

E

[

Y

2

]

−

E

[

X

]

2

−

E

[

Y

]

2

=

Var

(

X

)

+

Var

(

Y

)

.

{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} [X^{2}]+2\operatorname {E} [XY]+\operatorname {E} [Y^{2}]-(\operatorname {E} [X]^{2}+2\operatorname {E} [X]\operatorname {E} [Y]+\operatorname {E} [Y]^{2})\\[5pt]&=\operatorname {E} [X^{2}]+\operatorname {E} [Y^{2}]-\operatorname {E} [X]^{2}-\operatorname {E} [Y]^{2}\\[5pt]&=\operatorname {Var} (X)+\operatorname {Var} (Y).\end{aligned}}}

Sum of correlated variables With correlation and fixed sample size 일반적으로 n 변수의 합의 분산은 그들의 공분산(covariance) 의 합입니다:

Var

(

∑

i

=

1

n

X

i

)

=

∑

i

=

1

n

∑

j

=

1

n

Cov

(

X

i

,

X

j

)

=

∑

i

=

1

n

Var

(

X

i

)

+

2

∑

1

≤

i

<

j

≤

n

Cov

(

X

i

,

X

j

)

.

{\displaystyle \operatorname {Var} \left(\sum _{i=1}^{n}X_{i}\right)=\sum _{i=1}^{n}\sum _{j=1}^{n}\operatorname {Cov} (X_{i},X_{j})=\sum _{i=1}^{n}\operatorname {Var} (X_{i})+2\sum _{1\leq i<j\leq n}\operatorname {Cov} (X_{i},X_{j}).}

(주목: 두 번째 상등은 Cov(X i X i X i 라는 사실에서 비롯됩니다.)

여기서

Cov

(

X

i

,

X

j

)

{\displaystyle \operatorname {Cov} (X_{i},X_{j})}

공분산(covariance) 이며, 이것은 (만약 그것이 존재하면) 독립 확률 변수에 대해 영입니다. 공식은 합의 분산이 성분의 공분산 행렬에서 모든 원소의 합과 같음을 말합니다. 다음 표현은 합의 분산이 공분산 행렬의 대각 원소의 합에 그의 높은 삼각 원소 (또는 낮은 삼각 원소)의 합의 두 배를 더한 것임을 동등하게 말합니다; 이것은 공분산 행렬이 대칭임을 강조합니다. 이 공식은 고전적 테스트 이론(classical test theory) 에서 크론바흐의 알파(Cronbach's alpha) 의 이론에서 사용됩니다.

그래서 만약 변수가 같은 분산 σ 2 을 가지고 구별되는 변수의 평균 상관(correlation) 이 ρ 이면 그들의 평균의 분산은 다음입니다:

Var

(

X

¯

)

=

σ

2

n

+

n

−

1

n

ρ

σ

2

.

{\displaystyle \operatorname {Var} ({\overline {X}})={\frac {\sigma ^{2}}{n}}+{\frac {n-1}{n}}\rho \sigma ^{2}.}

이것은 평균의 분산이 상관의 평균에 함께 증가함을 의미합니다. 다시 말해서, 추가적인 상관 관측은 평균의 불확실성(uncertainty of the mean) 을 줄이는 것에서 추가적인 독립 관측만큼 효과적이지 않습니다. 게다가, 만약 변수가 단위 분산을 가지면, 예를 들어 만약 그들이 표준화되면, 이것은 다음으로 단순화됩니다:

Var

(

X

¯

)

=

1

n

+

n

−

1

n

ρ

.

{\displaystyle \operatorname {Var} ({\overline {X}})={\frac {1}{n}}+{\frac {n-1}{n}}\rho .}

이 공식은 고전적 테스트 이론의 스피어만–브라운 예측 공식(Spearman–Brown prediction formula) 에서 사용됩니다. 이것은, 평균 상관이 상수로 유지 또는 역시 수렴하는 것으로 제공되고, 만약 n 이 무한대로 가면, ρ 로 수렴합니다. 그래서 같은 상관 또는 수렴하는 평균 상관을 갖는 표준화된 변수의 평균의 분산에 대해 우리는 다음을 가집니다:

lim

n

→

∞

Var

(

X

¯

)

=

ρ

.

{\displaystyle \lim _{n\to \infty }\operatorname {Var} ({\overline {X}})=\rho .}

그러므로, 표준화된 변수의 큰 숫자의 평균의 분산은 그들의 평균 상관과 근사적으로 같습니다. 이것은, 비록 큰 숫자의 법칙(law of large numbers) 이 표본 평균이 독립 변수에 대해 수렴할 것이라고 말할지라도, 상관된 변수의 표본 평균이 일반적으로 모집단 평균에 수렴하지 않음을 분명하게 합니다.

I.i.d. with random sample size표본이 지식없이 취할 때, 나아가서, 일부 기준에 따라 얼마나 많은 관찰이 수용될 수 있을지 같은 경우가 있습니다. 그러한 경우에서, 표본 크기 N X

Var(∑X ) = E(N )Var(X ) + Var(N )E2 (X ) .[5] 만약 N 푸아송 분포 (Poisson distribution )N =nE(N ) = Var(N ) 입니다. 따라서, Var(∑X ) 의 추정량은 다음을 제공하는

n

S

X

2

+

n

X

¯

2

{\displaystyle nS_{X}^{2}+n{\bar {X}}^{2}}

표준 오차(standard error)

(

X

¯

)

=

S

X

2

+

X

¯

2

n

{\displaystyle ({\bar {X}})={\sqrt {\frac {S_{X}^{2}+{\bar {X}}^{2}}{n}}}}

Matrix notation for the variance of a linear combination

X

{\displaystyle X}

n

{\displaystyle n}

X

1

,

…

,

X

n

{\displaystyle X_{1},\ldots ,X_{n}}

c

{\displaystyle c}

n

{\displaystyle n}

c

1

,

…

,

c

n

{\displaystyle c_{1},\ldots ,c_{n}}

c

T

X

{\displaystyle c^{T}X}

선형 조합(linear combination) 이며, 여기서

c

T

{\displaystyle c^{T}}

c

{\displaystyle c}

전치(transpose) 를 나타냅니다. 역시

Σ

{\displaystyle \Sigma }

X

{\displaystyle X}

공분산 행렬(covariance matrix) 로 놓습니다.

c

T

X

{\displaystyle c^{T}X}

[6]

Var

(

c

T

X

)

=

c

T

Σ

c

.

{\displaystyle \operatorname {Var} (c^{T}X)=c^{T}\Sigma c.}

이것은 평균의 분산이 (그것들의 열 벡터와 함께) 다음으로 쓰일 수 있음을 의미합니다:

Var

(

x

¯

)

=

Var

(

1

/

n

⋅

1

′

X

)

=

1

/

n

2

⋅

1

′

Σ

1.

{\displaystyle \operatorname {Var} ({\bar {x}})=\operatorname {Var} (1/n\cdot 1'X)=1/n^{2}\cdot 1'\Sigma 1.}

Weighted sum of variables 공분산(covariance) Cov(aX , bY ) = ab Cov(X , Y ) 의 속성과 함께 스케일링 속성과 비아내메 공식은 다음임을 결합적으로 의미합니다:

Var

(

a

X

±

b

Y

)

=

a

2

Var

(

X

)

+

b

2

Var

(

Y

)

±

2

a

b

Cov

(

X

,

Y

)

.

{\displaystyle \operatorname {Var} (aX\pm bY)=a^{2}\operatorname {Var} (X)+b^{2}\operatorname {Var} (Y)\pm 2ab\,\operatorname {Cov} (X,Y).}

이것은, 변수의 가중된 합에서, 가장 큰 가중값을 가진 변수는 전체의 분산에서 반비례적으로 큰 가중값을 가질 것임을 의미합니다. 예를 들어, 만약 X 와 Y 가 비-상관이고 X 의 가중값이 Y 의 가중값의 두 배이면, X 의 분산의 가중값은 Y 의 분산의 가중값의 네 배가 될 것입니다.

위의 표현은 여러 변수의 가중된 합으로 확장될 수 있습니다:

Var

(

∑

i

n

a

i

X

i

)

=

∑

i

=

1

n

a

i

2

Var

(

X

i

)

+

2

∑

1

≤

i

∑

<

j

≤

n

a

i

a

j

Cov

(

X

i

,

X

j

)

{\displaystyle \operatorname {Var} \left(\sum _{i}^{n}a_{i}X_{i}\right)=\sum _{i=1}^{n}a_{i}^{2}\operatorname {Var} (X_{i})+2\sum _{1\leq i}\sum _{<j\leq n}a_{i}a_{j}\operatorname {Cov} (X_{i},X_{j})}

Product of independent variables 두 변수 X 와 Y 가 독립(independent) 이면, 그들 곱의 분산은 다음으로 제공됩니다:[7]

Var

(

X

Y

)

=

[

E

(

X

)

]

2

Var

(

Y

)

+

[

E

(

Y

)

]

2

Var

(

X

)

+

Var

(

X

)

Var

(

Y

)

.

{\displaystyle {\begin{aligned}\operatorname {Var} (XY)&=[\operatorname {E} (X)]^{2}\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2}\operatorname {Var} (X)+\operatorname {Var} (X)\operatorname {Var} (Y).\end{aligned}}}

동등하게, 기대의 기본 속성을 사용하여, 그것은 다음으로 제공됩니다:

Var

(

X

Y

)

=

E

(

X

2

)

E

(

Y

2

)

−

[

E

(

X

)

]

2

[

E

(

Y

)

]

2

.

{\displaystyle \operatorname {Var} (XY)=\operatorname {E} (X^{2})\operatorname {E} (Y^{2})-[\operatorname {E} (X)]^{2}[\operatorname {E} (Y)]^{2}.}

Product of statistically dependent variables 일반적으로, 만약 두 변수가 통계적으로 종속이면, 그들의 곱의 분산은 다음으로 제공됩니다:

Var

(

X

Y

)

=

E

[

X

2

Y

2

]

−

[

E

(

X

Y

)

]

2

=

Cov

(

X

2

,

Y

2

)

+

E

(

X

2

)

E

(

Y

2

)

−

[

E

(

X

Y

)

]

2

=

Cov

(

X

2

,

Y

2

)

+

(

Var

(

X

)

+

[

E

(

X

)

]

2

)

(

Var

(

Y

)

+

[

E

(

Y

)

]

2

)

−

[

Cov

(

X

,

Y

)

+

E

(

X

)

E

(

Y

)

]

2

{\displaystyle {\begin{aligned}\operatorname {Var} (XY)={}&\operatorname {E} [X^{2}Y^{2}]-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} (X^{2},Y^{2})+\operatorname {E} (X^{2})\operatorname {E} (Y^{2})-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} (X^{2},Y^{2})+(\operatorname {Var} (X)+[\operatorname {E} (X)]^{2})(\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2})\\[5pt]&{}-[\operatorname {Cov} (X,Y)+\operatorname {E} (X)\operatorname {E} (Y)]^{2}\end{aligned}}}

Decomposition 분산 분해 또는 전체 분산의 법칙(law of total variance) 에 대해 일반적인 공식은 다음입니다: 만약

X

{\displaystyle X}

Y

{\displaystyle Y}

X

{\displaystyle X}

Var

[

X

]

=

E

(

Var

[

X

∣

Y

]

)

+

Var

(

E

[

X

∣

Y

]

)

.

{\displaystyle \operatorname {Var} [X]=\operatorname {E} (\operatorname {Var} [X\mid Y])+\operatorname {Var} (\operatorname {E} [X\mid Y]).}

주어진

Y

{\displaystyle Y}

X

{\displaystyle X}

조건부 기대(conditional expectation)

E

(

X

∣

Y

)

{\displaystyle \operatorname {E} (X\mid Y)}

조건부 분산(conditional variance)

Var

(

X

∣

Y

)

{\displaystyle \operatorname {Var} (X\mid Y)}

Y 의 임의의 특정 값 y 가 주어지면, 주어진 사건 Y = y 에 대한 조건부 기대

E

(

X

∣

Y

=

y

)

{\displaystyle \operatorname {E} (X\mid Y=y)}

y 에 의존합니다; 그것은 함수

g

(

y

)

=

E

(

X

∣

Y

=

y

)

{\displaystyle g(y)=\operatorname {E} (X\mid Y=y)}

Y 에서 평가된 그 같은 함수는 조건부 기대

E

(

X

∣

Y

)

=

g

(

Y

)

{\displaystyle \operatorname {E} (X\mid Y)=g(Y)}

특히, 만약

Y

{\displaystyle Y}

y

1

,

y

2

,

y

3

…

{\displaystyle y_{1},y_{2},y_{3}\ldots }

p

1

,

p

2

,

p

3

…

{\displaystyle p_{1},p_{2},p_{3}\ldots }

E

(

Var

[

X

∣

Y

]

)

=

∑

i

p

i

σ

i

2

,

{\displaystyle \operatorname {E} (\operatorname {Var} [X\mid Y])=\sum _{i}p_{i}\sigma _{i}^{2},}

여기서

σ

i

2

=

Var

[

X

∣

Y

=

y

i

]

{\displaystyle \sigma _{i}^{2}=\operatorname {Var} [X\mid Y=y_{i}]}

Var

(

E

[

X

∣

Y

]

)

=

∑

i

p

i

μ

i

2

−

(

∑

i

p

i

μ

i

)

2

=

∑

i

p

i

μ

i

2

−

μ

2

,

{\displaystyle \operatorname {Var} (\operatorname {E} [X\mid Y])=\sum _{i}p_{i}\mu _{i}^{2}-\left(\sum _{i}p_{i}\mu _{i}\right)^{2}=\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2},}

여기서

μ

i

=

E

[

X

∣

Y

=

y

i

]

{\displaystyle \mu _{i}=\operatorname {E} [X\mid Y=y_{i}]}

μ

=

∑

i

p

i

μ

i

{\displaystyle \mu =\sum _{i}p_{i}\mu _{i}}

Var

[

X

]

=

∑

i

p

i

σ

i

2

+

(

∑

i

p

i

μ

i

2

−

μ

2

)

.

{\displaystyle \operatorname {Var} [X]=\sum _{i}p_{i}\sigma _{i}^{2}+\left(\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2}\right).}

비슷한 공식은 분산의 해석(analysis of variance) 에서 적용되며, 여기서 대응하는 공식은 다음입니다:

M

S

total

=

M

S

between

+

M

S

within

;

{\displaystyle {\mathit {MS}}_{\text{total}}={\mathit {MS}}_{\text{between}}+{\mathit {MS}}_{\text{within}};}

여기서

M

S

{\displaystyle {\mathit {MS}}}

선형 회귀(linear regression) 해석에서 대응하는 공식은 다음입니다:

M

S

total

=

M

S

regression

+

M

S

residual

.

{\displaystyle {\mathit {MS}}_{\text{total}}={\mathit {MS}}_{\text{regression}}+{\mathit {MS}}_{\text{residual}}.}

이것은 분산의 덧셈 가능성에서 역시 유도될 수 있는데, 왜냐하면 전체 (관측된) 점수는 예측된 점수와 오차 점수의 합이기 때문이며, 여기서 후자의 둘은 비-상관입니다.

비슷한 분해는 제곱된 편차의 합 (제곱들의 합,

S

S

{\displaystyle {\mathit {SS}}}

S

S

total

=

S

S

between

+

S

S

within

,

{\displaystyle {\mathit {SS}}_{\text{total}}={\mathit {SS}}_{\text{between}}+{\mathit {SS}}_{\text{within}},}

S

S

total

=

S

S

regression

+

S

S

residual

.

{\displaystyle {\mathit {SS}}_{\text{total}}={\mathit {SS}}_{\text{regression}}+{\mathit {SS}}_{\text{residual}}.}

Calculation from the CDF 비-음의 확률 변수에 대한 모집단 분산은 다음을 사용하여 누적 분포 함수(cumulative distribution function) F 의 관점에서 표현될 수 있습니다:

2

∫

0

∞

u

(

1

−

F

(

u

)

)

d

u

−

(

∫

0

∞

(

1

−

F

(

u

)

)

d

u

)

2

.

{\displaystyle 2\int _{0}^{\infty }u(1-F(u))\,du-{\Big (}\int _{0}^{\infty }(1-F(u))\,du{\Big )}^{2}.}

이 표현은, 누적 밀도 함수가 편리하게 표현될 수 있지만, 밀도(density) 는 그렇지 않은 상황에서 분산을 계산하기 위해 사용될 수 있습니다.

Characteristic property 확률 변수의 두 번째 모멘트(moment) 는 확률 변수의 첫 번째 모멘트 (즉, 평균), 즉,

a

r

g

m

i

n

m

E

(

(

X

−

m

)

2

)

=

E

(

X

)

{\displaystyle \mathrm {argmin} _{m}\,\mathrm {E} \left(\left(X-m\right)^{2}\right)=\mathrm {E} (X)}

φ

{\displaystyle \varphi }

X 에 대해

a

r

g

m

i

n

m

E

(

φ

(

X

−

m

)

)

=

E

(

X

)

{\displaystyle \mathrm {argmin} _{m}\,\mathrm {E} (\varphi (X-m))=\mathrm {E} (X)}

φ

(

x

)

=

a

x

2

+

b

{\displaystyle \varphi (x)=ax^{2}+b}

a > 0[8]

Units of measurement 기대 절대 편차와 달리, 변수의 분산은 변수 그 자체의 단위의 제곱인 단위를 가집니다. 예를 들어, 미터에서 측정된 변수는 제곱된 미터에서 측정된 분산을 가질 것입니다. 이 이유에 대해, 그들의 표준 편차(standard deviation) 또는 제곱근 평균 제곱 편차(root mean square deviation) 를 통해 데이터 집합을 기술하는 것이 분산을 사용하는 것보다 종종 선호됩니다. 주사위 예제에서 표준 편차는 √2.9 ≈ 1.7

표준 편차와 기대 절대 편차 둘 다는 분포의 "흩어짐"의 지표로 사용될 수 있습니다. 표준 편차는 기대 절대 편차보다 대수적 조작에 더 적합하고, 분산 및 그의 일반화 공분산(covariance) 과 함께 이론적 통계에서 자주 사용됩니다; 어쨌든 기대 절대 편차는 보다 건장(robust) 하게 되는 경향이 있는데 왜냐하면 그것은 측정 변칙(measurement anomalies) 또는 지나치게 두꺼운-꼬리 분포(heavy-tailed distribution) 로 인해 발생하는 이상값(outlier) 에 덜 민감하기 때문입니다.

Approximating the variance of a function 델타 방법(delta method) 은 하나 이상의 확률 변수의 함수의 분산을 근사화하기 위해 이-차 테일러 전개(Taylor expansion) 를 사용합니다: 확률 변수의 함수의 모멘트에 대해 테일러 전개 를 참조하십시오. 예를 들어, 한 변수의 함수의 근사 분산은, 만약 f 가 두 번 미분-가능이고 X 의 평균과 분산이 유한인 것으로 제공되면, 다음으로 제공됩니다:

Var

[

f

(

X

)

]

≈

(

f

′

(

E

[

X

]

)

)

2

Var

[

X

]

{\displaystyle \operatorname {Var} \left[f(X)\right]\approx \left(f'(\operatorname {E} \left[X\right])\right)^{2}\operatorname {Var} \left[X\right]}

Population variance and sample variance

어제 하루 종일 비의 측정과 같은 실제-세상 관측은 전형적으로 만들어질 수 있는 모든 가능한 관측의 완전한 집합이 절대 될 수 없습니다. 그렇기 때문에, 유한 집합에서 계산된 분산은 가능한 관측의 전체 모집단으로부터 계산될 수 있는 분산과 일반적으로 일치할 수 없습니다. 이것은 추정량(estimator) 방정식을 사용함으로써 관측의 모든 알려진 집합으로부터 계산될 수 있는 평균과 분산을 추정한다(estimates) 는 것을 의미합니다. 추정량은 잠재적인 관측의 전체 모집단(population) 으로부터 관측된 편향없이 도출된 n 개의 관측(observations) 의 표본(sample) 의 함수입니다. 이 예제에서 그 표본은 관심있는 지역 안에서 사용 가능한 비 게이지로부터 어제의 강우량의 실제 측정의 집합일 수 있습니다.

모집단 평균 및 모집단 분산에 대해 가장 간단한 추정량은 단순히 표본의 평균 및 분산, 표본 평균 (sample mean ) 및 (비-보정된) 표본 분산 ((uncorrected) sample variance )입니다 – 이들은 일치 추정량(consistent estimator) 이지만 (그들은 표본의 숫자가 증가함에 따라 올바른 값으로 수렴합니다), 개선이 될 수 있습니다. 표본의 분산을 취함으로써 모집단 분산을 추정하는 것은 일반적으로 최적에 가깝지만, 두 가지 방법에서 개선될 수 있습니다. 가장 간단하게, 표본 분산은, n 으로 나눔으로써, (표본) 평균에 대한 제곱된 편차(squared deviations) 의 평균으로 계산됩니다. 어쨌든, n 이외의 값을 사용하면 다양한 방식으로 추정량을 개선시킵니다. 분모에 대해 네 가지 공통 값은 n, n − 1, n + 1, 및 n − 1.5입니다: n 은 가장 단순한 것 (표본의 모집단 분산)이고, n − 1은 편향을 제거하고, n + 1은 정규 분포에 대해 평균 제곱된 오차(mean squared error) 를 최소화하고, n − 1.5은 정규 분포에 대해 표준 편차의 불-편향 추정(unbiased estimation of standard deviation) 에서 편향을 대부분 제거합니다.

먼저, 만약 모든 알려진 것으로부터의 평균이 미지수이면 (표본 평균으로 계산되면), 표본 분산은 편향 추정량(biased estimator) 입니다: 그것은 (n − 1) / n 의 인수에 의해 분산을 과소평가합니다; (n 대신에 n − 1로 나눔으로써) 이 인수에 의해 보정하는 것은 베셀의 보정(Bessel's correction) 이라고 불립니다. 결과 추정량은 불-편향이고, (보정된) 표본 분산 ((corrected) sample variance ) 또는 불-편향 표본 분산 (unbiased sample variance )이라고 불립니다. 예를 들어, n = 1일 때, 표본 평균 (그 자체)에 대한 하나의 관측의 분산은, 모집단 분산에 관계없이, 분명히 영입니다. 만약 평균이 분산을 추정하기 위해 사용된 같은 표본으로부터의 것보다 일부 다른 방식으로 결정되면, 이 편향이 발생하지 않고, 분산은 (독립적으로 알려진) 평균에 대한 표본의 것으로 안전하게 추정될 수 있습니다.

다음으로, 표본 분산은 일반적으로 표본 분산과 모집단 분산 사이의 평균 제곱된 오차(mean squared error) 를 최소화하지 않습니다. 편향에 대해 보정하는 것은 종종 이것을 더 악화시킵니다: 비록 최적의 스케일 인수는 모집단의 초과 뾰족(excess kurtosis) 에 의존하고 (평균 제곱된 오차: 분산(mean squared error: variance) 을 참조하십시오), 편향을 유발할지라도, 보정된 표본 분산보다 더 좋게 수행하는 스케일 인수를 항상 선택할 수 있습니다. 이것은 (n − 1보다 더 큰 숫자로 나눔으로써) 항상 불-편향 추정량을 축소하는 것으로 구성하고, 수축 추정량(shrinkage estimator) 의 간단한 예제입니다: 불-편향 추정량을 영으로 향하도록 "축소합니다". 정규 분포에 대해, (n − 1 또는 n 대신에) n + 1로 나눔으로써 평균 제곱된 오차를 최소화합니다. 결과 추정량은 편향이고, 어쨌든, 편향된 표본 변화 (biased sample variation )로 알려져 있습니다.

Population variance 일반적으로, 값 x i N 의 유한 모집단(population) 의 모집단 분산 population variance

σ

2

=

1

N

∑

i

=

1

N

(

x

i

−

μ

)

2

=

1

N

∑

i

=

1

N

(

x

i

2

−

2

μ

x

i

+

μ

2

)

=

(

1

N

∑

i

=

1

N

x

i

2

)

−

2

μ

(

1

N

∑

i

=

1

N

x

i

)

+

μ

2

=

(

1

N

∑

i

=

1

N

x

i

2

)

−

μ

2

{\displaystyle {\begin{aligned}\sigma ^{2}&={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}-\mu \right)^{2}={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}^{2}-2\mu x_{i}+\mu ^{2}\right)\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-2\mu \left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)+\mu ^{2}\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\mu ^{2}\end{aligned}}}

여기서 모집단 평균은 다음입니다:

μ

=

1

N

∑

i

=

1

N

x

i

.

{\displaystyle \mu ={\frac {1}{N}}\sum _{i=1}^{N}x_{i}.}

모집단 분산은 다음을 사용하여 역시 계산될 수 있습니다:

σ

2

=

1

N

2

∑

i

<

j

(

x

i

−

x

j

)

2

=

1

2

N

2

∑

i

,

j

=

1

N

(

x

i

−

x

j

)

2

.

{\displaystyle \sigma ^{2}={\frac {1}{N^{2}}}\sum _{i<j}\left(x_{i}-x_{j}\right)^{2}={\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}-x_{j}\right)^{2}.}

이것은 참인데 왜냐하면

1

2

N

2

∑

i

,

j

=

1

N

(

x

i

−

x

j

)

2

=

1

2

N

2

∑

i

,

j

=

1

N

(

x

i

2

−

2

x

i

x

j

+

x

j

2

)

=

1

2

N

∑

j

=

1

N

(

1

N

∑

i

=

1

N

x

i

2

)

−

(

1

N

∑

i

=

1

N

x

i

)

(

1

N

∑

j

=

1

N

x

j

)

+

1

2

N

∑

i

=

1

N

(

1

N

∑

j

=

1

N

x

j

2

)

=

1

2

(

σ

2

+

μ

2

)

−

μ

2

+

1

2

(

σ

2

+

μ

2

)

=

σ

2

{\displaystyle {\begin{aligned}{\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}-x_{j}\right)^{2}&={\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}^{2}-2x_{i}x_{j}+x_{j}^{2}\right)\\[5pt]&={\frac {1}{2N}}\sum _{j=1}^{N}\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}\right)\\[5pt]&\quad +{\frac {1}{2N}}\sum _{i=1}^{N}\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}^{2}\right)\\[5pt]&={\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)-\mu ^{2}+{\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)\\[5pt]&=\sigma ^{2}\end{aligned}}}

모집단 분산은 생성하는 확률 분포의 분산과 일치합니다. 이런 의미에서, 모집단의 개념은 무한 모집단을 갖는 연속 확률 변수로 확장될 수 있습니다.

Sample variance 많은 실제적 상황에서, 모집단의 참 분산은 이전 (a priori )으로 알려져 있지 않고 어떻게든지 반드시 계산되어야 합니다. 엄청나게 큰 모집단을 다룰 때, 모집단에서 모든 각 대상을 세는 것이 불가능하므로, 계산은 모집단의 표본(sample) 에 대해 수행되어야 합니다.[9]

우리는 모집단에서 n 값 Y 1 , ..., Y n 대체를 갖는 표본(sample with replacement) 을 취하고 (여기서 n < N ), 이 표본을 기초로 분산을 추정합니다.[10] 제곱된 편차(squared deviations) 의 평균을 제공합니다:

σ

Y

2

=

1

n

∑

i

=

1

n

(

Y

i

−

Y

¯

)

2

=

(

1

n

∑

i

=

1

n

Y

i

2

)

−

Y

¯

2

=

1

n

2

∑

i

,

j

:

i

<

j

(

Y

i

−

Y

j

)

2

.

{\displaystyle \sigma _{Y}^{2}={\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\overline {Y}}\right)^{2}=\left({\frac {1}{n}}\sum _{i=1}^{n}Y_{i}^{2}\right)-{\overline {Y}}^{2}={\frac {1}{n^{2}}}\sum _{i,j\,:\,i<j}\left(Y_{i}-Y_{j}\right)^{2}.}

여기서,

Y

¯

{\displaystyle {\overline {Y}}}

표본 평균(sample mean) 을 나타냅니다:

Y

¯

=

1

n

∑

i

=

1

n

Y

i

.

{\displaystyle {\overline {Y}}={\frac {1}{n}}\sum _{i=1}^{n}Y_{i}.}

Y i

Y

¯

{\displaystyle {\overline {Y}}}

σ

Y

2

{\displaystyle \sigma _{Y}^{2}}

n 의 모든 가능한 표본들 {Y i

σ

Y

2

{\displaystyle \sigma _{Y}^{2}}

E

[

σ

Y

2

]

=

E

[

1

n

∑

i

=

1

n

(

Y

i

−

1

n

∑

j

=

1

n

Y

j

)

2

]

=

1

n

∑

i

=

1

n

E

[

Y

i

2

−

2

n

Y

i

∑

j

=

1

n

Y

j

+

1

n

2

∑

j

=

1

n

Y

j

∑

k

=

1

n

Y

k

]

=

1

n

∑

i

=

1

n

[

n

−

2

n

E

[

Y

i

2

]

−

2

n

∑

j

≠

i

E

[

Y

i

Y

j

]

+

1

n

2

∑

j

=

1

n

∑

k

≠

j

n

E

[

Y

j

Y

k

]

+

1

n

2

∑

j

=

1

n

E

[

Y

j

2

]

]

=

1

n

∑

i

=

1

n

[

n

−

2

n

(

σ

2

+

μ

2

)

−

2

n

(

n

−

1

)

μ

2

+

1

n

2

n

(

n

−

1

)

μ

2

+

1

n

(

σ

2

+

μ

2

)

]

=

n

−

1

n

σ

2

.

{\displaystyle {\begin{aligned}\operatorname {E} [\sigma _{Y}^{2}]&=\operatorname {E} \left[{\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\frac {1}{n}}\sum _{j=1}^{n}Y_{j}\right)^{2}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\operatorname {E} \left[Y_{i}^{2}-{\frac {2}{n}}Y_{i}\sum _{j=1}^{n}Y_{j}+{\frac {1}{n^{2}}}\sum _{j=1}^{n}Y_{j}\sum _{k=1}^{n}Y_{k}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}\operatorname {E} [Y_{i}^{2}]-{\frac {2}{n}}\sum _{j\neq i}\operatorname {E} [Y_{i}Y_{j}]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\sum _{k\neq j}^{n}\operatorname {E} [Y_{j}Y_{k}]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\operatorname {E} [Y_{j}^{2}]\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}(\sigma ^{2}+\mu ^{2})-{\frac {2}{n}}(n-1)\mu ^{2}+{\frac {1}{n^{2}}}n(n-1)\mu ^{2}+{\frac {1}{n}}(\sigma ^{2}+\mu ^{2})\right]\\[5pt]&={\frac {n-1}{n}}\sigma ^{2}.\end{aligned}}}

따라서

σ

Y

2

{\displaystyle \sigma _{Y}^{2}}

n

−

1

n

{\displaystyle {\frac {n-1}{n}}}

σ

Y

2

{\displaystyle \sigma _{Y}^{2}}

편향된 표본 분산 (biased sample variance )으로 참조됩니다. 이 편향에 대해 보정하는 것은 불-편향된 표본 분산 (unbiased sample variance )을 산출합니다:

s

2

=

n

n

−

1

σ

Y

2

=

n

n

−

1

(

1

n

∑

i

=

1

n

(

Y

i

−

Y

¯

)

2

)

=

1

n

−

1

∑

i

=

1

n

(

Y

i

−

Y

¯

)

2

{\displaystyle s^{2}={\frac {n}{n-1}}\sigma _{Y}^{2}={\frac {n}{n-1}}\left({\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\overline {Y}}\right)^{2}\right)={\frac {1}{n-1}}\sum _{i=1}^{n}\left(Y_{i}-{\overline {Y}}\right)^{2}}

두 추정량 중 하나는, 버전이 문맥에 의해 결정될 수 있을 때, 표본 분산 으로 단순히 참조될 수 있습니다. 같은 증명은 연속 확률 분포로부터 추출된 표본에 대해 역시 적용가능합니다.

항 n − 1의 사용은 베셀의 보정(Bessel's correction) 이라고 불리고, 표본 공분산(sample covariance) 및 표본 표준 편차(sample standard deviation) (분산의 제곱근)에서 역시 사용됩니다. 제곱근은 오목 함수(concave function) 이고 따라서 분포에 따라 음의 편향 (옌센의 부등식(Jensen's inequality) )을 유발하고, 따라서 (베셀의 보정을 사용하여) 보정된 표본 표준 편차는 편향입니다. 표준 편차의 불-편향 추정(unbiased estimation of standard deviation) 은, 비록 정규 분포에 대해 항 n − 1.5을 사용하여 거의 불-편향 추정량을 산출할지라도, 기술적으로 관련된 문제입니다.

불-편향된 표본 분산은 함수 ƒ (y 1 , y 2 ) = (y 1 − y 2 )2 /2에 대해 U-통계(U-statistic) 로써, 이는 그것이 모집단의 2-원소 부분집합에 걸쳐 2-표본 통계량을 평균함으로써 구해짐을 의미합니다.

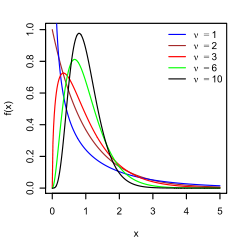

Distribution of the sample variance Distribution and cumulative distribution of S 2 /σ2 , for various values of ν = n − 1, when the yi are independent normally distributed.

확률 변수(random variable) 의 함수이기 때문에, 표본 분산은 그 자체로 확률 변수이고, 그것의 분포를 연구하는 것은 자연스럽습니다. Y i 정규 분포(normal distribution) 로부터 독립적 관측인 경우에서, 카그랜의 정리(Cochran's theorem) 는 s 2 이 스케일된 카이-제곱된 분포(chi-squared distribution) 를 따름을 보여줍니다:[11]

(

n

−

1

)

s

2

σ

2

∼

χ

n

−

1

2

.

{\displaystyle (n-1){\frac {s^{2}}{\sigma ^{2}}}\sim \chi _{n-1}^{2}.}

직접 결과에서 처럼, 그것은 다음임을 따릅니다:

E

(

s

2

)

=

E

(

σ

2

n

−

1

χ

n

−

1

2

)

=

σ

2

,

{\displaystyle \operatorname {E} (s^{2})=\operatorname {E} \left({\frac {\sigma ^{2}}{n-1}}\chi _{n-1}^{2}\right)=\sigma ^{2},}

및[12]

Var

[

s

2

]

=

Var

(

σ

2

n

−

1

χ

n

−

1

2

)

=

σ

4

(

n

−

1

)

2

Var

(

χ

n

−

1

2

)

=

2

σ

4

n

−

1

.

{\displaystyle \operatorname {Var} [s^{2}]=\operatorname {Var} \left({\frac {\sigma ^{2}}{n-1}}\chi _{n-1}^{2}\right)={\frac {\sigma ^{4}}{(n-1)^{2}}}\operatorname {Var} \left(\chi _{n-1}^{2}\right)={\frac {2\sigma ^{4}}{n-1}}.}

만약 Y i [13]

E

[

s

2

]

=

σ

2

,

Var

[

s

2

]

=

σ

4

n

(

(

κ

−

1

)

+

2

n

−

1

)

=

1

n

(

μ

4

−

n

−

3

n

−

1

σ

4

)

,

{\displaystyle \operatorname {E} [s^{2}]=\sigma ^{2},\quad \operatorname {Var} [s^{2}]={\frac {\sigma ^{4}}{n}}\left((\kappa -1)+{\frac {2}{n-1}}\right)={\frac {1}{n}}\left(\mu _{4}-{\frac {n-3}{n-1}}\sigma ^{4}\right),}

여기서 κ 는 분포의 뾰족(kurtosis) 이고 μ4 는 네 번째 중심 모멘트(central moment) 입니다.

만약 큰 숫자의 법칙(law of large numbers) 의 조건이 제곱된 관측에 대해 유지되면, s 2 는 σ 2 의 일치 추정량(consistent estimator) 입니다. 사실 추정량의 분산은 영으로 점근적으로 가는 경향이 있음을 알 수 있습니다. 점근적으로 동등한 공식은 케니와 키핑(Kenney and Keeping) (1951:164), 로즈와 스미스(Rose and Smith) (2002:264), 및 웨이스타인(Weisstein) (n.d.)에서 제공되었습니다.[14] [15] [16]

Samuelson's inequality 사무엘슨의 부등식(Samuelson's inequality) 은, 표본 평균 및 (편향된) 분산이 계산되어 왔던 것으로 주어지면, 표본에서 개별적인 관측이 취할 수 있는 값에 극한을 정하는 결과입니다.[17]

y

¯

±

σ

Y

(

n

−

1

)

1

/

2

{\displaystyle {\bar {y}}\pm \sigma _{Y}(n-1)^{1/2}}

Relations with the harmonic and arithmetic means 그것은 실수의 표본 {y i [18]

σ

y

2

≤

2

y

max

(

A

−

H

)

,

{\displaystyle \sigma _{y}^{2}\leq 2y_{\max }(A-H),}

여기서 y max 는 표본의 최댓값이고, A 는 산술 평균, H 는 표본의 조화 평균(harmonic mean) 이고

σ

y

2

{\displaystyle \sigma _{y}^{2}}

이 경계는 개선되어 왔고, 분산이 다음에 의해 경계지는 것임을 알려져 있습니다:

σ

y

2

≤

y

max

(

A

−

H

)

(

y

max

−

A

)

y

max

−

H

,

{\displaystyle \sigma _{y}^{2}\leq {\frac {y_{\max }(A-H)(y_{\max }-A)}{y_{\max }-H}},}

σ

y

2

≥

y

min

(

A

−

H

)

(

A

−

y

min

)

H

−

y

min

,

{\displaystyle \sigma _{y}^{2}\geq {\frac {y_{\min }(A-H)(A-y_{\min })}{H-y_{\min }}},}

여기서 y min 는 표본의 최솟값입니다.[19]

Tests of equality of variances 두 개 이상의 분산의 상등에 대해 테스팅은 어렵습니다. F 테스트(F test) 및 카이 제곱 테스트(chi square test) 는 비-정규성에 의해 둘 다 부정적인 영향을 받고 이 목적에 대해 권장되지 않습니다.

몇 가지 비-매개변수의 테스트가 제안되어 왔습니다: 이들은 바튼–데이비드–인싸리–파인트–시걸–투키(Barton–David–Ansari–Freund–Siegel–Tukey) 테스트, 키폰 테스트(Capon test) , 무드 테스트(Mood test) , 클로츠 테스트(Klotz test) 및 슈케미 테스트(Sukhatme test) 를 포함합니다. 슈케미 테스트는 두 분산에 적용되고 두 중앙값(median) 을 모두 알고 있어야 하고 영과 같아야 합니다. 무드, 클로츠, 키폰 및 바튼–데이비드–인싸리–파인트–시걸–투키 테스트는 두 분산에 역시 적용됩니다. 그것들은 중앙값이 미지수가 되지만 두 중앙값이 같아야 하는 요구를 허용합니다.

리히만 테스트(Lehmann test) 는 두 분산의 매개변수의 테스트입니다. 이 테스트는 몇 가지 변형이 알려져 있습니다. 분산의 상등의 다른 테스트는 박스 테스트(Box test) , 박스–앤더슨 테스트(Box–Anderson test) 및 모저스 테스트(Moses test) 를 포함합니다.

부트스트랩(bootstrap) 및 잭나이프(jackknife) 를 포함하는, 재-표본화 방법은 분산의 상등을 테스트하기 위해 사용될 수 있습니다.

History 용어 분산 은 1918년 논문 The Correlation Between Relatives on the Supposition of Mendelian Inheritance 로널드 피셔(Ronald Fisher) 에 의해 처음 도입되었습니다:[20]

유용한 통계학의 엄청난 몸체는 그의 평균으로부터 인간 측정(human measurement) 의 편차는 오차의 정규 법칙(Normal Law of Errors) 과 매우 근접하게 따르고, 그러므로, 분산성은 평균 제곱 오차(mean square error) 의 제곱근(square root) 에 해당하는 표준 편차(standard deviation) 로 균일하게 측정될 수 있음을 우리에게 보여줍니다. 표준 편차

σ

1

{\displaystyle \sigma _{1}}

σ

2

{\displaystyle \sigma _{2}}

σ

1

2

+

σ

2

2

{\displaystyle {\sqrt {\sigma _{1}^{2}+\sigma _{2}^{2}}}}

Geometric visualisation of the variance of an arbitrary distribution (2, 4, 4, 4, 5, 5, 7, 9): A frequency distribution is constructed. The centroid of the distribution gives its mean. A square with sides equal to the difference of each value from the mean is formed for each value. Arranging the squares into a rectangle with one side equal to the number of values, n , results in the other side being the distribution's variance, σ 2 . Moment of inertia 확률 분포의 분산은, 질량 중심에 대한 회전의 관점에서, 직선을 따라 해당하는 질량 분포의 고전 역학(classical mechanics) 에서 관성의 모멘트(moment of inertia) 와 유사합니다.[citation needed 이 유사성때문에 분산과 같은 그러한 것이 확률 분포(probability distribution) 의 모멘트 (moment )[citation needed 공분산 행렬은 다변량 분포에 대해 관성의 모멘트 텐서(moment of inertia tensor) 와 관련됩니다.

Σ

{\displaystyle \Sigma }

n 점의 구름의 관성 모멘트는 다음으로 제공됩니다:[citation needed

I

=

n

(

1

3

×

3

tr

(

Σ

)

−

Σ

)

.

{\displaystyle I=n(\mathbf {1} _{3\times 3}\operatorname {tr} (\Sigma )-\Sigma ).}

물리학 및 통계학에서 관성 모멘트 사이의 이러한 차이는 직선을 따라 모여진 점들에 대해 분명합니다. 많은 점이 x 축에 가깝고 그것을 따라 분포되어 있다고 가정합니다. 공분산 행렬은 다음처럼 보일 것입니다:

Σ

=

[

10

0

0

0

0.1

0

0

0

0.1

]

.

{\displaystyle \Sigma ={\begin{bmatrix}10&0&0\\0&0.1&0\\0&0&0.1\end{bmatrix}}.}

즉, x 방향에서 가장 큰 분산이 있습니다. 물리학자는 이것을 x 축에 대한 낮은 모멘트를 가지는 것으로 고려하므로 관성 모멘트 텐서는 다음입니다.

I

=

n

[

0.2

0

0

0

10.1

0

0

0

10.1

]

.

{\displaystyle I=n{\begin{bmatrix}0.2&0&0\\0&10.1&0\\0&0&10.1\end{bmatrix}}.}

Semivariance 반분산 (semivariance )은 분산과 같은 방식으로 계산되지만 오직 평균 아래로 떨어지는 그들의 관측이 계산에 포함됩니다:

Semivariance

=

1

n

∑

i

:

x

i

<

μ

(

x

i

−

μ

)

2

{\displaystyle {\text{Semivariance}}={1 \over {n}}\sum _{i:x_{i}<\mu }(x_{i}-\mu )^{2}}

그것은 때때로 투자(investments) 문맥에서 하락 위험(downside risk) 의 측정으로 묘사됩니다. 치우친 분포에 대해, 반분산은 분산이 제공하지 못하는 추가적인 정보를 제공할 수 있습니다:[21]

반분산과 관련된 부등식에 대해, Chebyshev's inequality § Semivariances 을 참조하십시오.

Generalizations For complex variables 만약

x

{\displaystyle x}

C

{\displaystyle \mathbb {C} }

복소(complex) -값 확률 변수이면, 그의 분산은

E

[

(

x

−

μ

)

(

x

−

μ

)

∗

]

{\displaystyle \operatorname {E} \left[(x-\mu )(x-\mu )^{*}\right]}

x

∗

{\displaystyle x^{*}}

x

{\displaystyle x}

복소수 켤레(complex conjugate) 입니다. 이 분산은 실수 스칼라입니다.

For vector-valued random variables As a matrix 만약

X

{\displaystyle X}

R

n

{\displaystyle \mathbb {R} ^{n}}

벡터(vector) -값 확률 변수이면, 분산의 자연스러운 일반화는

E

[

(

X

−

μ

)

(

X

−

μ

)

T

]

{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\operatorname {T} }\right]}

μ

=

E

(

X

)

{\displaystyle \mu =\operatorname {E} (X)}

X

T

{\displaystyle X^{\operatorname {T} }}

X

{\displaystyle X}

양의 반-확정 정사각 행렬(positive semi-definite square matrix) 이며, 공통적으로 분산-공분산 행렬(variance-covariance matrix) (또는 단순히 공분산 행렬 )로 참조됩니다.

만약

X

{\displaystyle X}

C

n

{\displaystyle \mathbb {C} ^{n}}

공분산 행렬(covariance matrix) 은

E

[

(

X

−

μ

)

(

X

−

μ

)

†

]

{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\dagger }\right]}

X

†

{\displaystyle X^{\dagger }}

X

{\displaystyle X}

켤레 전치(conjugate transpose) 입니다.[citation needed 이 행렬은 역시 양의 반-확정이고 정사각입니다.

As a scalar 행렬이라기 보다는 오히려 스칼라 값을 초래하는, 벡터-값 확률 변수

X

{\displaystyle X}

일반화된 분산(generalized variance)

det

(

C

)

{\displaystyle \det(C)}

행렬식(determinant) 입니다. 일반화된 분산은 그들의 평균 주변의 점들의 다차원 흩뜨림과 관련이 되는 것으로 보일 수 있습니다.[22]

다른 일반화는 확률 변수와 그의 평균 사이의 유클리드 거리(Euclidean distance) 를 고려함으로써 얻습니다. 이것은

E

[

(

X

−

μ

)

T

(

X

−

μ

)

]

=

tr

(

C

)

{\displaystyle \operatorname {E} \left[(X-\mu )^{\operatorname {T} }(X-\mu )\right]=\operatorname {tr} (C)}

대각합(trace) 입니다.

See also References

^ Some new deformation formulas about variance and covariance . Proceedings of 4th International Conference on Modelling, Identification and Control(ICMIC2012). June 2012. pp. 987–992.^ Loève, M. (1977) "Probability Theory", Graduate Texts in Mathematics , Volume 45, 4th edition, Springer-Verlag, p. 12.^ Bienaymé, I.-J. (1853) "Considérations à l'appui de la découverte de Laplace sur la loi de probabilité dans la méthode des moindres carrés", Comptes rendus de l'Académie des sciences Paris , 37, p. 309–317; digital copy available [1] ^ Bienaymé, I.-J. (1867) "Considérations à l'appui de la découverte de Laplace sur la loi de probabilité dans la méthode des moindres carrés", Journal de Mathématiques Pures et Appliquées, Série 2 , Tome 12, p. 158–167; digital copy available [2] [3] ^ Cornell, J R, and

Benjamin, C A, Probability, Statistics, and Decisions for Civil Engineers, McGraw-Hill, NY, 1970, pp.178-9.

^ Johnson, Richard; Wichern, Dean (2001). Applied Multivariate Statistical Analysis . Prentice Hall. p. 76. ISBN 0-13-187715-1 ^ Goodman, Leo A. (December 1960). "On the Exact Variance of Products". Journal of the American Statistical Association . 55 (292): 708–713. doi :10.2307/2281592 . JSTOR 2281592 .^ Kagan, A.; Shepp, L. A. (1998). "Why the variance?". Statistics & Probability Letters . 38 (4): 329–333. doi :10.1016/S0167-7152(98)00041-8 . ^ Navidi, William (2006) Statistics for Engineers and Scientists , McGraw-Hill, pg 14.

^ Montgomery, D. C. and Runger, G. C. (1994) Applied statistics and probability for engineers , page 201. John Wiley & Sons New York

^ Knight K. (2000), Mathematical Statistics , Chapman and Hall, New York. (proposition 2.11)

^ Casella and Berger (2002) Statistical Inference , Example 7.3.3, p. 331 [full citation needed

^ Cho, Eungchun; Cho, Moon Jung; Eltinge, John (2005) The Variance of Sample Variance From a Finite Population. International Journal of Pure and Applied Mathematics 21 (3): 387-394. http://www.ijpam.eu/contents/2005-21-3/10/10.pdf

^ Kenney, John F.; Keeping, E.S. (1951) Mathematics of Statistics. Part Two. 2nd ed. D. Van Nostrand Company, Inc. Princeton: New Jersey. http://krishikosh.egranth.ac.in/bitstream/1/2025521/1/G2257.pdf

^ Rose, Colin; Smith, Murray D. (2002) Mathematical Statistics with Mathematica. Springer-Verlag, New York. http://www.mathstatica.com/book/Mathematical_Statistics_with_Mathematica.pdf

^ Weisstein, Eric W. (n.d.) Sample Variance Distribution. MathWorld—A Wolfram Web Resource. http://mathworld.wolfram.com/SampleVarianceDistribution.html

^ Samuelson, Paul (1968). "How Deviant Can You Be?". Journal of the American Statistical Association 63 (324): 1522–1525. doi :10.1080/01621459.1968.10480944 . JSTOR 2285901 . ^ Mercer, A. McD. (2000). "Bounds for A–G, A–H, G–H, and a family of inequalities of Ky Fan's type, using a general method". J. Math. Anal. Appl . 243 (1): 163–173. doi :10.1006/jmaa.1999.6688 . ^ Sharma, R. (2008). "Some more inequalities for arithmetic mean, harmonic mean and variance". J. Math. Inequalities . 2 (1): 109–114. CiteSeerX 10.1.1.551.9397 doi :10.7153/jmi-02-11 . ^ Ronald Fisher (1918) The correlation between relatives on the supposition of Mendelian Inheritance ^ Fama, Eugene F.; French, Kenneth R. (2010-04-21). "Q&A: Semi-Variance: A Better Risk Measure?" . Fama/French Forum . {{cite web }}: CS1 maint: url-status (link )^ Kocherlakota, S.; Kocherlakota, K. (2004). "Generalized Variance". Encyclopedia of Statistical Sciences . Wiley Online Library. doi :10.1002/0471667196.ess0869 . ISBN 0471667196

![{\displaystyle \mu =\operatorname {E} [X]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/ce1b41598b8e8f45f57c1550ebb8d5c7ab8e1210)

![{\displaystyle \operatorname {Var} (X)=\operatorname {E} \left[(X-\mu )^{2}\right].}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/55622d2a1cf5e46f2926ab389a8e3438edb53731)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} \left[(X-\operatorname {E} [X])^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}-2X\operatorname {E} [X]+\operatorname {E} [X]^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}\right]-2\operatorname {E} [X]\operatorname {E} [X]+\operatorname {E} [X]^{2}\\[4pt]&=\operatorname {E} \left[X^{2}\right]-\operatorname {E} [X]^{2}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/4ad35c4161b9cf52868e879d457d8d796094ff02)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)=\sigma ^{2}&=\int _{\mathbb {R} }(x-\mu )^{2}f(x)\,dx\\[4pt]&=\int _{\mathbb {R} }x^{2}f(x)\,dx-2\mu \int _{\mathbb {R} }xf(x)\,dx+\int _{\mathbb {R} }\mu ^{2}f(x)\,dx\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-2\mu \int _{\mathbb {R} }x\,dF(x)+\mu ^{2}\int _{\mathbb {R} }\,dF(x)\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-2\mu \cdot \mu +\mu ^{2}\cdot 1\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-\mu ^{2},\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/2dfe669b6d3626df37e658dd74f047e369ec88ea)

![{\displaystyle [a,b]\subset \mathbb {R} }](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/a659536067aaaac2db1c44613a09a715f0cf7246)

![{\displaystyle \operatorname {E} [X]=\int _{0}^{\infty }\lambda xe^{-\lambda x}\,dx={\frac {1}{\lambda }}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/2fc9d5854b87fd1f6a380b1df34d7d9fffcf9b0b)

![{\displaystyle {\begin{aligned}\operatorname {E} [X^{2}]&=\int _{0}^{\infty }\lambda x^{2}e^{-\lambda x}\,dx\\&=\left[-x^{2}e^{-\lambda x}\right]_{0}^{\infty }+\int _{0}^{\infty }2xe^{-\lambda x}\,dx\\&=0+{\frac {2}{\lambda }}\operatorname {E} [X]\\&={\frac {2}{\lambda ^{2}}}.\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/2588fabdde3366a15fd7befe8a0b84082c04fa47)

![{\displaystyle \operatorname {Var} (X)=\operatorname {E} [X^{2}]-\operatorname {E} [X]^{2}={\frac {2}{\lambda ^{2}}}-\left({\frac {1}{\lambda }}\right)^{2}={\frac {1}{\lambda ^{2}}}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/61e084929116e61ef2607390d2fc0ba169060ca9)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\sum _{i=1}^{6}{\frac {1}{6}}\left(i-{\frac {7}{2}}\right)^{2}\\[5pt]&={\frac {1}{6}}\left((-5/2)^{2}+(-3/2)^{2}+(-1/2)^{2}+(1/2)^{2}+(3/2)^{2}+(5/2)^{2}\right)\\[5pt]&={\frac {35}{12}}\approx 2.92.\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/6b1b6a74f544d9422366dc015805d67149030ec7)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} (X^{2})-(\operatorname {E} (X))^{2}\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}i^{2}-\left({\frac {1}{n}}\sum _{i=1}^{n}i\right)^{2}\\[5pt]&={\frac {(n+1)(2n+1)}{6}}-\left({\frac {n+1}{2}}\right)^{2}\\[4pt]&={\frac {n^{2}-1}{12}}.\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/499bbaffd7153ce9032f21d6a08645a02591092f)

![{\displaystyle f(x\mid a,b)={\begin{cases}{\frac {1}{b-a}}&\mathrm {for} \ a\leq x\leq b,\\[8pt]0&\mathrm {for} \ x<a\ \mathrm {or} \ x>b\end{cases}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/02cd0f1b19309585de2d1d8f0d9be0ab2d6e6ad2)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} [(X+Y)^{2}]-(\operatorname {E} [X+Y])^{2}\\[5pt]&=\operatorname {E} [X^{2}+2XY+Y^{2}]-(\operatorname {E} [X]+\operatorname {E} [Y])^{2}.\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/aaaff2b45438d2d3b2b7b871a22172410f1ad838)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} [X^{2}]+2\operatorname {E} [XY]+\operatorname {E} [Y^{2}]-(\operatorname {E} [X]^{2}+2\operatorname {E} [X]\operatorname {E} [Y]+\operatorname {E} [Y]^{2})\\[5pt]&=\operatorname {E} [X^{2}]+\operatorname {E} [Y^{2}]-\operatorname {E} [X]^{2}-\operatorname {E} [Y]^{2}\\[5pt]&=\operatorname {Var} (X)+\operatorname {Var} (Y).\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/66abdfcab0297cc33b03880b44fa68fca5d83872)

![{\displaystyle {\begin{aligned}\operatorname {Var} (XY)&=[\operatorname {E} (X)]^{2}\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2}\operatorname {Var} (X)+\operatorname {Var} (X)\operatorname {Var} (Y).\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/16469e09583d6883bb5e28639939b2a4f14c5435)

![{\displaystyle \operatorname {Var} (XY)=\operatorname {E} (X^{2})\operatorname {E} (Y^{2})-[\operatorname {E} (X)]^{2}[\operatorname {E} (Y)]^{2}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/5542bf0e4e8a6553ce4b2283b91160208ead6ab4)

![{\displaystyle {\begin{aligned}\operatorname {Var} (XY)={}&\operatorname {E} [X^{2}Y^{2}]-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} (X^{2},Y^{2})+\operatorname {E} (X^{2})\operatorname {E} (Y^{2})-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} (X^{2},Y^{2})+(\operatorname {Var} (X)+[\operatorname {E} (X)]^{2})(\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2})\\[5pt]&{}-[\operatorname {Cov} (X,Y)+\operatorname {E} (X)\operatorname {E} (Y)]^{2}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/5cf52cafcb57f318cd8800340108665b6dfb3185)

![{\displaystyle \operatorname {Var} [X]=\operatorname {E} (\operatorname {Var} [X\mid Y])+\operatorname {Var} (\operatorname {E} [X\mid Y]).}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/d096b66af734c89681ab5cb61b24fbea63a48669)

![{\displaystyle \operatorname {E} (\operatorname {Var} [X\mid Y])=\sum _{i}p_{i}\sigma _{i}^{2},}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/dc52b9938aac880c80b76dfe0bacc302c1d0f1d3)

![{\displaystyle \sigma _{i}^{2}=\operatorname {Var} [X\mid Y=y_{i}]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/5f02e555171b20f14167f31a43ad480f720a6fa6)

![{\displaystyle \operatorname {Var} (\operatorname {E} [X\mid Y])=\sum _{i}p_{i}\mu _{i}^{2}-\left(\sum _{i}p_{i}\mu _{i}\right)^{2}=\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2},}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/069ee9f564216faf173487039b77447b1ef07da2)

![{\displaystyle \mu _{i}=\operatorname {E} [X\mid Y=y_{i}]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/0df777aa646f81fb52b31a3e13f983747fac39dd)

![{\displaystyle \operatorname {Var} [X]=\sum _{i}p_{i}\sigma _{i}^{2}+\left(\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2}\right).}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/5653ed0b0a55e26b4763766d3e118bc05ed569f4)

![{\displaystyle \operatorname {Var} \left[f(X)\right]\approx \left(f'(\operatorname {E} \left[X\right])\right)^{2}\operatorname {Var} \left[X\right]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/8c58412ffa8fdf818b89bafb3318c4ace7cd8e9b)

![{\displaystyle {\begin{aligned}\sigma ^{2}&={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}-\mu \right)^{2}={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}^{2}-2\mu x_{i}+\mu ^{2}\right)\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-2\mu \left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)+\mu ^{2}\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\mu ^{2}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/e37c1ee507b7c4281e55b812bc3cc4f9b29f490c)

![{\displaystyle {\begin{aligned}{\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}-x_{j}\right)^{2}&={\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}^{2}-2x_{i}x_{j}+x_{j}^{2}\right)\\[5pt]&={\frac {1}{2N}}\sum _{j=1}^{N}\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}\right)\\[5pt]&\quad +{\frac {1}{2N}}\sum _{i=1}^{N}\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}^{2}\right)\\[5pt]&={\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)-\mu ^{2}+{\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)\\[5pt]&=\sigma ^{2}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/df68fc666921dd44fea9b6cb04271f239140f4d3)

![{\displaystyle {\begin{aligned}\operatorname {E} [\sigma _{Y}^{2}]&=\operatorname {E} \left[{\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\frac {1}{n}}\sum _{j=1}^{n}Y_{j}\right)^{2}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\operatorname {E} \left[Y_{i}^{2}-{\frac {2}{n}}Y_{i}\sum _{j=1}^{n}Y_{j}+{\frac {1}{n^{2}}}\sum _{j=1}^{n}Y_{j}\sum _{k=1}^{n}Y_{k}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}\operatorname {E} [Y_{i}^{2}]-{\frac {2}{n}}\sum _{j\neq i}\operatorname {E} [Y_{i}Y_{j}]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\sum _{k\neq j}^{n}\operatorname {E} [Y_{j}Y_{k}]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\operatorname {E} [Y_{j}^{2}]\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}(\sigma ^{2}+\mu ^{2})-{\frac {2}{n}}(n-1)\mu ^{2}+{\frac {1}{n^{2}}}n(n-1)\mu ^{2}+{\frac {1}{n}}(\sigma ^{2}+\mu ^{2})\right]\\[5pt]&={\frac {n-1}{n}}\sigma ^{2}.\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/587c23d5bb641523e823629ee7d68f4751fa7db0)

![{\displaystyle \operatorname {Var} [s^{2}]=\operatorname {Var} \left({\frac {\sigma ^{2}}{n-1}}\chi _{n-1}^{2}\right)={\frac {\sigma ^{4}}{(n-1)^{2}}}\operatorname {Var} \left(\chi _{n-1}^{2}\right)={\frac {2\sigma ^{4}}{n-1}}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/d1240e22b54bede05c0d8ab0c9a0479a5583e222)

![{\displaystyle \operatorname {E} [s^{2}]=\sigma ^{2},\quad \operatorname {Var} [s^{2}]={\frac {\sigma ^{4}}{n}}\left((\kappa -1)+{\frac {2}{n-1}}\right)={\frac {1}{n}}\left(\mu _{4}-{\frac {n-3}{n-1}}\sigma ^{4}\right),}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/836f92da5719c874e2f8c61bc0bf2ece4c8fb7ea)

![{\displaystyle \operatorname {E} \left[(x-\mu )(x-\mu )^{*}\right]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/bb62b4d8683749664cb8df919f0726880ca928d0)

![{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\operatorname {T} }\right]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/bf542b139aefb337f7168452be1c805c3db4b93d)

![{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\dagger }\right]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/0af6c7c8ae123d49fd9b41d28cb6399b62012743)

![{\displaystyle \operatorname {E} \left[(X-\mu )^{\operatorname {T} }(X-\mu )\right]=\operatorname {tr} (C)}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/e876754196a6c8e415b0676542c344831f502764)