Standard deviation

통계학(statistics)에서, 표준 편차(standard deviation)는 값의 집합의 변화 또는 산포도(dispersion)의 양의 측정입니다.[1] 낮은 표준 편차는 집합의 (기댓값이라고 역시 불리는) 평균(mean)에 가까워지는 경향이 있지만, 높은 표준 편차는 그 값이 더 넓은 범위에 펼쳐져 있음을 나타냅니다.

표준 편차는 SD로 축약될 수 있고, 모집단 표준 편차에 대해 소문자 그리스 문자 시그마 σ, 또는 표본 표준 편차에 대해 라틴 문자 s로 수학 텍스트 및 방정식에서 가장 공통적으로 표시됩니다. (과학과 수학에서 기호 σ의 다른 사용에 대해 주요 기사를 참조하십시오.)

확률 변수(random variable), 통계적 모집단(statistical population), 데이터 집합(data set), 또는 확률 분포(probability distribution)의 표준 편차는 그의 분산(variance)의 제곱근(square root)입니다. 그것은, 평균 절대 편차(average absolute deviation)보다, 비록 실제로는 덜 건장(robust)하지만 대수적(algebraically)으로 더 간단합니다.[2][3] 표준 편차의 유용한 속성은, 분산과 달리, 데이터와 같은 단위로 표현된다는 것입니다.

모집단의 변동가능성을 표현하는 것 외에도, 표준 편차는 공통적으로 통계적 추론에서 신뢰도를 측정하기 위해서 사용됩니다. 예를 들어, 여론 조사(opinion poll) 데이터에서 오차의 한계(margin of error)는, 만약 같은 여론-조사가 여러 번 수행되면, 결과에서 예상된 표준 편차를 계산하는 것에 의해 결정됩니다. 표준 편차의 이러한 유도는 추정의 "표준 오차" 또는 평균을 언급할 때 "평균의 표준 오차"라고 역시 불립니다. 그것은, 만약 표본의 무한 숫자가 추출되고 각 표본에 대해 평균이 계산되면, 해당 모집단으로부터 계산되어야 하는 모든 평균의 표준 편차로써 계산됩니다.

모집단의 표준 편차와 (평균과 같은) 그 모집단에서 파생된 통계량의 표준 오차는 상당히 다르지만 관련됩니다 (관측의 숫자의 제곱근의 역에 의해 관련됩니다). 여론-조사의 보고된 오차의 한계는 평균의 표준 오차로부터 (또는 대안적으로 모집단의 표준 편차와 표본 크기의 제곱근의 역수의 곱으로부터, 이것은 같은 것입니다) 계산되고 전형적으로 표준 편차의 약 두 배—95% 신뢰 구간(confidence interval)의 절반입니다.

과학에서, 많은 연구자들이 실험 데이터의 표준 편차를 기록하고, 관례에 의해, 영 기댓값으로부터 이 표준 편차 더 떨어진 결과만 오직 통계적으로 유의미한(statistically significant) 것으로 고려됩니다—정규 확률 오차 또는 측정에서 변화는 이런 방법에서 아마도 진정한 효과 또는 결합으로부터 구별됩니다. 표준 편차는 금융에서 역시 중요하며, 여기서 투자의 수익률(rate of return)의 표준 편차는 투자 변동성(volatility)의 측정입니다.

모집단으로부터 오직 데이터의 표본(sample)을 유용할 때, 용어 표본의 표준 편차(standard deviation of the sample) 또는 표본 표준 편차(sample standard deviation)는 그들 데이터에 적용된 위에서-언급된 양 또는 모집단 표준 편차(population standard deviation) (전체 모집단의 표준 편차)의 불편향 추정인 수정된 양을 참조할 수 있습니다.

Basic examples

Sample standard deviation of metabolic rate of northern fulmars

로건은[4] 다음 예제를 제공합니다. 퍼니스(Furness)와 브라이언트(Bryant)는[5] 번식하는 북부 풀마-갈매기(northern fulmar) 8 수컷과 6 암컷에 대해 신진 대사율(metabolic rate)을 측정했습니다. 테이블은 퍼니스 데이터 집합을 보여줍니다.

| Sex | Metabolic rate | Sex | Metabolic rate |

|---|---|---|---|

| Male | 525.8 | Female | 727.7 |

| Male | 605.7 | Female | 1086.5 |

| Male | 843.3 | Female | 1091.0 |

| Male | 1195.5 | Female | 1361.3 |

| Male | 1945.6 | Female | 1490.5 |

| Male | 2135.6 | Female | 1956.1 |

| Male | 2308.7 | ||

| Male | 2950.0 |

그래프는 수컷과 암컷에 대해 대사율을 보여줍니다. 육안 검사에 의해, 대사율의 변동가능성은 암컷보다 수컷에서 더 큰 것으로 보입니다.

암컷 풀마에 대해 대사율의 표본 표준 편차는 다음으로 계산됩니다. 표본 표준 편차에 대해 공식은 다음입니다:

여기서 는 표본 항목의 관측된 값이고, 는 이들 관측의 평균 값이고, N은 표본에서 관측의 숫자입니다.

표본 표준 편차 공식에서, 이 예제에 대해, 분자는 평균 대사율로부터 각 개체 동물의 대사율의 제곱된 편자의 합입니다. 테이블은 암컷 풀마에 대한 제곱된 편차의 이 합의 계산을 보여줍니다. 암컷에 대해, 테이블에 표시된 것처럼, 제곱된 편차의 합은 886047.09입니다.

| Animal | Sex | Metabolic rate | Mean | Difference from mean | Squared difference from mean |

|---|---|---|---|---|---|

| 1 | Female | 727.7 | 1285.5 | -557.8 | 311140.84 |

| 2 | Female | 1086.5 | 1285.5 | -199.0 | 39601.00 |

| 3 | Female | 1091.0 | 1285.5 | -194.5 | 37830.25 |

| 4 | Female | 1361.3 | 1285.5 | 75.8 | 5745.64 |

| 5 | Female | 1490.5 | 1285.5 | 205.0 | 42025.00 |

| 6 | Female | 1956.1 | 1285.5 | 670.6 | 449704.36 |

| Mean of metabolic rates | 1285.5 | Sum of squared differences | 886047.09 | ||

표본 표준 편차 공식에서 분모는 N – 1이며, 여기서 N은 동물의 숫자입니다. 이 예제에서, N = 6 암컷이 있으므로, 분모는 6 – 1 = 5입니다. 암컷 풀마에 대해 표본 표준 편차는 따라서 다음입니다:

수컷 풀마에 대해, 비슷한 계산은 894.37, 근사적으로 암컷에 대해 표준 편자의 두 배의 표본 표준 편차를 제공합니다. 그래프는 암컷과 수컷에 대해 대사율 데이터, 평균 (빨간색 점), 및 표준 편차 (빨간색 직선)를 보여줍니다.

표본 표준 편차의 사용은 이들 14 풀마가 풀마의 더 많은 모집단의 표본임을 의미합니다. 이들 14 풀마가 전체 모집단 (아마도 마지막 14 생존하는 풀마)을 이루면, 표본 표준 편차 대신에, 계산은 모집단 표준 편차를 사용해야 합니다. 모집단 표준 편차 공식에서, 분모는 N − 1 대신에 N입니다. 측정은 전체 모집단에 대해 수행될 수 있는 것은 드물기 때문에, 기본적으로, 통계적 컴퓨터 프로그램(computer program)은 표본 표준 편차를 계산합니다. 마찬가지로, 저널 기사는 달리 명시되지 않은 한 표본 표준 편차를 보고합니다.

Population standard deviation of grades of eight students

관심있는 전체 인구가 특정 학급에서 8명의 학생이라고 가정합니다. 유한 숫자의 집합에 대해, 모집단 표준 편차는 그들의 평균값에서 뺀 값의 제곱된 편차의 평균(average)의 제곱근(square root)을 취함으로써 구해집니다. 8명의 학생 (즉, 통계적 모집단(statistical population))의 학급의 테이블은 다음 8 값입니다:

이들 여덟 데이터 점은 5의 평균을 가집니다:

먼저, 평균으로부터 각 점 데이터의 편차를 계산하고, 각각의 결과를 제곱(square)합니다:

분산(variance)은 이들 값의 평균입니다:

그리고 모집단 표준 편차는 분산의 제곱근과 같습니다:

이 공식은 만약 우리가 시작했던 여덟 값이 전체 모집단을 형성하면 오직 유효합니다. 만약 값이 일부 큰 부모 집단에서 추출한 확률 표본이면 (예를 들어, 2백만 명의 학급에서 무작위이고 독립적으로 선택된 8 학생이면), 우리는 종종 마지막 공식의 분모에서 8 (이것은 n입니다) 대신에 7 (이것은 n − 1입니다)로 나눕니다. 해당 경우에서, 원래 공식의 결과는 표본 표준 편차라고 불립니다. n이 아닌 n − 1로 나누면 더 큰 부모 집단의 분산의 분산의 불-편향 추정을 제공합니다. 이것은 베셀의 보정(Bessel's correction)으로 알려져 있습니다.[6]

Standard deviation of average height for adult men

만약 관심있는 모집단이 근사적으로 정규적으로 분포되면, 표준 편차는 특정 값의 위 또는 아래에 있는 관측의 비율에 대한 정보를 제공합니다. 예를 들어, 미국에서 성인 남성에 대해 평균 키는 약 70인치 (177.8cm)이며 표준 편차는 약 3인치 (7.62cm)입니다. 이것은 대부분의 남성 (정규 분포(normal distribution)를 가정하여, 약 68%)이 평균 (67-73 인치 (67–73인치 (170.18–185.42cm))의 3인치 (7.62cm) – 1 표준 편차 – 이내의 키를 가지고 있고 거의 모든 남성 (약 95 %)는 평균 (64–76인치 (162.56–193.04cm))의 6인치 – 2 표준 편차 – 이내의 키를 가짐을 의미합니다. 만약 표준 편차가 0이면 모든 남성은 정확히 177.8cm 키를 가져야 합니다. 만약 표준 편차가 20인치 (50.8cm)이면, 남성은 약 50–90인치 (127–228.6cm)로 훨씬 더 다양한 키를 가질 것입니다. 그 분포가 정규(normal) (종-모양)라고 가정하면, 3 표준 편차가 연구중인 표본 모집단의 99.7%를 차지합니다. (자세한 내용에 대해 68-95-99.7 규칙 또는 실험 규칙을 참조하십시오.)

Definition of population values

X를 평균 값 μ를 갖는 확률 변수(random variable)로 놓습니다:

여기서 연산자 E는 X의 평균 또는 기댓값(expected value)을 나타냅니다. 그런-다음 X의 표준 편차는 다음 상등입니다:

(기댓값의 속성(properties of expected value)을 사용하여 유도됩니다).

달리 말해서, 표준 편차 σ (시그마)는 X의 분산(variance)의 제곱근입니다; 즉, 그것은 (X − μ)2의 평균 값의 제곱근입니다.

(일변수(univariate)) 확률 분포의 표준 편차는 해당 분포를 가지는 확률 변수의 그것과 같습니다. 모든 확률 분포가 표준 편차를 갖는 것은 아닌데, 왜냐하면 이들 기댓값이 존재할 필요는 없기 때문입니다. 예를 들어, 코시 분포(Cauchy distribution)를 따르는 확률 변수의 표준 편차는 정의되지 않는데 왜냐하면 그의 기댓값 μ가 정의되지 않기 때문입니다.

Discrete random variable

X가, 각 값이 같은 확률을 가지는 것과 함께, 유한 데이터 집합 x1, x2, ..., xN으로부터 무작위 값을 취하는 경우에서, 표준 편차는 다음입니다:

또는, 합(summation) 표기법을 사용하여,

만약, 같은 확률을 가지는 것 대신에, 값이 다른 확률을 가지면, x1이 확률 p1을 가지고, x2가 확률 p2를 가지고, ..., xN이 확률 pN을 가지는 것으로 놓습니다. 이 경우에서, 표준 편차는 다음일 것입니다:

Continuous random variable

확률 밀도 함수(probability density function) p(x)를 갖는 연속 실수-값 확률 변수 X의 표준 편차는 다음입니다:

여기서 적분은 확률 변수 X의 가능한 값의 집합의 범위에 걸쳐 x에 대해 취해진 한정 적분(definite integral)입니다.

분포의 매개-변수 가족(parametric family of distributions)의 경우에서, 표준 편차는 매개-변수의 관점에서 표현될 수 있습니다. 예를 들어, 매개 변수 μ와 σ2를 갖는 로그-정규 분포(log-normal distribution)의 경우에서, 표준 편차는 다음입니다:

Estimation

우리는 모집단의 모든 각 구성원이 표본 추출되는 (표준화된 테스팅(standardized testing)에서 처럼) 경우에서 전체 모집단의 표준 편차를 찾을 수 있습니다. 이를 수행할 수 없는 경우에서, 표준 편차 σ는 모집단에서 추출한 확률 표본을 검사하고 표본의 통계량(statistic)을 계산함으로써 추정되며, 이것은 모집단 표준 편차의 추정으로 사용됩니다. 그러한 통계량은 추정기(estimator)로 불리고, 추정기 (또는 추정기의 값, 즉 추정치)는 표본 표준 편차로 불리고, (아마도 수정자와 함께) s에 의해 표시됩니다.

표본 평균(sample mean)이 많은 바람직한 속성 (불-편향(unbiased), 효율적(efficient), 최대 가능성)을 가진 단순 추정기에 대해, 모집단 평균을 추정하는 경우에서와 달리, 모든 이들 속성을 갖는 표준 편차에 대해 단일 추정기는 없고, 표준 편차의 불-편향 추정은 매우 기술적으로 관련된 문제입니다. 가장 자주, 표준 편차는 아래에 정의된 (N − 1 사용하는) 보정된 표본 표준 편차를 사용하여 추정되고, 이것은 종종 한정자없이 "표본 표준 편차"로 종종 참조됩니다. 어쨌든, 다른 추정기는 다른 관점에서 더 낫습니다; (N을 사용하는) 비-보정된 추정기는 더 낮은 평균 제곱 오차를 산출하지만, (정규 분포에 대해) N − 1.5를 사용하면 편향이 거의 완전히 제거됩니다.

Uncorrected sample standard deviation

(유한 모집단의) 모집단 표준 편차에 대해 공식은, (비록 표본이 추출되는 실제 모집단 크기가 훨씬 더 클 수 있을지라도) 표본 크기를 모집단 크기로 사용하여 표본에 적용될 수 있습니다. sN으로 표시되는 이 추정기는 비-보정된 표본 표준 편차 또는 때때로 (전체 모집단으로 여기는) 표본의 표준 편차로 알려져 있고, 다음처럼 정의됩니다:[citation needed]

여기서 는 표본 항목의 관측된 값이고 는 이들 관측의 평균 값이며, 분모 N은 표본의 크기를 나타냅니다: 이것은 표본 분산의 제곱근이며, 이것은 표본 평균에 대한 제곱된 편차(squared deviations)의 평균입니다.

이것은 일치 추정기(consistent estimator)이고 (표본의 숫자가 무한대로 갈 때 모집단 값에 대한 확률로 수렴합니다), 모집단이 정규적으로 분포될 때의 최대-가능성 추정량(maximum-likelihood estimate)입니다.[citation needed] 어쨌든, 이것은 편향 추정기(biased estimator)인데, 왜냐하면 그 추정은 일반적으로 너무 낮기 때문입니다. 편향은 표본 크기가 증가함에 따라 감소하고, 1/N일 때 차츰 없어지고, 따라서 작거나 알맞은 표본 크기에 대해 가장 중요합니다; 에 대해 편향은 1% 미만입니다. 따라서 매우 큰 표본 크기에 대해, 비-보정된 표본 표준 편차는 일반적으로 받아들일 수 있습니다. 이 추정기는 보정된 표본 표준 편차보다 균등하게 더 작은 평균 제곱 오차(mean squared error)를 가집니다.

Corrected sample standard deviation

만약 편향된 표본 분산 (모집단 분산의 하향-편향된 추정값인 표본의 두 번째 중심 모멘트(central moment))이 모집단의 표준 편차의 추정치를 계산하기 위해 사용되면, 결과는 다음입니다:

여기서 제곱근을 취하는 것은, 제곱근이 오목 함수(concave function)인 것에 기인하여, 옌센의 부등식(Jensen's inequality)에 의해, 더욱이 하향 편향을 설명합니다. 분산에서 편향은 쉽게 보정되지만, 제곱근으로부터 편향은 보정하는 것이 더 어렵고 문제에서 분포에 따라 다릅니다.

분산에 대해 불-편향된 추정기는 s2로 표시되는 불편향 표본 분산을 산출하기 위해 N 대신에 N − 1을 사용하여, 베셀의 보정(Bessel's correction)을 적용함으로써 제공됩니다:

이 추정기는 만약 분산이 존재하고 표본 값이 대체와 함께 독립적으로 추출되면 불-편향입니다. N − 1은 평균으로부터 편차의 벡터, 에서 자유도(degrees of freedom)의 숫자에 해당합니다.

제곱근을 취하면 편향이 다시-발생하며 (왜냐하면 제곱근은 비선형 함수이며, 이것은 기댓값과 교환(commute)되지 않기 때문입니다), s로 표시되는 보정된 표본 표준 편차를 산출합니다:

위에서 설명한 것처럼, s2는 모집단 분산에 대해 불-편향된 추정기이지만, s는, 비록 비-보정된 표본 표준 편차보다 현저하게 덜 편향될지라도, 여전히 모집단 표준 편차에 대해 편향된 추정기입니다. 이 추정기는 공통적으로 사용되고 일반적으로 간단히 "표본 표준 편차"로 알려져 있습니다. 편향은 작은 표본 (10보다 작은 N)에 대해 여전히 클 수 있습니다. 표본 크기가 커질수록, 편향의 양은 감소합니다. 우리는 자세한 정보를 얻고 및 사이의 차이가 더 작게 됩니다.

Unbiased sample standard deviation

표준 편차의 불-편향된 추정(unbiased estimation of standard deviation)에 대해, 평균 및 분산과 달리 모든 분포를 가로질러 작동하는 공식은 없습니다. 대신에, s는 기본으로 사용되고, 불-편향된 추정치를 생성하기 위해 보정 계수에 의해 스케일됩니다. 정규 분포에 대해, 불-편향된 추정기는 s/c4에 의해 주어지며, 여기서 보정 계수 (N에 따라 다름)는 감마 함수(Gamma function)의 관점에서 제공되고, 다음과 같습니다:

이는 표본 표준 편차의 표본화 분포가 (스케일된) 카이 분포(chi distribution)를 따르고, 보정 계수가 카이 분포의 평균이기 때문에 발생합니다.

근사는 N − 1을 N − 1.5로 대체함으로써 얻어질 수 있으며, 다음을 산출합니다:

이 근사에서 오차는 (1/N2로) 이차적으로 감쇠하고, 가장 작은 표본 또는 가장 높은 정밀도를 제외하고 모두 적합합니다: N = 3에 대해 편향은 1.3%이고, N = 9에 대해 편향은 이미 0.1%보다 작습니다. 보다 정확한 근사는 위의 를 로 대체하는 것입니다. [7]

다른 분포에 대해, 올바른 공식은 분포에 따라 다르지만, 엄지의 규칙은 근사의 한층 더 정제를 사용하는 것입니다:

여기서 γ2는 모집단 초과 뾰족(excess kurtosis)를 나타냅니다. 초과 뾰족은 특정 분포에 대해 미리 알려진 것, 또는 데이터로부터 추정될 수 있습니다.[citation needed]

Confidence interval of a sampled standard deviation

우리가 분포를 표본화함으로써 얻은 표준 편차는, 수학적인 이유에 대해 (여기서 신뢰 구간으로 설명됩니다) 및 측정의 실용적인 이유에 대해 (측정 오류) 둘 다, 자체로 절대적으로 정확하지는 않습니다. 수학적 효과는 신뢰 구간(confidence interval) 또는 CI로 설명될 수 있습니다. 표본이 클수록 신뢰 구간이 더 좁아지는 것을 보여주기 위해, 다음 예제를 생각해 보십시오: N = 2의 작은 모집단은 표준 편차를 추정할 오직 1 자유도를 가집니다. 결과는 SD의 95% CI는 0.45 × SD에서 31.9 × SD로 실행합니다; 인수는 여기서 다음과 같습니다:

여기서 는 k 자유도를 갖는 카이-제곱된 분포의 p-번째 분위-숫자이고, 는 신뢰 수준입니다. 이것은 다음과 동등합니다:

k = 1과 함께, 및 입니다. 이들 두 숫자의 제곱근의 역수는 우리에게 위에서 주어진 인수 0.45 및 31.9를 제공합니다.

N = 10의 더 큰 모집단은 표준 편차를 추정하기 위해 9 자유도를 가집니다. 위와 같은 계산은 이 경우에서 0.69 × SD에서 1.83 × SD로 실행하는 95% CI를 제공합니다. 따라서 심지어 10의 표본 모집단과 함께, 실제 SD는 여전히 표본화된 SD보다 거의 인수 2 더 높을 수 있습니다. 표본 모집단 N=100에 대해, 이것은 0.88 × SD에서 1.16 × SD까지 내려갑니다. 표본화된 SD가 실제 SD에 가깝다는 것을 보다 확신하기 위해 우리는 많은 숫자의 점을 표본화해야 합니다.

이들 같은 공식은 표준 정규 이론 아래에서 적합한 최소 제곱(least squares)으로부터 잔여의 분산에 대한 신뢰 구간을 얻기 위해 사용되며, 여기서 k는 이제 오류에 대해 자유도(degrees of freedom)의 숫자입니다.

Bounds on standard deviation

값 R의 범위를 스패닝하는 N > 4 데이터의 집합에 대해, 표준 편차 s의 위쪽 경계는 s = 0.6R에 의해 제공됩니다.[8] 근사적으로 정규인 것으로 취해지는 N > 100 데이터에 대해 표준 편차의 추정은 정규 곡선 아래 넓이의 95%가 평균의 양쪽에 대해 대략 이 표준 편차에 놓이는 것, 따라서 95% 확률과 함께 값 R의 총 범위는 s ≈ R/4를 만족하는 사 표준 편차를 나타내는 것을 휴리스틱으로부터 따릅니다. 이 소위 범위 규칙은 표본 크기(sample size) 추정에서 유용한데, 왜냐하면 가능한 값의 범위는 표준 편차보다 추정하기 쉽기 때문입니다. s ≈ R/K(N)을 만족하는 범위의 다른 제수 K(N)은 N의 다른 값에 대해 및 비-정규 분포에 대해 유효합니다. [9]

Identities and mathematical properties

표준 편차는 위치(location)에서 변화 아래에 불변이고, 확률 변수의 스케일(scale)과 함께 직접 스케일됩니다. 따라서 상수 c 및 확률 변수 X와 Y에 대해:

두 확률 변수의 합의 표준 편차는 그들의 개별적인 표준 편차와 그들 사이의 공분산(covariance)과 관련될 수 있습니다:

여기서 과 는, 각각, 분산과 공분산(covariance)을 나타냅니다.

제곱된 편차의 합의 계산은 데이터로부터 직접 계산된 모멘트(moment)와 관련될 수 있습니다. 다음 공식에서, 문자 E는 기댓값, 즉, 평균을 의미하는 것으로 해석됩니다.

표본 표준 편차는 다음을 계산될 수 있습니다:

모든 점에서 같은 확률을 갖는 유한 모집단에 대해, 우리는 다음을 가집니다:

이것은 표준 편차가 값의 제곱의 평균과 평균 값의 제곱 사이의 차이의 제곱근과 같음을 의미합니다. 증명에 대한 분산에 대해, 및 표본 표준 편차에 대한 유사한 결과에 대해 계산 공식을 참조하십시오.

Interpretation and application

큰 표준 편차는 데이터 점이 평균에서 멀리 펼쳐질 수 있음을 가리키고 작은 표준 편차는 그들이 평균 주위에 밀집되어 떼를 짓게 됨을 가리킵니다.

예를 들어, 세 모집단 {0, 0, 14, 14}, {0, 6, 8, 14} 및 {6, 6, 8, 8}의 각각은 7의 평균을 가집니다. 그들의 표준 편차는, 각각, 7, 5, 및 1입니다. 세 번째 모집단은 다른 둘 보다 훨씬 더 작은 표준 편차를 가지는데 왜냐하면 그의 값들은 모두 7에 가깝기 때문입니다. 이들 표준 편차는 데이터 점들 자체와 같은 단위를 가집니다. 만약, 예를 들어, 데이터 집합 {0, 6, 8, 14}이 연도에서 네 형제의 모집단의 나이를 나타내면, 표준 편차는 5년입니다. 또 다른 예제로써, 모집단 {1000, 1006, 1008, 1014}은 미터에서 측정된 네 명의 운동선수에 의해 이동한 거리를 나타낼 수 있습니다. 그것은 1007 미터의 평균을 가지고, 5 미터의 표준 편차를 가집니다.

표준 편차는 불확실성의 측정으로 역할을 할 수 있습니다. 물리적 과학에서, 예를 들어, 반복된 측정(measurement)의 그룹의 보고된 표준 편차는 그들의 측정의 정밀도(precision)를 제공합니다. 측정이 이론적 예측과 일치하는지 여부를 결정할 때, 그들의 측정의 표준 편차는 결정적인 중요의 것입니다: 만약 측정의 평균이 (표준 편차로 측정된 거리와 함께) 예측에서 너무 멀리 떨어져 있으면, 테스트될 이론이 개정되어야 합니다. 이것은 의미가 있는데 왜냐하면 그들이, 만약 예측이 정확하고 표준 편차가 적절하게 정량화되면, 합리적으로 발생할 것으로 예상되는 값의 범위 밖으로 떨어지기 때문입니다. 예측 구간(prediction interval)을 참조하십시오.

표준 편차는 전형적으로 값이 평균에서 얼마나 멀리 떨어져 있는지를 측정하지만, 다른 측정이 유효합니다. 에제는 평균 절대 편차(mean absolute deviation)이며, 이것은 표준 편차에서 내재된 제곱근 평균 제곱 거리(root mean square distance)와 비교되는, 평균 거리의 보다 직접적인 측정으로 여길 수 있습니다.

Application examples

값의 집합의 표준 편차를 이해하는 실용적인 값은 평균으로부터 있는 얼마나 많은 변화를 인식하는 것에 있습니다.

Experiment, industrial and hypothesis testing

표준 편차는 종종 실-세계 데이터를 모델과 비교하여 모델을 테스트하기 위해 사용됩니다. 예를 들어, 산업상의 응용에서 생산 라인에서 나오는 제품의 무게는 법적으로 요구되는 값을 준수해야 합니다. 제품의 일부를 무게를 달아서 평균 무게가 구할 수 있으며, 이것은 항상 장기 평균과 약간 다를 수 있습니다. 표준 편차를 사용함으로써, 최솟값과 최댓값이 평균 무게가 시간의 일부 매우 높은 백분율 (99.9% 이상) 안에 있는 것으로 계산될 수 있습니다. 만약 그것이 범위의 밖으로 떨어지면 생산 공정은 수정할 필요가 있습니다. 이와 같은 통계적 테스트는 테스팅이 상대적으로 비쌀 때 특히 중요합니다. 예를 들어, 만약 제품이 열리고 배수하고 무게를 다는 것, 또는 만약 제품이 테스트에서 달리 사용될 것이면 등이 있습니다.

실험 과학에서, 현실의 이론적 모델이 사용됩니다. 입자 물리학(Particle physics)은 전통적으로 발견의 선언에 대해 "5 시그마"의 표준을 사용합니다.[10] 5-시그마 수준은 무작위 변동이 결과를 산출할 수 있는 350만 개에서 하나의 기회로 해석합니다. 확실성의 이 수준은 힉스 보손(Higgs boson)과 일치하는 입자가 CERN에서 두 독립적인 실험에서 발견되었다고 주장하기 위해 요구되었고,[11] 이것은 역시 중력파의 첫 탐지의 선언으로 이어지는 중요성 수준이었습니다.[12]

Weather

간단한 예로, 내륙과 해안에 있는, 두 도시에 대해 평균 일일 최대 온도를 생각해 보십시오. 해안 근처 도시에 대해 일일 최대 온도의 범위는 내륙 도시에 대한 것보다 더 낮다는 것을 이해하는 것에 도움이 됩니다. 따라서 이들 두 도시는 같은 평균 최대 온도를 각각 가질 수 있지만, 해안 도시에 대해 일일 최대 온도의 표준 편차는 내륙 도시의 표준 편차보다 낮을 것인데, 왜냐하면, 임의의 특정 날짜에서, 실제 최대 온도는 해안 도시보다 내륙 도시의 평균 최대 온도에서 더 멀어질 가능성이 높기 때문입니다.

Finance

금융에서, 표준 편차는 주어진 자산 (주식, 채권, 소유권, 등)의 가격-변동과 관련된 위험(risk), 또는 자산의 포트폴리오의 위험[13] (활성으로 관리되는 상호 펀드, 인덱스 상호 펀드, 또는 ETF)의 측정으로 종종 사용됩니다. 위험은 자산 및/또는 포트폴리오의 수익에서 변동을 결정하고 투자자에게 투자 결정에 대해 (평균-분산 최적화(mean-variance optimization)로 알려진) 수학적 기초를 제공하기 때문에 투자의 포트폴리오를 효율적으로 관리하는 방법을 결정하는 것에서 중요한 요소입니다. 위험의 기본 개념은 투자가 증가함에 따라 투자에 대한 예상된 수익도 증가해야 하며, 이것은 위험 할증금으로 알려진 것입니다. 다시 말해서, 투자자는 해당 투자가 더 높은 위험의 수준 또는 불확실성을 수반할 때 투자에 대한 더 높은 수익을 기대해야 합니다. 투자를 평가할 때, 투자자는 예상된 수익과 미래 수익의 불확실성 둘 다를 추정해야 합니다. 표준 편차는 미래 수익의 불확실성의 정량화된 추정을 제공합니다.

예를 들어, 투자자가 두 주식 사이에 선택해야 한다고 가정하십시오. 지난 20년에 걸쳐 주식 A는 20 퍼센트 포인트(percentage point, 줄여서 pp)의 표준 편차와 함께, 10 퍼센트의 평균 수익률을 가졌고, 주식 B는 같은 기간에 걸쳐 12%의 평균 수익률을 가지지만 30 pp의 더 높은 표준 편차를 가집니다. 위험과 수익에 기초하여, 투자자는 주식 A가 더 안전한 선택이라고 결정할 수 있는데, 왜냐하면 주식 B의 추가적인 2%의 수익률은 추가적인 10 pp 표준 편차 (예상된 수익의 더 큰 위험 또는 불확실성)의 가치가 없기 때문입니다. 주식 B는 같은 상황 아래에서 주식 A보다 보다 종종 초기 투자의 짧게 떨어질 것 같고 (그러나 역시 초기 투자를 초과할 가능성도 있음), 평균에서 오직 2%를 반환할 것으로 예상됩니다. 이 예제에서, 주식 A는 약 10 퍼센트, 더하기 또는 빼기 20 pp (30 퍼센트에서 −10 퍼센트 범위), 미래 년도 수익률의 약 2/3의 수익을 올릴 것으로 예상됩니다. 미래에 보다 극단적인 가능한 수익 또는 결과를 고려할 때, 투자자는 평균 수익률에서 삼 표준 편차 (가능한 수익의 약 99.7 퍼센트)에 대한 결과를 포함하는 10 퍼센트 더하기 또는 빼기 60 pp 만큼의 결과, 또는 70 퍼센트에서 −50 퍼센트의 범위의 결과를 기대해야 합니다.

주어진 기간에 걸쳐 유가-증권의 수익률의 평균 (또는 산술 평균)을 계산하면 자산의 예상된 수익률이 생성될 것입니다. 각 기간에 대해, 실제 수익에서 예상된 수익을 빼면 평균에서 차이를 초래합니다. 각 기간에서 차이를 제곱하고 평균을 취하면 자산의 수익의 전체 분산을 초래합니다. 분산이 커질수록 더 큰 위험을 유가-증권이 지닙니다. 이 분산의 제곱근을 찾으면 문제에서 투자 도구의 표준 편차를 제공할 것입니다.

모집단 표준 편차는 볼린저 밴드(Bollinger Bands), 널리 채택된 기술 분석(technical analysis) 도구의 너비를 설정하기 위해 사용됩니다. 예를 들어, 위쪽 볼린저 밴드는 x + nσx로 제공됩니다. n에 대해 가장 공통적으로 사용되는 값은 2입니다; 수익률의 정규 분포를 가정하여, 밖으로 나가는 약 5 퍼센트 가능성이 있습니다.

재무 시간 급수는 비-정류 급수로 알려져 있지만, 표준 편차와 같은 위의 통계적 계산은 오직 정류 급수에 적용됩니다. 위의 통계적 도구를 비-정류 급수에 적용하기 위해, 급수는 먼저 정류 급수로 변환되어야 하며, 이제 그것으로부터 작업하기 위한 유효한 기반을 가지는 통계적 도구의 사용을 활성화합니다.

Geometric interpretation

기하학적 통찰력과 설명을 얻기 위해, 우리는 세 값, x1, x2, x3으로 시작할 것입니다. 이것은 R3에서 점 P = (x1, x2, x3)을 정의합니다. 직선 L = {(r, r, r) : r ∈ R}을 생각해 보십시오. 이것이 원점을 통과해서 지나는 "주 대각선"입니다. 만약 세 주어진 값이 모두 같으면, 표준 편차는 0이 되어야 하고 P는 L 위에 놓이게 됩니다. 따라서 표준 편차가 P와 L의 거리와 관련이 있다고 가정하는 것은 부당하지 않습니다. L에서 점 P으로의 직교적으로 이동하기 위해, 우리는 다음 점에서 시작합니다:

그의 좌표는 우리가 시작한 값의 평균입니다.

의 유도

|

|---|

|

은 위에 있으며 따라서 일부 에 대해 입니다. 직선 은 에서 로의 벡터와 직교가 됩니다. 그러므로: |

작은 대수는 P와 M 사이의 거리 (이것은 P와 직선 L 사이의 수직 거리와 같습니다) 은, 벡터의 차원의 숫자 (이 경우에서 3)의 제곱근에 곱해진, 벡터 (x1, x2, x3)의 표준 편차와 같습니다.

Chebyshev's inequality

관측은 평균에서 약간의 표준 편차를 벗어나는 것은 드뭅니다. 체비쇼프의 부등식은, 표준 편차가 정의된 모든 분포에 대해 평균의 표준 편차의 숫자 이내에서 데이터의 양은 적어도 다음 테이블에서 주어진 양만큼 입니다.

| 평균으로부터 거리 | 최소 모집단 |

|---|---|

| 50% | |

| 2σ | 75% |

| 3σ | 89% |

| 4σ | 94% |

| 5σ | 96% |

| 6σ | 97% |

| [14] | |

Rules for normally distributed data

중심 극한 정리(central limit theorem)는 많은 독립, 동일하게 분포된 확률 변수의 평균의 분포가 다음의 확률 밀도 함수(probability density function)를 갖는 유명한 종-모양 정규 분포를 향하는 경향임을 나타냅니다:

여기서 μ는 확률 변수의 기댓값(expected value), σ는 n1/2에 의해 표시되는 그들 분포의 표준 편차이고, n은 확률 변수의 숫자입니다. 표준 편차는, 비록 그것이 정규화 상수(normalizing constant)에서 역시 나타날지라도, 따라서 곡선이 얼마나 넓은지를 조정하는 간단한 스케일링 변수입니다.

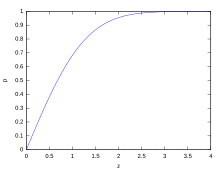

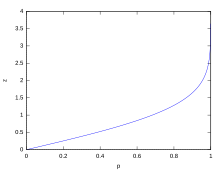

만약 데이터 분포가 근사적으로 정규이면, 평균의 z 표준 편차 이내에서 데이터 값의 비율은 다음에 의해 정의됩니다:

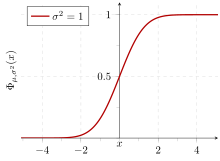

여기서 는 오차 함수(error function)입니다. 숫자 x보다 작거나 같은 비율은 누적 분포 함수(cumulative distribution function)에 의해 제공됩니다:

- .[15]

만약 데이터 분포가 근사적으로 정규이면 데이터 값의 약 68 퍼센트가 평균의 일 표준 편차 이내에 (수학적으로, μ ± σ이며, 여기서 μ는 산술 평균입니다), 약 95 퍼센트가 이 표준 편차 이내에 (μ ± 2σ), 및 약 99.7 퍼센트가 삼 표준 편차 이내에 (μ ± 3σ) 놓입니다. 이것은 68-95-99.7 규칙, 또는 경험적인 규칙으로 알려져 있습니다.

z의 다양한 값에 대해, 대칭 구간 내부 및 외부에 있을 것으로 예상되는 값의 백분율, CI = (−zσ, zσ)는 다음과 같습니다:

| 신뢰 구간 |

퍼센트 이내에 | 퍼센트 외부에 | |

|---|---|---|---|

| 비율 | 비율 | 분수 | |

| 0.318 639σ | 25% | 75% | 3 / 4 |

| 0.674490σ | 50% | 50% | 1 / 2 |

| 0.977925σ | 66.6% | 33.3% | 1 / 3 |

| 0.994458σ | 68% | 32% | 1 / 3.125 |

| 1σ | 68.2689492% | 31.7310508% | 1 / 3.1514872 |

| 1.281552σ | 80% | 20% | 1 / 5 |

| 1.644854σ | 90% | 10% | 1 / 10 |

| 1.959964σ | 95% | 5% | 1 / 20 |

| 2σ | 95.4499736% | 4.5500264% | 1 / 21.977895 |

| 2.575829σ | 99% | 1% | 1 / 100 |

| 3σ | 99.7300204% | 0.2699796% | 1 / 370.398 |

| 3.290527σ | 99.9% | 0.1% | 1 / 1000 |

| 3.890592σ | 99.99% | 0.01% | 1 / 10000 |

| 4σ | 99.993666% | 0.006334% | 1 / 15787 |

| 4.417173σ | 99.999% | 0.001% | 1 / 100000 |

| 4.5σ | 99.9993204653751% | 0.0006795346249% | 1 / 147159.5358 6.8 / 1000000 |

| 4.891638σ | 99.9999% | 0.0001% | 1 / 1000000 |

| 5σ | 99.9999426697% | 0.0000573303% | 1 / 1744278 |

| 5.326724σ | 99.99999% | 0.00001% | 1 / 10000000 |

| 5.730729σ | 99.999999% | 0.000001% | 1 / 100000000 |

| 6σ | 99.9999998027% | 0.0000001973% | 1 / 506797346 |

| 6.109410σ | 99.9999999% | 0.0000001% | 1 / 1000000000 |

| 6.466951σ | 99.99999999% | 0.00000001% | 1 / 10000000000 |

| 6.806502σ | 99.999999999% | 0.000000001% | 1 / 100000000000 |

| 7σ | 99.9999999997440% | 0.000000000256% | 1 / 390682215445 |

Relationship between standard deviation and mean

데이터의 집합의 평균 및 표준 편차는 보통 함께 보고되는 기술 통계학(descriptive statistics)입니다. 어떤 의미에서, 표준 편차는 만약 데이터의 중심이 평균에 대해 측정되면 통계적 산포도(statistical dispersion)의 "자연적인" 측정입니다. 이것은 평균으로부터 표준 편차가 임의의 다른 점보다 작기 때문입니다. 정확한 설명은 다음입니다: x1, ..., xn이 실수이고 다음 함수를 정의한다고 가정합니다:

미적분학(calculus)을 사용 또는 제곱식을 완성(completing the square)에 의해, σ(r)이 평균에서 유일한 최솟값을 가짐을 보이는 것이 가능합니다:

변동가능성은 변화의 계수(coefficient of variation)에 의해 역시 측정될 수 있으며, 이것은 평균에 대한 표준 편차의 비율입니다. 그것은 무-차원 숫자(dimensionless number)입니다.

Standard deviation of the mean

종종, 우리는 우리가 얻은 평균의 정밀도에 대한 일부 정보를 원합니다. 우리는 표본 평균의 표준 편차를 결정함으로써 이를 얻을 수 있습니다. 표본에서 값의 통계적 독립을 가정하여, 평균의 표준 편차는 다음에 의해 분포의 표준 편차와 관련됩니다:

여기서 N은 평균을 추정하기 위해 표본에서 관측의 숫자입니다. 이것은 다음과 함께 쉽게 입증될 수 있습니다 (분산의 기본 속성(basic properties of the variance)을 참조하십시오):

(통계적 독립성이 가정됩니다.)

따라서

다음을 초래합니다:

평균 의 표준 편차를 추정하기 위해, 미리 전체 모집단 의 표준 편차를 알아야 합니다. 어쨌든, 대부분의 응용에서, 이 매개-변수는 미지수입니다. 예를 들어, 만약 이전에 미지수 양의 10 측정의 급수가 실험실에서 수행되면, 결과 표본 평균 및 표본 표준 편차를 계산하는 것이 가능하지만, 평균의 표준 편차를 계산하는 것은 불가능입니다.

Rapid calculation methods

다음 두 공식은 실행하는 (반복적으로 업데이트된) 표준 편차를 나타낼 수 있습니다. 두 거듭제곱 합 s1과 s2의 집합은 x1, ..., xN으로 표시되는 x의 N 값의 집합에 걸쳐 계산됩니다:

이들 실행하는 합의 결과를 고려할 때, 값 N, s1, s2는 실행하는 표준 실행 편차의 현재 값을 계산하기 위해 언제든지 사용될 수 있습니다.

여기서 N은, 위에서 언급한 것처럼, 값의 집합의 크기입니다 (또는 s0로 역시 여길 수 있습니다).

비슷하게 표본 표준 편차에 대해,

컴퓨터 구현에서, 세 sj 합이 점점 커질 때, 우리는 반올림 오차(round-off error), 산술 오버플로(arithmetic overflow), 및 산술 언더플로(arithmetic underflow)를 고려해야 합니다. 아래의 방법은 감소된 반올림 오류와 함께 실행하는 합 방법을 계산합니다.[16] 이것은 계산 동안 이전 데이터를 저장할 필요없이 n 표본의 분산을 계산하기 위한 "원 패스" 알고리듬입니다. 이 방법을 시간 급수에 적용하면, n이 일정한-너비 슬라이딩 윈도우 계산이 아닌 각 새로운 표본과 함께 커져갈 때 n 데이터 점에 해당하는 표준 편차의 연속적인 값을 초래할 것입니다.

k = 1, ..., n에 대해:

여기서 A는 평균 값입니다.

주목: 인데 왜냐하면 또는 이기 때문입니다.

표본 분산:

모집단 분산:

Weighted calculation

값 xi가 같지-않은 가중 wi와 함께 가중될 때, 거듭제곱 합 s0, s1, s2는 각각 다음으로 계산됩니다:

그리고 표준 편차 방정식은 변경없이 남겨집니다. s0는 이제 가중의 합이고 표본 N의 숫자가 아닙니다.

감소된 반올림 오류를 갖는 증분 방법은 일부 추가적인 복잡성과 함께 역시 적용될 수 있습니다.

가중의 실행하는 값은 1에서 n까지 각 k에 대해 계산되어야 합니다:

그리고 위의 1/n이 사용되는 장소는 wi/Wn에 의해 대체되어야 합니다:

마지막 나눗셈에서,

및

또는

여기서 n은 원소의 전체 숫자이고, n'은 비-영 가중을 갖는 원소의 숫자입니다. 위의 공식은 만약 가중이 일과 같은 것으로 취해지면 위에서 주어진 더 간단한 공식과 같습니다.

History

용어 표준 편차는 1894년 칼 피어슨(Karl Pearson)에 의해 문서에서 처음으로 사용되었으며, 뒤이어 강의에서 그것을 사용합니다.[17][18] 이것은 같은 아이디어에 대해 이전의 대안적인 이름을 대체한 것이었습니다: 예를 들어 가우스(Gauss)는 평균 오류를 사용했습니다.[19]

See also

- 68–95–99.7 rule

- Accuracy and precision

- Chebyshev's inequality An inequality on location and scale parameters

- Cumulant

- Deviation (statistics)

- Distance correlation Distance standard deviation

- Error bar

- Geometric standard deviation

- Mahalanobis distance generalizing number of standard deviations to the mean

- Mean absolute error

- Pooled standard deviation

- Propagation of uncertainty

- Percentile

- Raw score

- Relative standard deviation

- Robust standard deviation

- Root mean square

- Sample size

- Samuelson's inequality

- Six Sigma

- Standard error

- Standard score

- Volatility (finance)

- Yamartino method for calculating standard deviation of wind direction

References

- ^ Bland, J.M.; Altman, D.G. (1996). "Statistics notes: measurement error". BMJ. 312 (7047): 1654. doi:10.1136/bmj.312.7047.1654. PMC 2351401. PMID 8664723.

- ^ Gauss, Carl Friedrich (1816). "Bestimmung der Genauigkeit der Beobachtungen". Zeitschrift für Astronomie und Verwandte Wissenschaften. 1: 187–197.

- ^ Walker, Helen (1931). Studies in the History of the Statistical Method. Baltimore, MD: Williams & Wilkins Co. pp. 24–25.

- ^ Logan, Murray (2010), Biostatistical Design and Analysis Using R (First ed.), Wiley-Blackwell

- ^ Furness, R.W.; Bryant, D.M. (1996). "Effect of wind on field metabolic rates of breeding northern fulmars". Ecology. 77 (4): 1181–1188. doi:10.2307/2265587. JSTOR 2265587.

- ^ Weisstein, Eric W. "Bessel's Correction". MathWorld.

- ^ Gurland, John; Tripathi, Ram C. (1971), "A Simple Approximation for Unbiased Estimation of the Standard Deviation", The American Statistician, 25 (4): 30–32, doi:10.2307/2682923, JSTOR 2682923

- ^ Shiffler, Ronald E.; Harsha, Phillip D. (1980). "Upper and Lower Bounds for the Sample Standard Deviation". Teaching Statistics. 2 (3): 84–86. doi:10.1111/j.1467-9639.1980.tb00398.x.

- ^ Browne, Richard H. (2001). "Using the Sample Range as a Basis for Calculating Sample Size in Power Calculations". The American Statistician. 55 (4): 293–298. doi:10.1198/000313001753272420. JSTOR 2685690.

- ^ "What does the 5 sigma mean?". Physics.org. Retrieved 2019-02-05.

- ^ "CERN experiments observe particle consistent with long-sought Higgs boson | CERN press office". Press.web.cern.ch. 2012-07-04. Retrieved 2015-05-30.

- ^ LIGO Scientific Collaboration, Virgo Collaboration (2016), "Observation of Gravitational Waves from a Binary Black Hole Merger", Physical Review Letters, 116 (6): 061102, arXiv:1602.03837, Bibcode:2016PhRvL.116f1102A, doi:10.1103/PhysRevLett.116.061102, PMID 26918975

- ^ "What is Standard Deviation". Pristine. Retrieved 2011-10-29.

- ^ Ghahramani, Saeed (2000). Fundamentals of Probability (2nd ed.). New Jersey: Prentice Hall. p. 438.

- ^ Eric W. Weisstein. "Distribution Function". MathWorld—A Wolfram Web Resource. Retrieved 2014-09-30.

- ^ Welford, BP (August 1962). "Note on a Method for Calculating Corrected Sums of Squares and Products". Technometrics. 4 (3): 419–420. CiteSeerX 10.1.1.302.7503. doi:10.1080/00401706.1962.10490022.

- ^ Dodge, Yadolah (2003). The Oxford Dictionary of Statistical Terms. Oxford University Press. ISBN 978-0-19-920613-1.

- ^ Pearson, Karl (1894). "On the dissection of asymmetrical frequency curves". Philosophical Transactions of the Royal Society A. 185: 71–110. Bibcode:1894RSPTA.185...71P. doi:10.1098/rsta.1894.0003.

- ^ Miller, Jeff. "Earliest Known Uses of Some of the Words of Mathematics".

External links

- "Quadratic deviation", Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- A simple way to understand Standard Deviation

- Standard Deviation – an explanation without maths

![{\displaystyle \operatorname {E} [X]=\mu .\,\!}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/a850f6d56e315eaef8b630976d5164b368ecb072)

![{\displaystyle {\begin{aligned}\sigma &={\sqrt {\operatorname {E} [(X-\mu )^{2}]}}\\&={\sqrt {\operatorname {E} [X^{2}]+\operatorname {E} [-2\mu X]+\operatorname {E} [\mu ^{2}]}}\\&={\sqrt {\operatorname {E} [X^{2}]-2\mu \operatorname {E} [X]+\mu ^{2}}}\\&={\sqrt {\operatorname {E} [X^{2}]-2\mu ^{2}+\mu ^{2}}}\\&={\sqrt {\operatorname {E} [X^{2}]-\mu ^{2}}}\\&={\sqrt {\operatorname {E} [X^{2}]-(\operatorname {E} [X])^{2}}}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/5989cb6c9ab3f8a7b49459edbdad1b01dbbce57e)

![{\displaystyle \sigma ={\sqrt {{\frac {1}{N}}\left[(x_{1}-\mu )^{2}+(x_{2}-\mu )^{2}+\cdots +(x_{N}-\mu )^{2}\right]}},{\rm {\ \ where\ \ }}\mu ={\frac {1}{N}}(x_{1}+\cdots +x_{N}),}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/2845de27edc898d2a2a4320eda5f57e0dac6f650)

![{\displaystyle \sigma (X)={\sqrt {\operatorname {E} [(X-\operatorname {E} [X])^{2}]}}={\sqrt {\operatorname {E} [X^{2}]-(\operatorname {E} [X])^{2}}}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/3e71dcf2798b6984965050e21d6b65a6ae6d5ca0)

![{\displaystyle s(X)={\sqrt {\frac {N}{N-1}}}{\sqrt {\operatorname {E} [(X-\operatorname {E} [X])^{2}]}}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/49e21e64affc7318070959ea9a56d844860ad5d9)

\cdot (x_{1}-\ell ,x_{2}-\ell ,x_{3}-\ell )&=0\\[4pt]r(x_{1}-\ell +x_{2}-\ell +x_{3}-\ell )&=0\\[4pt]r\left(\sum _{i}x_{i}-3\ell \right)&=0\\[4pt]\sum _{i}x_{i}-3\ell &=0\\[4pt]{\frac {1}{3}}\sum _{i}x_{i}&=\ell \\[4pt]{\overline {x}}&=\ell \end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/bb4ceccb59b001c737bee0b0a7235042055be7be)

![{\displaystyle {\text{Proportion}}\leq x={\frac {1}{2}}\left[1+\operatorname {erf} \left({\frac {x-\mu }{\sigma {\sqrt {2}}}}\right)\right]={\frac {1}{2}}\left[1+\operatorname {erf} \left({\frac {z}{\sqrt {2}}}\right)\right]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/3907d1b0502235fa3fd00f261b290406a02e7b21)