Statistics

| Statistics |

|---|

|

통계학(Statistics)은, 독일어: Statistik, 원래 "주, 국가의 설명"에서 유래하며,[1][2] 데이터의 수집, 구성, 분석, 해석, 및 표시와 관련된 분야입니다.[3][4][5] 과학, 산업, 또는 사회 문제에 통계를 적용할 때, 연구될 통계적 모집단(statistical population) 또는 통계적 모델(statistical model)로 시작하는 것이 전통적입니다. 모집단은 "한 국가에 살고 있는 모든 사람들" 또는 "결정을 구성하는 모든 각 원자"와 같은 다양한 사람 또는 대상이 될 수 있습니다. 통계는 설문 조사(surveys)와 실험(experiments) 설계의 관점에서 데이터 수집의 계획을 포함하여 데이터의 모든 측면을 다룹니다.[6]

설문 조사(census) 데이터가 수집될 수 없을 때, 통계 학자(statisticians)는 특정 실험 설계와 조사 표본(samples)을 개발함으로써 데이터를 수집합니다. 대표 표본화는 추론과 결론이 표본에서 전체로 합리적으로 확대될 수 있음을 보증합니다. 실험적 연구는 연구 중인 시스템을 측정을 얻고, 시스템을 조작하고, 그런-다음 같은 절차를 사용하여 추가적인 측정을 수행하여 만약 조작이 측정의 값을 수정했는지를 결정하기 위해 포함합니다. 대조적으로, 관측 연구(observational study)는 실험 조작을 포함하지 않습니다.

데이터 분석에는 두 가지 주요 통계적 방법이 사용됩니다: 하나는 평균(mean) 또는 표준 편차(standard deviation)와 같은 인덱스(indexes)를 사용하여 표본으로부터 데이터를 요약하는 기술 통계학(descriptive statistics)이고, 다른 하나는 (예를 들어, 관측 오차, 표본 추출 변동) 무작위 변동의 영향을 받는 데이터로부터 결론을 끌어내는 추론 통계학(inferential statistics)입니다.[7] 기술 통계학은 가장 자주 (표본 또는 모집단) 분포(distribution)의 속성의 두 개의 집합과 관련됩니다: 중심 경향(central tendency) (또는 위치(location))은 분포의 중심 또는 전형적인 값을 특성화하기 위해 탐색하고, 반면에 산포도(dispersion) (또는 가변성(variability))은 분포의 구성원이 그의 중심과 서로를 벗어나는 정도를 특성화합니다. 수학적 통계학(mathematical statistics) 위의 추론은 무작위 현상의 분석을 다루는 확률 이론의 틀 아래에서 만들어집니다.

표준 통계적 절차는 두 개의 통계적 데이터 집합, 또는 하나의 데이터 집합과 이상화된 모델로부터 추출된 합성 데이터 사이의 관계의 테스트(test of the relationship)로 이어지는 데이터의 수집을 포함합니다. 가설은 두 데이터 집합 사이의 통계적 관계에 대해 제안되고, 이것은 두 데이터 집합 사이의 관계 없는 이상화된 널 가설(null hypothesis)에 대한 대안(alternative)으로 비교됩니다. 널 가설을 거부하거나 반증하는 것은 시험에서 사용된 데이터가 주어지면 널이 거짓으로 입증될 수 있다는 의미를 정량화하는 통계적 테스트를 사용하여 수행됩니다. 널 가설에서 연구하여, 오류의 두 가지 기본 유형이 인식됩니다: 유형 I 오류(Type I error) (널 가설은 "거짓 긍정"을 제공하여 허위로 거절됨) 및 유형 II 오류(Type II error) (널 가설은 거부되지 않고 모집단 사이의 실제 차이는 "거짓 부정"을 제공하여 생략됩니다).[8] 여러 가지 문제들은 충분한 표본 크기를 얻는 것부터 적절한 널 가설을 지정하는 것까지 다양하게 이 틀과 관련되어 발생합니다.[7]

통계적 데이터를 생성하는 측정 과정은 역시 오류의 영향을 받습니다. 이들 오류의 대부분은 무작위 (잡음) 또는 시스템적 (편향(bias))으로 분류되지만, 오류의 다른 유형 (예를 들어, 분석가가 잘못된 단위를 보고 했을 때와 같은, 큰 실수)이 역시 발생할 수 있습니다. 누락된 데이터(missing data) 또는 중도절단(censoring)의 존재는 편향된 추정을 초래할 수 있고 특정 기술이 이들 문제를 해결하기 위해 개발되어 왔습니다.

Introduction

통계는 데이터(data)의 수집, 분석, 해석 또는 설명, 및 표시,[9] 또는 수학(mathematics)의 한 가지와 관련된 과학의 수학적 몸체입니다.[10] 어떤 사람들은 통계를 수학의 한 가지가 아닌 구별되는 수학적 과학으로 고려합니다. 많은 과학적 조사가 데이터를 사용하는 반면, 통계는 불확실성의 문맥에서 데이터를 사용하고 불확실성에 직면한 의사 결정과 관련이 있습니다.[11][12]

통계를 문제에 적용할 때, 연구될 모집단(population) 또는 프로세스로 시작하는 것이 공통적입니다. 모집단은 "한 국가에 살고 있는 모든 사람들" 또는 "결정을 구성하는 모든 각 원자"와 같은 다양한 주제가 될 수 있습니다. 이상적으로, 통계학자는 전체 인구에 대한 데이터를 수집합니다 (전수 조사(census)라고 하는 작업입니다). 이것은 정부 통계 기관에 의해 조직될 수 있습니다. 기술 통계(Descriptive statistics)는 모집단 데이터를 요약하기 위해 사용될 수 있습니다. 수치 설명자는 연속 데이터(continuous data) (예를 들어, 소득)에 대해 평균(mean)과 표준 편차(standard deviation)를 포함하고, 반면 빈도와 백분율은 (교육과 같은) 카테고리형 데이터를 설명하는 데 더 유용합니다.

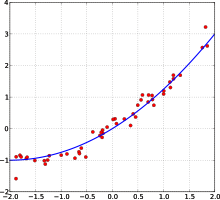

전수 조사가 가능하지 않을 때, 표본(sample)이라고 하는 모집단의 선택된 부분-집합이 연구됩니다. 일단 모집단을 대표하는 표본이 결정되면, 관찰 또는 실험(experimental) 설정에서 표본 구성원에 대한 데이터가 수집됩니다. 다시, 기술 통계는 표본 데이터를 요약하기 위해 사용될 수 있습니다. 어쨌든, 표본을 그리는 데에는 무작위성의 요소를 포함하고 있습니다; 따라서, 표본에서 숫자 설명자는 역시 불확실성이 발생하기 쉽습니다. 전체 모집단에 대한 의미 있는 결론을 도출하기 위해, 추론 통계(inferential statistics)가 필요합니다. 그것은 표본 데이터에서 패턴을 무작위성을 고려하면서 대표되는 모집단에 대한 추론을 도출하기 위해 사용합니다. 이들 추론은 데이터에 대한 예/아니오 질문에 답하고 (가설 테스트(hypothesis testing)), 데이터의 수치적 특성을 추정하고 (추정(estimation)), 데이터 내 연관성(associations)을 설명하고 (상관관계(correlation)), 데이터 내 관계를 (예를 들어, 회귀 분석(regression analysis)을 사용하여) 모델링하는 형식을 취할 수 있습니다. 추론은 연구될 모집단과 결합된 관찰되지 않은 값의 예보(forecasting), 예측(prediction), 및 추정으로 확장될 수 있습니다. 여기에는 시간 급수(time series) 또는 공간 데이터의 외삽(extrapolation)과 보간(interpolation), 및 데이터 채광(data mining)을 포함할 수 있습니다.

Mathematical statistics

수학적 통계는 통계에 수학(mathematics)을 적용하는 것입니다. 이를 위해 사용되는 수학적 기술에는 수학적 해석학(mathematical analysis), 선형 대수(linear algebra), 확률적 해석(stochastic analysis), 미분 방정식(differential equations), 및 측정-이론 확률 이론(measure-theoretic probability theory)을 포함합니다.[13][14]

History

추론에 대한 형식적인 논의는 8세기와 13세기 사이의 이슬람 황금 시대(Islamic Golden Age) 동안 아랍 수학자(Arab mathematicians)와 암호학자(cryptographers)로 거슬러 올라갑니다. 알-칼릴(Al-Khalil) (717–786)은 모음이 있거나 없는 모든 가능한 아랍어 단어를 나열하기 위해 순열(permutations)과 조합(combinations)의 첫 번째 사용 중 하나를 포함하는 Book of Cryptographic Messages을 썼습니다.[15] 알-킨디(Al-Kindi)의 Manuscript on Deciphering Cryptographic Messages는 빈도 분석(frequency analysis)을 사용하여 디코딩을 위한 통계적 추론(statistical inference)의 초기 예를 제공하는 암호화된 메시지를 해독하는 방법에 대한 자세한 설명을 제공합니다. 이븐 아들란(Ibn Adlan) (1187–1268)은 나중에 빈도 분석에서 표본 크기(sample size)를 사용하는 데 중요한 공헌을 했습니다.[15]

유럽에서 통계를 포함하는 최초의 저술은 John Graunt에 의한 Natural and Political Observations upon the Bills of Mortality의 출판과 함께 1663년으로 거슬러 올라갑니다.[16] 통계적 사고의 초기 적용은 국가가 인구 통계와 경제 데이트를 기반으로 정책을 수립해야 할 필요성을 중심으로 이루어졌으며, 따라서 통계-어원(stat- etymology)입니다. 통계학의 범위는 19세기 초반에 데이터의 수집과 분석 전반을 포함하도록 확대되었습니다. 오늘날 통계는 정부, 영업, 및 자연과 사회 과학 분야에서 널리 사용됩니다.

통계의 수학적 토대는 Gerolamo Cardano, Blaise Pascal, Pierre de Fermat, 및 Christiaan Huygens와 같은 수학자 사이에서 우연의 게임(games of chance)에 관한 토론에서 발전했습니다. 비록 확률의 아이디어가 고대와 중세의 법과 철학 (예를 들어, Juan Caramuel의 연구)에서 이미 검토되었지만, 수학 분야로서의 확률 이론(probability theory)은 특히 Jacob Bernoulli의 연구에서 17세기 말에야 형성되었습니다.[17] 최소 제곱의 방법(method of least squares)은 1805년 Adrien-Marie Legendre에 의해 처음 설명되었습니다.

현대 통계학 분야는 19세기 후반과 20세기 초반에 세 단계로 나타났습니다.[18] 세기의 전환기에 첫 번째 물결은 통계를 과학뿐만 아니라 산업과 정치에서도 분석에 사용되는 엄격한 수학 분야로 변형시킨 프랜시스 골턴(Francis Galton)과 칼 피어슨(Karl Pearson)의 연구에 의해 주도되었습니다. 골턴의 기여는 표준 편차(standard deviation), 상관 관계(correlation), 회귀 분석(regression analysis)의 개념을 도입하고 이들 방법을 키, 몸무게, 속눈썹 길이와 같은 다양한 인간 특성 연구에 적용을 포함합니다.[19] 피어슨은 다른 많은 것들 중에서 곱-모멘트로 정의되는 피어슨 곱-모멘트 상관-관계 계수,[20] 표본에 대한 분포와 피어슨 분포(Pearson distribution) 피팅을 위한 모멘트 방법(method of moments)을 개발했습니다.[21] 골턴과 피어슨은 최초의 수학적 통계와 생물통계학 (당시에는 생체측정이라고 불렀음)의 저널로 Biometrika를 설립했고, 후자는 University College London에 세계 최초의 대학 통계학과를 설립했습니다.[22]

1910년대와 20년대의 두 번째 물결은 William Sealy Gosset에 의해 시작되었고, 전 세계 대학에서 학문 분야를 정의하는 교과서를 쓴 로널드 피셔(Ronald Fisher)의 통찰력에서 정점에 이르렀습니다. 피셔의 가장 중요한 출판물은 1918년에 발표한 중요한 논문 The Correlation between Relatives on the Supposition of Mendelian Inheritance (통계 용어, 분산(variance)을 처음 사용함), 그의 고전적인 1925년 연구 Statistical Methods for Research Workers, 및 1935년 The Design of Experiments였으며,[23][24][25] 마지막에서 그는 엄격한 실험 설계(design of experiments) 모델을 개발했습니다. 그는 충분성(sufficiency), 보조 통계(ancillary statistics), 피셔의 선형 판별기(Fisher's linear discriminator) 및 피셔 정보(Fisher information)의 개념을 창안했습니다.[26] 그는 역시 차를 시음하는 여자(Lady tasting tea) 실험에서 널 가설(null hypothesis)이라는 용어를 만들었으며, 이는 "결코 증명되거나 확립된 적이 없지만, 실험 과정에서 반증될 가능성이 있다"는 것입니다.[27][28] 1930년 그의 저서 The Genetical Theory of Natural Selection에서, 그는 피셔의 원리[29] (A. W. F. Edwards가 "진화 생물학에서 아마도 가장 유명한 주장"이라고 부름)와 진화에서 발견되는 긍정적 피드백 폭주 효과에 대한 성 선택의 개념, Fisherian runaway와 같은 다양한 생물학적 개념에 통계를 적용했습니다.[30][31][32][33][34][35]

초기 개발의 개선과 확장을 주로 본 마지막 물결은 1930년대 Egon Pearson과 Jerzy Neyman 사이의 공동 연구에서 나타났습니다. 그들은 "유형 II" 오류, 테스트의 힘(power of a test) 및 신뢰 구간(confidence intervals)의 개념을 도입했습니다. 1934년 Jerzy Neyman은 계층화된 무작위 표본화가 일반적으로 목적 (할당) 표본화보다 더 나은 추정의 방법임을 보여주었습니다.[36]

오늘날, 통계적 방법은 의사 결정과 관련된 모든 분야에 적용되며, 수집된 데이터의 몸체에서 정확한 추론을 하고, 통계적 방법론에 기반한 불확실성에 직면하여 의사 결정을 내리기 위해 사용됩니다. 현대 컴퓨터의 사용은 대규모 통계 계산을 가속화하고 수동으로 수행하기에는 비-실용적인 새로운 방법을 가능하게 했습니다. 통계는 빅 데이터(big data)를 어떻게 분석할 것인가 하는 문제와 같은 활발히 연구되고 있는 분야입니다.[37]

Statistical data

Data collection

Sampling

전체 인구 조사 데이터가 수집될 수 없을 때, 통계학자는 특정 실험 설계(experiment designs)와 설문 조사(survey samples) 표본을 개발함으로써 표본 데이터를 수집합니다. 통계 자체는 통계적 모델(statistical models)을 통한 예측과 예보에 대한 도구도 제공합니다.

표본을 전체 모집단에 대한 지침으로 사용하기 위해, 전체 모집단을 진정으로 나타내는 것이 중요합니다. 대표 표본화(sampling)는 추론과 결론이 표본에서 모집단 전체로 안전하게 확장될 수 있음을 보장합니다. 주요 문제는 선택된 표본이 실제로 대표성을 나타내는 정도를 결정하는 데 있습니다. 통계는 표본과 데이터 수집 절차 내의 임의의 편향에 대해 추정하고 보정하기 위한 방법을 제공합니다. 연구 초기에 이들 문제를 줄이고, 모집단에 대한 진실을 식별하는 능력을 강화할 수 있는 실험을 위한 실험 설계 방법도 있습니다.

표본화 이론은 확률 이론(probability theory)의 수학 분야(mathematical discipline)의 일부입니다. 확률은 수학적 통계(mathematical statistics)에서 표본 통계(sample statistics)의 표본화 분포(sampling distributions)와 더 일반적으로 통계적 절차(statistical procedures)의 속성을 연구하기 위해 사용됩니다. 임의의 통계적 방법의 사용은 고려 중인 시스템 또는 모집단이 방법의 가정을 만족시킬 때 유효합니다. 고전적 확률 이론과 표본화 이론 사이의 관점의 차이점은, 대략적으로, 확률 이론은 표본에 관련된 확률을 추론(deduce)하기 위해 전체 모집단의 주어진 매개변수에서 시작한다는 것입니다. 통계적 추론은, 어쨌든, 반대 방향으로 이동합니다—즉, 표본에서 더 큰 또는 전체 모집단의 매개변수로 귀납적으로 추론(inductively inferring)하는 것입니다.

Experimental and observational studies

통계 연구 프로젝트에 대해 공통 목표는 인과-관계(causality)를 조사하고, 특히 예측기의 값에서 변화 또는 종속 변수에 대한 독립 변수(independent variables on dependent variables)의 효과에 대한 결론을 도출하는 것입니다. 인과 통계 연구에는 실험 연구(experimental studies)와 관찰 연구(observational studies)의 두 가지 주요 유형이 있습니다. 두 가지 유형의 연구에서, 독립 변수 (변수들)의 차이가 종속 변수의 행동에 미치는 영향이 관찰됩니다. 두 유형 사이의 차이점은 실제로 연구를 수행하는 방법에 있습니다. 각각은 매우 효과적일 수 있습니다. 실험적 연구는 연구 중인 시스템을 측정하고, 시스템을 조작하고, 그런-다음 조작으로 인해 측정값이 수정되었는지 확인하기 위해 같은 절차를 사용하여 추가 측정을 포함합니다. 대조적으로, 관찰 연구는 실험적 조작(experimental manipulation)을 포함하지 않습니다. 대신에, 데이터가 수집되고 예측기와 응답 사이의 상관-관계가 조사됩니다. 데이터 분석 도구는 무작위 연구(randomized studies)의 데이터에서 가장 잘 작동하지만, 그것들은 통계학자가 일관된 추정치(consistent estimators)를 생성하는 수정되고, 더 구조화된 추정 방법(예를 들어, 다른 많은 것들 중에서 차이 추정에서 차이점 및 도구 변수)을 사용하는—자연 실험(natural experiments)과 관측 연구(observational studies)와 같은[38]—다른 종류의 데이터에도 적용됩니다.

Experiments

통계 실험의 기본 단계는 다음과 같습니다:

- 연구 계획, 치료 효과(treatment effects)의 크기에 관한 예비 추정치, 대체 가설(alternative hypotheses), 및 추정된 실험 변동가능성(experimental variability)과 같은 정보를 사용하여 연구의 반복 횟수 찾기를 포함합니다.

- 실험의 설계(Design of experiments), 혼재 변수(confounding variable)의 영향을 줄이기 위해 블로킹(blocking)을 사용하고, 치료 효과와 실험 오류의 불-편향된 추정(unbiased estimates)을 허용하기 위해 피험자에게 치료의 무작위 할당(randomized assignment)을 사용합니다. 이 단계에서, 실험-연구가와 통계학자는 실험의 수행을 안내하고 실험 데이터의 주요 분석(primary analysis)을 지정하는 실험 프로토콜(experimental protocol)을 작성합니다.

- 실험 프로토콜에 따라 실험을 수행하고 실험 프로토콜에 따라 데이터를 분석합니다.

- 향후 연구를 위한 새로운 가설을 제안하기 위해 2차 분석에서 데이터 집합을 추가로 조사합니다.

- 연구 결과를 문서화하고 발표합니다.

인간 행동에 대한 실험에는 특별한 관심이 있습니다. 유명한 호손 연구(Hawthorne study)는 Western Electric Company의 Hawthorne 공장에서 작업 환경의 변화를 조사했습니다. 연구원들은 증가된 조명이 조립 공정(assembly line) 작업자의 생산성을 증가시킬지 여부를 결정하는 데 관심이 있었습니다. 연구원들은 먼저 공장에서 생산성을 측정하고, 그런-다음 공장의 한 영역에서 조명을 수정하고 조명에서 변화가 생산성에 영향을 미치는지 확인했습니다. 실제로 생산성이 (실험 조건 아래에서) 개선된 것으로 밝혀졌습니다. 어쨌든, 그 연구는 오늘날 실험 절차의 오류, 특히 대조군(control group)의 부족과 실명으로 인해 크게 비판받고 있습니다. 호손 효과(Hawthorne effect)는 관찰 자체로 인해 결과 (이 경우에서, 작업자 생산성)가 변경되었음을 발견하는 것을 말합니다. 호손 연구에 참여한 사람들은 조명이 바뀌었기 때문이 아니라 관찰되고 있었기 때문에 더 생산적이 되었습니다.[39]

Observational study

관찰 연구의 예는 흡연과 폐암 사이의 연관성을 탐구하는 연구입니다. 이러한 유형의 연구는 전형적으로 설문 조사를 관심 영역에 대한 관찰을 수집하고 그런-다음 통계 분석을 수행하기 위해 사용합니다. 이 경우에서, 연구자들은 아마도 코호트 연구(cohort study)를 통해 흡연자와 비흡연자 모두에 대한 관찰을 수집하고 그런-다음 각 그룹의 폐암 사례 수를 찾을 것입니다.[40] 사례-대조군 연구(case-control study)는 관심 결과 (예를 들어 폐암)가 있거나 없는 사람들을 초대하고 노출 이력을 수집하는 또 다른 유형의 관찰 연구입니다.

Types of data

측정 수준(levels of measurement)의 분류학을 생성하기 위한 다양한 시도가 있어 왔습니다. 정신-물리학자 Stanley Smith Stevens는 명목, 순서, 구간, 및 비율 스케일을 정의했습니다. 명목 측정은 값 사이에 의미 있는 순위 순서를 가지지 않고, 임의의 일-대-일 (단사) 변환을 허용합니다. 순서 측정은 연속 값 사이에 부정확한 차이를 가지지만, 해당 값에 의미 있는 순서를 가지고, 임의의 순서-보존하는 변환을 허용합니다. 구간 측정은 정의된 측정 사이에 의미 있는 거리를 가지지만, 영 값은 (경도(longitude)와 섭씨(Celsius) 또는 화씨(Fahrenheit)에서 온도 측정의 경우와 같이) 임의적이고, 임의의 선형 변환을 허용합니다. 비율 측정은 의미 있는 영 값과 정의된 다른 측정 사이의 거리를 모두 가지고, 임의의 재조정 변환을 허용합니다.

명목 또는 순서 측정에만 부합하는 변수는 수치적으로 합리적으로 측정될 수 없기 때문에, 때때로 그것들은 카테고리형 변수(categorical variables)로 함께 그룹화되는 반면, 비율과 구간 측정은 수치적 본성으로 인해 이산(discrete) 또는 연속적(continuous)일 수 있는 정량적 변수(quantitative variables)로 함께 그룹화됩니다. 그러한 구별은 종종 컴퓨터 과학에서 데이터 유형(data type)과 느슨하게 상관될 수 있으며, 이분법적인 카테고리형 변수는 부울 데이터 유형(Boolean data type), 정수 데이터 유형(integral data type)에서 임의로 할당된 정수(integers)를 갖는 다단 카테고리형 변수, 및 부동-점 산술(floating-point arithmetic)을 포함하는 실수 데이터 유형(real data type)의 연속 변수로 표현될 수 있습니다. 부동 소수점 연산. 그러나 통계 데이터 유형에 대한 컴퓨터 과학 데이터 유형의 매핑은 구현되는 후자의 카테고리화에 따라 다릅니다.

다른 분류가 제안되어 왔습니다. 예를 들어, Mosteller와 Tukey (1977)는 등급, 순위, 계산된 분수, 계수, 총액, 및 잔액을 구분했습니다.[41] Nelder (1990)는 연속 계수, 연속 비율, 계수 비율, 및 데이터의 카테고리형 모드를 설명했습니다.[42] (참조: Chrisman (1998),[43] van den Berg (1991).[44])

다양한 측정 절차에서 얻은 데이터에 다양한 통계적 방법을 적용하는 것이 적절한지 여부에 대한 문제는 변수의 변환과 연구 질문의 정확한 해석에 관한 문제로 인해 복잡합니다. "데이터와 데이터가 설명하는 것 사이의 관계는 특정 종류의 통계적 명제가 일부 변환 아래에서 불변이 아닌 진리 값을 가질 수 있다는 사실을 반영할 뿐입니다. 변환이 고려하기에 합리적인지 여부는 대답하려는 질문에 따라 다릅니다."[45]: 82

Methods

Descriptive statistics

기술 통계량(descriptive statistic, 카운트 명사 의미)은 정보(information) 수집의 특징을 정량적으로 설명하거나 요약하는 요약 통계량(summary statistic)이고,[46] 반면에 질량 명사 의미에서 기술적 통계량은 그들 통계량을 사용하고 분석하는 과정입니다. 기술 통계량은 추론 통계(inferential statistics) (또는 귀납 통계)와 구별되는데, 해당 기술 통계는 데이터를 사용하여 데이터의 표본이 나타내는 것으로 생각되는 모집단(population)에 대해 학습하기 보다는 표본(sample)을 요약하는 것을 목표로 합니다.

Inferential statistics

통계적 추론(Statistical inference)은 놓여있는 확률 분포(probability distribution)의 속성을 추론하기 위해 데이터 분석을 사용하는 과정입니다.[47] 추론적 통계 분석은 예를 들어 가설을 테스트하고 추정치를 도출함으로써 모집단(population)의 속성을 추론합니다. 그것은 관찰된 데이터 집합이 더 큰 모집단에서 표본화되었다고 가정합니다. 추론 통계는 기술 통계(descriptive statistics)와 대조될 수 있습니다. 기술 통계는 관찰된 데이터의 속성에만 관련되고, 데이터가 더 많은 모집단에서 왔다는 가정에 의존하지 않습니다.

Terminology and theory of inferential statistics

Statistics, estimators and pivotal quantities

주어진 확률 분포(probability distribution)를 갖는 독립 동일하게 분포된 (IID) 확률 변수를 생각해 보십시오: 표준 통계적 추론(statistical inference)과 추정 이론(estimation theory)은 무작위 표본(random sample)을 이들 IID 변수의 열 벡터(column vector)에 의해 주어진 확률 벡터(random vector)로 정의합니다.[48] 조사 중인 모집단(population)은 미지수 매개변수를 가질 수 있는 확률 분포로 설명됩니다.

통계량은 무작위 표본의 함수이지만, 미지수 매개변수의 함수가 아닌 확률 변수입니다. 어쨌든 통계량의 확률 분포는 미지수 매개변수를 가질 수 있습니다. 이제 미지수 매개변수의 함수를 생각해 보십시오: 추정량(estimator)은 그러한 함수를 추정하기 위해 사용되는 통계량입니다. 공통적으로 사용되는 추정량은 표본 평균(sample mean), 불-편향된 표본 분산(sample variance)과 표본 공분산(sample covariance)을 포함합니다.

무작위 표본과 미지수 매개변수의 함수이지만 확률 분포가 미지수 매개변수에 의존하지 않는 확률 변수는 중추적 양(pivotal quantity) 또는 피벗(pivot)이라고 불립니다. 널리 사용되는 피벗은 z-점수(z-score), 카이 제곱 통계량(chi square statistic), 및 스튜던트의 t-값(t-value)을 포함합니다.

주어진 매개변수의 두 추정기 사이에서, 더 낮은 평균 제곱 오차를 갖는 추정기가 더 효율적이라고 말합니다. 게다가, 추정기는 만약 그것의 기댓값(expected value)이 추정될 미지수 매개변수의 참 값(true value)과 같으면 불-편향이라고 말하고, 그것의 기댓값이 그러한 매개변수의 참 값에 대한 극한(limit)에서 수렴하면 점근적으로 불-편향입니다.

추정기에 대한 다른 바람직한 속성은 다음과 같습니다: 추정될 매개변수의 모든 가능한 값에 대해 가장 낮은 분산을 가지는 UMVUE 추정기 (이것은 보통 효율성보다 검증하기 더 쉬운 속성) 및 그러한 매개변수의 참 값에 확률에서 수렴(converges in probability)하는 일관된 추정기(consistent estimators)가 있습니다.

이것은 여전히 주어진 상황에서 추정량을 얻고 계산을 수행하는 방법에 대한 질문을 남깁니다. 몇 가지 방법이 제안되어 왔습니다: 모멘트 방법(method of moments), 최대 가능도(maximum likelihood) 방법, 최소 제곱(least squares) 방법, 및 방정식 추정(estimating equations)의 최신 방법이 있습니다.

Null hypothesis and alternative hypothesis

통계 정보의 해석은 보통 (그러나 반드시 필요한 것은 아닌) 변수 사이에 관계가 존재하지 않거나 시간이 지남에 따라 변화가 발생하지 않는다는 널 가설(null hypothesis)의 개발을 종종 포함할 수 있습니다.[49][50]

초보자를 위한 가장 좋은 예시는 형사 재판에서 직면하는 곤경입니다. 널 가설, H0은 피고인이 무죄라고 주장하는 반면, 대체 가설, H1은 피고인이 유죄라고 주장합니다. 기소는 유죄가 의심되기 때문에 발생합니다. H0 (현상 유지)는 H1에 반대되는 의미이고 H1이 "합리적인 의심을 넘어선" 증거에 의해 뒷받침되지 않은 한 유지됩니다. 어쨌든, 이 경우에서 "H0 거부 실패"는 무죄를 의미하는 것이 아니라 유죄를 선고하기에는 증거가 불충분하다는 의미일 뿐입니다. 따라서 배심원단은 H0를 반드시 수용하지는 않지만 H0를 거부하지 못합니다. 널 가설을 "입증"할 수는 없지만, 유형 II 오류를 테스트하는 힘 테스트(power test)를 통해 그것이 참에 얼마나 가까운지 테스트할 수 있습니다.

통계학자들이 대체 가설(alternative hypothesis)이라고 부르는 것은 단순히 널 가설(null hypothesis)과 모순되는 가설입니다.

Error

널 가설(null hypothesis)에서 연구함에, 두 가지 넓은 카테고리의 오류가 인식됩니다:

- Type I errors 여기서 널 가설이 거짓으로 기부되어 "거짓 양성"을 제공합니다.

- Type II errors 여기서 널 가설이 기부되지 않고 모집단 사이의 실제 차이가 누락되어, "거짓 음성"을 제공합니다.

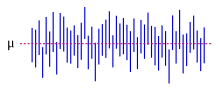

표준 편차(Standard deviation)는 표본의 개별 관측치가 표본 또는 모집단 평균과 같은 중심 값과 다른 정도를 나타내는 반면, 표준 오차(Standard error)는 표본 평균과 모집단 평균 사이의 차이의 추정치를 나타냅니다.

통계적 오차(statistical error)는 관측치가 기댓값(expected value)과 다른 총양입니다. 잔여(residual)는 주어진 표본 (예측이라고도 함)에서 기댓값의 추정기가 가정하는 값과 관측치가 다른 총양입니다.

평균 제곱 오차(Mean squared error)는 널리 사용되는 추정기 클래스인 효율적인 추정기(efficient estimators)를 얻는 데 사용됩니다. 제곱근 평균 제곱 오차(Root mean square error)는 단순히 평균 제곱 오차의 제곱근입니다.

많은 통계적 방법은 잔여의 제곱 합(residual sum of squares)을 최소화하려고 추구하고, 이것들은 최소 절대 편차(Least absolute deviations)와 대조적으로 "최소 제곱의 방법(methods of least squares)"이라고 합니다. 후자는 크고 작은 오류에 같은 가중치를 부여하고, 반면에 전자는 큰 오류에 더 많은 가중치를 부여합니다. 잔여 제곱합도 미분-가능(differentiable)이며, 이는 회귀(regression)를 수행하는 데 편리한 속성을 제공합니다. 선형 회귀(linear regression)에 적용되는 최소 제곱은 보통의 최소 제곱(ordinary least squares) 방법이라고 하고, 비-선형 회귀(nonlinear regression)에 적용되는 최소 제곱은 비-선형 최소 제곱(non-linear least squares)이라고 합니다. 역시 선형 회귀 모델에서, 모델의 비-결정적 부분은 오류 항, 교란 또는 더 간단히 잡음이라고 불립니다. 선형 회귀와 비선형 회귀 모두 다항식 최소 제곱(polynomial least squares)으로 처리되며, 이는 독립 변수 (x-축)의 함수로 종속 변수 (y-축) 예측의 분산과 추정된 (적합된) 곡선에서 편차 (오류, 잡음, 교란)를 설명합니다.

통계 데이터를 생성하는 측정 과정도 오류가 발생할 수 있습니다. 이들 오류의 대부분은 무작위(random) (잡음) 또는 시스템적(systematic) (편향)으로 분류되지만, 다른 유형의 오류 (예를 들어, 분석가가 잘못된 단위를 보고할 때와 같은 큰 실수)도 중요할 수 있습니다. 누락된 데이터(missing data) 또는 중도절단(censoring)의 존재는 편향된 추정을 초래할 수 있고 이들 문제를 해결하기 위한 특정 기술이 개발되어 왔습니다.[51]

Interval estimation

대부분의 연구는 모집단의 일부만 표본화하므로, 결과가 전체 모집단을 완전히 나타내지는 않습니다. 표본에서 얻은 임의의 추정치는 모집단 값의 근사치일 뿐입니다. 신뢰 구간(Confidence intervals)을 통해 통계학자는 표본 추정치가 전체 모집단의 참 값과 얼마나 근접하게 일치하는지 표현할 수 있습니다. 종종 그것들은 95% 신뢰 구간으로 표현됩니다. 공식적으로, 값에 대해 95% 신뢰 구간은 표본화와 분석이 같은 조건 (다른 데이터 집합 생성)에서 반복되면, 그 구간이 가능한 모든 경우의 95%에서 참 (모집단) 값을 포함할 것입니다. 이것은 참 값이 신뢰 구간에 있을 확률이 95%라는 것을 의미하지는 않습니다. 빈도주의자(frequentist)의 관점에서, 그러한 주장은 참 값(random variable)이 무작위 변수가 아니기 때문에 이치에 맞지 않습니다. 참 값은 주어진 간격 내에 있거나 그렇지 않습니다. 어쨌든, 임의의 데이터가 표본화되고 신뢰 구간을 구성하는 방법에 대한 계획이 주어지기 전에, 아직-계산되지-않은 구간이 참 값을 포함할 확률은 95%인 것이 사실입니다: 이 관점에서, 구간의 한계는 아직-관측되지-않은 확률 변수(random variables)입니다. 참 값을 포함할 주어진 확률을 갖는 것으로 해석될 수 있는 구간을 산출하는 한 가지 접근 방식은 베이즈 통계(Bayesian statistics)에서 신용 구간(credible interval)을 사용하는 것입니다: 이 접근 방식은 "확률"이 의미하는 바를 해석하는 다른 방식에 따라 다르며, 이 경우에서 베이즈 확률(Bayesian probability)로 해석했습니다.

원칙적으로 신뢰 구간은 대칭 또는 비-대칭일 수 있습니다. 구간은 비-대칭적일 수 있는데 왜냐하면 매개변수 (왼쪽-편 구간 또는 오른쪽-편 구간)에 대한 위쪽 또는 아래쪽 경계로 작동하기 때문이지만, 그것은 역시 비대칭일 수 있는데 왜냐하면 양측 구간이 추정치를 중심으로 대칭을 위반하여 구축되기 때문입니다. 때때로 신뢰 구간에 대해 경계는 점근적으로 도달되고 이것들은 참 경계를 근사하기 위해 사용됩니다.

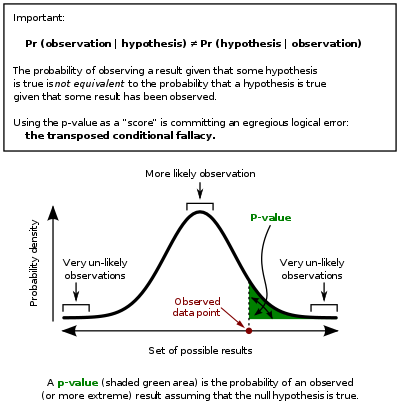

Significance

통계는 분석 아래에서 질문에 대한 간단한 예/아니오 유형의 답변을 드물게 제공합니다. 해석은 종종 숫자에 적용된 통계적 중요성 수준으로 내려오고 널 가설 (때때로 p-값(p-value)이라고도 함)을 정확하게 거부하는 값의 확률을 참조합니다.

표준 접근 방식은 널 가설을 대체 가설에 대항하여 테스트하는 것입니다.[48] 임계 영역(critical region)은 널 가설을 논박하게 만드는 추정기의 값 집합입니다. 따라서 유형 I 오류의 확률은 널 가설이 참 (통계적 중요성(statistical significance))으로 주어진 추정자가 임계 영역에 속할 확률이고 유형 II 오류의 확률은 대체 가설이 참으로 주어진 추정기가 임계 영역에 속하지 않을 확률입니다. 테스트의 통계적 힘(statistical power)은 널 가설이 거짓일 때 널 가설을 올바르게 거부할 확률입니다.

통계적 중요성을 언급한다고 해서 반드시 전체 결과가 실제 상황에서 유의미하다는 의미는 아닙니다. 예를 들어, 약물에 대한 대규모 연구에서, 약물이 통계적으로 유의미하지만 유익한 효과가 매우 작아 환자에게 눈에 띄게 도움이 되지 않는 것으로 나타날 수 있습니다.

원칙적으로 통계적 중요성(statistical significance)의 허용 가능한 수준은 논쟁의 대상이 될 수 있지만, 중요성 수준(significance level)은 테스트에서 널 가설을 거부할 수 있는 가장 큰 p-값입니다. 이 테스트는 p-값이 널 가설이 참이라고 가정할 때 적어도 테스트 통계량(test statistic)만큼 극단적인 결과를 관찰할 확률이라고 말하는 것과 논리적으로 동등합니다. 그러므로, 중요성 수준이 작을수록, 유형 I 오류를 범할 확률이 낮아집니다.

일부 문제는 보통 이 프레임워크와 관련이 있습니다 (가설 테스트의 비판(criticism of hypothesis testing)을 참조하십시오):

- 통계적으로 매우 유의미한 차이는 여전히 실질적인 의미가 없을 수 있지만, 이를 설명하기 위해 테스트를 적절하게 공식화하는 것은 가능합니다. 한 가지 응답은 가설이 거부 또는 수용되는지 여부를 보고할 때 p-값(p-value)을 포함하도록 중요성 수준(significance level)만 보고하는 것 이상을 포함합니다. 어쨌든, p-값은 관찰된 효과의 크기(size)나 중요성을 나타내지 않고 대규모 연구에서 사소한 차이의 중요성을 과장하는 것처럼 보일 수도 있습니다. 더 좋고 점점 더 공통적인 접근 방식은 신뢰 구간(confidence intervals)을 보고하는 것입니다. 비록 이것들은 가설 테스트 또는 p-값의 계산과 같은 계산에서 생성되지만, 그것들은 효과의 크기와 이를 둘러싼 불확실성을 모두 설명합니다.

- 전치된 조건부의 오류, 일명 검사의 오류(prosecutor's fallacy): 가설 테스트 접근 방식이 하나의 가설 (널 가설)을 선호하도록 강요하기 때문에 비판이 발생하는데, 왜냐하면 평가되는 것은 널 가설이 주어지면 관찰된 결과의 확률이고 관찰된 결과가 주어지면 널 가설의 확률이 아니기 때문입니다. 이 접근 방식에 대한 대안은 베이즈 추론에 의해 제공되지만, 이전 확률(prior probability)을 설정해야 합니다.[52]

- 널 가설을 거부한다고 해서 대안 가설이 자동으로 입증되는 것은 아닙니다.

- 추론적 통계(inferential statistics)에서 모든 것이 표본 크기에 의존하므로, 뚱뚱한 꼬리(fat tails) 아래에서 p-값이 심각하게 잘못-계산될 수 있습니다. [설명 필요]

Examples

일부 잘 알려진 통계 테스트와 절차는 다음과 같습니다:

Exploratory data analysis

탐색적 데이터 분석(Exploratory data analysis, 줄여서 EDA)은 데이터 집합(data sets)을 해석(analyzing)하기 위해 주요 특성을 요약하는 접근 방식이며, 종종 시각적 방법을 사용합니다. 통계적 모델(statistical model)이 사용될 수도 있고 사용되지 않을 수도 있지만, 주로 EDA는 형식적 모델링 또는 가설 테스트 임무를 넘어 데이터가 알려줄 수 있는 내용을 확인하기 위한 것입니다.

Misuse

통계의 오용(Misuse of statistics)은 설명과 해석에서 미묘하지만 심각한 오류가 발생할 수 있습니다—숙련된 전문가도 그러한 오류를 범한다는 점에서 미묘하고 치명적인 결정 오류로 이어질 수 있다는 점에서 심각합니다. 예를 들어, 사회 정책, 의료 행위, 다리와 같은 구조물의 신뢰성은 모두 통계의 적절한 사용에 의존합니다.

통계적 기술이 제대로 적용되더라도, 결과는 전문성 부족한 사람들에 대해 해석하기 어려울 수 있습니다. 데이터에서 추세—표본의 무작위 변동으로 인해 추세가 발생할 수 있는 정도를 측정—의 통계적 중요성(statistical significance)은 그 중요성의 직관적인 의미와 일치할 수도 있고 일치하지 않을 수도 있습니다. 사람들이 일상 생활에서 정보를 올바르게 처리하는 데 필요한 기본 통계적 기술 (및 회의론)의 집합은 통계적 소양(statistical literacy)으로 참조됩니다.

통계적 지식은 발표자에게 유리한 데이터만 해석하는 방법을 찾음으로써 의도적으로 오용(misused)되는 경우가 너무 많다는 일반적인 인식이 있습니다.[53] 통계에 대한 불신과 오해는 "세 종류의 거짓말이 있다: 거짓말, 저주-받은 거짓말, 통계"라는 인용문과 관련이 있습니다. 통계의 오용은 부주의하거나 의도적일 수 있고, Darrell Huff에 의한 책 How to Lie with Statistics에서는 다양한 고려 사항에 대해 설명합니다.[53] 통계의 사용과 오용을 밝히기 위해 특정 분야에서 사용되는 통계적 기술에 대한 검토가 이루어지고 있습니다 (예를 들어, Warne, Lazo, Ramos, and Ritter (2012)).[54]

통계의 오용을 피하는 방법에는 적절한 다이어그램을 사용하고 편향(bias)을 피하는 것을 포함합니다.[55] 오용은 결론이 지나치게-일반화(overgeneralized)되고 그것들이 실제보다 더 많은 것을 대표한다고 주장할 때 발생할 수 있으며, 종종 고의적으로 또는 무의식적으로 표본화 편향을 간과함으로써 발생할 수 있습니다.[56] 막대 그래프는 틀림없이 사용하고 이해하기 가장 쉬운 다이어그램이고, 그것들은 손으로 또는 간단한 컴퓨터 프로그램으로 만들 수 있습니다.[55] 불행히도, 대부분의 사람들은 편견이나 오류를 찾지 않으므로, 그것들은 눈에 띄지 않습니다. 따라서, 사람들은 심지어 잘 표현되지 않아도 무언가가 사실이라고 종종 믿을 수 있습니다.[56] 통계에서 수집한 데이터를 믿을 수 있고 정확하게 만들기 위해, 채취된 표본이 전체를 대표해야 합니다.[57] Huff에 따르면, "표본의 의존-가능성은 [편향]에 의해 파괴될 수 있습니다... 어느 정도 회의론을 허용하십시오."[58]

통계에 대한 이해를 돕기 위해, Huff는 각 경우에서 물어볼 일련의 질문을 제안했습니다:[53]

- Who says so? (Does he/she have an axe to grind?)

- How does he/she know? (Does he/she have the resources to know the facts?)

- What's missing? (Does he/she give us a complete picture?)

- Did someone change the subject? (Does he/she offer us the right answer to the wrong problem?)

- Does it make sense? (Is his/her conclusion logical and consistent with what we already know?)

Misinterpretation: correlation

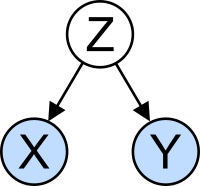

상관-관계(correlation)의 개념은 그것으로 인해 발생할 수 있는 잠재적인 혼란에 대해 특히 주목할 만합니다. 데이터 집합(data set)에 대한 통계적 분석은 종종 고려 중인 모집단의 두 변수 (속성)가 마치 연결된 것처럼 함께 변하는 경향이 있음을 보여줍니다. 예를 들어, 사망 연령도 살펴보는 연간 소득에 대한 연구는 가난한 사람들이 부유한 사람들보다 수명이 짧은 경향이 있음을 발견할 수 있습니다. 두 변수는 상관관계가 있다고 말합니다; 어쨌든, 그것들은 서로의 원인일 수도 있고 아닐 수도 있습니다. 상관 현상은 잠복 변수 또는 혼재 변수(confounding variable)라고 불리는 이전에 고려되지 않은 세 번째 현상으로 인해 발생할 수 있습니다. 이 때문에, 두 변수 사이에 인과관계의 존재를 즉시 유추할 수 있는 방법은 없습니다.

Applications

Applied statistics, theoretical statistics and mathematical statistics

응용 통계(Applied statistics)는, 때때로 통계 과학(Statistical science)으로 참조되며,[59] 기술 통계와 추론 통계의 응용으로 구성됩니다.[60][61] 이론적 통계(Theoretical statistics)는 통계적 추론(statistical inference)에 대한 접근 방식의 정당성을 뒷받침하고, 마찬가지로 수학적 통계(mathematical statistics)를 포괄하는 논리적 논증과 관련이 있습니다. 수학적 통계는 추정과 추론 방법과 관련된 결과 도출에 필요한 확률 분포(probability distributions)의 조작뿐만 아니라. 계산적 통계(computational statistics)와 실험 설계(design of experiments)의 다양한 측면을 포함합니다.

통계 컨설턴트(Statistical consultants)는 특정 질문과 관련된 사내 전문 지식을 가지지 않는 조직과 회사를 도울 수 있습니다.

Machine learning and data mining

기계 학습(Machine learning) 모델은 계산 알고리듬의 사용을 통해 데이터에서 패턴을 포획하는 통계와 확률적 모델입니다.

Statistics in academia

통계학은 자연과 사회 과학, 정부와 영업을 포함한 다양한 학문 분야에 적용할 수 있습니다. 영업 통계는 서비스 개선과 마케팅 연구를 포함하여 계량경제학(econometrics), 감사 및 생산과 운영에 통계적 방법을 적용합니다.[62] 열대 생물학에서 두 저널에 대한 연구에 따르면 12가지 가장 빈번한 통계 테스트는 다음과 같습니다: Analysis of Variance (ANOVA), Chi-Square Test, Student’s T Test, Linear Regression, Pearson’s Correlation Coefficient, Mann-Whitney U Test, Kruskal-Wallis Test, Shannon’s Diversity Index, Tukey's Test, Cluster Analysis, Spearman’s Rank Correlation Test, 및 Principal Component Analysis.[63]

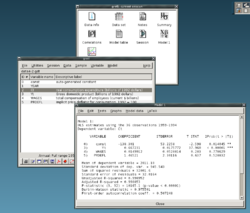

전형적인 통계 과정은 기술 통계, 확률, 이항과 정규 분포(normal distributions), 가설의 테스트와 신뢰 구간, 선형 회귀(linear regression), 및 상관-관계를 다룹니다.[64] 학부생을 위한 현대 기초 통계 과정은 올바른 테스트 선택, 결과 해석, 및 자유 통계 소프트웨어(free statistics software) 사용에 중점을 둡니다.[63]

Statistical computing

20세기 후반부터 시작된 컴퓨팅 파워에서 빠르고 지속적인 증가는 통계적 과학의 실천에 상당한 영향을 미쳤습니다. 초기 통계적 모델은 거의 항상 선형 모델(linear models)의 클래스에 속했지만, 적절한 수치 알고리듬(algorithms)과 결합된 강력한 컴퓨터는 일반화된 선형 모델(generalized linear models)과 다-수준 모델(multilevel models)과 같은 새로운 유형의 생성뿐만 아니라 (신경망(neural networks)과 같은) 비-선형 모델(nonlinear models)에 대한 관심을 증가시켰습니다.

컴퓨팅 성능이 향상되면서 순열 테스트(permutation tests)와 부트스트랩(bootstrap)과 같은 재-표본화(resampling)를 기반으로 하는 계산 집약적인 방법의 인기가 높아진 반면, 깁스 표본화(Gibbs sampling)와 같은 기술은 베이즈 모델(Bayesian models)을 보다 실현 가능하게 만들었습니다. 컴퓨터 혁명은 "실험적" 및 "실증적" 통계에 대한 새로운 강조와 함께 통계의 미래에 영향을 미칩니다. 이제 많은 수의 일반 및 특수 목적 통계 소프트웨어(statistical software)를 사용할 수 있습니다. 복잡한 통계 계산이 가능한 사용 가능한 소프트웨어의 예제는 Mathematica, SAS, SPSS, 및 R과 같은 프로그램을 포함합니다.

Business statistics

영업에서, "통계"는 널리 사용되는 관리- 및 의사-결정 지원(decision support) 도구입니다. 특히 재무 관리, 마케팅 관리, 생산, 서비스와 운영 관리에 적용됩니다.[65][66] 통계는 역시 관리 회계와 감사에서 많이 사용됩니다. 경영 과학(Management Science) 분야는 영업에서 통계, 및 기타 수학의 사용을 공식화합니다. (경제학(Econometrics)은 경제 관계(economic relationships)에 실증적 내용을 제공하기 위해 경제 데이터(economic data)에 통계적 방법을 적용하는 것입니다.)

전형적인 "영업 통계" 과정은 영업 전공을 대상으로 하고, 기술 통계 (데이터 수집, 설명, 분석, 및 요약), 확률 (전형적으로 이항과 정규 분포), 가설의 테스트와 신뢰 구간, 선형 회귀, 및 상관-관계를 덮습니다; (후속) 과정에는 예측, 시간 급수, 의사-결정 트리, 다중 선형 회귀, 및 영업 분석의 기타 주제를 포함할 수 있습니다. Business mathematics § University level도 참조하십시오. CFA와 같은 전문 인증 프로그램(Professional certification programs)에는 종종 통계 주제가 포함됩니다.

Statistics applied to mathematics or the arts

전통적으로, 통계는 대부분의 과학에서 "필요한 학습"이었던 반-표준화된 방법론을 사용하여 추론을 그리는 것과 관련되었습니다.[67] 이 전통은 비-추론적 맥락에서 통계를 사용하면서 바뀌었습니다. 한때 많은 분야에서 학위-요구 사항으로 취해진 건조한 주제로 고려되었던 것이 이제는 열광적으로 보입니다. 처음에는 일부 수학적 순수주의자들의 조롱을 받았지만 이제는 특정 영역에서 필수적인 방법론으로 고려됩니다.

- 숫자 이론(number theory)에서, 분포 함수에 의해 생성된 데이터의 산점도(scatter plots)는 통계에 사용되는 친숙한 도구로 변환되어 기본 패턴을 드러내고 가설로 이어질 수 있습니다.

- 카오스 이론(chaos theory)과 프랙탈 기하학(fractal geometry)을 결합한 예보(forecasting)에서 통계의 예측 방법은 비디오 작품을 만들기 위해 사용할 수 있습니다.[68]

- Jackson Pollock의 프로세스 아트는 예술적 실험에 의존하여 자연에서 놓여있는 분포가 예술적으로 드러났습니다.[69] 컴퓨터의 출현으로, 움직이는 비디오 아트를 만들고 분석하기 위해 이러한 배포 중심의 자연스러운 프로세스를 공식화하기 위해 통계적 방법이 적용되었습니다.

- 통계 방법은 통계적 방법을 사용하여 그 경우를 예측할 수 있는 일정 시간 동안만 작동하는 마르코프 프로세스(Markov process)에 기반한 카드 트릭에서와 같이 행위 예술(performance art)에서 예측적으로 사용될 수 있습니다.

- 통계는 Iannis Xenakis에 의해 발명된 통계적 또는 확률적 음악(stochastic music)에서와 같이 예측적으로 예술을 창조하기 위해 사용될 수 있습니다. 이러한 유형의 예술성은 항상 예상대로 나오지는 않지만 통계를 사용하여 예측하고 조정할 수 있는 방식으로 작동합니다.

Specialized disciplines

통계적 기술은 생물통계학, 컴퓨터 생물학, 컴퓨터 사회학, 네트워크 생물학, 사회 과학, 사회학, 및 사회 연구를 포함한 광범위한 유형의 과학과 사회 연구에서 사용됩니다. 일부 조사 분야는 응용 통계를 너무 광범위하게 사용하여 전문 용어를 사용합니다. 이러한 분야에는 다음을 포함합니다:

- Actuarial science (assesses risk in the insurance and finance industries)

- Applied information economics

- Astrostatistics (statistical evaluation of astronomical data)

- Biostatistics

- Chemometrics (for analysis of data from chemistry)

- Data mining (applying statistics and pattern recognition to discover knowledge from data)

- Data science

- Demography (statistical study of populations)

- Econometrics (statistical analysis of economic data)

- Energy statistics

- Engineering statistics

- Epidemiology (statistical analysis of disease)

- Geography and geographic information systems, specifically in spatial analysis

- Image processing

- Jurimetrics (law)

- Medical statistics

- Political science

- Psychological statistics

- Reliability engineering

- Social statistics

- Statistical mechanics

게다가, 고유한 전문 용어와 방법론을 개발한 특정 유형의 통계 분석이 있습니다:

- Bootstrap / jackknife resampling

- Multivariate statistics

- Statistical classification

- Structured data analysis

- Structural equation modelling

- Survey methodology

- Survival analysis

- Statistics in various sports, particularly baseball – known as sabermetrics – and cricket

통계는 영업과 제조에서도 핵심 기반 도구를 형성합니다. 그것은 측정 시스템의 변동가능성, (통계 프로세스 제어 또는 SPC에서와 같이) 제어 프로세스를 이해하고 데이터를 요약하고, 데이터-기반 결정을 내리기 위해 사용됩니다. 이러한 역할에서, 그것은 핵심 도구이고, 아마도 유일하게 신뢰할 수 있는 도구일 것입니다.

See also

| Library resources about Statistics |

- Abundance estimation

- Glossary of probability and statistics

- List of academic statistical associations

- List of important publications in statistics

- List of national and international statistical services

- List of statistical packages (software)

- List of statistics articles

- List of university statistical consulting centers

- Notation in probability and statistics

- Statistics education

- World Statistics Day

- Foundations and major areas of statistics

- Foundations of statistics

- List of statisticians

- Official statistics

- Multivariate analysis of variance

References

- ^ "statistics", Oxford English Dictionary (3rd ed.), Oxford University Press, September 2005

{{citation}}: Invalid|mode=CS1(help) (Subscription or UK public library membership required.) - ^ “Statistik” in Digitales Wörterbuch der deutschen Sprache

- ^ "Statistics". Oxford Reference. Oxford University Press. January 2008. ISBN 978-0-19-954145-4. Archived from the original on 2020-09-03. Retrieved 2019-08-14.

- ^ Romijn, Jan-Willem (2014). "Philosophy of statistics". Stanford Encyclopedia of Philosophy. Archived from the original on 2021-10-19. Retrieved 2016-11-03.

- ^ "Cambridge Dictionary". Archived from the original on 2020-11-22. Retrieved 2019-08-14.

- ^ Dodge, Y. (2006) The Oxford Dictionary of Statistical Terms, Oxford University Press. ISBN 0-19-920613-9

- ^ a b Lund Research Ltd. "Descriptive and Inferential Statistics". statistics.laerd.com. Retrieved 2014-03-23.

- ^ "What Is the Difference Between Type I and Type II Hypothesis Testing Errors?". About.com Education. Archived from the original on 2017-02-27. Retrieved 2015-11-27.

- ^ Moses, Lincoln E. (1986) Think and Explain with Statistics, Addison-Wesley, ISBN 978-0-201-15619-5. pp. 1–3

- ^ Hays, William Lee, (1973) Statistics for the Social Sciences, Holt, Rinehart and Winston, p.xii, ISBN 978-0-03-077945-9

- ^ Moore, David (1992). "Teaching Statistics as a Respectable Subject". In F. Gordon; S. Gordon (eds.). Statistics for the Twenty-First Century. Washington, DC: The Mathematical Association of America. pp. 14–25. ISBN 978-0-88385-078-7.

- ^ Chance, Beth L.; Rossman, Allan J. (2005). "Preface" (PDF). Investigating Statistical Concepts, Applications, and Methods. Duxbury Press. ISBN 978-0-495-05064-3. Archived (PDF) from the original on 2020-11-22. Retrieved 2009-12-06.

- ^ Lakshmikantham, D.; Kannan, V. (2002). Handbook of stochastic analysis and applications. New York: M. Dekker. ISBN 0824706609.

- ^ Schervish, Mark J. (1995). Theory of statistics (Corr. 2nd print. ed.). New York: Springer. ISBN 0387945466.

- ^ a b Broemeling, Lyle D. (1 November 2011). "An Account of Early Statistical Inference in Arab Cryptology". The American Statistician. 65 (4): 255–257. doi:10.1198/tas.2011.10191. S2CID 123537702.

- ^ Willcox, Walter (1938) "The Founder of Statistics". Review of the International Statistical Institute 5(4): 321–328. JSTOR 1400906

- ^ J. Franklin, The Science of Conjecture: Evidence and Probability before Pascal, Johns Hopkins Univ Pr 2002

- ^ Helen Mary Walker (1975). Studies in the history of statistical method. Arno Press. ISBN 9780405066283. Archived from the original on 2020-07-27. Retrieved 2015-06-27.

- ^ Galton, F (1877). "Typical laws of heredity". Nature. 15 (388): 492–553. Bibcode:1877Natur..15..492.. doi:10.1038/015492a0.

- ^ Stigler, S.M. (1989). "Francis Galton's Account of the Invention of Correlation". Statistical Science. 4 (2): 73–79. doi:10.1214/ss/1177012580.

- ^ Pearson, K. (1900). "On the Criterion that a given System of Deviations from the Probable in the Case of a Correlated System of Variables is such that it can be reasonably supposed to have arisen from Random Sampling". Philosophical Magazine. Series 5. 50 (302): 157–175. doi:10.1080/14786440009463897. Archived from the original on 2020-08-18. Retrieved 2019-06-27.

- ^ "Karl Pearson (1857–1936)". Department of Statistical Science – University College London. Archived from the original on 2008-09-25.

- ^ Box, JF (February 1980). "R.A. Fisher and the Design of Experiments, 1922–1926". The American Statistician. 34 (1): 1–7. doi:10.2307/2682986. JSTOR 2682986.

- ^ Yates, F (June 1964). "Sir Ronald Fisher and the Design of Experiments". Biometrics. 20 (2): 307–321. doi:10.2307/2528399. JSTOR 2528399.

- ^ Stanley, Julian C. (1966). "The Influence of Fisher's "The Design of Experiments" on Educational Research Thirty Years Later". American Educational Research Journal. 3 (3): 223–229. doi:10.3102/00028312003003223. JSTOR 1161806. S2CID 145725524.

- ^ Agresti, Alan; David B. Hichcock (2005). "Bayesian Inference for Categorical Data Analysis" (PDF). Statistical Methods & Applications. 14 (3): 298. doi:10.1007/s10260-005-0121-y. S2CID 18896230. Archived (PDF) from the original on 2013-12-19. Retrieved 2013-12-19.

- ^ OED quote: 1935 R.A. Fisher, The Design of Experiments ii. 19, "We may speak of this hypothesis as the 'null hypothesis', and the null hypothesis is never proved or established, but is possibly disproved, in the course of experimentation."

- ^ Fisher|1971|loc=Chapter II. The Principles of Experimentation, Illustrated by a Psycho-physical Experiment, Section 8. The Null Hypothesis

- ^ Edwards, A.W.F. (1998). "Natural Selection and the Sex Ratio: Fisher's Sources". American Naturalist. 151 (6): 564–569. doi:10.1086/286141. PMID 18811377. S2CID 40540426.

- ^ Fisher, R.A. (1915) The evolution of sexual preference. Eugenics Review (7) 184:192

- ^ Fisher, R.A. (1930) The Genetical Theory of Natural Selection. ISBN 0-19-850440-3

- ^ Edwards, A.W.F. (2000) Perspectives: Anecdotal, Historical and Critical Commentaries on Genetics. The Genetics Society of America (154) 1419:1426

- ^ Andersson, Malte (1994). Sexual Selection. Princeton University Press. ISBN 0-691-00057-3. Archived from the original on 2019-12-25. Retrieved 2019-09-19.

- ^ Andersson, M. and Simmons, L.W. (2006) Sexual selection and mate choice. Trends, Ecology and Evolution (21) 296:302

- ^ Gayon, J. (2010) Sexual selection: Another Darwinian process. Comptes Rendus Biologies (333) 134:144

- ^ Neyman, J (1934). "On the two different aspects of the representative method: The method of stratified sampling and the method of purposive selection". Journal of the Royal Statistical Society. 97 (4): 557–625. doi:10.2307/2342192. JSTOR 2342192.

- ^ "Science in a Complex World – Big Data: Opportunity or Threat?". Santa Fe Institute. Archived from the original on 2016-05-30. Retrieved 2014-10-13.

- ^ Freedman, D.A. (2005) Statistical Models: Theory and Practice, Cambridge University Press. ISBN 978-0-521-67105-7

- ^ McCarney R, Warner J, Iliffe S, van Haselen R, Griffin M, Fisher P (2007). "The Hawthorne Effect: a randomised, controlled trial". BMC Med Res Methodol. 7 (1): 30. doi:10.1186/1471-2288-7-30. PMC 1936999. PMID 17608932.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ Rothman, Kenneth J; Greenland, Sander; Lash, Timothy, eds. (2008). "7". Modern Epidemiology (3rd ed.). Lippincott Williams & Wilkins. p. 100. ISBN 9780781755641.

- ^ Mosteller, F.; Tukey, J.W (1977). Data analysis and regression. Boston: Addison-Wesley.

- ^ Nelder, J.A. (1990). The knowledge needed to computerise the analysis and interpretation of statistical information. In Expert systems and artificial intelligence: the need for information about data. Library Association Report, London, March, 23–27.

- ^ Chrisman, Nicholas R (1998). "Rethinking Levels of Measurement for Cartography". Cartography and Geographic Information Science. 25 (4): 231–242. doi:10.1559/152304098782383043.

- ^ van den Berg, G. (1991). Choosing an analysis method. Leiden: DSWO Press

- ^ Hand, D.J. (2004). Measurement theory and practice: The world through quantification. London: Arnold.

- ^ Mann, Prem S. (1995). Introductory Statistics (2nd ed.). Wiley. ISBN 0-471-31009-3.

- ^ Upton, G., Cook, I. (2008) Oxford Dictionary of Statistics, OUP. ISBN 978-0-19-954145-4.

- ^ a b Piazza Elio, Probabilità e Statistica, Esculapio 2007

- ^ Everitt, Brian (1998). The Cambridge Dictionary of Statistics. Cambridge, UK New York: Cambridge University Press. ISBN 0521593468.

- ^ "Cohen (1994) The Earth Is Round (p < .05)". YourStatsGuru.com. Archived from the original on 2015-09-05. Retrieved 2015-07-20.

- ^ Rubin, Donald B.; Little, Roderick J.A., Statistical analysis with missing data, New York: Wiley 2002

- ^ Ioannidis, J.P.A. (2005). "Why Most Published Research Findings Are False". PLOS Medicine. 2 (8): e124. doi:10.1371/journal.pmed.0020124. PMC 1182327. PMID 16060722.

{{cite journal}}: CS1 maint: unflagged free DOI (link) - ^ a b c Huff, Darrell (1954) How to Lie with Statistics, WW Norton & Company, Inc. New York. ISBN 0-393-31072-8

- ^ Warne, R. Lazo; Ramos, T.; Ritter, N. (2012). "Statistical Methods Used in Gifted Education Journals, 2006–2010". Gifted Child Quarterly. 56 (3): 134–149. doi:10.1177/0016986212444122. S2CID 144168910.

- ^ a b Drennan, Robert D. (2008). "Statistics in archaeology". In Pearsall, Deborah M. (ed.). Encyclopedia of Archaeology. Elsevier Inc. pp. 2093–2100. ISBN 978-0-12-373962-9.

- ^ a b Cohen, Jerome B. (December 1938). "Misuse of Statistics". Journal of the American Statistical Association. 33 (204). JSTOR: 657–674. doi:10.1080/01621459.1938.10502344.

- ^ Freund, J.E. (1988). "Modern Elementary Statistics". Credo Reference.

- ^ Huff, Darrell; Irving Geis (1954). How to Lie with Statistics. New York: Norton.

The dependability of a sample can be destroyed by [bias]... allow yourself some degree of skepticism.

- ^ Nelder, John A. (1999). "From Statistics to Statistical Science". Journal of the Royal Statistical Society. Series D (The Statistician). 48 (2): 257–269. doi:10.1111/1467-9884.00187. ISSN 0039-0526. JSTOR 2681191. Archived from the original on 2022-01-15. Retrieved 2022-01-15.

- ^ Nikoletseas, M.M. (2014) "Statistics: Concepts and Examples." ISBN 978-1500815684

- ^ Anderson, D.R.; Sweeney, D.J.; Williams, T.A. (1994) Introduction to Statistics: Concepts and Applications, pp. 5–9. West Group. ISBN 978-0-314-03309-3

- ^ "Journal of Business & Economic Statistics". Journal of Business & Economic Statistics. Taylor & Francis. Archived from the original on 27 July 2020. Retrieved 16 March 2020.

- ^ a b Natalia Loaiza Velásquez, María Isabel González Lutz & Julián Monge-Nájera (2011). "Which statistics should tropical biologists learn?" (PDF). Revista Biología Tropical. 59: 983–992. Archived (PDF) from the original on 2020-10-19. Retrieved 2020-04-26.

- ^ Pekoz, Erol (2009). The Manager's Guide to Statistics. Erol Pekoz. ISBN 9780979570438.

- ^ "Aims and scope". Journal of Business & Economic Statistics. Taylor & Francis. Archived from the original on 23 June 2021. Retrieved 16 March 2020.

- ^ "Journal of Business & Economic Statistics". Journal of Business & Economic Statistics. Taylor & Francis. Archived from the original on 27 July 2020. Retrieved 16 March 2020.

- ^ http://facweb.cs.depaul.edu/brewster/lsp121/Files/Stats2009.pdf [bare URL PDF]

- ^ Cline, Graysen (2019). Nonparametric Statistical Methods Using R. EDTECH. ISBN 978-1-83947-325-8. OCLC 1132348139. Archived from the original on 2022-05-15. Retrieved 2021-09-16.

- ^ Palacios, Bernardo; Rosario, Alfonso; Wilhelmus, Monica M.; Zetina, Sandra; Zenit, Roberto (2019-10-30). "Pollock avoided hydrodynamic instabilities to paint with his dripping technique". PLOS ONE. 14 (10): e0223706. Bibcode:2019PLoSO..1423706P. doi:10.1371/journal.pone.0223706. ISSN 1932-6203. PMC 6821064. PMID 31665191.

Further reading

- Lydia Denworth, "A Significant Problem: Standard scientific methods are under fire. Will anything change?", Scientific American, vol. 321, no. 4 (October 2019), pp. 62–67. "The use of p values for nearly a century [since 1925] to determine statistical significance of experimental results has contributed to an illusion of certainty and [to] reproducibility crises in many scientific fields. There is growing determination to reform statistical analysis... Some [researchers] suggest changing statistical methods, whereas others would do away with a threshold for defining "significant" results." (p. 63.)

- Barbara Illowsky; Susan Dean (2014). Introductory Statistics. OpenStax CNX. ISBN 9781938168208.

- Stockburger, David W. "Introductory Statistics: Concepts, Models, and Applications". Missouri State University (3rd Web ed.). Archived from the original on 28 May 2020.

- OpenIntro Statistics Archived 2019-06-16 at the Wayback Machine, 3rd edition by Diez, Barr, and Cetinkaya-Rundel

- Stephen Jones, 2010. Statistics in Psychology: Explanations without Equations. Palgrave Macmillan. ISBN 9781137282392.

- Cohen, J (1990). "Things I have learned (so far)" (PDF). American Psychologist. 45 (12): 1304–1312. doi:10.1037/0003-066x.45.12.1304. Archived from the original (PDF) on 2017-10-18.

- Gigerenzer, G (2004). "Mindless statistics". Journal of Socio-Economics. 33 (5): 587–606. doi:10.1016/j.socec.2004.09.033.

- Ioannidis, J.P.A. (2005). "Why most published research findings are false". PLOS Medicine. 2 (4): 696–701. doi:10.1371/journal.pmed.0040168. PMC 1855693. PMID 17456002.

{{cite journal}}: CS1 maint: unflagged free DOI (link)

External links

- (Electronic Version): TIBCO Software Inc. (2020). Data Science Textbook.

- Online Statistics Education: An Interactive Multimedia Course of Study. Developed by Rice University (Lead Developer), University of Houston Clear Lake, Tufts University, and National Science Foundation.

- UCLA Statistical Computing Resources

- Philosophy of Statistics from the Stanford Encyclopedia of Philosophy