Conditional probability

| Part of a series on statistics |

| Probability theory |

|---|

|

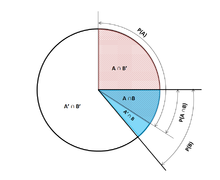

확률 이론(probability theory)에서, 조건부 확률(conditional probability)은 또 다른 사건이 (가정, 추정, 주장 또는 증거에 의해) 발생된 것으로 주어졌을 때 발생하는 사건(event)의 확률(probability)의 측정입니다.[1] 만약 관심의 사건이 A이고 사건 B가 알려져 있거나 발생한 것으로 가정되면, "주어진 B에 대한 A의 조건부 확률" 또는 "조건 B 아래에서 A의 확률"은 P(A|B), 또는 때때로 PB(A) 또는 P(A/B)로 보통 쓰입니다. 예를 들어, 임의의 주어진 사람이 임의의 주어진 날에 기침을 하는 확률은 단지 5%일 수 있습니다. 그러나 만약 우리가 그 사람이 감기(cold)에 걸렸다고 알고 있거나 가정하면, 그들이 기침을 할 가능성이 훨씬 높아집니다. 기침하는 어떤 사람이 아픈 조건부 확률은 75%일 수 있으며, 이때에: P(기침) = 5%; P(아픔 | 기침) = 75%입니다.

조건부 확률의 개념은 확률 이론에서 가장 기본적인 것 중에 하나이고 가장 중요한 개념 중 하나입니다.[2] 그러나 조건부 확률은 꽤 의미가 선명하지 않을 수 있고 주의-깊은 해석이 필요합니다.[3] 예를 들어, A와 B 사이에 인과 관계가 있을 필요가 없고, 그들이 반드시 동시에 발생할 필요가 없습니다.

P(A|B)는 P(A) (A의 무조건적 확률)와 같을 수도 있고 같지 않을 수도 있습니다. 만약 P(A|B) = P(A)이면, 사건 A와 사건 B는 "독립적(independent)"이라고 말합니다: 그러한 경우에서, 어느 한 쪽 사건에 대한 지식이 남은 한 사건에 대한 정보(information)을 제공하지 않습니다. P(A|B) (주어진 B에 대한 A의 조건부 확률)은 전형적으로 P(B|A)와 다릅니다. 예를 들어, 만약 한 사람이 뎅기열(Dengue)을 가지면, 그들은 뎅기열에 대해 테스트에서 90%의 확률로 양성을 가집니다. 이 경우에서, 측정되는 것은 만약 사건 B ("뎅기열을 가짐")가 발생하면, B (뎅기열을 가짐)가 발생한 것으로 주어졌을 때 A (테스트가 양성임)의 확률이 90%입니다: 즉, P(A|B) = 90%입니다. 대안적으로, 만약 한 사람의 테스트가 뎅기열에 대해 양성이면, 그들이 실제로 이 희귀 질환을 가지는 오직 15% 가능성을 가질 것인데 왜냐하면 테스트에 대해 거짓 양성(false positive) 율은 높을 수 있습니다. 이 경우에서, 측정되는 것은 사건 A (테스트가 양성임)가 발생한 것으로 주어졌을 때 사건 B (뎅기열을 가짐)의 확률입니다: P(B|A) = 15%입니다. 두 확률을 잘못되게 식을 세우는 것은 기본율 오류(base rate fallacy)와 같은 추론의 다양한 오류에 원인이 있습니다. 조건부 확률은 베이즈의 정리(Bayes' theorem)를 사용하여 되돌릴 수 있습니다.

조건부 확률은 조건부 확률 테이블(conditional probability table)에 표시될 수 있습니다.

Definition

Conditioning on an event

Kolmogorov definition

확률 공간의 시그마-필드(sigma-field)로부터, 두 사건(events) A와 B, B의 무조건 확률(unconditional probability) (즉, 사건 B가 발생하는)이 영보다 크다는 것, P(B) > 0와 함께 주어지면, 주어진 B에 대한 A의 조건부 확률은 사건 A와 B의 결합 확률, 및 B의 확률(probability)의 몫(quotient)으로 정의됩니다:[4]

여기서 는 사건 A와 B 둘 다가 발생하는 확률입니다. 이것은 B가 발생하는 상황으로 표본 공간을 제한하는 것으로 시각화될 수 있습니다. 이 방정식의 숨은 논리는 만약 A와 B에 대해 가능한 결과가 B가 발생하는 결과로 제한되면, 이 집합이 새로운 표본 공간으로 사용된다는 것입니다.

이것은 정의이지만 이론적인 결과가 아님에 주목하십시오. 우리는 단지 양 를 으로 나타내고 그것을 주어진 B에 대한 A의 조건부 확률이라고 부를 뿐입니다.

As an axiom of probability

데 피네티(de Finetti)와 같은, 일부 저자는 확률의 공리(axiom of probability)로 조건부 확률을 소개하는 것을 선호합니다:

비록 수학적으로는 동등할지라도, 이것은 철학적으로 선호될 수 있습니다; 주관적 이론(subjective theory)과 같은 주요한 확률 해석(probability interpretations) 아래에서, 조건부 확률은 원시적 엔터디로 여겨집니다. 게다가, 이 "곱셈 공리"는 서로 배타적 사건(mutually exclusive events)에 대해 합 공리와 함께 대칭을 도입합니다:[5]

As the probability of a conditional event

조건부 확률은 조건부 사건 의 확률로 정의될 수 있습니다.[6] 사건 and 에 놓여-있는 실험이 반복된다고 가정하면, 굳맨–누엔–반 프라센(Goodman–Nguyen–van Fraassen) 조건부 사건은 다음으로 정의될 수 있습니다:

그것은 다음인 것으로 보일 수 있습니다:

이것은 조건부 확률의 콜모고로프 정의를 만족시킵니다. 방정식 는 이론적 결과이지만 정의가 아님에 주목하십시오. 조건적 사건을 통한 정의는 콜모고로프 공리(Kolmogorov axioms)의 관점에서 직접적으로 이해될 수 있고 실험 데이터의 관점에서 확률의 콜모고로프 해석(interpretation of probability)에 특히 가깝습니다. 예를 들어, 조건부 사건은 조건적 사건 의 일반화된 개념에 이어지는 그들 자신으로 반복될 수 있습니다. 수열 는 독립적이고 동일하게 분포된 확률 변수(i.i.d.)임을 보여줄 수 있으며,[6] 이것은 조건부 확률에 대해 큰 숫자의 강한 법칙(strong law of large numbers)을 산출합니다:

Measure-theoretic definition

만약 P(B) = 0이면, 간단한 정의에 따라, P(A|B)는 정의되지 않습니다. 어쨌든, (연속 확률 변수(continuous random variable)로부터 발생하는 것과 같은) 그러한 사건의 σ-대수(σ-algebra)에 관한 조건부 확률을 정의하는 것이 가능합니다.

예를 들어, 만약 X와 Y가 밀도 ƒX,Y(x, y)를 갖는 비-퇴화이고 결합적으로 연속 확률 변수이면, 만약 B가 양의 측정(measure)을 가지면,

B가 영 측정을 가지는 경우는 문제가 있습니다. 단일 점을 나타내는 B = {y0}의 경우에 대해, 조건부 확률은 다음으로 정의될 수 있습니다:

어쨌든 이 접근법은 보렐–콜모고로프 역설(Borel–Kolmogorov paradox)로 이어집니다. 영 측정의 보다 일반적인 경우는 훨씬 더 문제가 있는데, 왜냐하면 모든 δyi가 영에 접근함에 따라,

의 극한이 영에 가까워질 때 그들의 관계에 의존함에 주목함으로써 알 수 있기 때문입니다. 자세한 정보에 대해 조건부 기대(conditional expectation)를 참조하십시오.

Conditioning on a random variable

X를 확률 변수로 놓습니다; 우리는 X가 유한, 즉, X는 오직 유한하게 많은 값 x를 취하는 표시를 형식으로 씀을 가정합니다. A를 사건으로 놓습니다. 주어진 X에 대해 A의 조건부 확률은,

일 때마다, 값

을 취하는, P(A|X)로 쓰이는, 확률 변수로 정의됩니다.

보다 공식적으로,

조건부 확률 P(A|X)는 X의 함수입니다: 예를 들어, 만약 함수 g가 다음으로 정의되면,

다음입니다:

- .

P(A|X)와 X는 이제 둘 다 확률 변수(random variable)인 것을 주목하십시오. 전체 확률의 법칙(law of total probability)으로부터, P(A|X)의 기댓값(expected value)은 A의 무조건 확률(probability)과 같습니다.

Partial conditional probability

부분 조건부 확률 은 조건 사건 의 각각이 100%와 다를 수 있는 정도 (믿음의 정도, 경험의 정도)에 대해 발생해 온 것으로 주어지는 사건 의 확률에 대한 것입니다. 빈번하게, 부분 조건부 확률은, 만약 조건이 적절한 길이 의 실험 반복에서 테스트되면, 의미가 있습니다.[7] 그러한 -경계진 부분 조건부 확률은 모든 확률 사양 를 준수하는 길이 의 시험대에서 사건 의 조건부로 예상된(conditionally expected) 평균 발생으로 정의될 수 있습니다. 즉:

그것에 기초하여, 부분 조건부 확률은 다음으로 정의될 수 있습니다:

여기서 입니다. [7]

제프리 조건부화(Jeffrey conditionalization)[8] [9]는 조건 사건이 파티션(partition)을 반드시 형성해야 하는 부분 조건부 확률의 특별한 경우입니다:

Example

누군가가 두 개의 공정한 육-면체 주사위(dice)를 은밀하게 굴린다고 가정하고, 우리는 그 합이 5보다 크지 않다는 정보가 주어지면, 첫 번째 주사위의 윗면의 값이 2일 확률을 계산하기를 원합니다.

D1 = 2일 때 확률

테이블 1은 적색 및 진회색 셀에 표시되는 숫자가 D1 + D2를 갖는, 주사위 각각은 확률 1/36로 발생하는, 두 주사위의 굴려진 값 36 조합의 표본 공간(sample space)을 보여줍니다.

36 결과의 정확히 6개에서 D1 = 2이며; 따라서 P(D1 = 2) = 6⁄36 = 1⁄6입니다:

Table 1 + D2 1 2 3 4 5 6 D1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

D1 + D2 ≤ 5일 때 확률

테이블 2는 36 결과의 정확히 10개에 대해 D1 + D2 ≤ 5임을 보여주며, 따라서 P(D1 + D1 ≤ 5) = 10⁄36입니다:

Table 2 + D2 1 2 3 4 5 6 D1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

D1 + D2 ≤ 5 주어졌을 때 D1 = 2일 확률

테이블 3은 10 결과의 3개에 대해, D1 = 2임을 보여줍니다.

따라서, 조건부 확률 P(D1 = 2 | D1+D2 ≤ 5) = 3⁄10 = 0.3입니다:

Table 3 + D2 1 2 3 4 5 6 D1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

여기서, 조건부 확률의 정의에 대해 초기 표기법에서, 조건하는 사건 B는 D1 + D2 ≤ 5인 것이고, 사건 A는 D1 = 2입니다. 우리는, 테이블에서 보이는 것처럼, 을 가집니다.

Use in inference

통계적 추론(statistical inference)에서, 조건부 확률은 새로운 정보를 기반으로 사건(event)의 확률을 업데이트한 것입니다.[3] 새로운 정보를 통합하는 것은 다음으로 수행될 수 있습니다:[1]

- 표본 공간(sample space), 말하자면 (X,P)에 있는, 관심의 사건, A로 놓습니다.

- 사건 B가 발생했거나 발생할 것임을 아는 것에서 사건 A의 발생은, B로 제한되었을 때 A의 발생, 즉, 를 의미합니다.

- B의 발생의 지식없이, A의 발생에 대한 정보는 단순히 P(A)일 것입니다.

- 사건 B가 발생했거나 발생할 것임을 아는 것에서 A의 확률은, B가 발생했을 확률, P(B)에 상대적인 의 확률일 것입니다.

- 이것은 P(B) > 0일 때마다 를 초래하고 그렇지 않으면 0입니다.

이 접근은 원래 확률 측정과 일치하고 모든 콜모고로프 공리(Kolmogorov axioms)를 만족시키는 확률 측정을 초래합니다. 이 조건부 확률 측정은 역시 X에 관한 A의 확률의 상대적인 크기가 B에 관하여 보존될 것임을 가정함으로써 결과로써 생길 것입니다 (참고. 아래의 공식적인 유도(a Formal Derivation) 참조하십시오).

"증거" 또는 "정보"라는 표현은 일반적으로 확률의 베이즈 해석(Bayesian interpretation of probability)에서 사용됩니다. 조건하는 사건은 조건된 사건에 대해 증거로 해석됩니다. 즉, P(A)는 증거 E를 설명하기 전의 A의 확률이고, P(A|E)는 증거 E를 설명한 후 또는 P(A)를 업데이트한 후에 A의 확률입니다. 이것은 위에 주어진 첫 번째 정의인 빈도주의 해석과 일치합니다.

Statistical independence

사건 A와 B는, 만약

이면, 통계적으로 독립(statistically independent)인 것으로 정의됩니다.

만약 P(B)가 영이 아니면, 이것은

인 명제와 동등합니다.

비슷하게, 만약 P(A)가 영이 아니면,

은 역시 동등합니다. 비록 유도된 형식이 보다 직관적으로 보일지라도, 그것들은 조건부 확률이 정의되지 않을 수 있기 때문에 바람직한 정의가 아니고, 선호되는 정의는 A와 B에서 대칭적입니다.

독립 사건 대 서로 배타적 사건(Independent events vs. mutually exclusive events)

서로 독립적 사건과 서로 배타적 사건(mutually exclusive events)의 개념은 분리되고 별개입니다. 다음 테이블은 (조건하는 사건의 확률이 0이 아닌 것으로 제공되는) 두 경우에 대해 결과를 대조합니다.

| 만약 통계적 독립이면 | 만약 서로 배타적이면 | |

|---|---|---|

| 0 | ||

| 0 | ||

| 0 |

사실, 서로 배타적 사건은 절대 통계적으로 독립일 수 없는데, 왜냐하면 하나가 발생한 것을 아는 것이 다른 것에 대한 정보 (구체적으로, 그것이 확실히 발생하지 않았다는 것)를 제공하기 때문입니다.

Common fallacies

- These fallacies should not be confused with Robert K. Shope's 1978 "conditional fallacy", which deals with counterfactual examples that beg the question.

Assuming conditional probability is of similar size to its inverse

일반적으로, P(A|B) ≈ P(B|A)라고 가정할 수 없습니다. 이것은, 심지어 통계에 능숙한 사람들에게조차도, 교활한 오류일 수 있습니다.[10] P(A|B)와 P(B|A) 사이의 관계는 베이즈의 정리(Bayes' theorem)에 의해 주어집니다:

즉, 오직 만약 P(B)/P(A) ≈ 1, 또는 동등하게, P(A) ≈ P(B)이면, P(A|B) ≈ P(B|A)입니다.

Assuming marginal and conditional probabilities are of similar size

일반적으로, P(A) ≈ P(A|B)라고 가정할 수 없습니다. 이들 확률은 전체 확률의 법칙(law of total probability)을 통해 연결됩니다:

- .

여기서 사건 은 의 셀 수 있는 분할(partition)을 형성합니다.

이 오류는 선택 편향(selection bias)을 통해 발생할 수 있습니다.[11] 예를 들어, 의학적 주장의 문맥에서, SC를 후유증(sequela) (만성 질환) S가 환경 (급성 질환) C의 결과로 발생하는 사건으로 놓습니다. H를 개인이 의료 도움을 찾는 사건으로 놓습니다. 대부분의 경우에서, C가 S의 원인이 되지 않으므로 P(SC)가 낮다고 가정합니다. 역시 의학적 관심은 만약 S가 C로 인해서 발생했다면 오직 요구된다고 가정합니다. 환자의 경험으로부터, 의사는 따라서 P(SC)가 높다고 잘못 판단할 수 있습니다. 의사에 의해 관찰된 실제 확률은 P(SC|H)입니다.

Over- or under-weighting priors

이전 확률을 부분적으로 또는 완전히 취하지 않는 것은 기저율 태만(base rate neglect)이라고 불립니다. 반대로, 이전 확률로부터 불충분한 조정은 보수주의(conservatism)입니다.

Formal derivation

공식적으로, P(A | B)는, B에 없는 결과가 확률 0을 가지고 것 및 모든 원래의 확률 측정(probability measure)과 일치하는 것을 만족하는, 표본 공간에서 새로운 확률 함수에 따라 A의 확률로 정의됩니다.[12][13]

Ω를 기본 사건(elementary event) {ω}을 갖는 표본 공간(sample space)으로 놓습니다. 우리가 사건 B ⊆ Ω이 발생해 왔다고 말을 들었다고 가정해 보십시오. (조건부 표기법에 의해 표시되는) 새로운 확률 분포는 이것을 반영하기 위해 {ω}에 할당되는 것입니다. B에서 사건에 대해, 확률의 상대적인 크기가 보존될 것이라고 가정하는 것이 합리적입니다. 어떤 상수 스케일 인수 α에 대해, 새로운 분포는 따라서 다음을 만족시킬 것입니다:

α를 선택하기 위해 1과 2를 3에 대입하면:

따라서 새로운 확률 분포는 다음입니다:

이제 일반적인 사건 A에 대해,

See also

- Borel–Kolmogorov paradox

- Chain rule (probability)

- Class membership probabilities

- Conditional probability distribution

- Conditioning (probability)

- Joint probability distribution

- Monty Hall problem

- Posterior probability

References

- ^ a b Gut, Allan (2013). Probability: A Graduate Course (Second ed.). New York, NY: Springer. ISBN 978-1-4614-4707-8.

- ^ Ross, Sheldon (2010). A First Course in Probability (8th ed.). Pearson Prentice Hall. ISBN 978-0-13-603313-4.

- ^ a b Casella, George; Berger, Roger L. (2002). Statistical Inference. Duxbury Press. ISBN 0-534-24312-6.

- ^ Kolmogorov, Andrey (1956), Foundations of the Theory of Probability, Chelsea

{{citation}}: Cite has empty unknown parameter:|1=(help) - ^ Gillies, Donald (2000); "Philosophical Theories of Probability"; Routledge; Chapter 4 "The subjective theory"

- ^ a b Draheim, Dirk (2017). "An Operational Semantics of Conditional Probabilities that Fully Adheres to Kolmogorov's Explication of Probability Theory". doi:10.13140/RG.2.2.10050.48323/3.

- ^ a b c Draheim, Dirk (2017). "Generalized Jeffrey Conditionalization (A Frequentist Semantics of Partial Conditionalization)". Springer. Retrieved December 19, 2017.

- ^ Jeffrey, Richard C. (1983), The Logic of Decision, 2nd edition, University of Chicago Press

- ^ "Bayesian Epistemology". Stanford Encyclopedia of Philosophy. 2017. Retrieved December 29, 2017.

- ^ Paulos, J.A. (1988) Innumeracy: Mathematical Illiteracy and its Consequences, Hill and Wang. ISBN 0-8090-7447-8 (p. 63 et seq.)

- ^ Thomas Bruss, F; Der Wyatt Earp Effekt; Spektrum der Wissenschaft; March 2007

- ^ George Casella and Roger L. Berger (1990), Statistical Inference, Duxbury Press, ISBN 0-534-11958-1 (p. 18 et seq.)

- ^ Grinstead and Snell's Introduction to Probability, p. 134

External links

- Weisstein, Eric W. "Conditional Probability". MathWorld.

- F. Thomas Bruss Der Wyatt-Earp-Effekt oder die betörende Macht kleiner Wahrscheinlichkeiten (in German), Spektrum der Wissenschaft (German Edition of Scientific American), Vol 2, 110–113, (2007).

- Visual explanation of conditional probability

![{\displaystyle P(X\in A\mid Y\in \bigcup _{i}[y_{i},y_{i}+\delta y_{i}])\approxeq {\frac {\sum _{i}\int _{x\in A}f_{X,Y}(x,y_{i})\,dx\,\delta y_{i}}{\sum _{i}\int _{x\in \mathbb {R} }f_{X,Y}(x,y_{i})\,dx\,\delta y_{i}}},}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/26f127ee4281f3096623f1808477d47e2d60ad01)

![{\displaystyle {\begin{aligned}1&=\sum _{\omega \in \Omega }{P(\omega \mid B)}\\&=\sum _{\omega \in B}{P(\omega \mid B)}+{\cancelto {0}{\sum _{\omega \notin B}P(\omega \mid B)}}\\&=\alpha \sum _{\omega \in B}{P(\omega )}\\[5pt]&=\alpha \cdot P(B)\\[5pt]\Rightarrow \alpha &={\frac {1}{P(B)}}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/bc21b49c38af5566aeb4794016be9ee06b40458c)

![{\displaystyle {\begin{aligned}P(A\mid B)&=\sum _{\omega \in A\cap B}{P(\omega \mid B)}+{\cancelto {0}{\sum _{\omega \in A\cap B^{c}}P(\omega \mid B)}}\\&=\sum _{\omega \in A\cap B}{\frac {P(\omega )}{P(B)}}\\[5pt]&={\frac {P(A\cap B)}{P(B)}}\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/4f6e98f9200e5cf74a15231fc3c753ccfeb8d1c6)