Median

통계학(statistics)과 확률 이론(probability theory)에서, 중앙값은 데이터 표본(data sample), 모집단(population), 또는 확률 분포(probability distribution)의 상위 절반과 하위 절반을 구분하는 값입니다. 데이터 집합에 대해, 그것은 "중간" 값으로 생각될 수 있습니다. 평균(mean 또는 average)과 비교되는 데이터를 설명하는 것에서 중앙값의 기본 특징은 극단적으로 크거나 극단적으로 작은 값의 작은 비율에 의해 기울어지지(skewed) 않고, 따라서 "전형적인" 값의 더 나은 표현을 제공한다는 것입니다. 중위 소득(median income)은, 예를 들어, 소득 분포가 매우 기울어질 수 있기 때문에 "전형적인" 소득이 무엇인지 제안하는 더 나은 방법일 수 있습니다. 중앙값은 50%의 고장 점(breakdown point)을 가지는 가장 큰 저항 통계량(resistant statistic)이기 때문에, 강건 통계(robust statistics)에서 중심적으로 중요합니다: 데이터의 절반 이상이 오염되지 않은 한, 중앙값은 임의적으로 크거나 임의적으로 작은 결과가 아닙니다.

Finite data set of numbers

유한 숫자의 목록의 중앙값은 해당 숫자가 가장 작은 것에서 가장 큰 순서로 나열될 때 "중간" 숫자입니다.

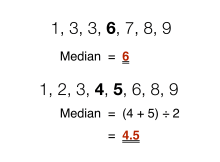

만약 데이터 집합이 관측의 홀수를 가지면 중간의 하나가 선택됩니다. 예를 들어 다음 7개의 숫자 목록은,

- 1, 3, 3, 6, 7, 8, 9

네 번째 숫자인 6의 중앙값을 가집니다.

만약 데이터 집합이 관측의 짝수를 가지면, 구별되는 중간 값이 없고 중앙값은 보통 두 중간 값의 산술 평균(arithmetic mean)으로 정의됩니다.[1][2] 예를 들어, 8개의 숫자로 구성된 이 데이터 집합은,

- 1, 2, 3, 4, 5, 6, 8, 9

4.5, 즉, 의 중앙값을 가집니다. (좀 더 기술적인 용어로, 이것은 중앙값을 완전히 정돈된(trimmed) 중간-범위(mid-range)로 해석합니다).

일반적으로, 이 관례와 함께, 중앙값은 다음과 같이 정의될 수 있습니다: 원소의 데이터 집합 에 대해, 작은 것부터 큰 것 순으로 순서화되어,

- 만약 이 홀수이면,

- 만약 이 짝수이면,

| 유형 | 설명 | 예제 | 결과 |

|---|---|---|---|

| 산술 평균 | 데이터 집합의 값의 합을 값의 개수로 나눈 값: | (1 + 2 + 2 + 3 + 4 + 7 + 9) / 7 | 4 |

| 중앙값 | 데이터 집합의 더 큰 부분과 더 작은 부분을 구분하는 중간 값 | 1, 2, 2, 3, 4, 7, 9 | 3 |

| 최빈값 | 데이터 집합에서 가장 빈번한 값 | 1, 2, 2, 3, 4, 7, 9 | 2 |

Formal definition

공식적으로, 모집단(population)의 중앙값은 모집단의 많아야 절반이 제안된 중앙값보다 작고 많아야 절반이 제안된 중앙값보다 큰 값을 만족하는 임의의 값입니다. 위에서 보인 것처럼, 중앙값은 고유하지 않을 수 있습니다. 만약 각 집합이 모집단의 절반보다 작게 포함되면, 일부 모집단은 고유한 중앙값과 정확하게 같습니다.

중앙값은 임의의 순서화(ordered)된 (일-차원) 데이터에 대해 잘-정의된 것이고, 임의의 거리 메트릭(distance metric)과 무관합니다. 중앙값은 따라서 순위가 매겨지지만 숫자가 아닌 클래스에 적용될 수 있지만 (예를 들어, 학생이 A에서 F까지 등급이 매겨질 때 중앙값 등급 계산), 그 결과는 경우의 짝수가 있으면 클래스 사이의 중간일 수 있습니다.

기하학적 중앙값(geometric median)은, 다른 한편으로, 임의의 숫자의 차원에서 정의됩니다. 그 결과가 표본의 구성원과 일치하도록 강제되는 관련된 개념은 메도이드(medoid)입니다.

중앙값에 대해 널리 인정되는 표준 표기법은 없지만, 일부 저자는 변수 x의 중앙값을 x͂ 또는 μ1/2로 표현하기도 하고,[1] 때로는 M로 표시하기도 합니다.[3][4] 이들 경우의 어떤 것에서, 중앙값에 대해 이들 기호 또는 다른 기호의 사용은 그것들이 도입될 때 명시적으로 정의되어야 합니다.

중앙값은 통계적 분포와 결합된 전형적 값을 요약하는 다른 방법의 특별한 경우입니다: 그것은 2번째 사분위수(quartile), 5번째 십분위수(decile), 및 50번째 백분위수(percentile)입니다.

Uses

중앙값은 전형적으로 분포가 기울어져(skewed) 있거나, 극단 값이 알려져 있지 않거나, 이상값(outlier)이 및기지 않는, 예를 들어, 측정/녹음 오류일 수 있기 때문에, 극단 값에 대한 감소된 중요성을 덧붙일 때 위치(location)의 측정으로 사용될 수 있습니다.

예를 들어, 다음 중복집합(multiset)을 생각해 보십시오:

- 1, 2, 2, 2, 3, 14.

중앙값은 이 경우에서 2이고, (최빈값(mode)과 마찬가지로), 그것은 전체 값 중 하나를 제외한 모든 값보다 큰 4의 산술 평균(arithmetic mean)보다 중심(center)의 더 나은 인식으로 보일 수 있습니다. 어쨌든, 평균이 중앙값보다 분포의 "꼬리쪽으로 더" 이동한다는 널리 인용되는 경험적 관계는 일반적으로 참이 아닙니다. 기껏해야, 두 통계량이 "너무 멀리" 떨어져 있을 수 없다고 말할 수 있습니다; 아래의 § Inequality relating means and medians를 참조하십시오.[5]

중앙값은 집합에서 중간 데이터를 기반으로 하므로, 극단적인 결과 값을 계산하기 위해 알 필요가 없습니다. 예를 들어, 문제를 해결하는 데 필요한 시간을 조사하는 심리학 테스트에서, 만약 작은 일부의 사람들이 주어진 시간 내에 문제를 전혀 해결하지 못하더라도, 중앙값은 여전히 계산될 수 있습니다.[6]

중앙값은 이해하기 위해 간단하고 계산하기 위해 쉽지만, 역시 평균(mean)에 대한 강건 근사이기 때문에, 중앙값은 기술 통계학(descriptive statistics)에서 널리 사용되는 요약 통계량(summary statistic)입니다. 이러한 문맥에서, 변동가능성(variability)의 측정에 대해: 범위(range), 사분위수-사이 범위(interquartile range), 평균 절대 편차(mean absolute deviation), 및 중앙값 절대 편차(median absolute deviation)와 같은 몇 가지 선택이 있습니다.

실용적인 목적을 위해, 위치와 산포도의 다른 측정값이 데이터의 표본에서 해당 모집단 값을 얼마나 잘 추정할 수 있는지에 따라 종종 비교됩니다. 표본 중앙값을 사용하여 추정된 중앙값은 이와 관련하여 좋은 속성을 가지고 있습니다. 만약 주어진 모집단 분포가 가정되면 보통 최적은 아니지만, 그것의 속성은 항상 합리적으로 좋습니다. 예를 들어, 후보 추정기의 효율성(efficiency)의 비교는 표본 평균이 데이터가 두꺼운-꼬리 분포 또는 분포의 혼합에서 데이터를 오염되지 않을 때 – 오직 그때 – 통계적으로 더 효율적이라는 것을 보여줍니다. 심지어 그때에, 중앙값은 (대규모 정규 표본에 대해) 최소-분산 평균과 비교하여 64% 효율성을 가지며, 이것은 중앙값의 분산이 평균의 분산보다 ~50% 더 클 것임을 말하는 것입니다.[7][8]

Probability distributions

누적 분포 함수(cumulative distribution function) F를 갖는 임의의 실수(real)-값 확률 분포(probability distribution)에 대해, 중앙값은 다음 부등식을 만족시키는 임의의 실수 m으로 정의됩니다:

- .

동등한 문구는 F에 따라 분포된 확률 변수 X를 사용합니다:

이 정의는 X를 절대적으로 연속 분포(absolutely continuous distribution) (확률 밀도 함수(probability density function) ƒ를 가짐)를 가지는 것으로 요구하지도 않고, 이산 분포도 요구하지 않음을 주목하십시오. 전자의 경우에서, 부등식은 상등으로 업그레이드될 수 있습니다: 중앙값은 다음을 만족시킵니다:

- .

R 위에 임의의 확률 분포(probability distribution)는 적어도 하나의 중앙값을 갖지만, 병리학적인 경우에서, 하나보다 많은 중앙값이 있을 수 있습니다: 만약 F가 (그곳에서 ƒ=0이 되도록) 구간 위에 상수 1/2이면, 해당 구간의 임의의 값은 중앙값입니다.

Medians of particular distributions

특정 유형의 분포의 중앙값은 그것들의 매개변수에서 쉽게 계산될 수 있습니다; 게다가, 그것들은 심지어 코시 분포(Cauchy distribution)와 같이 잘-정의된 평균이 없는 일부 분포에도 존재합니다:

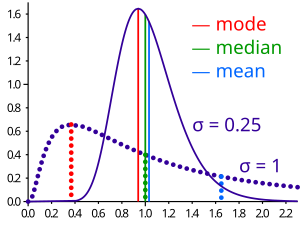

- 대칭 단일-봉우리 분포(unimodal distribution)의 중앙값은 최빈값과 일치합니다.

- 평균 μ를 보유하는 대칭 분포(symmetric distribution)의 중앙값은 역시 μ 값을 취합니다.

- 평균 μ와 분산 σ2을 갖는 정규 분포(normal distribution)의 중앙값은 μ입니다. 사실, 정규 분포에 대해, 평균 = 중앙값 = 최빈값입니다.

- 구간 [a, b]에서 균등 분포(uniform distribution)의 중앙값은 (a + b) / 2이며, 이것은 역시 평균입니다.

- 위치 매개변수 x0와 스케일 매개변수 y를 갖는 코시 분포(Cauchy distribution)의 중앙값은 x0, 위치 매개변수입니다.

- 지수 a > 1를 갖는 거듭제곱 법칙 분포(power law distribution) x−a의 중앙값은 21/(a − 1)xmin이며, 여기서 xmin는 거듭제곱 법칙이 유지되는 최솟값입니다.[10]

- 율 매개변수(rate parameter) λ를 갖는 지수 분포(exponential distribution)의 중앙값은 2의 자연 로그를 율 매개변수로 나눈 값: λ−1ln 2입니다.

- 모양 매개변수 k와 스케일 매개변수 λ를 갖는 웨이블 분포(Weibull distribution)의 중앙값은 λ(ln 2)1/k입니다.

Populations

Optimality property

확률 변수(random variable) X에 관한 실수 변수 c의 평균 절대 오차(mean absolute error)는 다음입니다:

X의 확률 분포가 위의 기댓값이 존재함을 만족하는 것이면, m이 X의 중앙값인 것과 m이 X에 관한 평균 절대 오차의 최소화기인 것은 필요충분 조건이라는 조건으로 합니다.[11] 특히, m은 표본 중앙값인 것과 m이 절대 편차의 산술 평균을 최소화하는 것은 필요충분 조건입니다.[12]

보다 일반적으로, 중앙값은 아래 다변수 중앙값(multivariate median) (구체적으로, 공간 중앙값(spatial median))에 대한 섹션에서 논의된 것처럼 다음의 최솟값으로 정의됩니다:

- .

중앙값의 이 최적화-기반 정의는 통계적 데이터-분석, 예를 들어, k-중앙값 클러스터링(k-medians clustering)에서 유용합니다.

Inequality relating means and medians

만약 분포가 유한 분산을 가지면, 중앙값 와 평균 사이의 거리는 일 표준편차(standard deviation)에 의해 경계집니다.

이 경계는 다음처럼 옌센 부등식(Jensen's inequality)을 두 번 사용했었던 맬로우스(Mallows)에 의해 입증되었습니다.[13] |·|를 절댓값(absolute value)에 대해 사용하여, 우리는 다음을 가집니다:

첫 번째 부등식과 세 번째 부등식은 각각 볼록한 것인 절대-값 함수와 제곱 함수에 적용된 옌센의 부등식에서 옵니다. 두 번째 부등식은 중앙값이 절대 편차(absolute deviation) 함수 를 최소화한다는 사실에서 옵니다.

맬로우스의 증명은 단순히 절댓값을 노름(norm)으로 대체함으로써 부등식의 다변수 버전을 얻기 위해 일반화될 수 있습니다:[14]

여기서 m은 공간 중앙값(spatial median), 즉, 함수 의 최소화기입니다. 공간 중앙값은 데이터-집합의 차원이 둘 이상일 때 고유합니다.[15][16]

대안적 증명은 한-쪽 체비쇼프 부등식을 사용합니다; 그것은 위치와 스케일 매개변수에 대한 부등식에서 나타납니다. 이 공식은 역시 칸텔리의 부등식(Cantelli's inequality)에서 직접 따릅니다.[17]

Unimodal distributions

단일-봉우리(unimodal) 분포의 경우에 대해, 우리는 중앙값과 평균 사이의 거리에 대한 더 뚜렷한 경계를 달성할 수 있습니다:

- .[18]

유사한 관계가 중앙값과 최빈값 사이에 유지됩니다:

Jensen's inequality for medians

옌센의 부등식은 유한 기댓값 E[X]를 갖는 임의의 확률 변수 X와 임의의 볼록 함수 f에 대해 다음임을 말합니다:

이 부등식은 마찬가지로 중앙값을 일반화합니다. 우리는 함수 f:ℝ→ℝ가 만약, 임의의 t에 대해, 다음이 (단일 점(single point) 또는 빈 집합(empty set)의 퇴화 사례를 허용하는) 닫힌 구간(closed interval)이면 C 함수라고 말합니다:

모든 각 볼록 함수는 C 함수이지만, 그 전환은 유지되지 않습니다. 만약 f가 C 함수이면, 다음입니다:

만약 중앙값이 고유하지 않으면, 그 명제는 대응하는 상한에 대해 유지됩니다.[19]

Medians for samples

The sample median

Efficient computation of the sample median

비록 n 항목을 비교-정렬화(comparison-sorting)가 Ω(n log n)을 요구하지만, 선택 알고리듬(selection algorithm)은 오직 Θ(n) 연산을 갖는 n 항목 중 k번째-가장 작은 것을 계산할 수 있습니다. 이것은 n/2 순서 통계량 (또는 표본의 짝수에 대해, 두 중간 순서 통계량의 산술 평균(arithmetic mean))인 중앙값을 포함합니다.[20]

선택 알고리듬은 여전히 Ω(n) 메모리를 요구하다는 단점을 가집니다. 즉, 그것들은 메모리에 전체 표본 (또는 그것의 선형-크기 부분)을 가져야 합니다. 이것과, 마찬가지로 선형 시간 요구 사항이 금지될 수 있기 때문에, 중앙값에 대해 여러 추정 절차가 개발되어 왔습니다. 간단한 규칙은 셋의-원소 부분표본의 중앙값으로 중앙값을 추정하는 셋의 규칙의 중앙값입니다; 이것은 공통적으로 그것의 입력의 중앙값의 추정치를 사용하는 퀵소트(quicksort) 정렬 알고리듬에서 서브루틴으로 사용됩니다. 보다 강건 추정기(robust estimator)는 투키(Tukey)의 ninther으로, 이것은 제한된 재귀로 적용된 셋의 규칙의 중앙값입니다:[21] 만약 A가 배열(array)로 배치된 표본이고, 다음이면:

- med3(A) = median(A[1], A[n/2], A[n]),

다음입니다:

- ninther(A) = med3(med3(A[1 ... 1/3n]), med3(A[1/3n ... 2/3n]), med3(A[2/3n ... n]))

다시-중앙값(remedian)은 선형 시간을 요구하지만 부분-선형 메모리를 요구하는 중앙값에 대해 추정기이며, 표본에 걸쳐 단일 경로에서 작동합니다.[22]

Sampling distribution

표본 평균과 표본 중앙값 둘 다의 분포는 라플라스(Laplace)에 의해 결정되었습니다.[23] 밀도 함수 를 갖는 모집단에서 표본 중앙값의 분포는 평균 과 다름이고 분산을 갖는 점근적으로 정규입니다:[24]

여기서 은 의 중앙값이고 은 표본 크기입니다. 현대적인 증명은 아래에 나옵니다. 라플라스의 결과는 이제 임의적인 분위-숫자의 점근적 분포의 특별한 경우로 이해됩니다.

정규 표본에 대해, 그 밀도는 이고, 따라서 큰 표본에 대해, 중앙값의 분산은 와 같습니다.[7] (역시 아래의 섹션 #Efficiency을 참조하십시오.)

Derivation of the asymptotic distribution

우리는 표본 크기를 홀수 이도록 취하고 변수를 연속이라고 가정합니다; 이산 변수의 경우에 대해 공식은 아래 § Empirical local density에 제공됩니다. 표본은 확률 , , 및 를 갖는 삼항 분포에 해당하는 "중간값 아래", "중간값에서", 및 "중간값 위에"로 요약될 수 있습니다. 연속 변수에 대해, 여러 표본 값이 중앙값과 정확히 같을 확률은 0이므로, 우리는 삼항 분포에서 직접 지점에서의 밀도를 계산할 수 있습니다:

- .

이제 우리는 베타 함수를 도입합니다. 정수 인수 와 에 대해, 이것은 로 표현될 수 있습니다. 역시, 임을 기억해 내십시오. 이들 관계를 사용하고 와 둘 다를 와 같게 설정하면 마지막 표현을 다음으로 쓰이게 허용합니다:

따라서 중앙값의 밀도 함수는 에 의해 앞으로 밀어진 대칭 베타 분포입니다. 그것의 평균은, 우리의 예상대로, 0.5이고 그것의 분산은 입니다. 체인 규칙(chain rule)에 의해, 표본 중앙값의 대응하는 분산은 다음입니다:

- .

추가적인 2는 극한(limit)에서 무시할 수 있습니다.

Empirical local density

실제로, 함수 와 는 종종 알려져 있지 않거나 가정되지 않습니다. 어쨌든, 그것들은 관측된 빈도 분포에서 추정될 수 있습니다. 이 섹션에서, 우리는 예제를 제공합니다. 3,800개 (이산-값) 관측의 표본을 나타내는 다음 테이블을 생각해 보십시오:

| v | 0 | 0.5 | 1 | 1.5 | 2 | 2.5 | 3 | 3.5 | 4 | 4.5 | 5 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| f(v) | 0.000 | 0.008 | 0.010 | 0.013 | 0.083 | 0.108 | 0.328 | 0.220 | 0.202 | 0.023 | 0.005 |

| F(v) | 0.000 | 0.008 | 0.018 | 0.031 | 0.114 | 0.222 | 0.550 | 0.770 | 0.972 | 0.995 | 1.000 |

관측은 이산-값이기 때문에, 중앙값의 정확한 분포를 구성하는 것은 에 대해 위의 표현의 즉각적인 평행이동이 아닙니다; 우리는 자체의 표본에서 중앙값의 여러 인스턴스를 가질 수 있습니다 (전형적으로 그렇습니다). 따라서 우리는 모든 이들 가능성에 걸쳐 합해야 합니다:

여기서, i는 중앙값보다 엄격하게 작은 점의 숫자이고 k는 엄격하게 큰 숫자입니다.

이들 예비 자료를 사용하여, 평균과 중앙값의 표준 오차에 대한 표본 크기의 영향을 조사하는 것이 가능합니다. 관측된 평균은 3.16, 관측된 원시 중앙값은 3이고 관측된 보간 중앙값은 3.174입니다. 다음 테이블은 몇 가지 비교 통계량을 제공합니다.

Sample size Statistic |

3 | 9 | 15 | 21 |

|---|---|---|---|---|

| 중앙값의 기댓값 | 3.198 | 3.191 | 3.174 | 3.161 |

| 중앙값의 표준 오차 (위의 공식) | 0.482 | 0.305 | 0.257 | 0.239 |

| 중앙값의 표준 오차 (점근적 근사) | 0.879 | 0.508 | 0.393 | 0.332 |

| 중앙값의 표준 오차 | 0.421 | 0.243 | 0.188 | 0.159 |

중앙값의 기댓값은 표본 크기가 증가함에 따라 약간 떨어지고, 반면에, 예상대로, 중앙값과 평균 둘 다의 표준 오차는 표본 크기의 역제곱근에 비례합니다. 점근적 근사는 표준 오차를 과대평가함으로써 주의 측면에서 오류가 발생합니다.

Estimation of variance from sample data

의 값–의 점근적 값, 여기서 는 모집단 중앙값–은 여러 저자에 의해 연구되어 왔습니다. 표준 "삭제 일" 잭나이프(jackknife) 방법은 불일치(inconsistent) 결과를 생성합니다.[25] 대안–"삭제 k" 방법, 여기서 는 표본 크기로 증가함–은 점근적으로 일치됨을 보여줍니다.[26] 이 방법은 큰 데이터 집합에 대해 계산적인 비용이 많이 들 수 있습니다. 부트스트랩 추정치는 일치되는 것으로 알려져 있지만,[27] 매우 느리게 수렴합니다 (의 차수(order)).[28] 다른 방법이 제안되어 왔지만 그것들의 행동은 큰 표본과 작은 표본 사이에 다를 수 있습니다.[29]

Efficiency

중앙값의 분산에 대한 평균의 분산의 비율로 측정되는 표본 중앙값의 효율성(efficiency)은 표본 크기와 놓여있는 모집단 분포에 따라 다릅니다. 정규 분포(normal distribution)에서 크기 의 표본에 대해, 큰 N에 대해 효율성은 다음입니다:

효율성은 이 무한대 경향일 때 로 경향입니다.

다시 말해서, 중앙값의 상대적 분산은 일 것이거나, 평균의 분산보다 57% 더 클 것입니다 – 중앙값의 상대적 표준 오차(standard error)는 일 것이거나, 평균의 표준 오차(standard error of the mean), 보다 25% 더 클 것입니다 (역시 위의 섹션 #Sampling distribution을 참조하십시오).[30]

Other estimators

하나의 중앙값에 대한 대칭인 일변수 분포에 대해, 호지스-레만 추정기(Hodges–Lehmann estimator)는 모집단 중앙값의 강건(robust)하고 효율적인 추정기(efficient estimator)입니다.[31]

만약 데이터가 확률 분포(probability distribution)의 특정 가족을 지정하는 통계적 모델(statistical model)에 의해 표현되면, 중앙값의 추정은 해당 확률 분포의 가족을 데이터에 맞추고 맞춰진 분포의 이론적 중앙값을 계산함으로써 얻어질 수 있습니다. 파레토 보간(Pareto interpolation)은 모집단이 파레토 분포(Pareto distribution)를 가진다고 가정될 때 이것의 응용입니다.

Multivariate median

이전에, 이 기사는 표본 또는 모집단이 일-차원일 때 일변수 중앙값을 논의했습니다. 차원이 2 이상이면, 일변수 중앙값의 정의를 확장하는 여러 개념이 있습니다; 각 그러한 다변수 중앙값은 차원이 정확하게 1일 때 일변수 중앙값과 일치합니다.[31][32][33][34]

Marginal median

주변 중앙값은 고정된 좌표의 집합에 관해 정의된 벡터에 대해 정의됩니다. 주변 중앙값은 그것의 성분이 일변수 중앙값인 벡터로 정의됩니다. 주변 중앙값은 계산하기 쉽고, 그것의 속성은 Puri와 Sen에 의해 연구되었습니다.[31][35]

Geometric median

유클리드 공간에서 표본 점 의 이산 집합의 기하 중앙값(geometric median)은 같은 점에 대한 거리의 합을 최소하하는 점입니다.[a]

주변 중앙값과 달리, 기하학적 중앙값은 평행이동(translations)과 회전(rotations)과 같은 유클리드 닮음 변환(similarity transformations)에 관해 등변(equivariant)입니다.

Median in all directions

만약 모든 좌표 시스템에 대해 주변 중앙값이 일치하면, 그것들의 공통 위치는 "모든 방향에서 중앙값"이라고 이름-지을 수 있습니다.[37] 이 개념은 중앙값 투표자 정리(median voter theorem)로 인해 투표 이론과 관련이 있습니다. 그것이 존재할 때, 모든 방향에서 중앙값은 기하학적 중앙값과 (적어도 이산 분포에 대해) 일치합니다.

Centerpoint

더 높은 차원에서 중앙값의 대안적인 일반화는 중심점(centerpoint)입니다.

Interpolated median

이산 변수를 다룰 때, 때때로 관찰된 값을 놓여있는 연속 구간의 중간점으로 고려하는 것이 유용합니다. 이에 대한 예제는 의견이나 선호도가 정해진 숫자의 가능한 응답을 갖는 스케일 위에 표현되는 Likert 스케일입니다. 만약 스케일이 양의 정수로 구성되면, 3의 관측은 2.50에서 3.50 사이의 구간을 나타내는 것으로 고려될 수 있습니다. 놓여있는 변수의 중앙값을 추정하는 것이 가능합니다. 만약, 말하자면, 관측의 22%가 값 2 또는 아래의 것이고 55.0%가 3 또는 아래의 것이면 (따라서 33%가 값 3을 가지면), 중앙값 은 3인데 왜냐하면 중앙값은 가 절반보다 큰 의 가장 작은 값이기 때문입니다. 그러나 보간된 중앙값은 2.50에서 3.50 사이 어딘가에 있습니다. 먼저 우리는 구간 너비 의 절반을 중앙값 구간의 위쪽 경계를 얻기 위해 중앙값에 더합니다. 그런-다음 우리는 50% 표시 위에 놓이는 33%의 비율과 같은 구간 너비의 비율을 뺍니다. 다시 말해서, 우리는 관측의 횟수에 비례하여 구간 너비를 나눕니다. 이 경우에서, 33%는 중앙값 아래 28%와 중앙값 위 5%로 분할되고 따라서 우리는 3.50의 위쪽 경계에서 구간 너비의 5/33을 빼서 보간된 중앙값 3.35를 얻습니다. 보다 공식적으로, 만약 값 가 알려져 있으면, 보간된 중앙값은 다음에서 계산될 수 있습니다:

대안적으로, 만약 관측된 표본에서 중앙값 카테고리 위에 점수가 있고, 그것 안에 점수가 있고 그것 아래에 점수가 있으면, 보간된 중앙값은 다음에 의해 제공됩니다:

Pseudo-median

하나의 중앙값에 대한 대칭인 일변수 분포에 대해, 호지스-레만 추정기(Hodges–Lehmann estimator)는 모집단 중앙값의 강건하고 매우 효율적인 추정기입니다; 비-대칭 분포에 대해, 호지스-레만 추정기는 대칭화된 분포의 중앙값이고 모집단 중앙값에 가까운 모집단 유사-중앙값의 강건하고 매우 효율적인 추정기입니다.[38] 호지스-레만 추정기는 다변수 분포로 일반화되어 왔습니다.[39]

Variants of regression

타일–씬 추정기(Theil–Sen estimator)는 기울기(slope)의 중앙값 찾기를 기반으로 하는 강건(robust) 선형 회귀(linear regression)에 대한 방법입니다.[40]

Median filter

중앙값 필터(median filter)는 회색스케일(grayscale) 이미지에서 임의의 소금과 후추 노이즈(salt and pepper noise)를 효과적으로 제거할 수 있는 이미지 처리(image processing)의 중요한 도구입니다.

Cluster analysis

클러스터 분석(cluster analysis)에서, k-중앙값 클러스터링(k-medians clustering) 알고리듬은 클러스터를 정의하는 방법을 제공하며, 이것에서 k-중앙값 클러스터링에서 사용되는 클러스터-평균 사이의 거리를 최대화하는 기준은 클러스터-중앙값 사이의 거리를 최대화함으로써 대체됩니다.

Median–median line

이것은 강건 회귀의 방법입니다. 그 아이디어는 독립 매개변수 의 값에 따라 이변수 데이터 집합을 둘의 절반: 중앙값보다 작은 값을 갖는 왼쪽 절반과 중앙값보다 큰 값을 갖는 오른쪽 절반으로 나눌 것을 제안한 1940년 발드(Wald)로 거슬러 올라갑니다.[41] 그는 왼쪽과 오른쪽 절반의 종속 와 독립 변수의 수단을 취하고 이들 두 점을 연결하는 직선의 기울기를 추정할 것을 제안했습니다. 그 직선은 그런-다음 데이터 집합에 있는 대부분의 점에 맞도록 조정될 수 있습니다.

1942년 Nair와 Shrivastava는 유사한 아이디어를 제안했지만 대신 부분표본의 평균을 계산하기 전에 표본을 셋의 같은 부분으로 나눌 것을 주장했습니다.[42] 1951년 Brown과 Mood는 평균보다는 둘의 부분표본의 중앙값을 사용하는 아이디어를 제안했습니다.[43] Tukey는 이들 아이디어를 결합하고 표본을 셋의 같은 크기의 부분표본으로 나누고 부분표본의 중앙값을 기반으로 직선을 추정할 것을 권장했습니다.[44]

Median-unbiased estimators

임의의 평균-불편향 추정기는 가우스(Gauss)에 의해 관찰된 것처럼 제곱된-오차 손실 함수(loss function)에 관한 위험(risk) (예상된 손실)을 최소화합니다. 중앙값-불편향 추정기는 라플라스(Laplace)에 의해 관찰된 것처럼 절대-편차(absolute-deviation) 손실 함수에 관한 위험을 최소화합니다. 다른 손실 함수(loss functions)는 통계적 이론(statistical theory), 특히 강건 통계(robust statistics)에서 사용됩니다.

중앙값-불편향 추정기의 이론은 1947년 George W. Brown에 의해 부흥되었습니다:[45]

일-차원 매개변수 θ의 추정은 만약, 고정된 θ에 대해, 추정의 분포의 중앙값이 값 θ에 있으면; 즉, 추정이 과대평가하는 만큼 자주 과소평가하면 중앙값-불편향인 것으로 말할 것입니다. 이 요구 사항은 대부분의 목적에 대해 평균-불편향 요구 사항만큼을 달성하는 것으로 보이고 일대일 변환 아래에서 불변이라는 추가적인 속성을 가집니다.

— page 584

중앙값-불편향 추정기의 추가적인 속성이 보고되어 왔습니다.[46][47][48][49] 중앙값-불편향 추정기는 일-대-일 변환 아래에서 불변입니다.

(평균-불편향 추정기에 대해 최소-분산 속성과 유사한 의미에서) 최적인 중앙값-불편향 추정기를 구성하는 방법이 있습니다. 그러한 구성은 단조 가능도-함수(monotone likelihood-functions)를 가지는 확률 분포에 대해 존재합니다.[50][51] 하나의 그러한 절차는 평균-불편향 추정기에 대해 Rao–Blackwell 절차의 아날로그입니다: 그 절차는 Rao–Blackwell 절차보다 더 작은 클래스의 확률 분포에 대해 유지되지만 더 큰 클래스의 손실 함수(loss function)에 대해 유지됩니다.[52]

History

고대 근동의 과학 연구자들은 요약 통계량을 사용하지 않고, 대신 다양한 현상을 통합하는 더 넓은 이론과 최대 일치를 제공했던 값을 선택한 것으로 보입니다.[53] 지중해 (및 나중에, 유럽) 학계 내에서, 평균과 같은 통계량은 근본적으로 중세와 근대 초기의 발전입니다. (유럽 이외의 중앙값의 역사와 그 전조는 상대적으로 연구되지 않은 상태로 남아 있습니다.)

중앙값이라는 아이디어는 다양한 평가(appraisals)를 공정하게 분석하기 위해 13세기 탈무드(Talmud)에 등장했습니다.[54][55] 어쨌든, 그 개념은 더 넓은 과학계로 퍼지지 않았습니다.

대신, 현대 중앙값의 가장 가까운 조상은 알-비루니(Al-Biruni)에 의해 발명된 중간-범위(mid-range)입니다.[56]: 31 [57] 알-비루니의 연구가 후대 학자들에게 전달되었는지는 불분명합니다. 알-비루니가 그의 기술을 금속 시험(assay)에 적용했지만, 그가 그의 연구를 발표한 후에도, 대부분의 시험가는 부정 행위로 보이지 않도록 결과에서 여전히 가장 불리한 값을 채택했습니다.[56]: 35–8 어쨌든, 발견의 시대(Age of Discovery) 동안 바다에서 증가된 항해는 선박의 항해사가 적대적인 해안에 대한 불리한 날씨에서 위도를 결정하려고 점점 더 많이 시도해야 했으며, 요약 통계량에 대한 새로운 관심으로 이어졌음을 의미했습니다. 재발견되었든 독립적으로 발명되었든, 해리엇(Harriot)의 "Instructions for Raleigh's Voyage to Guiana, 1595"에서 항해사에게 중간-범위가 권장되었습니다.[56]: 45–8

중앙값의 아이디어는 나침반(compass) 탐색에 대한 섹션에서 에드워드 라이트(Edward Wright)의 1599년 책 Certaine Errors in Navigation에서 처음 등장했을 수 있습니다. 라이트는 측정된 값을 버리는 것을 꺼렸고, 중앙값–중간 범위(mid-range)보다 데이터집합의 더 많은 비율을 포함하는–이 정확할 가능성이 더 높다고 느꼈을 것입니다. 어쨌든, 라이트는 자신의 기술 사용에 대한 예를 제공하지 않았으며, 그가 현대 중앙값의 개념을 설명했는지 확인하기가 어렵게 만듭니다.[53][57][b] (확률의 맥락에서) 중앙값은 확실히 크리스티안 하위헌스(Christiaan Huygens)의 서신에서 확실하게 나타났지만, 통계적 업무(actuarial practice)에 부적합한 통계량의 한 예제로 나타났습니다.[53]

중앙값의 가장 초기 권장 사항은 로저 조셉 보스코비치가 L1 노름을 기반으로 하고 따라서 중앙값에 대해 암시적으로 회귀 방법을 개발했던 1757년으로 거슬러 올라갑니다.[53][58] 1774년에, 라플라스(Laplace)는 이 생각을 분명히 했습니다: 그는 중앙값을 이후 PDF의 값의 표준 추정기로 사용할 것을 제안했습니다. 특정 기준은 예상되는 오류의 크기 를 최소화하는 것이었습니다; 여기서 는 추정치이고 는 참 값입니다. 이것을 끝내기 위해, 라플라스는 1800년대 초반에 표본 평균과 표본 중앙값 둘 다의 분포를 결정했습니다.[23][59] 어쨌든, 10년 후, 가우스(Gauss)와 르장드르(Legendre)는 평균을 얻기 위해 를 최소화하는 최소 제곱(least squares) 방법을 개발했습니다. 회귀의 문맥에서, 가우스와 르장드르의 혁신은 훨씬 더 쉬운 계산을 제공합니다. 결과적으로, 라플라스의 제안은 일반적으로 150년 후 컴퓨팅 장치(computing devices)가 등장할 때까지 거부되었습니다 (그리고 여전히 상대적으로 드문 알고리듬입니다).[60]

1843년 안토니 어거스틴 쿠르노(Antoine Augustin Cournot)는 확률 분포를 둘의 같은 절반으로 나누는 값에 대해 중앙값 (valeur médiane)라는 용어를 처음으로 사용했습니다.[61] 구스타프 테오도어 페히너(Gustav Theodor Fechner)는 사회적 및 심리학적 현상에서 중앙값 (Centralwerth)을 사용했습니다.[62] 그것은 이전에 오직 천문학과 관련 분야에서 사용되었습니다. 구스타프 페히너(Gustav Fechner)는, 비록 그것이 이전에 라플라스에 의해 사용되었지만, 데이터의 형식적 분석에 중앙값을 대중화했었고,[62] 중앙값은 프랜시스 이시드로 에지워스(F. Y. Edgeworth)에 의한 교과서에 등장했습니다.[63] 프랜시스 골턴(Francis Galton)은 1881년에 영어 용어 median을 사용했으며,[64][65] 1869년에 middle-most value이라는 용어를, 1880년에 medium이라는 용어를 사용했습니다.[66][67]

통계학자들은 직관적인 명확성과 수동 계산의 용이성을 위해 19세기 내내 중앙값의 사용을 강력하게 권장했습니다. 어쨌든, 중윗값의 개념은 산술 평균(arithmetic mean)과 마찬가지로 더 높은 모멘트 이론에 적합하지 않았고, 컴퓨터로 계산하기가 훨씬 더 어렵습니다. 결과로써, 중앙값은 20세기 동안 산술 평균에 의해 일반 평균의 개념으로 꾸준히 대체되었습니다.[53][57]

See also

- Medoids which are a generalisation of the median in higher dimensions

- Central tendency

- Absolute deviation

- Bias of an estimator

- Concentration of measure for Lipschitz functions

- Median (geometry)

- Median graph

- Median search

- Median slope

- Median voter theory

- Weighted median

- Median of medians: Algorithm to calculate the approximate median in linear time

- Order statistic

Notes

References

- ^ a b Weisstein, Eric W. "Statistical Median". MathWorld.

- ^ Simon, Laura J.; "Descriptive statistics" Archived 2010-07-30 at the Wayback Machine, Statistical Education Resource Kit, Pennsylvania State Department of Statistics

- ^ David J. Sheskin (27 August 2003). Handbook of Parametric and Nonparametric Statistical Procedures: Third Edition. CRC Press. pp. 7–. ISBN 978-1-4200-3626-8. Retrieved 25 February 2013.

- ^ Derek Bissell (1994). Statistical Methods for Spc and Tqm. CRC Press. pp. 26–. ISBN 978-0-412-39440-9. Retrieved 25 February 2013.

- ^ {{cite web|url=http://www.amstat.org/publications/jse/v13n2/vonhippel.html%7Ctitle=Mean, Median, and Skew: Correcting a Textbook Rule|journal=Journal of Statistics Education, v13n2 |author=Paul T. von Hippel|year=2005}

- ^ Robson, Colin (1994). Experiment, Design and Statistics in Psychology. Penguin. pp. 42–45. ISBN 0-14-017648-9.

- ^ a b Williams, D. (2001). Weighing the Odds. Cambridge University Press. p. 165. ISBN 052100618X.

- ^ Maindonald, John; Braun, W. John (2010-05-06). Data Analysis and Graphics Using R: An Example-Based Approach. Cambridge University Press. p. 104. ISBN 978-1-139-48667-5.

- ^ "AP Statistics Review - Density Curves and the Normal Distributions". Archived from the original on 8 April 2015. Retrieved 16 March 2015.

- ^ Newman, Mark EJ. "Power laws, Pareto distributions and Zipf's law." Contemporary physics 46.5 (2005): 323–351.

- ^ Stroock, Daniel (2011). Probability Theory. Cambridge University Press. pp. 43. ISBN 978-0-521-13250-3.

- ^ André Nicolas (https://math.stackexchange.com/users/6312/andr%c3%a9-nicolas), The Median Minimizes the Sum of Absolute Deviations (The $ {L}_{1} $ Norm), URL (version: 2012-02-25): https://math.stackexchange.com/q/113336

- ^ Mallows, Colin (August 1991). "Another comment on O'Cinneide". The American Statistician. 45 (3): 257. doi:10.1080/00031305.1991.10475815.

- ^ Piché, Robert (2012). Random Vectors and Random Sequences. Lambert Academic Publishing. ISBN 978-3659211966.

- ^ Kemperman, Johannes H. B. (1987). Dodge, Yadolah (ed.). "The median of a finite measure on a Banach space: Statistical data analysis based on the L1-norm and related methods". Papers from the First International Conference Held at Neuchâtel, August 31–September 4, 1987. Amsterdam: North-Holland Publishing Co.: 217–230. MR 0949228.

- ^ Milasevic, Philip; Ducharme, Gilles R. (1987). "Uniqueness of the spatial median". Annals of Statistics. 15 (3): 1332–1333. doi:10.1214/aos/1176350511. MR 0902264.

- ^ K.Van Steen Notes on probability and statistics

- ^ Basu, S.; Dasgupta, A. (1997). "The Mean, Median, and Mode of Unimodal Distributions:A Characterization". Theory of Probability and Its Applications. 41 (2): 210–223. doi:10.1137/S0040585X97975447. S2CID 54593178.

- ^ Merkle, M. (2005). "Jensen's inequality for medians". Statistics & Probability Letters. 71 (3): 277–281. doi:10.1016/j.spl.2004.11.010.

- ^ Alfred V. Aho and John E. Hopcroft and Jeffrey D. Ullman (1974). The Design and Analysis of Computer Algorithms. Reading/MA: Addison-Wesley. ISBN 0-201-00029-6. Here: Section 3.6 "Order Statistics", p.97-99, in particular Algorithm 3.6 and Theorem 3.9.

- ^ Bentley, Jon L.; McIlroy, M. Douglas (1993). "Engineering a sort function". Software: Practice and Experience. 23 (11): 1249–1265. doi:10.1002/spe.4380231105. S2CID 8822797.

- ^ Rousseeuw, Peter J.; Bassett, Gilbert W. Jr. (1990). "The remedian: a robust averaging method for large data sets" (PDF). J. Amer. Statist. Assoc. 85 (409): 97–104. doi:10.1080/01621459.1990.10475311.

- ^ a b Stigler, Stephen (December 1973). "Studies in the History of Probability and Statistics. XXXII: Laplace, Fisher and the Discovery of the Concept of Sufficiency". Biometrika. 60 (3): 439–445. doi:10.1093/biomet/60.3.439. JSTOR 2334992. MR 0326872.

- ^ Rider, Paul R. (1960). "Variance of the median of small samples from several special populations". J. Amer. Statist. Assoc. 55 (289): 148–150. doi:10.1080/01621459.1960.10482056.

- ^ Efron, B. (1982). The Jackknife, the Bootstrap and other Resampling Plans. Philadelphia: SIAM. ISBN 0898711797.

- ^ Shao, J.; Wu, C. F. (1989). "A General Theory for Jackknife Variance Estimation". Ann. Stat. 17 (3): 1176–1197. doi:10.1214/aos/1176347263. JSTOR 2241717.

- ^ Efron, B. (1979). "Bootstrap Methods: Another Look at the Jackknife". Ann. Stat. 7 (1): 1–26. doi:10.1214/aos/1176344552. JSTOR 2958830.

- ^ Hall, P.; Martin, M. A. (1988). "Exact Convergence Rate of Bootstrap Quantile Variance Estimator". Probab Theory Related Fields. 80 (2): 261–268. doi:10.1007/BF00356105. S2CID 119701556.

- ^ Jiménez-Gamero, M. D.; Munoz-García, J.; Pino-Mejías, R. (2004). "Reduced bootstrap for the median". Statistica Sinica. 14 (4): 1179–1198.

- ^ Maindonald, John; John Braun, W. (2010-05-06). Data Analysis and Graphics Using R: An Example-Based Approach. ISBN 9781139486675.

- ^ a b c Hettmansperger, Thomas P.; McKean, Joseph W. (1998). Robust nonparametric statistical methods. Kendall's Library of Statistics. Vol. 5. London: Edward Arnold. ISBN 0-340-54937-8. MR 1604954.

- ^ Small, Christopher G. "A survey of multidimensional medians." International Statistical Review/Revue Internationale de Statistique (1990): 263–277. doi:10.2307/1403809 JSTOR 1403809

- ^ Niinimaa, A., and H. Oja. "Multivariate median." Encyclopedia of statistical sciences (1999).

- ^ Mosler, Karl. Multivariate Dispersion, Central Regions, and Depth: The Lift Zonoid Approach. Vol. 165. Springer Science & Business Media, 2012.

- ^ Puri, Madan L.; Sen, Pranab K.; Nonparametric Methods in Multivariate Analysis, John Wiley & Sons, New York, NY, 1971. (Reprinted by Krieger Publishing)

- ^ Vardi, Yehuda; Zhang, Cun-Hui (2000). "The multivariate L1-median and associated data depth". Proceedings of the National Academy of Sciences of the United States of America. 97 (4): 1423–1426 (electronic). Bibcode:2000PNAS...97.1423V. doi:10.1073/pnas.97.4.1423. MR 1740461. PMC 26449. PMID 10677477.

- ^ Davis, Otto A.; DeGroot, Morris H.; Hinich, Melvin J. (January 1972). "Social Preference Orderings and Majority Rule" (PDF). Econometrica. 40 (1): 147–157. doi:10.2307/1909727. JSTOR 1909727. The authors, working in a topic in which uniqueness is assumed, actually use the expression "unique median in all directions".

- ^ Pratt, William K.; Cooper, Ted J.; Kabir, Ihtisham (1985-07-11). Corbett, Francis J (ed.). "Pseudomedian Filter". Architectures and Algorithms for Digital Image Processing II. 0534: 34. Bibcode:1985SPIE..534...34P. doi:10.1117/12.946562. S2CID 173183609.

- ^ Oja, Hannu (2010). Multivariate nonparametric methods with R: An approach based on spatial signs and ranks. Lecture Notes in Statistics. Vol. 199. New York, NY: Springer. pp. xiv+232. doi:10.1007/978-1-4419-0468-3. ISBN 978-1-4419-0467-6. MR 2598854.

- ^ Wilcox, Rand R. (2001), "Theil–Sen estimator", Fundamentals of Modern Statistical Methods: Substantially Improving Power and Accuracy, Springer-Verlag, pp. 207–210, ISBN 978-0-387-95157-7.

- ^ Wald, A. (1940). "The Fitting of Straight Lines if Both Variables are Subject to Error" (PDF). Annals of Mathematical Statistics. 11 (3): 282–300. doi:10.1214/aoms/1177731868. JSTOR 2235677.

- ^ Nair, K. R.; Shrivastava, M. P. (1942). "On a Simple Method of Curve Fitting". Sankhyā: The Indian Journal of Statistics. 6 (2): 121–132. JSTOR 25047749.

- ^ Brown, G. W.; Mood, A. M. (1951). "On Median Tests for Linear Hypotheses". Proc Second Berkeley Symposium on Mathematical Statistics and Probability. Berkeley, CA: University of California Press. pp. 159–166. Zbl 0045.08606.

- ^ Tukey, J. W. (1977). Exploratory Data Analysis. Reading, MA: Addison-Wesley. ISBN 0201076160.

- ^ Brown, George W. (1947). "On Small-Sample Estimation". Annals of Mathematical Statistics. 18 (4): 582–585. doi:10.1214/aoms/1177730349. JSTOR 2236236.

- ^ Lehmann, Erich L. (1951). "A General Concept of Unbiasedness". Annals of Mathematical Statistics. 22 (4): 587–592. doi:10.1214/aoms/1177729549. JSTOR 2236928.

- ^ Birnbaum, Allan (1961). "A Unified Theory of Estimation, I". Annals of Mathematical Statistics. 32 (1): 112–135. doi:10.1214/aoms/1177705145. JSTOR 2237612.

- ^ van der Vaart, H. Robert (1961). "Some Extensions of the Idea of Bias". Annals of Mathematical Statistics. 32 (2): 436–447. doi:10.1214/aoms/1177705051. JSTOR 2237754. MR 0125674.

- ^ Pfanzagl, Johann; with the assistance of R. Hamböker (1994). Parametric Statistical Theory. Walter de Gruyter. ISBN 3-11-013863-8. MR 1291393.

- ^ Pfanzagl, Johann. "On optimal median unbiased estimators in the presence of nuisance parameters." The Annals of Statistics (1979): 187–193.

- ^ Brown, L. D.; Cohen, Arthur; Strawderman, W. E. (1976). "A Complete Class Theorem for Strict Monotone Likelihood Ratio With Applications". Ann. Statist. 4 (4): 712–722. doi:10.1214/aos/1176343543.

- ^ Page; Brown, L. D.; Cohen, Arthur; Strawderman, W. E. (1976). "A Complete Class Theorem for Strict Monotone Likelihood Ratio With Applications". Ann. Statist. 4 (4): 712–722. doi:10.1214/aos/1176343543.

- ^ a b c d e Bakker, Arthur; Gravemeijer, Koeno P. E. (2006-06-01). "An Historical Phenomenology of Mean and Median". Educational Studies in Mathematics. 62 (2): 149–168. doi:10.1007/s10649-006-7099-8. ISSN 1573-0816. S2CID 143708116.

- ^ Adler, Dan (31 December 2014). "Talmud and Modern Economics". Jewish American and Israeli Issues. Archived from the original on 6 December 2015. Retrieved 22 February 2020.

- ^ Modern Economic Theory in the Talmud by Yisrael Aumann

- ^ a b c d Eisenhart, Churchill (24 August 1971). The Development of the Concept of the Best Mean of a Set of Measurements from Antiquity to the Present Day (PDF) (Speech). 131st Annual Meeting of the American Statistical Association. Colorado State University.

- ^ a b c "How the Average Triumphed Over the Median". Priceonomics. Retrieved 2020-02-23.

- ^ Stigler, S. M. (1986). The History of Statistics: The Measurement of Uncertainty Before 1900. Harvard University Press. ISBN 0674403401.

- ^ Laplace PS de (1818) Deuxième supplément à la Théorie Analytique des Probabilités, Paris, Courcier

- ^ Jaynes, E.T. (2007). Probability theory : the logic of science (5. print. ed.). Cambridge [u.a.]: Cambridge Univ. Press. p. 172. ISBN 978-0-521-59271-0.

- ^ Howarth, Richard (2017). Dictionary of Mathematical Geosciences: With Historical Notes. Springer. p. 374.

- ^ a b Keynes, J.M. (1921) A Treatise on Probability. Pt II Ch XVII §5 (p 201) (2006 reprint, Cosimo Classics, ISBN 9781596055308 : multiple other reprints)

- ^ Stigler, Stephen M. (2002). Statistics on the Table: The History of Statistical Concepts and Methods. Harvard University Press. pp. 105–7. ISBN 978-0-674-00979-0.

- ^ Galton F (1881) "Report of the Anthropometric Committee" pp 245–260. Report of the 51st Meeting of the British Association for the Advancement of Science

- ^ David, H. A. (1995). "First (?) Occurrence of Common Terms in Mathematical Statistics". The American Statistician. 49 (2): 121–133. doi:10.2307/2684625. ISSN 0003-1305. JSTOR 2684625.

- ^ encyclopediaofmath.org

- ^ personal.psu.edu

External links

- "Median (in statistics)", Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- Median as a weighted arithmetic mean of all Sample Observations

- On-line calculator

- Calculating the median

- A problem involving the mean, the median, and the mode.

- Weisstein, Eric W. "Statistical Median". MathWorld.

- Python script for Median computations and income inequality metrics

- Fast Computation of the Median by Successive Binning

- 'Mean, median, mode and skewness', A tutorial devised for first-year psychology students at Oxford University, based on a worked example.

- The Complex SAT Math Problem Even the College Board Got Wrong: Andrew Daniels in Popular Mechanics

This article incorporates material from Median of a distribution on PlanetMath, which is licensed under the Creative Commons Attribution/Share-Alike License.

![{\displaystyle \int _{(-\infty ,m]}dF(x)\geq {\frac {1}{2}}{\text{ and }}\int _{[m,\infty )}dF(x)\geq {\frac {1}{2}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/c490b959f69a76debf7ab4ece5e891a3a9bd2e47)

![{\displaystyle f[E(x)]\leq E[f(x)]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/1874d0eeb97b95fcab3c70f25df212e2cb4af2d2)

![{\displaystyle f^{-1}\left(\,(-\infty ,t]\,\right)=\{x\in \mathbb {R} \mid f(x)\leq t\}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/0bb6a4a02d8480c441a0f73bea93cc4fffb9b08d)

![{\displaystyle f(\operatorname {Median} [X])\leq \operatorname {Median} [f(X)]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/71d1c1e4434b41fe5617b85c49b2e9d308c8a1a3)

![{\displaystyle \Pr[\operatorname {Median} =v]\,dv={\frac {(2n+1)!}{n!n!}}F(v)^{n}(1-F(v))^{n}f(v)\,dv}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/b99f214189b2882487bfbae7997046efa4a88cc4)

![{\displaystyle m_{\text{int}}=m+w\left[{\frac {1}{2}}-{\frac {F(m)-{\frac {1}{2}}}{f(m)}}\right].}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/5e823608d9eba650d4796825d3043ef41d06370e)

![{\displaystyle m_{\text{int}}=m-{\frac {w}{2}}\left[{\frac {k-i}{j}}\right].}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/2880593c3a1fd9d8346af9aa8c2be6d83da114b3)