Eigenvalues and eigenvectors

선형 대수(linear algebra)에서, 선형 변환(linear transformation)의 고유벡터(eigenvector, /ˈaɪɡənˌvɛktər/) 또는 특성 벡터(characteristic vector)는 해당 선형 변환이 그것에 적용될 때 많아야 스칼라(scalar) 인수만큼 변경되는 비-영 벡터(vector)입니다. 종종 로 표시되는 대응하는 고윳값(eigenvalue)은 고유벡터가 스케일링되는 인수입니다.

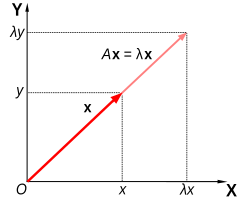

기하학적으로, 실수 비-영 고윳값에 해당하는 고유벡터는 그것이 변환에 의해 늘어나는 방향을 가리키고 고윳값은 그것이 확장되는 인수입니다. 만약 고윳값이 음수이면, 방향이 반대로 됩니다.[1] 느슨하게 말하면, 다차원 벡터 공간(vector space)에서, 고유벡터는 회전하지 않습니다.

Formal definition

만약 T가 필드(field) F에 걸쳐 벡터 공간 V에서 자체로의 선형 변환이고 v가 V에서 비-영(nonzero) 벡터이면, v는 만약 T(v)가 v의 스칼라 배수이면 T의 고유벡터입니다. 이것은 다음과 같이 쓸 수 있습니다:

여기서 λ는 v와 결합된 고윳값(eigenvalue), 특성 값(characteristic value), 또는 특성 근(characteristic root)으로 알려진 F에서 스칼라입니다.

nxn 정사각 행렬과 벡터 공간의 임의의 기저(basis)로 주어진 n-차원 벡터 공간에서 자체로의 선형 변환 사이에는 직접적인 대응 관계가 있습니다. 따라서, 유한-차원 벡터 공간에서, 행렬의 언어나 선형 변환 언어를 사용하여 고윳값과 고유벡터를 정의하는 것은 동등합니다.[2][3]

만약 V가 유한-차원이면, 위의 방정식은 다음과 동등합니다:[4]

여기서 A는 T의 행렬 표현이고 u는 v의 좌표 벡터(coordinate vector)입니다.

Overview

고윳값과 고유벡터는 선형 변환의 분석에서 두드러지게 나타납니다. 접두사 eigen-은 '적절한', '특성', '자신의'에 대한 독일어 단어 eigen (영어 단어 own과 동족)에서 채택되었습니다.[5][6] 원래 강체의 회전 운동의 주요 축(principal axes)을 연구하는 데 사용되는, 고윳값과 고유벡터는 예를 들어, 안정성 분석, 진동 분석, 원자 궤도, 안면 인식, 및 행렬 대각화에서 광범위한 응용 분야를 가집니다.

본질에서, 선형 변환 T의 고유 벡터 v는, T가 그것에 적용될 때, 방향을 변경하지 않는 비-영 벡터입니다. T를 고유벡터에 적용하는 것은 고윳값이라고 불리는 스칼라 값 λ만큼만 고유벡터를 스케일링합니다. 이 조건은 방정식으로 쓸 수 있습니다:

이는 고윳값 방정식(eigenvalue equation) 또는 고유방정식(eigenequation)으로 참조됩니다. 일반적으로, λ는 임의의 스칼라(scalar)일 수 있습니다. 예를 들어, λ는 음수일 수 있으며, 이 경우에서 고유벡터는 스케일링의 일부로 방향을 거꾸로 하거나, 그것은 영 또는 복소수(complex)일 수 있습니다.

여기에 표시된 모나 리자의 예제는 간단한 설명을 제공합니다. 그림 위에 각 점은 그림의 중심에서 해당 점을 가리키는 벡터로 나타낼 수 있습니다. 이 예제에서 선형 변환은 전단 매핑(shear mapping)이라고 불립니다. 위쪽 절반에서 그림의 중앙을 통과하는 수평 축에서 얼마나 떨어져 있는지에 비례하여 점은 오른쪽으로 이동하고, 아래쪽 절반에서 점은 마찬가지 방법으로 왼쪽으로 이동합니다. 따라서 원본 이미지에서 각 점을 가리키는 벡터는 오른쪽 또는 왼쪽으로 기울어지고, 그 변환에 의해 더 길거나 짧아집니다. 수평 축을 따라 있는 점은 이 변환이 적용될 때 전혀 움직이지 않습니다. 그러므로, 수직 성분 없이 오른쪽이나 왼쪽을 직접 가리키는 임의의 벡터는 매핑이 방향을 변경하지 않기 때문에 이 변환의 고유벡터입니다. 더욱이. 이들 고유벡터는 매핑이 길이를 변경하지 않기 때문에 모두 1과 같은 고윳값을 가집니다.

선형 변환은 다양한 벡터 공간에서 벡터를 매핑하는 많은 다른 형식을 취할 수 있으므로, 고유벡터도 많은 형식을 취할 수 있습니다. 예를 들어, 선형 변환은 와 같은 미분 연산자(differential operator)일 수 있으며, 이 경우에서 고유벡터는 다음과 같이 해당 미분 연산자에 의해 스케일링되는 고유함수(eigenfunctions)라고 불리는 함수입니다:

대안적으로, 선형 변환은 n x n 행렬의 형식을 취할 수 있으며, 이 경우에서 고유벡터는 n x 1 행렬입니다. 만약 선형 변환이 n x n 행렬 A의 형식에서 표현되면, 위의 선형 변환에 대해 고윳값 방정식은 다음 행렬 곱셈으로 다시 쓸 수 있습니다:

여기서 고유벡터 v는 n x 1 행렬입니다. 행렬에 대해, 고윳값과 고유벡터는 행렬을 분해하기 위해—예를 들어, 그것을 대각화함으로써 사용될 수 있습니다.

고윳값과 고유벡터는 밀접하게 관련된 많은 수학적 개념을 발생시키고, 그것들을 이름-지정할 때 접두사 고유-(eigen-)가 자유롭게 적용됩니다:

- 각각 대응하는 고윳값과 쌍을 이루는 선형 변환의 모든 고유벡터의 집합은 해당 변환의 고유시스템(eigensystem)이라고 불립니다.[7][8]

- 같은 고윳값에 해당하는 T의 모든 고유벡터의 집합은, 영 벡터와 함께, 해당 고윳값과 결합된 T의 고유공간(eigenspace), 또는 특성 공간(characteristic space)이라고 불립니다.[9]

- 만약 T의 고유벡터의 집합이 T의 도메인의 기저(basis)를 형성하면, 이 기저는 고유기저(eigenbasis)라고 불립니다.

History

고윳값은 종종 선형 대수 또는 행렬 이론의 맥락에서 소개됩니다. 역사적으로, 어쨌든, 그것들은 이차 형식(quadratic forms)과 미분 방정식(differential equations)의 연구에서 발생했습니다.

18세기에, 레온하르트 오일러(Leonhard Euler)는 강체의 회전 운동을 연구하고, 주요 축(principal axes)의 중요성을 발견했습니다.[a] 조제프-루이 라그랑주(Joseph-Louis Lagrange)는 주요 축이 관성 행렬의 고유벡터임을 깨달았습니다.[10]

19세기 초, 오귀스탱-루이 코시(Augustin-Louis Cauchy)는 그들의 연구가 이차초곡면 표면(quadric surfaces)을 분류하기 위해 어떻게 사용될 수 있는지 확인하고, 그것들 임의적인 차원으로 일반화했습니다.[11] 코시는 역시 현재 고윳값(eigenvalue)이라고 불리는 것에 대해 racine caractéristique (특성 근)이라는 용어를 만들었습니다; 그의 용어는 특성 방정식(characteristic equation)에서 살아남습니다.[b]

나중에, 조제프 푸리에(Joseph Fourier)는 라그랑주와 피에르-시몽 라플라스(Pierre-Simon Laplace)의 연구를 그의 유명한 1822년 저서 Théorie analytique de la chaleur에서 변수의 분리에 의해 열 방정식(heat equation)을 풀기 위해 사용했습니다.[12] 샤를 프랑수아 스튀름(Charles-François Sturm)은 푸리에의 아이디어를 더욱 발전시켰고, 코시의 관심을 끌었으며, 코시는 이를 자신의 아이디어와 결합하고 실수 대칭 행렬이 실수 고윳값을 가진다는 사실에 도달했습니다.[11] 이것은 1855년 샤를 에르미트(Charles Hermite)에 의해 현재 에르미트 행렬(Hermitian matrices)이라고 불리는 것으로 확장되었습니다.[13]

같은 시기에, 프란체스코 브리오스키(Francesco Brioschi)는 직교 행렬(orthogonal matrices)의 고윳값이 단위 원 위에 놓임을 입증했고,[11] 알프레트 클렙슈(Alfred Clebsch)는 비-대칭 행렬(skew-symmetric matrices)에 대한 대응하는 결과를 찾았습니다.[13] 마지막으로, 카를 바이어슈트라스(Karl Weierstrass)는 라플라스에 의해 시작된 안정성 이론(stability theory)에서 결함-있는 행렬(defective matrices)이 불안정성을 유발할 수 있음을 깨달음으로써 중요한 측면을 밝혔습니다.[11]

그동안, 조제프 리우빌(Joseph Liouville)은 스튀름의 그것과 유사한 고윳값 문제를 연구했습니다; 그들의 연구에서 성장한 분야는 이제 스튀름-리우빌 이론(Sturm–Liouville theory)이라고 불립니다.[14] 슈바르츠(Schwarz)는 19세기 말에 일반적인 도메인에 대한 라플라스 방정식(Laplace's equation)의 첫 번째 고윳값을 연구했고, 반면에 푸앵카레(Poincaré)는 몇 년 후 푸아송의 방정식(Poisson's equation)을 연구했습니다.[15]

20세기 초에, 다비트 힐베르트(David Hilbert)는 연산자를 무한 행렬로 봄으로써 적분 연산자(integral operators)의 고윳값을 연구했습니다.[16] 그는 1904년에 고윳값과 고유벡터를 나타내기 위해 "자신의(own)"를 의미하는[6] 독일어 단어 고유(eigen)를 처음으로 사용했지만,[c] 그는 키르히호프와 헤르만 폰 헬름홀츠(Hermann von Helmholtz)에 의한 관련된 용법을 따랐을 수도 있습니다. 한동안, 영어에서 표준 용어는 "적절한 값"이었지만, 오늘날에는 "고윳값"이라는 보다 독특한 용어가 표준입니다.[17]

고윳값과 고유벡터를 계산하기 위한 최초의 수치적 알고리듬은 리카르트 폰 미제스(Richard von Mises)가 거듭제곱 방법(power method)을 발표한 1929년에 나타났습니다. 오늘날 가장 널리 사용되는 방법 중 하나, QR 알고리듬(QR algorithm)은 1961년 John G. F. Francis[18] 및 Vera Kublanovskaya[19]에 의해 독립적으로 제안했습니다.[20][21]

Eigenvalues and eigenvectors of matrices

고윳값과 고유벡터는 종종 행렬에 중점을 둔 선형 대수 과정의 맥락에서 학생들에게 소개됩니다.[22][23] 게다가, 유한-차원 벡터 공간에 걸친 선형 변환은 행렬을 사용하여 나타낼 수 있으며,[2][3] 이는 수치 및 계산 응용에서 특히 일반적입니다.[24]

삼-차원 벡터와 같이 n개의 스칼라의 목록으로 구성된 n-차원 벡터를 생각해 보십시오:

이들 벡터는 다음임을 만족하는 스칼라 λ가 있으면 서로의 스칼라 배수, 또는 평행 또는 공선형(collinear)이라고 말합니다:

이 경우에서 .

이제 n x n 행렬 A에 의해 정의된 n-차원 벡터의 선형 변환을 생각해 보십시오:

또는

여기서, 각 행에 대해,

만약 v와 w가 스칼라 배수라고 발생하면, 즉 다음이면,

-

(1)

v는 선형 변환 A의 고유벡터(eigenvector)이고 스칼라 인수 λ는 해당 고유벡터에 대응하는 고윳값(eigenvalue)입니다. 방정식 (1)은 행렬 A에 대한 고윳값 방정식(eigenvalue equation)입니다.

방정식 (1)은 다음으로 동등하게 말할 수 있습니다:

-

(2)

여기서 I는 n × n 항등 행렬(identity matrix)이고 0는 영 벡터입니다.

Eigenvalues and the characteristic polynomial

방정식 (2)가 비-영 해 v를 가지는 것과 행렬 (A − λI)의 행렬식(determinant)이 영인 것은 필요충분 조건입니다. 그러므로, A의 고윳값은 다음 방정식을 만족시키는 λ의 값입니다:

-

(3)

행렬식에 대한 라이프니츠 공식을 사용하여, 방정식 (3)의 왼쪽 변은 변수 λ의 다항(polynomial) 함수이고 이 다항식의 차수(degree)는 행렬 A의 차수, n입니다. 그 계수(coefficients)는, 차수 n의 항이 항상 (−1)nλn인 것을 제외하고, A의 엔트리에 따라 달라집니다. 이 다항식은 A의 특성 다항식(characteristic polynomial)이라고 불립니다. 방정식 (3)은 A의 특성 방정식(characteristic equation 또는 secular equation)이라고 불립니다.

대수학의 기본 정리(fundamental theorem of algebra)는 차수가 n의 다항식인 n x n 행렬 A의 특성 다항식이 n 선형 항의 곱으로 인수화(factored)될 수 있음을 의미합니다:

-

(4)

여기서 각 λi는 실수일 수 있지만 일반적으로 복소수입니다. 모두 구별되는 값을 가지지 않을 수 있는 숫자 λ1, λ2, ..., λn은 다항식의 근이고 A의 고윳값입니다.

나중에 예제 섹션에서 자세히 설명하는 간단한 예제로, 다음 행렬을 생각해 보십시오:

(A − λI)의 행렬식을 취하여, A의 특성 다항식은 다음과 같습니다:

특성 다항식을 영과 같게 설정하여, 그것은 A의 두 고윳값인 λ=1과 λ=3에 근을 가집니다. 각 고윳값에 해당하는 고유벡터는 방정식 에서 v의 성분에 대해 풂으로써 찾을 수 있습니다. 이 예제에서, 고유벡터는 다음의 임의의 비-영 스칼라 배수입니다:

만약 행렬 A의 엔트리가 모두 실수이면, 특성 다항식의 계수도 실수이지만, 고윳값은 여전히 비-영 허수 부분을 가질 수 있습니다. 그러므로 해당 고유벡터의 엔트리는 비-영 허수 부분을 가질 수도 있습니다. 마찬가지로, 고윳값은 A의 모든 엔트리가 유리수이거나 모두 정수인 경우에도 무리수일 수 있습니다. 어쨌든, A의 엔트리가 모두 유리수를 포함하는 대수적 숫자(algebraic numbers)이면, 고윳값도 대수적 숫자여야 합니다 (즉, 그것들은 마법처럼 초월적 숫자가 될 수 없습니다).

실수 계수를 갖는 실수 다항식의 비-실수 근은 복소 켤레(complex conjugates)의 쌍으로 그룹화될 수 있으며, 즉, 각 쌍의 두 구성원은 부호만 다른 허수 부분과 같은 실수 부분을 가집니다. 만약 차수가 홀수이면, 사잇값 정리(intermediate value theorem)에 의해 근 중 적어도 하나는 실수입니다. 그러므로, 홀수 차수를 갖는 임의의 실수 행렬은 적어도 하나의 실수 고윳값을 가지고, 반면에 짝수 차수를 갖는 실수 행렬은 실수 고윳값을 가지지 않을 수 있습니다. 이들 복소 고윳값과 결합된 고유벡터도 복소수이고 복소 켤레 쌍으로도 나타납니다.

Algebraic multiplicity

λi를 n × n 행렬 A의 고윳값이라고 놓습니다. 고윳값의 대수적 중복도(algebraic multiplicity) μA(λi)는 특성 다항식의 근으로서의 중복도, 즉, (λ − λi)k가 해당 다항식을 균등하게 나눔을 만족하는 가장 큰 정수 k입니다.[9][25][26]

행렬 A가 차원 n을 가지고 d ≤ n 구별되는 고윳값을 가진다고 가정합니다. 방정식 (4)는 A의 특성 다항식을 잠재적으로 반복하는 일부 항을 갖는 n 선형 항의 곱으로 인수화하는 반면, 특성 다항식은 대신 구별되는 고윳값에 각각 대응하고 대수적 중복도의 거듭제곱으로 올려진 d 항의 곱으로 쓸 수 있습니다:

만약 d = n이면 오른쪽 변은 n 선형 항의 곱이고 이것은 방정식 (4)와 같습니다. 각 고윳값의 대수적 중복도의 크기는 다음과 같이 차원 n과 관련되어 있습니다:

만약 μA(λi) = 1이면, λi는 단순 고윳값(simple eigenvalue)이라고 말합니다.[26] 만약 μA(λi)가 다음 섹션에서 정의된 λi의 기하 중복도, γA(λi)와 같으면, λi는 반-단순 고윳값(semisimple eigenvalue)이라고 말합니다.

Eigenspaces, geometric multiplicity, and the eigenbasis for matrices

n x n 행렬 A의 특정 고윳값 λ가 주어지면, 집합(set) E를 식 (2)를 만족시키는 모든 벡터 v로 정의합니다:

다른 한편으로, 이 집합은 정확히 행렬 (A − λI)의 커널(kernel) 또는 널공간입니다. 다른 한편으로, 정의에 의해, 이 조건을 만족시키는 임의의 비-영 벡터는 λ와 결합된 A의 고유벡터입니다. 따라서, 집합 E는 영 벡터와 λ와 결합된 A의 모든 고유벡터의 집합의 합집합이고, E는 (A − λI)의 널공간과 같습니다. E는 λ와 결합된 A의 고유공간(eigenspace) 또는 특성 공간(characteristic space)이라고 불립니다.[27][9] 일반적으로, λ는 복소수이고 고유벡터는 복소수 n x 1 행렬입니다. 널공간의 속성은 그것이 선형 부분공간(linear subspace)이라는 것이므로, E는 의 선형 부분공간입니다.

고유공간 E는 선형 부분공간이기 때문에, 그것은 덧셈 아래에서 닫혀 있습니다. 즉, 만약 두 벡터 u와 v가 u, v ∈ E라고 쓰는 집합 E에 속하면, (u + v) ∈ E 또는 동등하게 A(u + v) = λ(u + v)입니다. 이것은 행렬 곱셈의 분배 속성(distributive property)을 사용하여 확인될 수 있습니다. 마찬가지로, E는 선형 부분공간이므로, 그것은 스칼라 곱셈 아래에서 닫혀 있습니다. 즉, 만약 v ∈ E이고 α가 복소수이면, (αv) ∈ E 또는 동등하게 A(αv) = λ(αv)입니다. 이것은 복소수에 의한 복소수 행렬의 곱셈이 교환적(commutative)이라는 점에 주목함으로써 확인될 수 있습니다. u + v와 αv가 영이 아닌 한, 그것들은 역시 λ와 결합된 A의 고유벡터입니다.

λ와 결합된 고유공간 E의 차원, 또는 λ와 결합된 선형 독립 고유벡터의 최대 개수는 고윳값의 기하 중복도(geometric multiplicity) γA(λ)으로 참조됩니다. E는 역시 (A − λI)의 널공간이기 때문에, λ의 기하 중복도는 다음과 같이 (A − λI)의 차원과 랭크와 관련되어 있는 (A − λI)의 널러티(nullity)라고도 불리는 (A − λI)의 널공간의 차원입니다:

고윳값과 고유벡터의 정의 때문에, 고윳값의 기하 중복도는 적어도 일이여야 하며, 즉, 각 고윳값은 적어도 하나의 결합된 고유벡터를 가집니다. 게다가, 고윳값의 기하 중복도는 그것의 대수적 중복도를 초과할 수 없습니다. 추가적으로, 고윳값의 대적수 중복도는 n을 초과할 수 없음을 기억하십시오.부등식 를 입증하기 위해, 기하 중복도의 정의가 임을 만족하는 직교-정규 고유벡터 의 존재를 어떻게 의미하는지 생각해 보십시오. 따라서 우리는 첫 번째 열이 이들 고유벡터이고, 남아있는 열이 의 이들 고유벡터에 직교하는 벡터의 임의의 직교정규 집합이 될 수 있는 (유니태리) 행렬 를 찾을 수 있습니다. 그런-다음 는 완전한 랭크를 가지고 따라서 역-가능이고, 를 갖는 는 꼭대기 왼쪽 블록이 대각 행렬 인 행렬입니다. 이것은 임을 의미합니다. 다시 맗해서, 는 와 유사하며, 이는 임을 의미합니다. 그러나 의 정의에서, 우리는 가 인수 를 포함한다는 것을 알고 있으며, 이는 의 대수적 중복도가 를 만족시켜야 함을 의미합니다.

가 개의 구별되는 고윳값 을 가진다고 가정하며, 여기서 의 기하 중복도는 입니다. 의 전체 기하 중복도는,의 고윳값의 모든 고유공간의 합의 차원, 또는 동등하게 의 선형적으로 독립 고유벡터의 최대 개수입니다. 만약 이면,

- 모든 의 고윳값의 고유공간의 직접 합은 전체 벡터 공간 입니다.

- 의 기저는 의 개의 선형적으로 독립 벡터로부터 형성될 수 있습니다; 그러한 기저는 고유기저(eigenbasis)라고 불립니다.

- 에서 임의의 벡터는 의 고유벡터의 선형 조합으로 쓸 수 있습니다.

Additional properties of eigenvalues

를 고윳값 를 갖는 복소수의 임의적인 행렬이라고 놓습니다. 각 고윳값은 이 목록에서 번 나타나며, 여기서 는 고윳값의 대수적 중복도입니다. 다음은 이 행렬과 그것의 고윳값의 속성입니다:

- 대각선 원소의 합으로 정의된 의 대각합(trace)은 역시 모든 고윳값의 합입니다,[28][29][30]

- 의 행렬식(determinant)은 모든 고윳값의 곱입니다,[28][31][32]

- 임의의 양의 정수 에 대해 의 번재 거듭제곱의 고윳값; 즉, 의 고윳값은 입니다.

- 행렬 가 역-가능(invertible)인 것과 모든 각 고윳값이 비-영인 것은 필요충분 조건입니다.

- 만약 가 역-가능이면, 의 고윳값은 이고 각 고윳값의 기하 중복도는 일치합니다. 게다가, 역의 특성 방정식은 원래 방정식의 상반 다항식(reciprocal polynomial)이기 때문에, 고윳값은 같은 대수적 중복도를 공유합니다.

- 만약 가 켤레 전치(conjugate transpose) 와 같으면, 또는 동등하게 가 에르미트(Hermitian)이면, 모든 각 고윳값은 실수입니다. 같은 것은 임의의 대칭(symmetric) 실수 행렬에 대해 참입니다.

- 만약 가 에르미트일뿐만 아니라 양수-한정(positive-definite), 양수-반한정(positive-semidefinite), 음수-한정(negative-definite), 또는 음수-반한정(negative-semidefinite)이면, 모든 각 고윳값은 각각 양수, 비-음수, 음수, 또는 비-양수입니다.

- 만약 가 유니태리(unitary)이면, 모든 각 고윳값은 절댓값 를 가집니다.

- 만약 가 행렬이고 가 그것의 고윳값이면, 행렬 의 고윳값은 입니다 (여기서 는 항등 행렬입니다). 게다가, 이면, 의 고윳값은 입니다. 보다 일반적으로, 다항식 에 대해 행렬 의 고윳값은 입니다.

Left and right eigenvectors

많은 분야에서 전통적으로 벡터를 단일 행을 갖는 행렬이 아닌 단일 열을 갖는 행렬로 나타냅니다. 이러한 이유로, 행렬의 맥락에서 "고유벡터"라는 단어는 거의 항상 오른쪽 고유벡터(right eigenvector), 즉 정의 방정식, 방정식 (1)에서 행렬 를 오른쪽으로 곱하는 열 벡터를 나타냅니다.

고윳값과 고유벡터 문제는 행렬 를 왼쪽에 곱하는 행 벡터에 대해서도 정의될 수 있습니다. 이 공식에서, 정의하는 방정식은 다음과 같습니다:

여기서 는 스칼라이고 는 행렬입니다. 이 방정식을 만족시키는 임의의 행 벡터 는 의 왼쪽 고유벡터(left eigenvector)라고 불리고 는 그것의 결합된 고윳값입니다. 이 방정식의 전치를 취하여,

이 방정식을 방정식 (1)과 비교하여, 의 왼쪽 고유벡터는 같은 고윳값을 갖는 의 오른쪽 고유벡터의 전치와 같다는 것을 바로 알 수 있습니다. 게다가, 의 특성 다항식은 의 특성 다항식과 같기 때문에, 의 왼쪽 고유벡터의 고윳값은 의 오른쪽 고유벡터의 고윳값과 같습니다.

Diagonalization and the eigendecomposition

A의 고유벡터가 기저를 형성하거나, 동등하게 A가 결합된 고윳값 λ1, λ2, ..., λn를 갖는 선형적으로 독립 고유벡터 v1, v2, ..., vn를 가진다고 가정합니다. 고윳값은 구별될 필요가 없습니다. 열이 A의 n개의 선형적으로 독립 고유벡터인 정사각 행렬(square matrix) Q를 정의합니다:

Q의 각 열은 A의 고유벡터이므로, A에 Q를 오른쪽에 곱하는 것은 Q의 각 열에 결합된 고윳값에 의해 스케일됩니다:

이를 염두에 두고, 각 대각 원소 Λii 가 Q의 i-번째 열과 결합된 고윳값인 대각 행렬 Λ를 정의합니다. 그런-다음

Q의 열은 선형적으로 독립이므로, Q는 역-가능입니다. 방정식의 양쪽 변에 Q−1을 오른쪽에 곱하면,

또는 대신 왼쪽 변에 Q−1을 곱함으로써,

따라서 A는 그것의 고유벡터로 구성된 행렬, 대각선을 따라 그것의 고윳값을 갖는 대각 행렬, 및 고유벡터 행렬의 역행렬로 분해될 수 있습니다. 이것은 고유분해(eigendecomposition)라고 불리고 닮음 변환(similarity transformation)입니다. 그러한 행렬 A는 대각 행렬 Λ와 닮았거나 대각화-가능(diagonalizable)이라고 말합니다. 행렬 Q는 닮음 변환의 기저 행렬의 변경입니다. 기본적으로, 행렬 A와 Λ는 두 개의 다른 기저로 표현된 같은 선형 변환을 나타냅니다. 고유벡터는 선형 변환을 Λ로 나타낼 때 기저로 사용됩니다.

반대로, 행렬 A가 대각화-가능이라고 가정합니다. P를 P−1AP가 일부 대각 행렬 D가 있음을 만족하는 비-특이 정사각 행렬이라고 놓습니다. 왼쪽에 둘 다 P를 곱하면, AP = PD입니다. 따라서 P의 각 열은 고윳값이 D의 대응하는 대각 원소인 A의 고유벡터여야 합니다. P의 열은 P에 대해 역-가능이 되도록 선형적으로 독립이어야 하므로, A의 n개의 선형적으로 독립 고유벡터가 존재합니다. 그런-다음 A의 고유벡터가 지저를 형성하는 것과 A가 대각화-가능인 것이 따라옵니다.

대각화-가능이 아닌 행렬은 결점-있는(defective) 것이라고 말합니다. 결점-있는 행렬에 대해, 고유벡터의 개념은 일반화된 고유벡터(generalized eigenvectors)로 일반화되고 고윳값의 대각 행렬은 조르당 정규 형식(Jordan normal form)으로 일반화됩니다. 대수적으로 닫힌 필드에 걸쳐, 임의의 행렬 A는 조르당 정규 형식(Jordan normal form)을 가지고 따라서 일반화된 고유벡터의 기저와 일반화된 고유공간(generalized eigenspaces)으로의 분해를 허용합니다.

Variational characterization

에르미트(Hermitian) 경우에서, 고윳값은 변동적 특성을 부여할 수 있습니다. 의 가장 큰 고윳값은 이차 형식(quadratic form) 의 최댓값입니다. 해당 최댓값을 실현하는 의 값은 고유벡터입니다.

Matrix examples

Two-dimensional matrix example

다음 행렬을 생각해 보십시오

오른쪽 그림은 평면에서 점 좌표에 대한 이 변환을 미치는 영향을 보여줍니다. 이 변환의 고유벡터 v는 방정식 (1)을 만족시키고, 행렬 (A − λI)의 행렬식이 영과 같다는 λ의 값이 고윳값입니다.

A의 특성 다항식을 찾기 위해 행렬식을 취하여,

특성 다항식을 영과 같게 설정하여, 그것은 A의 두 고윳값인 λ=1과 λ=3에 근을 가집니다.

λ=1에 대해, 방정식 (2)가 됩니다,

v1 = −v2를 갖는 임의의 비-영 벡터는 이 방정식을 풉니다. 그러므로, 위의 것은 이 벡터의 임의의 스칼라 배수와 마찬가지로 λ=1에 해당하는 A의 고유벡터입니다.

λ=3에 대해, 방정식 (2)는 다음이 됩니다:

v1 = v2를 갖는 임의의 비-영 벡터는 이 방정식을 풉니다. 그러므로,

위의 것은 이 벡터의 임의의 스칼라 배수와 마찬가지로 λ=3에 해당하는 A의 고유벡터입니다.

따라서 벡터 vλ=1와 vλ=3는 각각 고윳값 λ=1과 λ=3과 결합된 A의 고유벡터입니다.

Three-dimensional matrix example

다음 행렬을 생각해 보십시오:

A의 특성 방정식은 다음과 같습니다:

특성 다항식의 근은 2, 1, 및 11이며 A의 단지 세 개의 고윳값입니다. 이들 고윳값은 고유벡터 , , 및 , 또는 이들의 비-영 배수에 해당합니다.

Three-dimensional matrix example with complex eigenvalues

다음 순환 순열 행렬(cyclic permutation matrix)을 생각해 보십시오:

이 행렬은 벡터의 좌표를 한 위치 위로 이동하고 첫 번째 좌표를 맨 아래로 이동합니다. 그것의 특성 다항식은 1 − λ3이며, 그것의 근은 다음과 같습니다:

여기서 는 을 갖는 허수 단위(imaginary unit)입니다.

실수 고윳값 λ1 = 1에 대해, 세 개의 같은 비-영 엔트리를 갖는 임의의 벡터는 고유벡터입니다. 예를 들어,

허수 고윳값의 복소수 켤레 쌍에 대해,

그런-다음

그리고

그러므로, A의 다른 두 개의 고유벡터는 복소수이고 각각 고윳값 λ2와 λ3를 갖는 와 입니다. 두 개의 복소수 고유벡터는 역시 복소수 켤레 쌍으로 나타납니다:

Diagonal matrix example

오직 주요 대각선을 따라 엔트리를 갖는 행렬은 대각 행렬(diagonal matrices)이라고 불립니다. 대각 행렬의 고윳값은 대각 원소 자체입니다. 다음 행렬을 생각해 보십시오:

A의 특성 방정식은 다음과 같습니다:

이는 근 λ1 = 1, λ2 = 2, 및 λ3 = 3를 가집니다. 이들 근은 A의 대각 원소이자 고윳값입니다.

각 대각 원소는 오직 비-영 구성 요소가 해당 대각 원소와 같은 행에 있는 고유벡터에 해당합니다. 이 예제에서, 고윳값은 각각 이들 벡터의 스칼라 배수뿐만 아니라 다음 고유벡터에 해당합니다:

Triangular matrix example

주요 대각선 위의 원소가 모두 영인 행렬은 아래쪽 삼각 행렬(lower triangular matrix)이라고 불리고 주요 대각선 아래의 원소가 모두 영인 행렬은 위쪽 삼각 행렬(upper triangular matrix)이라고 불립니다. 대각 행렬과 마찬가지로, 삼각 행렬의 고윳값은 주요 대각선의 원소입니다.

다음 아래쪽 삼각 행렬을 생각해 보십시오,

A의 특성 다항식은 다음과 같습니다:

이는 근 λ1 = 1, λ2 = 2, 및 λ3 = 3을 가집니다. 이들 근은 A의 대각 원소이자 고윳값입니다.

이들 고윳값은 각각 이들 벡터의 스칼라 배수뿐만 아니라 다음 고유벡터에 해당합니다:

Matrix with repeated eigenvalues example

이전 예제에서 처럼, 다음 아래쪽 삼각 행렬은

그것의 대각 원소의 곱인 특성 다항식을 가집니다:

이 다항식의 근이자 따라서 고윳값은 2와 3입니다. 각 고윳값의 대수적 중복도는 2입니다; 다시 말해서, 그것들은 둘 다 이중근입니다. 모든 구별되는 고윳값의 대수적 중복도의 합은 특성 다항식의 차수이자 A의 차원, μA = 4 = n입니다.

다른 한편으로, 고윳값 2의 기하 중복도는 오직 1인데, 왜냐하면 그것의 고유공간이 단지 하나의 벡터 에 의해 스팬되고 따라서 1차원이기 때문입니다. 마찬가지로, 고윳값 3의 기하 중복도는 1인데 왜냐하면 그것의 고유공간이 단 하나의 벡터 에 의해 스팬되기 때문입니다. 전체 기하 중복도 γA는 2이며, 이는 2개의 구별되는 고윳값을 갖는 행렬에 대해 가장 작은 값입니다. 기하 중복도는 이후 섹션에서 정의됩니다.

Eigenvector-eigenvalue identity

에르미트 행렬(Hermitian matrix)에 대해, 정규화된 고유벡터의 j-번째 성분의 노름 제곱은 행렬 고윳값과 대응하는 작은 행렬(minor matrix)의 고윳값만을 사용하여 계산될 수 있습니다: 여기서 는 원래 행렬로부터 j-번째 행과 열을 제거함으로써 형성된 부분행렬(submatrix)입니다.[33][34][35] 이 항등식은 역시 대각화-가능 행렬(diagonalizable matrices)로 확장되고, 문헌에서 여러 번 재발견되어 왔습니다.[34]

Eigenvalues and eigenfunctions of differential operators

선형 변환 T의 고윳값과 고유벡터 정의는 놓여있는 벡터 공간이 무한-차원의 힐베르트 공간(Hilbert space) 또는 바나흐 공간(Banach space)인 경우에도 유효합니다. 무한-차원 공간 위에 동작하는 널리 사용되는 선형 변환 클래스는 함수 공간(function spaces) 위에 미분 연산자(differential operators)입니다. D를 실수 인수 t의 무한하게 미분-가능 실수 함수의 공간 C∞ 위에 선형 미분 연산자라고 놓습니다. D에 대한 고윳값 방정식은 다음 미분 방정식(differential equation)입니다:

이 방정식을 만족시키는 함수는 D의 고유벡터이고 공통적으로 고유함수(eigenfunctions)라고 불립니다.

Derivative operator example

다음 고윳값 방정식을 갖는 도함수 연산자 를 생각해 보십시오:

이 미분 방정식은 양쪽 변에 dt/f(t)를 곱하고 적분함으로써 풀 수 있습니다. 그것의 해, 다음 지수 함수(exponential function)은

도함수 연산자의 고유함수입니다. 이 경우에서 고유함수 자체는 결합된 고윳값의 함수입니다. 특히, λ = 0에 대해 고유함수 f(t)는 상수입니다.

주요 고유함수(eigenfunction) 기사는 다른 예제를 제공합니다.

General definition

고윳값과 고유벡터의 개념은 자연스럽게 임의적인 벡터 공간 위에 임의적인 선형 변환(linear transformations)으로 확장됩니다. V를 스칼라(scalars)의 일부 필드(field) K에 걸쳐 임의의 벡터 공간이라고 놓고, T를 V를 V로 매핑하는 선형 변환이라고 놓습니다:

우리는 비-영 벡터 v ∈ V가 T의 고유벡터(eigenvector)인 것과 다음임을 만족하는 스칼라 λ ∈ K가 존재하는 것은 필요충분 조건이라고 말합니다:

-

(5)

이 방정식은 T에 대해 고윳값 방정식이라고 불리고, 스칼라 λ는 고유벡터 v에 해당하는 T의 고윳값(eigenvalue)입니다. T(v)는 변환 T를 벡터 v에 적용한 결과이고, 반면에 λv는 스칼라 λ와 v의 곱입니다.[36][37]

Eigenspaces, geometric multiplicity, and the eigenbasis

고윳값 λ가 주어졌을 때, 다음 집합을 생각해 보십시오:

이는 λ와 결합된 모든 고유벡터의 집합과 영 벡터의 합집합입니다. E는 λ와 결합된 T의 고유공간(eigenspace) 또는 특성 공간(characteristic space )이라고 불립니다.

선형 변환의 정의에 의해, x, y ∈ V와 α ∈ K에 대해, 다음과 같습니다:

그러므로, 만약 u와 v가 λ와 결합된 T의 고유벡터, 즉 u, v ∈ E이면, 다음과 같습니다:

따라서, u + v와 αv는 둘 다 영 또는 λ와 결합된 T의 고유벡터, 즉 u + v, αv ∈ E이고, E는 덧셈과 스칼라 곱셈 아래에서 닫혀 있습니다. 따라서, λ와 결합된 고유공간 E는 V의 선형 부분공간입니다.[38] 만약 해당 부분공간이 차원 1을 가지면, 그것은 때때로 고유선(eigenline)이라고 불립니다.[39]

고윳값 λ의 기하 중복도(geometric multiplicity) γT(λ)는 λ와 결합된 고유공간의 차원, 즉, 해당 고윳값과 결합된 선형적으로 독립 고유벡터의 최대 개수입니다.[9][26] 고윳값과 고유벡터의 정의에 의해, γT(λ) ≥ 1인데 왜냐하면 모든 각 고윳값은 적어도 하나의 고유벡터를 가지지 때문입니다.

T의 고유공간은 항상 직접 합(direct sum)을 형성합니다. 결과적으로, 서로 다른 고윳값의 고유벡터는 항상 선형적으로 독립입니다. 그러므로, 고유공간의 차원의 합은 T가 연산하는 벡터 공간의 차원 n을 초과할 수 없고, n개의 구별되는 고윳값보다 많을 수 없습니다.[d]

T의 고유벡터에 의해 스팬된 임의의 부분공간은 T의 불변 부분공간(invariant subspace)이고, 그러한 부분공간에 대한 T의 제한은 대각화-가능입니다. 게다가, 전체 벡터 공간 V가 T의 고유벡터에 의해 스팬될 수 있거나, 동등하게 T의 모든 고윳값과 결합된 고유공간의 직접 합이 전체 벡터 공간 V이면, 고유기저(eigenbasis)라고 불리는 V의 기저는 T의 선형적으로 독립 고유벡터로 형성될 수 있습니다. T가 고유기저를 허용할 때, T는 대각화-가능입니다.

Spectral theory

만약 λ가 T의 고윳값이면, 연산자 (T − λI)는 일-대-일이 아니고, 따라서 그것의 역 (T − λI)−1은 존재하지 않습니다. 그 전환은 유한-차원 벡터 공간에 대해 참이지만 무한-차원 벡터 공간에 대해 참이 아닙니다. 일반적으로, 연산자 (T − λI)는 λ가 고윳값이 아닌 경우에도 역을 가지지 않을 수 있습니다.

이러한 이유로, 함수형 해석(functional analysis)에서 고윳값은 연산자 (T − λI)가 경계진(bounded) 역을 가지지 않는 모든 스칼라 λ의 집합으로서 선형 연산자 T의 스펙트럼으로 일반화될 수 있습니다. 연산자의 스펙트럼은 항상 모든 그것의 고윳값을 포함하지만 그것들에 제한되지 않습니다.

Associative algebras and representation theory

벡터 공간 위에 동작하는 대수적 대상을 일반화하여, 벡터 공간 위에 동작하는 단일 연산자를 대수적 표현(algebra representation) – 모듈(module) 위에 동작하는 결합 대수로 대체할 수 있습니다. 그러한 동작에 대한 연구는 표현 이론(representation theory)의 분야입니다.

가중값의 표현-이론적 개념은 고윳값의 아날로그이고, 반면에 가중값 벡터(weight vectors)와 가중값 공간(weight spaces)은 각각 고유벡터와 고유공간의 아날로그입니다.

Dynamic equations

가장 간단한 미분 방정식(difference equations)은 다음 형식을 가집니다:

의 관점에서 에 대해 이 방정식의 해는 다음 특성 방정식에 의해 구할 수 있습니다:

이는 위의 차이 방정식과 k – 1 방정식 로 구성된 방정식의 집합을 행렬 형식으로 쌓음으로써 찾을 수 있으며, 쌓인 변수 벡터 에서 한번-지연된 값의 관점에서 일차의 k-차원 시스템을 제공하고, 이 시스템의 행렬의 특성 방정식을 취합니다. 이 방정식은 다음 해 방정식에서 사용하기 위한 k 특성 근 을 제공합니다:

유사한 절차가 다음 다음 형식의 미분 방정식(differential equation)을 푸는 데 사용됩니다:

Calculation

고윳값과 고유벡터의 계산은 기본 선형 대수 교과서에 제시될 때 이론이 종종 실제와 매우 거리가 먼 주제입니다.

Classical method

고전적인 방법은 먼저 고윳값을 찾고, 그런-다음 각 고윳값에 대한 고유벡터를 계산하는 것입니다. 그것은 여러 가지 면에서 부동-점과 같은 정확하지 않은 산술에 적합하지 않습니다.

Eigenvalues

행렬 의 고윳값은 특성 다항식의 근을 찾음으로써 결정될 수 있습니다. 이것은 행렬에 대해 쉽지만, 행렬의 크기에 따라 난이도가 급격히 증가합니다.

이론에서, 특성 다항식의 계수는 행렬 원소의 곱의 합이기 때문에 정확하게 계산될 수 있습니다; 그리고 필요한 정확도로 임의적인 차수의 다항식의 모든 근을 찾을 수 있는 알고리듬이 있습니다.[40] 어쨌든, 이 접근 방식은 계수가 피할 수 없는 반올림 오차(round-off errors)에 의해 오염되고, 다항식의 근이 (윌킨슨의 다항식에 의해 예시되는 것처럼) 계수의 매우 민감한 함수일 수 있기 때문에 실제로 실행 가능하지 않습니다.[40] 심지어 원소가 정수인 행렬의 경우에도 그 계산은 비-자명한 것이 되는데, 왜냐하면 합이 매우 길기 때문입니다; 상수 항은 행렬에 대해 다른 곱의 합인 행렬식(determinant)이기 때문입니다.[e]

다항식의 근에 대한 명시적 대수적 공식(algebraic formulas)은 차수 이 4 이하인 경우에만 존재합니다. 아벨–루피니 정리(Abel–Ruffini theorem)에 따르면 5차 이상의 다항식의 근에 대한 일반적, 명시적이고 정확한 대수적 공식은 없습니다. (차수 을 갖는 임의의 다항식은 차수 의 일부 동반 행렬(companion matrix)의 특성 다항식이기 때문에 일반성이 중요합니다.) 그러므로, 차수 5 이상의 행렬에 대해, 고윳값과 고유벡터는 명시적인 대수적 공식으로 얻을 수 없고, 따라서 근사적인 수치적 방법(numerical methods)으로 계산되어야 합니다. 3차 다항식의 근에 대한 정확한 공식조차도 수치적으로 비실용적입니다.

Eigenvectors

일단 고윳값의 (정확한) 값이 알려지면, 대응하는 고유벡터는 고윳값 방정식의 비-영 해를 참음으로써 찾을 수 있으며, 이는 알려진 계수를 갖는 선형 방정식의 시스템이 됩니다. 예를 들어, 6이 다음 행렬의 고윳값이라는 것을 알고 나면:

방정식 를 풂으로써 고유벡터를 찾을 수 있으며, 즉,

이 행렬 방정식은 다음 두 개의 선형 방정식(linear equations)과 동등합니다: 즉,

두 방정식 모두 단일 선형 방정식 로 축소됩니다. 그러므로, 임의의 비-영 실수 에 대해 형식의 임의의 벡터는 고윳값 을 갖는 의 고유벡터입니다.

위의 행렬 는 또 다른 고윳값 을 가집니다. 유사한 계산은 해당 고유벡터가 의 비-영 해, 즉, 임의의 비-영 실수 에 대한 형식의 임의의 벡터라는 것을 보여줍니다.

Simple iterative methods

먼저 고유벡터를 찾고 그런-다음 고유 벡터에서 각 고윳값을 결정하는 전환(converse) 접근 방식은 컴퓨터에서 훨씬 더 다루기 쉬운 것으로 밝혀졌습니다. 여기에서 가장 쉬운 알고리듬은 임의적인 시작 벡터를 선택하고 그런-다음 그것을 행렬과 반복적으로 곱하는 것입니다 (선택적으로 원소를 적당한 크기로 유지하기 위해 벡터를 정규화합니다); 이것은 벡터를 고유벡터를 향해 수렴하게 만듭니다. 변형은 대신 벡터에 을 곱하는 것입니다; 이로 인해 에 가장 가까운 고윳값의 고유벡터로 수렴하게 됩니다.

만약 가 의 고유벡터(의 좋은 근사)이면, 대응하는 고윳값은 다음과 같이 계산될 수 있습니다:

여기서 는 의 켤레 전치(conjugate transpose)를 나타냅니다.

Modern methods

임의적인 행렬의 고윳값과 고유벡터를 계산하는 효율적이고 정확한 방법은 QR 알고리듬(QR algorithm)이 1961년에 설계될 때까지 알려지지 않았습니다.[40] 하우스홀더 변환(Householder transformation)을 LU 분해와 결합하면 QR 알고리듬보다 수렴이 더 나은 알고리듬이 됩니다. 큰 에르미트 희소 행렬(sparse matrices)에 대해, 랭크쏘스 알고리듬(Lanczos algorithm)은 여러 다른 가능성 중에서 고윳값과 고유벡터를 계산하기 위한 효율적인 반복 방법(iterative method)의 한 예제입니다.[40]

행렬의 고윳값을 계산하는 대부분의 숫자 방법은 계산의 부산물로 해당 고유벡터의 집합을 결정하지만, 때때로 구현자가 더 이상 필요하지 않은 고유벡터 정보를 폐기하도록 선택합니다.

Applications

Eigenvalues of geometric transformations

다음 테이블은 2×2 행렬, 고윳값, 및 고유벡터를 따라 평면에서 몇 가지 변환 예제를 보여줍니다.

| Scaling | Unequal scaling | Rotation | Horizontal shear | Hyperbolic rotation | |

|---|---|---|---|---|---|

| Illustration |

|

|

|

|

|

| Matrix | |||||

| Characteristic polynomial |

|||||

| Eigenvalues, | |||||

| Algebraic mult., |

|||||

| Geometric mult., |

|||||

| Eigenvectors | All nonzero vectors |

회전에 대한 특성 방정식은 θ가 180°의 정수 배수가 아닐 때마다 음수인 판별식(discriminant) 를 갖는 이차 방정식(quadratic equation)입니다. 그러므로, 이들 특수한 경우를 제외하고, 두 고윳값은 복소수, 입니다; 그리고 모든 고유벡터는 비-실수 엔트리를 가집니다. 실제로, 그것들의 특수한 경우를 제외하고, 회전은 평면에서 모든 각 비-영 벡터의 방향을 변경합니다.

정사각형을 같은 넓이의 직사각형으로 변환하는 선형 변환 (조임 매핑)은 역수 고윳값을 가집니다.

Schrödinger equation

변환 가 미분 연산자의 관점에서 표현되는 고윳값 방정식의 예제는 양자 역학(quantum mechanics)에서 시간-독립적인 슈뢰딩거 방정식(Schrödinger equation)입니다:

여기서 , 해밀턴(Hamiltonian)은 이-차 미분 연산자(differential operator)이고 , 파동함수(wavefunction)는 에너지로 해석되는 고윳값 에 해당하는 고유함수 중 하나입니다.

어쨌든, 슈뢰딩거 방정식의 경계 상태(bound state) 해에만 관심이 있는 경우에서, 제곱 적분-가능(square integrable) 함수의 공간 내에서 를 찾습니다. 이 공간은 잘-정의된 스칼라 곱(scalar product)을 갖는 힐베르트 공간(Hilbert space)이므로, 와 가 각각 일-차원 배열 (즉, 벡터)와 행렬로 나타낼 수 있는 기저 집합(basis set)을 도입할 수 있습니다. 이를 통해 슈뢰딩거 방정식을 행렬 형식으로 나타낼 수 있습니다.

괄-호 표기법(bra–ket notation)은 이러한 맥락에서 자주 사용됩니다. 제곱 적분-가능 함수의 힐베르트 공간에서 시스템의 상태를 나타내는 벡터는 로 표현됩니다. 이 표기법에서, 슈뢰딩거 방정식은 다음과 같습니다:

여기서 는 의 고유상태(eigenstate)이고 는 고윳값을 나타냅니다. 는 관찰-가능 자기-인접 연산자(self-adjoint operator), 에르미트 행렬의 무한-차원 아날로그입니다. 행렬의 경우와 마찬가지로, 위의 방정식에서 는 변환 를 에 적용하여 얻은 벡터로 이해됩니다.

Wave transport

광파, 음파, 및 마이크로파는 정적 무질서 시스템(disordered system)을 횡단할 때 무작위로 여러 번 산란됩니다. 다중 산란이 파동을 반복적으로 무작위화하더라도, 궁극적으로 시스템을 통한 일관된 파동 전송은 필드 전송 행렬 로 설명될 수 있는 결정론적 과정입니다.[41][42] 전송 연산자 의 고유벡터는 파동이 무질서한 시스템의 고유채널: 파동이 시스템을 통해 이동할 수 있는 독립 경로로 결합할 수 있도록 하는 무질서-별 입력 파동-전면의 집합을 형성합니다. 의 고윳값, 는 각 고유채널과 결합된 강도 투과율에 해당합니다. 확산 시스템의 전송 연산자의 놀라운 속성 중 하나는 과 을 갖는 두-봉우리 고윳값 분포입니다.[42] 게다가, 완전 투과율을 넘어서는 열린 고유채널의 놀라운 속성 중 하나는 고유채널의 통계적으로 강건한 공간 프로파일입니다.[43]

Molecular orbitals

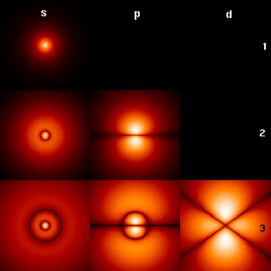

양자 역학(quantum mechanics), 특히 원자 물리학과 분자 물리학에서, 하트리-폭(Hartree–Fock) 이론 내에서, 원자 궤도와 분자 궤도는 폭 연산자(Fock operator)의 고유벡터에 의해 정의될 수 있습니다. 해당 고윳값은 코프만스의 정리(Koopmans' theorem)를 통해 이온화 퍼텐셜(ionization potentials)로 해석됩니다. 이 경우에서, 고유벡터라는 용어는 좀 더 일반적인 의미로 사용되는데, 왜냐하면 폭 연산자가 궤도와 그것들의 고윳값에 명시적으로 의존하기 때문입니다. 따라서, 이 측면을 강조하고 싶다면, 비선형 고윳값 문제에 대해 이야기해야 합니다. 그러한 방정식은 보통 이 경우에서 자체-일관적 필드(self-consistent field) 방법이라고 불리는 반복 절차에 의해 해결됩니다. 양자 화학(quantum chemistry)에서, 종종 비-직교 기저 집합에서 하트리-폭 방정식을 나타냅니다. 이 특정 표현은 호르탐 방정식(Roothaan equations)이라고 불리는 일반화된 고윳값 문제입니다.

Geology and glaciology

지질학(geology), 특히 빙하 퇴적물(glacial till)의 연구에서, 고유벡터와 고윳값은 클래스트(clast) 구조의 성분 방향과 딥(dip)에 대한 대량의 정보는 3-D 공간에서 6개의 숫자로 요약될 수 있는 방법으로 사용됩니다. 현장에서, 지질학자는 토양 표본에서 수백 또는 수천 개의 클래스트에 대해 그러한 데이터를 수집할 수 있으며, 이는 Tri-Plot (Sneed and Folk) 다이어그램이나,[44][45] Wulff Net 위에 스테레오넷(Stereonet)과 같이 그래픽으로만 비교될 수 있습니다.[46]

방향 텐서에 대한 출력은 세 개의 직교 (수직) 공간의 축에 있습니다. 세 개의 고유벡터는 그것들의 고윳값 에 의해 으로 순서화됩니다;[47] 그런-다음 은 강도 측면에서 클래스트의 주요 방향/딥, 는 2차 방향, 및 은 3차 방향입니다. 클래스트 방향은 360°의 나침반 장미(compass rose)에서 고유벡터의 방향으로 정의됩니다. 딥은 텐서의 모듈러스, 고윳값으로 측정됩니다: 이 값은 0° (dip 없음)에서 90° (수직)까지 평가됩니다. , , 및 의 상대 값은 퇴적물의 구조의 본성에 따라 결정됩니다. 만약 이면, 구조는 등방적이라고 말합니다. 만약 이면, 구조는 평면이라고 말합니다. 만약 이면, 구조는 선형이라고 말합니다.[48]

Principal component analysis

대칭 양의 반한정 (PSD) 행렬의 고유분해(eigendecomposition)는 각각의 고유벡터가 비-음의 고윳값을 가지는 고유벡터의 직교 기저(orthogonal basis)를 생성합니다. PSD 행렬의 직교 분해는 표본 공분산 행렬이 PSD인 다변수 해석(multivariate analysis)에 사용됩니다. 이러한 직교 분해는 통계학에서 주요 성분 분석(principal component analysis, PCA)이라고 불립니다. PCA는 변수 사이의 선형 관계(linear relations)를 연구합니다. PCA는 공분산 행렬(covariance matrix) 또는 상관 행렬(correlation matrix)에서 수행됩니다 (여기서 각 변수는 1과 같은 표본 분산을 가지도록 조정됩니다). 공분산 행렬 또는 상관 행렬에 대해, 고유벡터는 주요 성분(principal components)에 해당하고 고윳값은 주요 성분에 의해 설명되는 분산에 해당합니다. 상관 행렬의 주요 성분 분석은 관찰된 데이터의 공간에 대한 직교 기저(orthogonal basis)를 제공합니다: 이 기저에서, 가장 큰 고윳값은 많은 관찰된 데이터 중에서 대부분의 공변동성과 결합된 주요 성분에 해당합니다.

주요 성분 분석은 생물-정보학(bioinformatics)에서 발생하는 것과 같은 대규모 데이터 집합의 연구에서 차원 감소(dimensionality reduction)의 수단으로 사용됩니다. Q 방법론(Q methodology)에서, 상관 행렬의 고윳값은 Q-방법론자의 실질적인(practical) 유의성의 판단을 결정합니다 (이는 가설 테스트의 통계적 유의성과는 다릅니다; 비고, 인수의 개수를 결정하는 기준). 보다 일반적으로, 주요 성분 분석은 구조 방정식 모델링(structural equation modeling)에서 인수 분석(factor analysis)의 방법으로 사용될 수 있습니다.

Vibration analysis

고윳값 문제는 많은 자유도를 갖는 기계 구조물의 진동 해석에서 자연스럽게 발생합니다. 고윳값은 진동의 자연스러운 주파수(natural frequencies, 또는 고유진동수(eigenfrequencies))이고, 고유벡터는 이들 진동 모드의 모양입니다. 특히, 감쇠되지 않은 진동은 다음에 의해 지배됩니다:

또는

즉, 가속도는 위치에 비례합니다 (즉, 가 시간에 따라 정현파가 될 것으로 예상합니다).

차원에서, 은 질량 행렬(mass matrix)이 되고 는 강성 행렬(stiffness matrix)이 됩니다. 그런-다음 허용-가능한 해는 일반화된 고윳값 문제(generalized eigenvalue problem)에 대한 해의 선형 조합입니다:

여기서 는 고윳값이고 는 (허수) 각도 주파수(angular frequency)입니다. 주요 진동 모드는 만의 고유벡터인 주요 컴플라이언스 모드와 다릅니다. 게다가, 다음에 의해 지배되는 감쇠 진동(damped vibration)은,

다음과 같은 소위 이차 고윳값 문제(quadratic eigenvalue problem)로 이어집니다,

이것은 더 큰 시스템을 푸는 비용으로 대수적 조작(algebraic manipulation)에 의해 일반화된 고윳값 문제로 축소될 수 있습니다.

고유벡터의 직교성 속성은 시스템이 고유벡터의 선형 합으로 표현될 수 있도록 미분 방정식의 분리를 허용합니다. 복잡한 구조의 고윳값 문제는 종종 유한 원소 해석(finite element analysis)을 사용하여 해결되지만, 스칼라-값 진동 문제에 대한 해를 깔끔하게 일반화합니다.

Eigenfaces

이미지 처리(image processing)에서, 처리된 얼굴 이미지는 각 픽셀의 밝기를 구성 요소로 하는 벡터로 볼 수 있습니다.[49] 이 벡터 공간의 차원은 픽셀의 숫자입니다. 정규화된 대규모 얼굴 사진의 집합과 결합된 공분산 행렬(covariance matrix)의 고유벡터는 고유-얼굴(eigenfaces)이라고 불립니다; 이것은 주요 성분 분석(principal component analysis)의 예제입니다. 그것들은 임의의 얼굴 이미지를 그둘 중 일부의 선형 조합(linear combination)으로 표현하는 데 매우 유용합니다. 생체-인식(biometrics)의 얼굴 인식(facial recognition) 가지에서, 고유-얼굴은 식별 목적으로 얼굴에 데이터 압축을 적용하는 수단을 제공합니다. 손 제스처를 결정하는 고유 시작 시스템과 관련된 연구도 이루어져 왔습니다.

이 개념과 유사하게, 고유-음성(eigenvoices)은 언어에서 단어와 같은 특정 발화에 대한 인간 발음의 일반적인 변동성의 방향을 나타냅니다. 그러한 고유음성의 선형 조합을 기반으로, 단어의 새로운 음성 발음은 구성될 수 있습니다. 이들 개념은 화자 적응을 위한 자동 말투 인식 시스템에서 유용한 것으로 밝혀져 왔습니다.

Tensor of moment of inertia

역학(mechanics)에서, 관성 텐서의 모멘트(moment of inertia tensor)의 고유벡터는 강체의 주요 축(principal axes)을 정의합니다. 관성(inertia)의 모멘트의 텐서(tensor)는 질량의 중심(center of mass)을 중심으로 하는 강체의 회전을 결정하기 위해 필요한 핵심 수량입니다.

Stress tensor

고체 역학(solid mechanics)에서, 스트레스(stress) 텐서는 대칭적이고 따라서 대각선 위에 고윳값과 기저로 고유벡터를 갖는 대각선 텐서로 분해될 수 있습니다. 그것이 대각선이기 때문에, 이 방향에서, 스트레스 텐서는 전단(shear) 성분을 가지지 않습니다; 그것이 가지고 있는 성분은 주요 성분입니다.

Graphs

스펙트럼 그래프 이론(spectral graph theory)에서, 그래프(graph)의 고윳값은 그래프의 인접 행렬(adjacency matrix) 의 고윳값 또는 이산 라플라스 연산자(discrete Laplace operator)로 인한 그래프의 라플라스 행렬(Laplacian matrix)의 (증가적인) 고윳값으로 정의되며, 이는 (때때로 조합론적 라플라스라고 불림) 또는 (때때로 정규화된 라플라스라고 불림)이며, 여기서 는 꼭짓점 의 차수와 같은 를 갖는 대각 행렬이고, 에서, -번째 대각선 엔트리는 입니다. 그래프의 -번째 주요 고유벡터는 라플라스의 -번째 가장 큰 고윳값 또는 -번째 가장 작은 고윳값에 해당하는 고유벡터로 정의됩니다. 그래프의 첫 번째 주요 고유벡터는 단순히 주요 고유벡터라고도 참조됩니다.

주요 고유벡터는 꼭짓점의 중심성(centrality)을 측정하기 위해 사용됩니다. Google의 PageRank 알고리듬이 한 예제입니다. World Wide Web 그래프의 수정된 인접 행렬(adjacency matrix)의 주요 고유벡터는 페이지 순위를 그것의 성분으로 제공합니다. 이 벡터는 행-정규화 인접 행렬로 표시되는 마르코프 체인(Markov chain)의 정류 분포(stationary distribution)에 해당합니다; 어쨌든, 인접 행렬은 정류 분포가 존재함을 보장하기 위해 먼저 수정되어야 합니다. 두 번째로 가장 작은 고유벡터는 스펙트럼 클러스터링(spectral clustering)을 통해 그래프를 클러스터로 분할하기 위해 사용될 수 있습니다. 다른 방법도 클러스터링에 사용될 수 있습니다.

Basic reproduction number

기본 재생산 숫자 ()는 전염병이 어떻게 퍼지는가를 연구하는 데 토대적인 숫자입니다. 한 명의 감염자가 완전히 감염되기 쉬운 사람들의 모집단에 포함되면, 는 한 명의 전형적인 감염자가 감염시킬 평균 사람 숫자입니다. 감염의 세대 시간은 한 사람이 감염되는 시점부터 다음 사람이 감염되는 시점까지의 시간, 입니다. 이질적인 모집단에서, 다음 세대 행렬은 시간 가 지난 후 모집단에서 얼마나 많은 사람들이 감염될 것인지를 정의합니다. 그런-다음 은 다음 세대 행렬의 가장 큰 고윳값입니다.[50][51]

See also

- Antieigenvalue theory

- Eigenoperator

- Eigenplane

- Eigenmoments

- Eigenvalue algorithm

- Introduction to eigenstates

- Jordan normal form

- List of numerical-analysis software

- Nonlinear eigenproblem

- Normal eigenvalue

- Quadratic eigenvalue problem

- Singular value

- Spectrum of a matrix

Notes

- ^ Note:

- In 1751, Leonhard Euler proved that any body has a principal axis of rotation: Leonhard Euler (presented: October 1751; published: 1760) "Du mouvement d'un corps solide quelconque lorsqu'il tourne autour d'un axe mobile" (On the movement of any solid body while it rotates around a moving axis), Histoire de l'Académie royale des sciences et des belles lettres de Berlin, pp. 176–227. On p. 212, Euler proves that any body contains a principal axis of rotation: "Théorem. 44. De quelque figure que soit le corps, on y peut toujours assigner un tel axe, qui passe par son centre de gravité, autour duquel le corps peut tourner librement & d'un mouvement uniforme." (Theorem. 44. Whatever be the shape of the body, one can always assign to it such an axis, which passes through its center of gravity, around which it can rotate freely and with a uniform motion.)

- In 1755, Johann Andreas Segner proved that any body has three principal axes of rotation: Johann Andreas Segner, Specimen theoriae turbinum [Essay on the theory of tops (i.e., rotating bodies)] ( Halle ("Halae"), (Germany): Gebauer, 1755). (https://books.google.com/books?id=29 p. xxviiii [29]), Segner derives a third-degree equation in t, which proves that a body has three principal axes of rotation. He then states (on the same page): "Non autem repugnat tres esse eiusmodi positiones plani HM, quia in aequatione cubica radices tres esse possunt, et tres tangentis t valores." (However, it is not inconsistent [that there] be three such positions of the plane HM, because in cubic equations, [there] can be three roots, and three values of the tangent t.)

- The relevant passage of Segner's work was discussed briefly by Arthur Cayley. See: A. Cayley (1862) "Report on the progress of the solution of certain special problems of dynamics," Report of the Thirty-second meeting of the British Association for the Advancement of Science; held at Cambridge in October 1862, 32: 184–252; see especially pp. 225–226.

- ^ Kline 1972, pp. 807–808 Augustin Cauchy (1839) "Mémoire sur l'intégration des équations linéaires" (Memoir on the integration of linear equations), Comptes rendus, 8: 827–830, 845–865, 889–907, 931–937. From p. 827: "On sait d'ailleurs qu'en suivant la méthode de Lagrange, on obtient pour valeur générale de la variable prinicipale une fonction dans laquelle entrent avec la variable principale les racines d'une certaine équation que j'appellerai l'équation caractéristique, le degré de cette équation étant précisément l'order de l'équation différentielle qu'il s'agit d'intégrer." (One knows, moreover, that by following Lagrange's method, one obtains for the general value of the principal variable a function in which there appear, together with the principal variable, the roots of a certain equation that I will call the "characteristic equation", the degree of this equation being precisely the order of the differential equation that must be integrated.)

- ^ See:

- David Hilbert (1904) "Grundzüge einer allgemeinen Theorie der linearen Integralgleichungen. (Erste Mitteilung)" (Fundamentals of a general theory of linear integral equations. (First report)), Nachrichten von der Gesellschaft der Wissenschaften zu Göttingen, Mathematisch-Physikalische Klasse (News of the Philosophical Society at Göttingen, mathematical-physical section), pp. 49–91. From p. 51: "Insbesondere in dieser ersten Mitteilung gelange ich zu Formeln, die die Entwickelung einer willkürlichen Funktion nach gewissen ausgezeichneten Funktionen, die ich 'Eigenfunktionen' nenne, liefern: ..." (In particular, in this first report I arrive at formulas that provide the [series] development of an arbitrary function in terms of some distinctive functions, which I call eigenfunctions: ... ) Later on the same page: "Dieser Erfolg ist wesentlich durch den Umstand bedingt, daß ich nicht, wie es bisher geschah, in erster Linie auf den Beweis für die Existenz der Eigenwerte ausgehe, ... " (This success is mainly attributable to the fact that I do not, as it has happened until now, first of all aim at a proof of the existence of eigenvalues, ... )

- For the origin and evolution of the terms eigenvalue, characteristic value, etc., see: Earliest Known Uses of Some of the Words of Mathematics (E)

- ^ For a proof of this lemma, see Roman 2008, Theorem 8.2 on p. 186; Shilov 1977, p. 109; Hefferon 2001, p. 364; Beezer 2006, Theorem EDELI on p. 469; and Lemma for linear independence of eigenvectors

- ^ By doing Gaussian elimination over formal power series truncated to terms it is possible to get away with operations, but that does not take combinatorial explosion into account.

Citations

- ^ Burden & Faires 1993, p. 401.

- ^ a b Herstein 1964, pp. 228, 229.

- ^ a b Nering 1970, p. 38.

- ^ Weisstein n.d.

- ^ Betteridge 1965.

- ^ a b "Eigenvector and Eigenvalue". www.mathsisfun.com. Retrieved 2020-08-19.

- ^ Press et al. 2007, p. 536.

- ^ Wolfram.com: Eigenvector.

- ^ a b c d Nering 1970, p. 107.

- ^ Hawkins 1975, §2.

- ^ a b c d Hawkins 1975, §3.

- ^ Kline 1972, p. 673.

- ^ a b Kline 1972, pp. 807–808.

- ^ Kline 1972, pp. 715–716.

- ^ Kline 1972, pp. 706–707.

- ^ Kline 1972, p. 1063, p..

- ^ Aldrich 2006.

- ^ Francis 1961, pp. 265–271.

- ^ Kublanovskaya 1962.

- ^ Golub & Van Loan 1996, §7.3.

- ^ Meyer 2000, §7.3.

- ^ Cornell University Department of Mathematics (2016) Lower-Level Courses for Freshmen and Sophomores. Accessed on 2016-03-27.

- ^ University of Michigan Mathematics (2016) Math Course Catalogue Archived 2015-11-01 at the Wayback Machine. Accessed on 2016-03-27.

- ^ Press et al. 2007, p. 38.

- ^ Fraleigh 1976, p. 358.

- ^ a b c Golub & Van Loan 1996, p. 316.

- ^ Anton 1987, pp. 305, 307.

- ^ a b Beauregard & Fraleigh 1973, p. 307.

- ^ Herstein 1964, p. 272.

- ^ Nering 1970, pp. 115–116.

- ^ Herstein 1964, p. 290.

- ^ Nering 1970, p. 116.

- ^ Wolchover 2019.

- ^ a b Denton et al. 2022.

- ^ Van Mieghem 2014.

- ^ Korn & Korn 2000, Section 14.3.5a.

- ^ Friedberg, Insel & Spence 1989, p. 217.

- ^ Nering 1970, p. 107; Shilov 1977, p. 109 Lemma for the eigenspace

- ^ Lipschutz & Lipson 2002, p. 111.

- ^ a b c d Trefethen & Bau 1997.

- ^ Vellekoop & Mosk 2007, pp. 2309–2311.

- ^ a b Rotter & Gigan 2017, p. 15005.

- ^ Bender et al. 2020, p. 165901.

- ^ Graham & Midgley 2000, pp. 1473–1477.

- ^ Sneed & Folk 1958, pp. 114–150.

- ^ Knox-Robinson & Gardoll 1998, p. 243.

- ^ Busche, Christian; Schiller, Beate. "Endogene Geologie - Ruhr-Universität Bochum". www.ruhr-uni-bochum.de.

- ^ Benn & Evans 2004, pp. 103–107.

- ^ Xirouhakis, Votsis & Delopoulus 2004.

- ^ Diekmann, Heesterbeek & Metz 1990, pp. 365–382.

- ^ Heesterbeek & Diekmann 2000.

Sources

- Aldrich, John (2006), "Eigenvalue, eigenfunction, eigenvector, and related terms", in Miller, Jeff (ed.), Earliest Known Uses of Some of the Words of Mathematics

- Anton, Howard (1987), Elementary Linear Algebra (5th ed.), New York: Wiley, ISBN 0-471-84819-0

- Beauregard, Raymond A.; Fraleigh, John B. (1973), A First Course In Linear Algebra: with Optional Introduction to Groups, Rings, and Fields, Boston: Houghton Mifflin Co., ISBN 0-395-14017-X

- Beezer, Robert A. (2006), A first course in linear algebra, Free online book under GNU licence, University of Puget Sound

- Bender, Nicholas; Yamilov, Alexey; Yilmaz, Hasan; Cao, Hui (2020-10-14). "Fluctuations and Correlations of Transmission Eigenchannels in Diffusive Media". Physical Review Letters. 125 (16): 165901. arXiv:2004.12167. Bibcode:2020PhRvL.125p5901B. doi:10.1103/physrevlett.125.165901. ISSN 0031-9007. PMID 33124845. S2CID 216553547.

- Benn, D.; Evans, D. (2004), A Practical Guide to the study of Glacial Sediments, London: Arnold, pp. 103–107

- Betteridge, Harold T. (1965), The New Cassell's German Dictionary, New York: Funk & Wagnall, LCCN 58-7924

- Burden, Richard L.; Faires, J. Douglas (1993), Numerical Analysis (5th ed.), Boston: Prindle, Weber and Schmidt, ISBN 0-534-93219-3

- Denton, Peter B.; Parke, Stephen J.; Tao, Terence; Zhang, Xining (January 2022). "Eigenvectors from Eigenvalues: A Survey of a Basic Identity in Linear Algebra" (PDF). Bulletin of the American Mathematical Society. 59 (1): 31–58. arXiv:1908.03795. doi:10.1090/bull/1722. S2CID 213918682. Archived (PDF) from the original on 19 January 2022.

- Diekmann, O; Heesterbeek, JA; Metz, JA (1990), "On the definition and the computation of the basic reproduction ratio R0 in models for infectious diseases in heterogeneous populations", Journal of Mathematical Biology, 28 (4): 365–382, doi:10.1007/BF00178324, hdl:1874/8051, PMID 2117040, S2CID 22275430

- Fraleigh, John B. (1976), A First Course In Abstract Algebra (2nd ed.), Reading: Addison-Wesley, ISBN 0-201-01984-1

- Francis, J. G. F. (1961), "The QR Transformation, I (part 1)", The Computer Journal, 4 (3): 265–271, doi:10.1093/comjnl/4.3.265

- Francis, J. G. F. (1962), "The QR Transformation, II (part 2)", The Computer Journal, 4 (4): 332–345, doi:10.1093/comjnl/4.4.332

- Friedberg, Stephen H.; Insel, Arnold J.; Spence, Lawrence E. (1989), Linear algebra (2nd ed.), Englewood Cliffs, NJ: Prentice Hall, ISBN 0-13-537102-3

- Golub, Gene H.; Van Loan, Charles F. (1996), Matrix computations (3rd ed.), Baltimore, MD: Johns Hopkins University Press, ISBN 978-0-8018-5414-9

- Graham, D.; Midgley, N. (2000), "Graphical representation of particle shape using triangular diagrams: an Excel spreadsheet method", Earth Surface Processes and Landforms, 25 (13): 1473–1477, Bibcode:2000ESPL...25.1473G, doi:10.1002/1096-9837(200012)25:13<1473::AID-ESP158>3.0.CO;2-C, S2CID 128825838

- Hawkins, T. (1975), "Cauchy and the spectral theory of matrices", Historia Mathematica, 2: 1–29, doi:10.1016/0315-0860(75)90032-4

- Heesterbeek, J. A. P.; Diekmann, Odo (2000), Mathematical epidemiology of infectious diseases, Wiley series in mathematical and computational biology, West Sussex, England: John Wiley & Sons

- Hefferon, Jim (2001), Linear Algebra, Colchester, VT: Online book, St Michael's College

- Herstein, I. N. (1964), Topics In Algebra, Waltham: Blaisdell Publishing Company, ISBN 978-1114541016

- Kline, Morris (1972), Mathematical thought from ancient to modern times, Oxford University Press, ISBN 0-19-501496-0

- Knox-Robinson, C.; Gardoll, Stephen J. (1998), "GIS-stereoplot: an interactive stereonet plotting module for ArcView 3.0 geographic information system", Computers & Geosciences, 24 (3): 243, Bibcode:1998CG.....24..243K, doi:10.1016/S0098-3004(97)00122-2

- Korn, Granino A.; Korn, Theresa M. (2000), "Mathematical Handbook for Scientists and Engineers: Definitions, Theorems, and Formulas for Reference and Review", New York: McGraw-Hill (2nd Revised ed.), Bibcode:1968mhse.book.....K, ISBN 0-486-41147-8

- Kublanovskaya, Vera N. (1962), "On some algorithms for the solution of the complete eigenvalue problem", USSR Computational Mathematics and Mathematical Physics, 1 (3): 637–657, doi:10.1016/0041-5553(63)90168-X

- Lipschutz, Seymour; Lipson, Marc (12 August 2002). Schaum's Easy Outline of Linear Algebra. McGraw Hill Professional. p. 111. ISBN 978-007139880-0.

- Meyer, Carl D. (2000), Matrix analysis and applied linear algebra, Philadelphia: Society for Industrial and Applied Mathematics (SIAM), ISBN 978-0-89871-454-8

- Nering, Evar D. (1970), Linear Algebra and Matrix Theory (2nd ed.), New York: Wiley, LCCN 76091646

- Press, William H.; Teukolsky, Saul A.; Vetterling, William T.; Flannery, Brian P. (2007), Numerical Recipes: The Art of Scientific Computing (3rd ed.), ISBN 978-0521880688

- Roman, Steven (2008), Advanced linear algebra (3rd ed.), New York: Springer Science + Business Media, ISBN 978-0-387-72828-5

- Rotter, Stefan; Gigan, Sylvain (2017-03-02). "Light fields in complex media: Mesoscopic scattering meets wave control". Reviews of Modern Physics. 89 (1): 015005. arXiv:1702.05395. Bibcode:2017RvMP...89a5005R. doi:10.1103/RevModPhys.89.015005. S2CID 119330480.

- Shilov, Georgi E. (1977), Linear algebra, Translated and edited by Richard A. Silverman, New York: Dover Publications, ISBN 0-486-63518-X

- Sneed, E. D.; Folk, R. L. (1958), "Pebbles in the lower Colorado River, Texas, a study of particle morphogenesis", Journal of Geology, 66 (2): 114–150, Bibcode:1958JG.....66..114S, doi:10.1086/626490, S2CID 129658242

- Trefethen, Lloyd N.; Bau, David (1997), Numerical Linear Algebra, SIAM

- Van Mieghem, Piet (18 January 2014). "Graph eigenvectors, fundamental weights and centrality metrics for nodes in networks". arXiv:1401.4580 [math.SP].

- Vellekoop, I. M.; Mosk, A. P. (2007-08-15). "Focusing coherent light through opaque strongly scattering media". Optics Letters. 32 (16): 2309–2311. Bibcode:2007OptL...32.2309V. doi:10.1364/OL.32.002309. ISSN 1539-4794. PMID 17700768. S2CID 45359403.

- Weisstein, Eric W. "Eigenvector". mathworld.wolfram.com. Retrieved 4 August 2019.

- Weisstein, Eric W. (n.d.). "Eigenvalue". mathworld.wolfram.com. Retrieved 2020-08-19.

- Wolchover, Natalie (13 November 2019). "Neutrinos Lead to Unexpected Discovery in Basic Math". Quanta Magazine. Retrieved 27 November 2019.

- Xirouhakis, A.; Votsis, G.; Delopoulus, A. (2004), Estimation of 3D motion and structure of human faces (PDF), National Technical University of Athens

Further reading

- Golub, Gene F.; van der Vorst, Henk A. (2000), "Eigenvalue Computation in the 20th Century" (PDF), Journal of Computational and Applied Mathematics, 123 (1–2): 35–65, Bibcode:2000JCoAM.123...35G, doi:10.1016/S0377-0427(00)00413-1, hdl:1874/2663

- Hill, Roger (2009). "λ – Eigenvalues". Sixty Symbols. Brady Haran for the University of Nottingham.

- Kuttler, Kenneth (2017), An introduction to linear algebra (PDF), Brigham Young University

- Strang, Gilbert (1993), Introduction to linear algebra, Wellesley, MA: Wellesley-Cambridge Press, ISBN 0-9614088-5-5

- Strang, Gilbert (2006), Linear algebra and its applications, Belmont, CA: Thomson, Brooks/Cole, ISBN 0-03-010567-6

External links

- What are Eigen Values? – non-technical introduction from PhysLink.com's "Ask the Experts"

- Eigen Values and Eigen Vectors Numerical Examples – Tutorial and Interactive Program from Revoledu.

- Introduction to Eigen Vectors and Eigen Values – lecture from Khan Academy

- Eigenvectors and eigenvalues | Essence of linear algebra, chapter 10 – A visual explanation with 3Blue1Brown

- Matrix Eigenvectors Calculator from Symbolab (Click on the bottom right button of the 2x12 grid to select a matrix size. Select an size (for a square matrix), then fill out the entries numerically and click on the Go button. It can accept complex numbers as well.)

Theory

- Computation of Eigenvalues

- Numerical solution of eigenvalue problems Edited by Zhaojun Bai, James Demmel, Jack Dongarra, Axel Ruhe, and Henk van der Vorst

![{\displaystyle \left[{\begin{smallmatrix}2&1\\1&2\end{smallmatrix}}\right]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/838a30dc9d065ec434dff490bd84061ed569db3b)

![{\displaystyle {\begin{aligned}|A-\lambda I|&=\left|{\begin{bmatrix}2&1\\1&2\end{bmatrix}}-\lambda {\begin{bmatrix}1&0\\0&1\end{bmatrix}}\right|={\begin{vmatrix}2-\lambda &1\\1&2-\lambda \end{vmatrix}}\\[6pt]&=3-4\lambda +\lambda ^{2}\\[6pt]&=(\lambda -3)(\lambda -1).\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/0084c80ab8c7637830cdf01f1c754f92a6598ac0)

![{\displaystyle {\begin{aligned}|A-\lambda I|&=\left|{\begin{bmatrix}2&0&0\\0&3&4\\0&4&9\end{bmatrix}}-\lambda {\begin{bmatrix}1&0&0\\0&1&0\\0&0&1\end{bmatrix}}\right|={\begin{vmatrix}2-\lambda &0&0\\0&3-\lambda &4\\0&4&9-\lambda \end{vmatrix}},\\[6pt]&=(2-\lambda ){\bigl [}(3-\lambda )(9-\lambda )-16{\bigr ]}=-\lambda ^{3}+14\lambda ^{2}-35\lambda +22.\end{aligned}}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/30165fb86a7e23644d2e3373a1c2c68af4756523)