Matrix (mathematics)

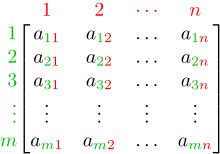

수학(mathematics)에서, 행렬(matrix, 복수형 matrices)은 행과 열로 배열된 숫자, 기호, 또는 표현의 직사각 배열(array) 또는 테이블로, 수학적 대상 또는 그러한 대상의 속성을 나타내기 위해 사용됩니다.

예를 들어, 위는 2개의 행과 3개의 열을 갖는 행렬입니다. 이것은 종종 "2행 3열, 행렬", " 행렬", 또는 차원 의 행렬이라고 참조됩니다.

추가 사양 없이, 행렬은 선형 맵(linear maps)을 나타내고, 선형 대수(linear algebra)에서 명시적 계산을 허용합니다. 그러므로, 행렬의 연구는 선형 대수 큰 부분을 차지하고, 추상 선형 대수의 대부분의 속성과 연산은 행렬의 관점에서 표현될 수 있습니다. 예를 들어, 행렬 곱셈(matrix multiplication)은 선형 맵의 합성(composition)을 나타냅니다.

모든 행렬이 선형 대수와 관련되는 것은 아닙니다. 이것은, 특히, 그래프 이론에서, 발생 행렬(incidence matrices)과 인접 행렬(adjacency matrices)의 경우입니다.[1] 이 기사는 선형 대수와 관련된 행렬에 초점을 맞추고, 달리 지정되지 않은 한, 모든 행렬은 선형 맵을 나타내거나 이를테면 그렇게 볼 수 있습니다.

행과 열의 개수가 같은 행렬, 정사각 행렬(Square matrices)은 행렬 이론에서 중요한 역할을 합니다. 주어진 차원의 정사각 행렬은 비교환 링(noncommutative ring)을 형성하며, 이는 비교환 링의 가장 공통적인 예제 중 하나입니다. 정사각 행렬의 행렬식(determinant)은 정사각 행렬의 연구에 토대가 되는 행렬과 결합된 숫자입니다; 예를 들어, 정사각 행렬이 역-가능(invertible)인 것과 그것이 비-영 행렬식을 가지는 것은 필요충분 조건이고, 정사각 행렬의 고윳값(eigenvalues)이 다항(polynomial) 행렬식의 근인 것은 필요충분 조건입니다.

기하학(geometry)에서, 행렬은 기하학적 변환 (예를 들어, 회전) 및 좌표 변경을 지정하고 나타내는 데 널리 사용됩니다. 수치 해석(numerical analysis)에서, 많은 계산 문제는 행렬 계산으로 축소함으로써 해결되고, 여기에는 종종 거대한 차원의 행렬 계산이 포함됩니다. 행렬은 대부분의 수학과 대부분의 과학 분야에서 직접적으로 또는 기하학과 수치 해석에서 사용을 통해 사용됩니다.

행렬 이론(Matrix theory)은 행렬의 연구에 초점을 맞춘 수학의 한 가지입니다. 그것은 처음에는 선형 대수의 하위-가지였지만, 곧 그래프 이론, 대수학, 조합론, 및 통계학과 관련된 주제를 포함하도록 성장했습니다.

Definition

행렬은 행렬의 엔트리라고 불리는 숫자 (또는 다른 수학적 대상)의 직사각 배열입니다. 행렬은 덧셈 및 곱셈과 같은 표준 연산(operations)을 따릅니다.[2] 가장 공통적으로, 필드 F에 걸쳐 행렬은 F의 원소의 직사각 배열입니다.[3][4] 실수 행렬(real matrix)과 복소수 행렬(complex matrix)은 그 엔트리가 각각 실수 또는 복소수인 행렬입니다. 보다 일반적인 엔트리의 유형은 아래에서 설명합니다. 예를 들어, 이것은 실수 행렬입니다:

행렬의 숫자, 기호 또는 표현은 엔트리 또는 원소라고 불립니다. 행렬에서 엔트리의 수평 줄과 수직 줄은 각각 행과 열이라고 불립니다.

Size

행렬의 크기는 그것이 포함하는 행과 열의 개수에 의해 정의됩니다. 그것들이 양의 정수인 한 (보통의 의미에서) 행렬의 행과 열의 개수는 제한이 없습니다. m개의 행과 n개의 열을 갖는 행렬은 m × n 행렬이라고 불리지만, m과 n은 그것의 차원(dimensions)이라고 불립니다. 예를 들어 위의 행렬 A는 3 × 2 행렬입니다.

단일 행을 갖는 행렬은 행 벡터(row vectors)라고 불리고, 단일 열을 갖는 행렬은 열 벡터(column vectors)라고 불립니다. 같은 개수의 행과 열을 갖는 행렬은 정사각 행렬(square matrix)이라고 불립니다.[5] 무한한 개수의 행이나 열 (또는 둘 다)을 갖는 행렬은 무한 행렬(infinite matrix)이라고 불립니다. 컴퓨터 대수 프로그램과 같은 일부 문맥에서, 빈 행렬(empty matrix)이라고 불리는 행이나 열이 없는 행렬을 고려하는 것이 유용합니다.

| Name | Size | Example | Description |

|---|---|---|---|

| 행 벡터 | 1 × n | 하나의 행을 갖는 행렬, 때때로 벡터를 나타내기 위해 사용됩니다 | |

| 열 벡터 | n × 1 | 하나의 열을 갖는 행렬, 때때로 벡터를 나타내기 위해 사용됩니다 | |

| 정사각 행렬 | n × n | 같은 개수의 행과 열을 갖는 행렬, 때때로 반사, 회전, 또는 전단과 같은 벡터 공간에서 자체로의 선형 변환을 나타내기 위해 사용됩니다 |

Notation

기호적 행렬 표기법의 세부 사항은 일부 우세한 추세와 함께 광범위하게 다양합니다. 행렬은 공통적으로 행렬 가 다음과 같이 표현되도록 대괄호 또는 소괄호 안에 작성됩니다: 이것은 다음과 같이 인덱스와 함께 오직 단일 일반적인 항을 씀으로써 축약될 수 있습니다: 또는 인 경우에서 로 축약됩니다.

행렬은 보통 대문자 (예를 들어, 위의 예제에서 A)를 사용하여 기호화되고, 반면 대응하는 소문자는 두 개의 아래첨자 인덱스 (예를 들어, a11, 또는 a1,1)와 함께 엔트리를 나타냅니다. 행렬을 기호화하기 위해 대문자를 사용하는 것 외에도, 많은 저자는 행렬을 다른 수학적 객체와 더욱 구별하기 위해 공통적으로 굵은 글꼴 (이탤릭체가 아님)과 같은 특별한 인쇄 스타일을 사용합니다. 대안적인 표기법은 에서와 같이 굵은 글꼴 스타일을 사용하거나 사용하지 않고 변수 이름과 함께 이중-밑줄을 사용하는 것과 관련됩니다.

행렬 A의 -번째 행과 -번째 열에 있는 엔트리는 행렬의 , 또는 엔트리라고도 참조되고, 공통적으로 또는 로 표시됩니다. 해당 엔트리에 대한 대안적인 표기법은 및 입니다. 예를 들어, 다음 행렬 A의 (1, 3) 엔트리는 5입니다 (역시 , , 또는이라고 표시됩니다):

때때로, 행렬의 엔트리는 와 같은 형식에 의해 정의될 수 있습니다. 예를 들어, 다음 행렬 A의 각 엔트리는 공식 에 의해 결정됩니다:

이 경우에서, 행렬 자체는 때때로 대괄호나 이중 소괄호 안에 해당 공식에 의해 정의됩니다. 예를 들어, 위의 행렬은 A = [i−j], 또는 A = ((i−j))로 정의됩니다. 만약 행렬 크기가 m × n이면, 위에서-언급된 공식 는 임의의 i = 1, ..., m과 임의의 j = 1, ..., n에 대해 유효합니다. 이것은 별도로 지정되거나, 아래첨자로 m × n을 사용하여 표시될 수 있습니다. 예를 들어, 위의 행렬 A는 3 × 4이고, A = [i − j] (i = 1, 2, 3; j = 1, ..., 4), 또는 A = [i − j]3×4로 정의될 수 있습니다.

일부 프로그래밍 언어는 이중 아래첨자 배열 (또는 배열의 배열)을 사용하여 m × n 행렬을 나타냅니다. 일부 프로그래밍 언어는 배열 인덱스의 번호 매기기를 0부터 시작하며, 이 경우에서 m × n 행렬의 엔트리는 0 ≤ i ≤ m − 1와 0 ≤ j ≤ n − 1로 인덱싱됩니다.[6] 이 기사는 열거가 1부터 시작하는 수학적 쓰기의 보다 공통적인 규칙을 따릅니다.

별표는 때때로 행렬에서 전체 행이나 전체 열을 참조하기 위해 사용됩니다. 예를 들어, 는 A의 i번째 행을 나타내고, 는 A의 j번째 열을 참조합니다.

모든 m × n 실수 행렬의 집합(set)은 종종 또는 으로 표시됩니다. 또 다른 필드(field)에 걸쳐 또는 링(ring) R에 걸쳐 모든 m × n 행렬의 집합은 유사하게 또는 으로 표시됩니다. 만약 m = n, 즉 정사각 행렬(square matrices)의 경우이면, 그 차원을 반복하지 않습니다: 또는 [7] 종종, 이 의 자리에 사용됩니다.

Basic operations

행렬을 수정하기 위해 적용될 수 있는 몇 개의 기본 연산이 있습니다: 그것들은 행렬 덧셈, 스칼라 곱셈, 전치, 행렬 곱셈, 행 연산, 및 부분행렬이라고 불립니다.[9]

Addition, scalar multiplication, and transposition

| Operation | Definition | Example |

|---|---|---|

| 덧셈 | 두 m-×-n 행렬 A와 B의 합 A+B은 엔트리-별로 계산됩니다:

|

|

| 스칼라 곱셈 | 숫자 c (추상 대수의 용어에서 스칼라라고도 불림)와 행렬 A의 곱 cA는 A의 모든 각 엔트리에 c를 곱함으로써 계산됩니다:

이 연산은 스칼라 곱셈이라고 불리지만, 그것의 결과는 혼동을 피하기 위해 "스칼라 곱"이라고 이름-짓지 않는데, 왜냐하면 "스칼라 곱"은 때때로 "안의 곱"에 대한 동의어로 사용되기 때문입니다. |

|

| 전치 | m-×-n 행렬 A의 전치는 n-×-m 행렬 AT ( Atr 또는 tA라고도 표시됨)는 행을 열로 바꿈으로써 형되고 그 반대도 마찬가지입니다:

|

숫자의 친숙한 속성은 행렬의 이들 연산으로 확장됩니다: 예를 들어 덧셈은 교환적(commutative), 즉, 행렬 합은 피합수의 순서에 의존하지 않습니다: A + B = B + A.[10] 전치는 덧셈과 스칼라 곱셈과 호환되며, (cA)T = c(AT) 및 (A + B)T = AT + BT로 표현됩니다. 마지막으로 (AT)T = A입니다.

Matrix multiplication

두 행렬의 곱셈이 정의되는 것과 왼쪽 행렬의 열의 개수와 오른쪽 행의 행의 개수가 같은 것은 필요충분 조건입니다. 만약 A가 m-×-n 행렬이고 B가 n-×-p 행렬이면, 행렬 곱 AB는 m-×-p 행렬이며 그것들의 엔트리는 A의 대응하는 행과 B의 대응하는 열의 점 곱(dot product)에 의해 주어집니다:[11]

여기서 1 ≤ i ≤ m이고 1 ≤ j ≤ p입니다.[12] 예를 들어, 곱에서 밑줄 친 엔트리 2340는 (2 × 1000) + (3 × 100) + (4 × 10) = 2340로 계산됩니다:

행렬 곱셈은 규칙 (AB)C = A(BC) (결합성), 및 (A + B)C = AC + BC와 마찬가지로 C(A + B) = CA + CB (왼쪽 분배성과 오른쪽 분배성)를 만족시키며, 이때 행렬의 크기는 다양한 곱이 정의됨을 만족해야 합니다.[13] 곱 AB는 BA가 정의되는 조건 없이 정의될 수 있으며, 즉, A와 B가 각각 m-×-n이고 n-×-k 행렬이고 m ≠ k인 경우입니다. 두 곱이 모두 정의되더라도, 그것들은 일반적으로 같을 필요는 없으며, 즉,

- AB ≠ BA,

다시 말해, 행렬 곱셈은 그것의 곱이 인수의 순서와 무관한 숫자 (유리수, 실수, 또는 복소수)와 현저하게 대조적으로 교환적(commutative)이지 않습니다.[11] 서로 교환하지 않는 두 행렬의 예제는 다음과 같습니다:

반면에

방금 설명한 보통의 행렬 곱셈 외에도, 아다마르 곱(Hadamard product)과 크로네커 곱(Kronecker product)과 같이 곱셈의 형식으로 고려될 수 있는 행렬 위에 덜 자주 사용되는 다른 연산도 존재합니다.[14] 그것들은 실베스터 방정식(Sylvester equation)과 같은 행렬 방정식을 풀 때 발생합니다.

Row operations

행 연산의 세 가지 유형이 있습니다:

- 행 덧셈, 즉 행을 또 다른 행과 더하는 것입니다;

- 행 곱셈, 즉 행의 모든 엔트리와 비-영 상수를 곱하는 것입니다;

- 행 바꾸기, 즉 행렬의 두 행을 서로 바꾸는 것입니다;

이들 연산은 선형 방정식(linear equations) 풀기 및 행렬 역(matrix inverses) 찾기를 포함하여 여러 가지 방법으로 사용됩니다.

Submatrix

행렬의 부분행렬(submatrix)은 행 및/또는 열의 임의의 모음을 삭제함으로써 얻습니다.[15][16][17] 예를 들어, 다음 3-x-4 행렬에서, 행 3과 열 2를 제거함으로써 2-x-3 부분행렬을 구성할 수 있습니다:

행렬의 소행렬식(minors)과 여인수(cofactor)는 특정 부분행렬의 행렬식(determinant)을 계산함으로써 구합니다.[17][18]

주요 부분행렬(principal submatrix)은 특정 행과 열을 제거함으로써 얻은 정사각 부분행렬입니다. 그 정의는 저자마다 다릅니다. 일부 저자에 따르면, 주요 부분행렬은 남아 있는 행 인덱스 집합이 남아 있는 열 인덱스 집합과 같은 부분행렬입니다.[19][20] 다른 저자는 주요 부분행렬을 어떤 숫자 k에 대해 처음 k개의 행과 열이 남아 있는 것으로 정의합니다;[21] 이러한 유형의 부분행렬은 선행 주요 부분행렬(leading principal submatrix)이라고도 합니다.[22]

Linear equations

행렬은 여러 선형 방정식, 즉, 선형 방정식의 시스템을 간결하게 쓰고 작업하기 위해 사용될 수 있습니다. 예를 들어, A가 m×n 행렬, x는 n개의 변수 x1, x2, ..., xn의 열 벡터 (즉, n×1-행렬)를 지정하고 b는 m×1-열 벡터이면, 다음 행렬 방정식은

다음 선형 방정식의 시스템과 동등합니다:[23]

행렬을 사용하여, 이것은 모든 방정식을 개별적으로 작성함으로써 가능한 것보다 더 간단하게 해결될 수 있습니다. 만약 n = m이고 방정식이 독립적(independent)이면, 이것은 다음을 씀으로써 수행될 수 있습니다:

여기서 A−1는 A의 역 행렬(inverse matrix)입니다. 만약 A가 역을 가지지 않으면, 해는—어떤 것이라도 있다면—그것의 일반화된 역(generalized inverse)을 사용하여 구할 수 있습니다.

Linear transformations

행렬과 행렬 곱셈은 선형 맵이라고도 알려져 있는 선형 변환과 관련될 때 필수 기능을 나타냅니다. 실수 m×n 행렬 A는 Rn에서 각 벡터 x를 Rm에서 벡터인 (행렬) 곱 Ax에 매핑하는 선형 변환 Rn → Rm을 발생시킵니다. 반대로 각 선형 변환 f: Rn → Rm은 고유한 m×n 행렬 A에서 발생합니다: 명시적으로, A의 (i, j)-엔트리는 f(ej)의 i번째 좌표이며, 여기서 ej = (0,...,0,1,0,...,0)은 j번째 위치에 1을 갖고 모든 다른 곳에서 0을 갖는 단위 벡터(unit vector)입니다. 행렬 A는 선형 맵 f를 나타낸다고 말하고, A는 f의 변환 행렬이라고 불립니다.

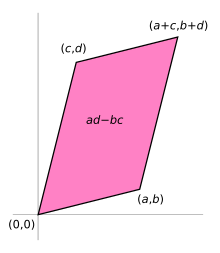

예를 들어, 다음 2×2 행렬은

단위 정사각형(unit square)을 (0, 0), (a, b), (a + c, b + d), 및 (c, d)에 꼭짓점을 갖는 평행사변형(parallelogram)으로의 변환으로 볼 수 있습니다. 오른쪽 그림에서 평행사변형은 A에 각 열 벡터 , 및 를 차례로 곱함으로써 얻습니다. 이들 벡터는 단위 정사각형의 꼭짓점을 정의합니다.

다음 테이블은 R2의 결합된 선형 맵을 갖는 여러 2×2 실수 행렬을 보여줍니다. 파란색 원본은 녹색 격자와 모양에 매핑됩니다. 원점 (0,0)은 검은색 점으로 표시됩니다.

| Horizontal shear with m = 1.25. |

Reflection through the vertical axis | Squeeze mapping with r = 3/2 |

Scaling by a factor of 3/2 |

Rotation by π/6 = 30° |

|

|

|

|

|

행렬과 선형 맵 사이의 일-대-일 대응 아래에서, 행렬 곱셈은 맵의 합성(composition)에 해당합니다:[24] 만약 k×m 행렬 B가 또 다른 선형 맵 g: Rm → Rk를 나타내면, 합성 g ∘ f는 BA에 의해 표현되는데, 왜냐하면 다음과 같기 때문입니다:

- (g ∘ f)(x) = g(f(x)) = g(Ax) = B(Ax) = (BA)x.

마지막 상등은 위에서 언급한 행렬 곱셈의 결합성에서 따릅니다.

행렬 A의 랭크는 행렬의 선형적으로 독립(linearly independent) 행 벡터의 최대 개수이며, 선형적으로 독립 열 벡터의 최대 개수와 같습니다.[25] 동등하게, 그것은 A에 의해 표현되는 선형 맵의 이미지(image)의 차원(dimension)입니다.[26] 랭크-널러티 정리(rank–nullity theorem)는 행렬의 커널(kernel) 차원에 랭크를 더한 것이 행렬의 열 개수와 같다고 말합니다.[27]

Square matrix

정사각 행렬(square matrix)은 행과 열의 개수가 같은 행렬입니다.[5] n×n 행렬은 n차 정사각 행렬로 알려져 있습니다. 같은 차수의 임의의 두 정사각 행렬은 더하고 곱할 수 있습니다. 엔트리 는 정사각 행렬의 주요 대각선(main diagonal)을 형성합니다. 그것들은 행렬의 왼쪽 위 모서리에서 오른쪽 아래 모서리까지 이어지는 가상의 직선 위에 놓입니다.

Main types

Name Example with n = 3 Diagonal matrix Lower triangular matrix Upper triangular matrix

Diagonal and triangular matrix

만약 주요 대각선 아래에 있는 A의 모든 엔트리가 영이면, A는 위쪽 삼각 행렬(upper triangular matrix)이라고 불립니다. 마찬가지로 만약 주요 대각선 위에 있는 A의 모든 엔트리가 영이면, A는 아래쪽 삼각 행렬(lower triangular matrix)이라고 불립니다. 만약 주요 대각선 밖의 모든 엔트리가 영이면, A는 대각 행렬(diagonal matrix)이라고 불립니다.

Identity matrix

크기 n의 항등 행렬(identity matrix) In은 주요 대각선(main diagonal)의 모든 원소가 1이고 모든 다른 원소가 0과 같은 n×n 행렬입니다. 예를 들면 다음과 같습니다:

그것은 차수 n의 정사각 행렬이고, 특수한 종류의 대각 행렬(diagonal matrix)입니다. 그것은 항등 행렬이라고 불리는데 왜냐하면 그것과의 곱셈은 행렬을 변경하지 않기 때문입니다:

- AIn = ImA = A for any m-by-n matrix A.

항등 행렬의 비-영 스칼라 배수는 스칼라 행렬이라고 불립니다. 만약 행렬 엔트리가 필드에서 오면, 스칼라 행렬은 행렬 곱셈 아래에서 그룹을 형성하며, 즉, 필드의 비-영 원소의 곱셈 그룹과 동형적입니다.

Symmetric or skew-symmetric matrix

그것의 전치와 같은 정사각 행렬 A, 즉 A = AT는 대칭 행렬(symmetric matrix)입니다. 만약 대신 A가 그것의 전치의 부정과 같으면, 즉 A = −AT이면, A는 반-대칭 행렬(skew-symmetric matrix)입니다. 복소수 행렬에서, 대칭은 종종 A∗ = A를 만족시키는 에르미트 행렬(Hermitian matrices)의 개념으로 대체되며, 여기서 별표(star 또는 asterisk)는 행렬의 켤레 전치(conjugate transpose), 즉 A의 복소수 켤레(complex conjugate)의 전치를 나타냅니다.

스펙트럼 정리(spectral theorem)에 따르면, 실수 대칭 행렬과 복소수 에르미트 행렬은 고유기저(eigenbasis)를 가집니다; 즉, 모든 각 벡터는 고유벡터의 선형 조합(linear combination)으로 표현될 수 있습니다. 두 경우 모두에서, 모든 고윳값은 실수입니다.[28] 이 정리는 무한하게 많은 행과 열을 갖는 행렬과 관련된 무한-차원 상황으로 일반화될 수 있으며, 아래를 참조하십시오.

Invertible matrix and its inverse

정사각 행렬 A는 다음임을 만족하는 행렬 B가 존재하면 역가능(invertible) 또는 비-특이(non-singular)라고 불립니다:

여기서 In는 주요 대각선(main diagonal)에 1을 갖고 다른 모든 곳에 0을 갖는 n×n 항등 행렬(identity matrix)입니다. 만약 B가 존재하면, 그것은 고유하고 A의 역 행렬(inverse matrix)이라고 불리고, A−1로 표시됩니다.

Definite matrix

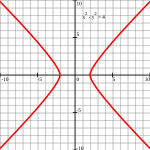

| Positive definite matrix | Indefinite matrix |

|---|---|

Points such that (Ellipse). |

Points such that (Hyperbola). |

대칭 실수 행렬 A는 다음과 같은 결합된 이차 형식(quadratic form)이 Rn에서 모든 각 비-영 벡터 x에 대해 양수 값을 가지면 양수-한정(positive-definite)이라고 불립니다:

- f (x) = xTA x

만약 f (x)가 음수 값만 산출하면 A는 음수-한정(negative-definite)입니다; 만약 f가 음수 값과 양수 값을 모두 생성하면 A는 비-한정(indefinite)입니다.[31] 만약 이차 형식 f가 오직 비-음의 값 (양수 또는 0)을 생성하면, 대칭 행렬은 양수-반한정 (또는 양수가 아닌 값만 있으면 음수-반한정)이라고 불립니다; 따라서 그 행렬은 정확히 그것의 양수-반한정도 아니고 음수-반한정도 아닐 때 비-한정입니다.

대칭 행렬이 양수-한정인 것과 모든 그것의 고윳값이 양수인 것은 필요충분 조건이며, 즉, 그 행렬은 양수-반한정이고 역-가능입니다.[32] 오른쪽 테이블은 2x2 행렬에 대한 두 가지 가능성을 보여줍니다.

두 개의 서로 다른 벡터를 입력으로 허용하면 A에 결합된 쌍선형 형식(bilinear form)을 대신 생성됩니다:[33]

- BA (x, y) = xTAy.

복소수 행렬의 경우에서, 같은 용어와 결과가 적용되며, 대칭 행렬, 이차 형식, 쌍선형 형식, 및 전치 xT가 각각 에르미트 행렬, 에르미트 형식, 반쌍선형 형식, 및 켤레 전치(conjugate transpose) xH로 대체됩니다.

Orthogonal matrix

직교 행렬(orthogonal matrix)은 그것의 열과 행이 직교 단위 벡터 (즉, 직교-정규 벡터)인 실수 엔트리를 갖는 정사각 행렬입니다. 동등하게, 행렬 A는 만약 그것의 전치(transpose)가 그것의 역(inverse)과 같으면 직교입니다:

이것은 다음을 동반합니다:

여기서 In는 크기 n의 항등 행렬(identity matrix)입니다.

직교 행렬 A는 반드시 역-가능 (역 A−1 = AT을 가짐), 유니태리 (A−1 = A*), 및 정규 (A*A = AA*)입니다. 임의의 직교 행렬의 행렬식(determinant)은 +1 또는 −1입니다. 특수 직교 행렬(special orthogonal matrix)은 행렬식(determinant) +1을 갖는 직교 행렬입니다. 선형 변환(linear transformation)으로서, 행렬식 +1을 갖는 모든 각 직교 행렬은 반사 없는 순수 회전(rotation)이며, 즉, 변환이 변환된 구조의 방향을 보존하고, 반면에 행렬식 −1을 갖는 모든 각 직교 행렬은 방향을 거꾸로 하며, 즉, 순수 반사(reflection)와 (아마도 널) 회전의 합성입니다. 항등 행렬은 행렬식 1을 가지고, 각도 영에 의한 순수 회전입니다.

직교 행렬의 복소수(complex) 아날로그는 유니태리 행렬(unitary matrix)입니다.

Main operations

Trace

정사각 행렬 A의 대각합(trace), tr(A)은 그것의 대각선 엔트리의 합입니다. 행렬 곱셈은 위에서 언급한 것처럼 교환적이지 않지만, 두 행렬 곱의 대각합은 인수의 순서와 무관합니다:

- .

이것은 행렬 곱셈의 정의에서 바로 나타납니다:

따라서 두 개보다 많은 행렬 곱의 대각합은 행렬의 순환 순열(cyclic permutations)과 무관하며, 어쨌든 이것은 일반적으로 임의적인 순열에는 적용되지 않습니다 (예를 들어, 일반적으로 tr(ABC) ≠ tr(BAC)). 역시, 행렬의 대각합은 그것의 전치의 대각합과 같습니다. 즉,

- tr(A) = tr(AT).

Determinant

정사각 행렬 A의 행렬식(determinant, det(A) 또는 |A|로 표시됨)은 행렬의 특정 속성을 인코딩하는 숫자입니다. 행렬이 역-가능인 것과 그것의 행렬식이 비-영인 것은 필요충분 조건입니다. 그 절댓값은 단위 정사각 (또는 정육면체)의 이미지의 (R2에서) 넓이 또는 (R3에서) 부피와 같고, 반면에 그 부호는 해당 선형 맵의 방향에 해당합니다: 행렬식이 양수인 것과 방향이 유지되는 것은 필요충분 조건입니다.

2×2 행렬의 행렬식은 다음에 의해 제공됩니다:

3x3 행렬의 행렬식은 6개의 항이 포함됩니다 (사뤼스의 규칙(rule of Sarrus)). 더 긴 라이프니츠 공식(Leibniz formula)은 이들 두 공식을 모든 차원으로 일반화합니다.[35]

정사각 행렬의 곱의 행렬식은 그것들의 행렬식의 곱과 같습니다:

- det(AB) = det(A) · det(B), 또는 대안적인 표기법을 사용하여:

- |AB| = |A| · |B|.[36]

임의의 행의 배수를 또 다른 행에 더하거나, 임의의 열의 배수를 또 다른 열에 더하는 것은 행렬식을 변경하지 않습니다. 두 행 또는 두 열을 교환하는 것은 행렬식에 −1을 곱함으로써 행렬식에 영향을 미칩니다.[37] 이들 연산을 사용하여, 임의의 행렬은 아래쪽 (또는 위쪽) 삼각 행렬로 변환될 수 있고, 그러한 행렬에 대해, 행렬식은 주요 대각선에 있는 엔트리의 곱과 같습니다; 이것은 임의의 행렬의 행렬식을 계산하기 위한 방법을 제공합니다. 마지막으로, 라플라스 전개(Laplace expansion)는 소행렬식(minors), 즉 더 작은 행렬의 행렬식으로 행렬식을 표현합니다.[38] 이 전개는 행렬식의 재귀적 정의에 사용될 수 있으며 (고유 엔트리인 1x1 행렬의 행렬식, 또는 1인 0x0 행렬의 행렬식을 시작하는 사례로 취합니다), 그것은 라이프니츠 공식과 동등한 것으로 볼 수 있습니다. 행렬식은 크라메르의 규칙(Cramer's rule)을 사용하여 선형 시스템(linear systems)을 풀기 위해 사용될 수 있으며, 여기서 두 개의 관련된 정사각 행렬의 행렬식의 나눗셈은 각 시스템의 변수의 값과 같게 합니다.[39]

Eigenvalues and eigenvectors

다음을 만족시키는 숫자 와 비-영 벡터 v는

각각, A의 고윳값(eigenvalue)과 고유벡터(eigenvector)라고 불립니다.[40][41] 숫자 λ가 n×n-행렬 A의 고윳값인 것과 A−λIn가 역가능이 아닌 것은 필요충분 조건이며, 이는 다음과 동등(equivalent)합니다:

행렬식 det(XIn−A)의 평가에 의해 주어진 불확정(indeterminate) X에서 다항식 pA는 A의 특성 다항식(characteristic polynomial)이라고 불립니다. 그것은 차수(degree) n의 일계수 다항식(monic polynomial)입니다. 그러므로 다항 방정식 pA(λ) = 0은 많아야 n 다른 해, 즉, 그 행렬의 고윳값을 가집니다.[43] 그것들은 심지어 A의 엔트리가 실수이더라도 복소수일 수 있습니다. 케일리-해밀턴 정리(Cayley–Hamilton theorem)에 따르면, pA(A) = 0, 즉, 행렬 자체를 자신의 특성 다항식에 대입한 결과는 영행렬(zero matrix)을 산출합니다.

Computational aspects

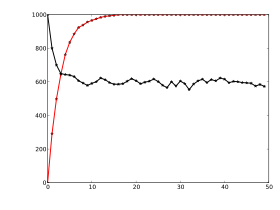

행렬 계산은 종종 다른 기술로 수행될 수 있습니다. 많은 문제는 직접 알고리듬 또는 반복적 접근 방식으로 해결될 수 있습니다. 예를 들어, 정사각 행렬의 고유벡터는 n이 무한대로 가는 경향일 때 고유벡터로 수렴하는 벡터 xn의 수열(sequence)을 찾음으로써 얻을 수 있습니다.[44]

각 특정 문제에 대해 가장 적합한 알고리듬을 선택하기 위해, 모든 사용-가능한 알고리듬의 효율성과 정밀도 둘 다를 결정하는 것이 중요합니다. 이들 문제를 연구하는 영역은 수치적 선형 대수(numerical linear algebra)라고 불립니다.[45] 다른 수치적 상황과 마찬가지로 두 가지 주요 측면은 알고리듬의 복잡성(complexity)과 수치적 안정성(numerical stability)입니다.

알고리듬의 복잡성을 결정한다는 것은 행렬의 곱셈과 같은 일부 알고리듬을 수행하기 위해 덧셈과 스칼라의 곱셈과 같은 기본 연산이 얼마나 필요한지에 대한 위쪽 경계(upper bounds) 또는 추정을 찾는 것을 의미합니다. 위에서 주어진 정의를 사용하여 두 개의 n×n 행렬의 행렬 곱을 계산하는 것은 n3 곱셈이 필요한데, 왜냐하면 곱의 n2 엔트리 중 임의의 것에 대해, n 곱셈이 필요하기 때문입니다. 슈트라센 알고리듬(Strassen algorithm)은 이 "소박한(naive)" 알고리듬을 능가합니다; 그것은 n2.807 곱셈만 필요합니다.[46] 정제된 접근 방식은 컴퓨팅 장치의 특정 기능도 통합합니다.

많은 실제 상황에서, 포함된 행렬에 대한 추가 정보가 알려져 있습니다. 중요한 경우는 희소 행렬(sparse matrices), 즉 대부분의 엔트리가 영인 행렬입니다. 말하자면 켤레 그래디언트 방법(conjugate gradient method)과 같이 희소 행렬 A에 대해 선형 시스템 Ax = b를 풀기 위해 특별히 조정된 알고리듬이 있습니다.[47]

입력 값에서 작은 편차가 결과에서 큰 편차로 이어지지 않으면 알고리듬은, 대략적으로 말하자면, 수치적으로 안정적입니다. 예를 들어, 라플라스 전개를 통해 행렬의 역을 계산합니다 (adj(A)는 A의 수반 행렬(adjugate matrix)을 나타냅니다):

- A−1 = adj(A) / det(A)

위는 행렬의 행렬식이 매우 작으면 상당한 반올림 오차로 이어질 수 있습니다. 행렬의 노름(norm of a matrix)은 행렬 역의 계산과 같은 선형 대수적 문제의 조건화(conditioning)를 포획하기 위해 사용될 수 있습니다.[48]

대부분의 컴퓨터 프로그래밍 언어는 배열을 지원하지만 행렬에 대한 내장된 명령으로 설계되지 않았습니다. 대신, 사용 가능한 외부 라이브러리는 현재 사용되는 거의 모든 프로그래밍 언어로 배열에 대한 행렬 연산을 제공합니다. 행렬 조작은 컴퓨터의 가장 초기의 수치적 응용 프로그램 중 하나였습니다.[49] 최초의 Dartmouth BASIC은 1964년에 구현된 두 번째 버전부터 배열에 대한 행렬 산술 명령을 내장했습니다. 일찍이 1970년대에, HP 9830과 같은 일부 엔지니어링 데스크톱 컴퓨터는 행렬에 대한 BASIC 명령을 추가하기 위한 ROM 카트리지를 가졌습니다. APL과 같은 일부 컴퓨터 언어는 행렬을 조작하도록 설계되었고, 다양한 수학 프로그램은 행렬 계산을 지원하기 위해 사용될 수 있습니다.[50]

Decomposition

행렬을 보다 쉽게 접근할 수 있는 형식으로 렌더링하는 여러 가지 방법이 있습니다. 그것들은 일반적으로 행렬 분해(matrix decomposition) 또는 행렬 인수분해(matrix factorization) 기술이라고 참조됩니다. 모든 이들 기술의 관심은 변환을 적용한 후 이들 수량을 계산할 수 있도록, 또는 특정 행렬 연산을 일부 유형의 행렬에 대해 알고리듬적으로 더 쉽게 수행할 수 있도록, 행렬식, 랭크, 또는 역과 같은 해당 행렬의 특정 속성을 보존하는 것입니다.

LU 분해 인수 행렬은 아래쪽 (L) 및 위쪽 삼각 행렬 (U)의 곱입니다.[51] 일단 이 분해가 계산되면, 선형 시스템은 전방향 대입과 역방향 대입이라는 간단한 기술을 통해 보다 효율적으로 해결될 수 있습니다. 마찬가지로 삼각 행렬의 역은 알고리듬적으로 계산하기가 더 쉽습니다. 가우스 소거법(Gaussian elimination)은 유사한 알고리듬입니다; 그것은 임의의 행렬을 행 사다리꼴 형식(row echelon form)으로 변환합니다.[52] 방법 둘 다는 행 또는 열을 교환하고 한 행의 배수를 또 다른 행에 더하는 것에 해당하는 적절한 기본 행렬(elementary matrices)로 행렬을 곱함으로써 진행됩니다. 특이값 분해(Singular value decomposition)는 임의의 행렬 A를 곱 UDV∗로 표현하며, 여기서 U와 V는 유니태리 행렬(unitary matrices)이고 D는 대각 행렬입니다.

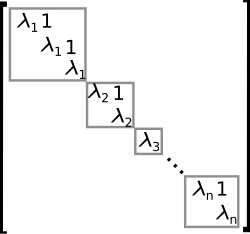

고유분해(eigendecomposition) 또는 대각화(diagonalization)는 A를 곱 VDV−1로 표현하며, 여기서 D는 대각 행렬이고 V는 적절한 역-가능 행렬입니다.[53] 만약 A가 이 형식으로 쓸 수 있으면, 그것은 대각화-가능(diagonalizable)이라고 불립니다. 보다 일반적으로, 모든 행렬에 적용할 수 있는, 조르당 분해는 행렬을 조르당 정규 형식으로 변환합니다. 즉 말하자면, 오른쪽에서 보인 것처럼 A의 고윳값 λ1에서 λn까지의 비-영 엔트리만 주요 대각선에 배치되고 주요 대각선 바로 위에 1과 같은 엔트리를 가지는 행렬입니다.[54] 고유분해가 주어지면, A의 n번째 거듭제곱 (즉, n-겹 반복된 행렬 곱셈)은 다음을 통해 계산될 수 있습니다:

- An = (VDV−1)n = VDV−1VDV−1...VDV−1 = VDnV−1

그리고 대각 행렬의 거듭제곱은 대각 엔트리의 해당하는 거듭제곱을 취함으로써 계산될 수 있으며, 이는 대신 A에 대해 거듭제곱하는 것보다 훨씬 더 쉽습니다. 이것은 선형 미분 방정식, 행렬 로그, 및 행렬의 제곱근을 푸는 데 자주 발생하는 필요성, 행렬 지수 eA를 계산하기 위해 사용될 수 있습니다.[55] 수치적으로 나쁜-조건된 상황을 피하기 위해, 슈어 분해(Schur decomposition)와 같은 추가 알고리듬이 사용될 수 있습니다.[56]

Abstract algebraic aspects and generalizations

행렬은 다양한 방법으로 일반화될 수 있습니다. 추상 대수학은 보다 일반적인 필드(fields) 또는 심지어 링(rings)에서 엔트리를 갖는 행렬을 사용하고, 반면 선형 대수은 선형 맵의 개념에서 행렬의 속성을 코드화합니다. 무한하게 많은 열과 행을 갖는 행렬을 고려할 수 있습니다. 또 다른 확장은 종종 숫자의 수열로 실현될 수 있는 벡터와 달리 숫자의 고-차원 배열로 볼 수 있는 텐서(tensors)이고, 반면에 행렬은 직사각형 또는 2-차원 숫자의 배열입니다.[57] 특정 요구 사항에 따라 행렬은 행렬 그룹으로 알려진 그룹(groups)을 형성하는 경향이 있습니다. 마찬가지로 특정 조건 아래에서, 행렬은 행렬 링(matrix rings)으로 알려진 링(rings)을 형성합니다. 행렬의 곱은 일반적으로 교환적이지 않지만, 특정 행렬은 행렬 필드(matrix fields)로 알려진 필드(fields)를 형성합니다.

Matrices with more general entries

이 기사는 그 엔트리가 실수 또는 복소수인 행렬에 초점을 맞춥니다. 어쨌든, 행렬은 실수나 복소수보다 훨씬 더 일반적인 엔트리의 유형으로 고려될 수 있습니다. 일반화의 첫 번째 단계로, 임의의 필드, 즉, 덧셈, 뺄셈, 곱셈, 및 나눗셈 연산이 정의되고 잘 행동하는 집합이, 예를 들어 유리수 또는 유한 필드를 R 또는 C 대신 사용될 수 있습니다. 예를 들어 코딩 이론(coding theory)은 유한 필드에 걸쳐 행렬을 사용합니다. 고윳값(eigenvalues)이 고려되는 곳마다, 이것들은 다항식의 근이므로 행렬의 엔트리의 필드보다 더 큰 필드에만 존재할 수 있습니다; 예를 들어, 그것들이 실수 엔트리를 갖는 행렬의 경우에서 복소수일 수 있습니다. 행렬의 엔트리를 더 큰 필드 (예를 들어, 실수 행렬을 그 엔트리가 모두 실수로 발생하는 복소수 행렬로 보기 위해)의 원소로 재해석할 수 있는 가능성은 각 정사각 행렬이 고윳값의 전체 집합을 보유하도록 고려할 수 있습니다. 대안적으로 처음부터 C와 같이 대수적으로 닫힌 필드에 엔트리를 갖는 행렬만 고려할 수 있습니다.

보다 일반적으로, 링(ring) R에서 엔트리를 갖는 행렬은 수학에서 널리 사용됩니다.[58] 링은 나눗셈 연산이 존재할 필요가 없다는 점에서 필드보다 더 일반적인 개념입니다. 행렬의 매우 같은 덧셈과 곱셈 연산도 이 설정으로 확장됩니다. R에 걸쳐 모든 정사각 n×n 행렬의 집합 M(n, R) (Mn(R)이라고도 표시됨[7])은 행렬 링(matrix ring)이라고 불리는 링이며, 왼쪽 R-모듈 Rn의 자기사상 링(endomorphism ring)과 동형적입니다.[59] 만약 링 R이 교환적(commutative), 즉 곱셈이 교환적이면, 링 M(n, R)도 R에 걸쳐 결합 대수(associative algebra)입니다. 교환 링 R에 걸쳐 정사각 행렬의 행렬식(determinant)은 여전히 라이프니츠 공식(Leibniz formula)을 사용하여 정의될 수 있습니다; 그러한 행렬이 역-가능인 것과 그것의 행렬식이 필드 F에 걸쳐 상황을 일반화하는 R에서 역-가능인 것은 필요충분 조건이며, 여기서 모든 각 비-영 원소는 역-가능입니다.[60] 극단-링(superrings)에 걸쳐 행렬은 극단-행렬(supermatrices)이라고 불립니다.[61]

행렬은 항상 같은 링에 모든 엔트리를 포함하지 않으며, 심지어 어떤 링에도 전혀 포함하지 않습니다. 하나의 특별하지만 공통적인 경우는 엔트리 자체가 행렬인 행렬로 고려될 수 있는 블록 행렬(block matrices)입니다. 엔트리는 정사각 행렬일 필요가 없고, 따라서 임의의 링의 구성원일 필요가 없습니다; 그러나 그것들의 크기는 특정 호환성 조건을 충족해야 합니다.

Relationship to linear maps

선형 맵 Rn → Rm은 위에서(above) 설명된 것처럼 m×n 행렬과 동등합니다. 보다 일반적으로, 유한-차원 벡터 공간 사이의 임의의 선형 맵 f: V → W은 다음임을 만족하는 V의 기저 v1, ..., vn와 W의 w1, ..., wm를 선택한 후 (따라서 n은 V의 차원이고 m은 W의 차원임) 행렬 A = (aij)에 의해 설명될 수 있습니다:

다른 말로, A의 열 j는 W의 기저 벡터 wi의 관점에서 vj의 이미지를 표현합니다; 따라서 이 관계는 행렬 A의 엔트리를 고유하게 결정합니다. 행렬은 기저의 선택에 따라 달라집니다: 기저의 다른 선택은 다양한 결과를 낳지만, 동등한 행렬(equivalent matrices)을 발생시킵니다.[62] 위의 많은 구체적인 개념은 이러한 관점에서 재해석될 수 있으며, 예를 들어, 전치 행렬 AT는 이중 기저(dual bases)에 관해 A에 의해 주어진 선형 맵의 전치를 설명합니다.[63]

이들 속성은 보다 자연스럽게 다시 설명될 수 있습니다: 합성으로 곱셈을 갖는 필드 에서 엔트리를 갖는 모든 행렬의 카테고리(category)는 이 필드에 걸쳐 유한-차원 벡터 공간과 선형 맵의 카테고리와 동등합니다.

보다 일반적으로, m×n 행렬의 집합은 단위를 갖는 임의적인 링 R에 대해 자유 모듈 Rm과 Rn 사이의 R-선형 맵을 나타내기 위해 사용될 수 있습니다. 이들 맵의 n = m 합성이 가능할 때, 그리고 이것이 Rn의 자기사상 링(endomorphism ring)을 나타내는 n×n 행렬의 행렬 링(matrix ring)을 발생시킵니다.

Matrix groups

그룹(group)은 대상의 집합과 이항 연산(binary operation), 즉, 특정 요구 사항에 따라 두 대상을 세 번째 대상으로 결합하는 연산으로 구성된 수학적 구조입니다.[64] 대상은 행렬이고 그룹 연산이 행렬 곱셈인 그룹은 행렬 그룹(matrix group)이라고 불립니다.[65][66] 그룹 모든 각 원소가 역-가능이어야 하므로, 가장 일반적인 행렬 그룹은 일반 선형 그룹(general linear groups)이라고 불리는 주어진 크기의 모든 역-가능 행렬의 그룹입니다.

행렬 곱과 역 아래에서 보존되는 행렬의 임의의 속성은 추가 행렬 그룹을 정의하기 위해 사용될 수 있습니다. 예를 들어, 주어진 크기와 1의 행렬식을 갖는 행렬은 특수 선형 그룹(special linear group)이라고 불리는 그것들의 일반 선형 그룹의 부분그룹 (즉, 포함된 더 작은 그룹)을 형성합니다.[67] 다음 조건에 의해 결정되는 직교 행렬(Orthogonal matrices)은

- MTM = I,

직교 그룹(orthogonal group)을 형성합니다.[68] 모든 각 직교 행렬은 행렬식(determinant) 1 또는 −1을 가집니다. 행렬식 1을 갖는 직교 행렬은 특수 직교 그룹(special orthogonal group)이라고 불리는 하위그룹을 형성합니다.

모든 각 유한 그룹은 대칭 그룹(symmetric group)의 정칙 표현(regular representation)을 고려함으로써 알 수 있는 것처럼 행렬 그룹과 동형적(isomorphic)입니다.[69] 일반 그룹은 표현 이론(representation theory)을 수단으로 비교적 잘 이해되고 있는 행렬 그룹을 이용하여 연구될 수 있습니다.[70]

Infinite matrices

무한한 대상이기 때문에, 그러한 행렬을 명시적으로 작성할 수 없는 경우에도 무한하게 많은 행 및/또는 열을 갖는 행렬을 고려할 수도 있습니다.[71] 중요한 것은 집합 인덱싱 행에서 모든 각 원소와 집합 인덱싱 열에서 모든 각 원소에 대해, 잘-정의된 엔트리가 있다는 것입니다 (이들 인덱스 집합은 자연수의 하위 집합일 필요도 없습니다). 덧셈, 뺄셈, 스칼라 곱셈, 및 전치의 기본 연산은 여전히 문제 없이 정의될 수 있습니다; 어쨌든, 행렬 곱셈은 결과 엔트리를 정의하기 위해 무한 합계를 포함할 수 있고, 이것들은 일반적으로 정의되지 않습니다.

만약 R이 단위를 갖는 임의의 링이면, 오른쪽 R 모듈로 의 자기사상의 링은 그 엔트리가 에 의해 인덱싱되고, 그 열 각각이 오직 유한하게 많은 비-영 엔트리를 포함하는 열 유한 행렬 의 링에 동형적입니다. 오른쪽 R 모듈로 고려된 M의 자기사상은 유사한 대상, 그 행 각각이 오직 유한하게 많은 비-영 엔트리를 가지는 행 유한 행렬 을 초래합니다.

만약 무한 행렬이 선형 맵을 설명하기 위해 사용되면, 다음에 따라오는 이유로, 모든 열에 비-영 엔트리가 유한한 개수만 있는 행렬만 사용할 수 있습니다. 행렬 A가 선형 맵 f: V→W를 설명하려면, 두 공간 모두에 대한 기저가 선택되어야 합니다; 정의에 의해 이것은 공간에서 모든 각 벡터가 계수(coefficients)의 (열) 벡터 v로 쓰인, 오직 유한하게 많은 엔트리 vi가 비-영이도록 기저 벡터의 (유한한) 선형 조합으로 고유하게 작성될 수 있음을 의미함을 상기하십시오. 이제 A의 열은 W의 기저에서 V의 개별 기저 벡터의 f에 의한 이미지를 설명하며, 이는 오직 이들 열이 오직 유한하게 많은 비-영 엔트리를 가지면 의미가 있습니다. 어쨌든, A의 행에는 제한이 없습니다: 곱 A·v는 관련된 v의 오직 유한하게 많은 비-영 계수가 있으므로, 모든 각 엔트리 중 하나는, 심지어 그것이 곱의 무한 합으로 주어지더라도, 오직 유한하게 많은 비-영 항을 포함하고 따라서 잘 정의됩니다. 더욱이, 이것은 A의 열의 선형 조합을 형성하는 것과 같으며 실제로는 오직 그것들 중 유한하게 많은 것만 포함하므로, 결과에는 각 열이 있기 때문에 오직 유한하게 많은 비-영 엔트리를 가집니다. 주어진 유형의 두 행렬의 곱은 잘 정의되어 있고 (열-인덱스와 행-인덱스 집합이 일치하는 조건으로 하여), 유형이 같고, 선형 맵의 합성에 해당합니다.

만약 R이 노름된(normed) 링이면, 행 또는 열 유한성 조건은 완화될 수 있습니다. 노름이 있으면, 절대적으로 수렴 급수(absolutely convergent series)가 유한 합 대신 사용될 수 있습니다. 예를 들어, 열 합계가 절대적으로 수렴하는 수열인 행렬은 링을 형성합니다. 유사하게, 행 합이 절대적으로 수렴하는 급수인 행렬도 링을 형성합니다.

무한 행렬은 역시 힐베르트 공간 위에 연산자를 설명하기 위해 사용될 수 있으며, 여기서 수렴과 연속성(continuity) 문제가 발생하여, 다시 부과되어야 하는 특정 제약이 발생합니다. 어쨌든, 행렬의 명시적 관점은 문제를 난독화하는 경향이 있고,[72] 함수형 해석(functional analysis)의 추상적이고 보다 강력한 도구가 대신 사용될 수 있습니다.

Empty matrix

빈 행렬(empty matrix)은 행이나 열 (또는 둘 다)의 개수가 영인 행렬입니다.[73][74] 빈 행렬은 영 벡터 공간(zero vector space)과 관련된 맵을 처리하는 데 도움이 됩니다. 예를 들어, 만약 A가 3x0 행렬이고 B가 0x3 행렬이면, AB는 3-차원 공간 V에서 자체로의 널 맵에 해당하는 3x3 영 행렬이고, 반면에 BA는 0x0 행렬입니다. 빈 행렬에 대한 공통적인 표기법은 없지만, 대부분의 컴퓨터 대수 시스템(computer algebra systems)은 그것들을 만들고 계산하는 것을 허용합니다. 0x0 행렬의 행렬식은 행렬식에 대해 라이프니츠 공식에서 발생하는 빈 곱(empty product)을 1로 할 때 1입니다. 이 값은 역시 임의의 유한-차원 공간에서 자체로의 항등 맵이 행렬식 1을 가진다는 살식과 일치하며, 행렬식의 특성화의 일부로 자주 사용되는 사실입니다.

행렬식 특성화의 일부로 자주 사용되는 행렬식 1을 갖는다는 사실과도 일치합니다.

Applications

수학 및 다른 과학 모두에서 행렬의 수많은 응용이 있습니다. 그들 중 일부는 단지 행렬에서 숫자의 집합의 간결한 표현을 이용합니다. 예를 들어, 게임 이론과 경제학에서, 지불 행렬(payoff matrix)은 주어진 (유한한) 대안 집합 중에서 플레이어가 선택하는 것에 따라 두 플레이어의 지불을 인코딩합니다.[75] 텍스트 마이닝(Text mining) 및 자동화된 시소러스(thesaurus) 편집은 tf-idf와 같은 문서-용어 행렬(document-term matrices)을 사용하여 여러 문서에서 특정 단어의 빈도를 추적합니다.[76]

복소수는 다음을 통해 특정 실수 2x2 행렬로 나타낼 수 있습니다:

이것 아래에서 복소수와 행렬의 덧셈과 곱셈이 서로 대응합니다. 예를 들어, 2x2 회전 행렬은 위와 같이 절댓값(absolute value)이 1인 어떤 복소수로 곱셈을 나타냅니다. 일반적으로 쿼터니언(quaternions)과 클리포드 대수(Clifford algebras)에 대해서도 유사한 해석이 가능합니다.[77]

힐 암호(Hill cipher)와 같은 초기 암호화(encryption) 기술도 행렬을 사용했습니다. 어쨌든, 행렬의 선형 본성으로 인해, 이들 코드는 비교적 쉽게 깨질 수 있습니다.[78] 컴퓨터 그래픽은 행렬을 대상을 나타내기 위해; 이론적인 카메라 관찰에 해당하는 3-차원 물체를 2-차원 화면에 투사하는 것과 같은 작업을 수행하기 위해, 아핀 회전 행렬을 사용하여 물체의 변형을 계산하기 위해; 그리고 샤프닝, 블러링, 에지 감지, 등과 같은 이미지 합성곱을 적용하기 위해 사용합니다.[79] 다항식 링(polynomial ring)에 걸쳐 행렬은 제어 이론(control theory)의 연구에서 중요합니다.

화학(Chemistry)은 특히 분자 결합(molecular bonding)과 분광학(spectroscopy)을 논의하기 위해 양자 이론(quantum theory)을 사용하기 때문에 다양한 방식으로 행렬을 사용합니다. 하트리-폭 방법(Hartree–Fock method)의 분자 오비탈(molecular orbitals)을 얻기 위해 호오탄 방정식(Roothaan equations)을 푸는 데 사용되는 겹침 행렬(overlap matrix)과 폭 행렬(Fock matrix)이 그 예입니다.

Graph theory

유한 그래프(finite graph)의 인접 행렬(adjacency matrix)은 그래프 이론(graph theory)의 기본 개념입니다.[80] 그것은 그래프의 어떤 꼭짓점이 가장자리로 연결되어 있는지 기록합니다. 두 개의 다른 값 (예를 들어, 각각 "예"와 "아니오"를 의미하는 1과 0)만 포함하는 행렬은 논리적 행렬(logical matrices)이라고 불립니다. 거리 (또는 비용) 행렬은 가장자리의 거리에 대한 정보를 포함합니다.[81] 이들 개념은 하이퍼링크로 연결된 웹사이트나 도로 등으로 연결된 도시에 적용될 수 있으며, 이 경우에서 (연결 네트워크가 극도로 밀집되지 않은 한), 행렬은 희소한(sparse) 경향이 있습니다. 즉, 비-영 엔트리가 거의 포함되지 않습니다. 그러므로, 특별히 맞춤화된 행렬 알고리듬은 네트워크 이론(network theory)에 사용될 수 있습니다.

Analysis and geometry

미분가능 함수(differentiable function) ƒ: Rn → R의 헤세 행렬(Hessian matrix)은 여러 좌표 방향에 관한 ƒ의 이차 도함수(second derivatives), 즉, 다음과 같이 구성됩니다:[82]

그것은 함수의 지역적 성장 행동에 대한 정보를 인코딩합니다: 임계 점 x = (x1, ..., xn), 즉, ƒ의 첫 번째 부분 도함수 가 사라지는 점이 주어지면, 함수는 헤세 행렬이 양수 한정이면 지역 최솟값을 가집니다. 이차 프로그래밍(Quadratic programming)은 행렬에 부착된 함수와 밀접하게 관련된 이차 함수의 전역 최솟값 또는 최댓값을 찾기 위해 사용될 수 있습니다 (위 참조).[83]

기하학적 상황에서 자주 사용되는 또 다른 행렬은 미분가능 맵 f: Rn → Rm의 야코비 행렬(Jacobi matrix)입니다. 만약 f1, ..., fm이 f의 구성 요소를 나타내면, 야코비 행렬은 다음과 같이 정의됩니다:[84]

만약 n > m이고, 야코비 행렬의 랭크가 최댓값 m에 도달하면, f는 암시적 함수 정리(implicit function theorem)에 의해 해당 점에서 지역적으로 역가능입니다.[85]

부분 미분 방정식(Partial differential equations)은 방정식의 최고-차수 미분 연산자의 계수 행렬을 고려함으로써 분류될 수 있습니다. 타원 부분 미분 방정식(elliptic partial differential equations)에 대해, 이 행렬은 양수 한정이며, 문제에서 해당 방정식의 가능한 해의 집합에 결정적인 영향을 미칩니다.[86]

유한 원소 방법(finite element method)은 부분 미분방정식을 풀기 위한 중요한 수치적 방법으로, 복잡한 물리적 시스템을 모의실험하는데 널리 적용됩니다. 그것은 조각별 선형 함수에 의해 일부 방정식에 대한 해를 근사화하기 위해 시도하며, 여기서 조각은 충분하게 미세한 격자에 대해 선택되며, 차례로 행렬 방정식으로 재구성될 수 있습니다.[87]

Probability theory and statistics

확률적 행렬(Stochastic matrices)은 행이 확률 벡터(probability vectors), 즉, 엔트리가 비-음수이고 합계가 1인 정사각형 행렬입니다. 확률적 행렬은 유한하게 많은 상태를 갖는 마르코프 체인(Markov chains)을 정의하기 위해 사용됩니다.[88] 확률적 행렬의 행은 현재 행에 해당하는 상태에 있는 일부 입자의 다음 위치에 대한 확률 분포를 제공합니다. 마르코프 체인-같은 흡수 상태(absorbing states), 즉 임의의 입자가 결국 도달하는 상태의 속성은 전이 행렬의 고유벡터에서 읽을 수 있습니다.[89]

통계는 역시 많은 다양한 형식에서 행렬을 사용합니다.[90] 기술 통계학(descriptive statistics)은 종종 데이터 행렬로 표현될 수 있는 데이터의 집합을 설명하는 것과 관련이 있으며, 차원 감소(dimensionality reduction) 기술을 적용할 수 있습니다. 공분산 행렬(covariance matrix)은 여러 확률 변수(random variables)의 상호 분산(variance)을 인코딩합니다.[91] 행렬을 사용하는 또 다른 기술은 선형 최소 제곱(linear least squares), 다음과 같은 선형 함수에 의해 (x1, y1), (x2, y2), ..., (xN, yN) 쌍의 유한 집합을 근사화하는 방법입니다:

- yi ≈ axi + b, i = 1, ..., N

이는 행렬의 특이 값 분해(singular value decomposition)와 관련된 행렬의 관점에서 공식화될 수 있습니다.[92]

확률 행렬(Random matrices)은 그 엔트리가 행렬 정규 분포(matrix normal distribution)와 같은 적절한 확률 분포(probability distributions)에 따르는 무작위 숫자인 행렬입니다. 확률 이론을 넘어, 그것들은 숫자 이론에서 물리학에 이르는 영역에 적용됩니다.[93][94]

Symmetries and transformations in physics

선형 변환과 관련된 대칭(symmetries)은 현대 물리학에서 중요한 역할을 합니다. 예를 들어, 양자 필드 이론(quantum field theory)에서 기본 입자(elementary particles)는 특수 상대성의 로렌츠 그룹(Lorentz group)의 표현과 보다 구체적으로, 스핀 그룹(spin group) 아래에서의 그것들의 행동에 따라 분류됩니다. 파울리 행렬(Pauli matrices)과 보다 일반적인 감마 행렬(gamma matrices)을 포함하는 구체적인 표현은 스피너(spinors)로 행동하는 페르미온(fermions)의 물리적 설명의 필수적인 부분입니다.[95] 세 개의 가장 가벼운 쿼크(quarks)에 대해, 특수 유니태리 그룹 SU(3)를 포함하는 그룹-이론적인 표현이 있습니다; 그것들의 계산을 위해, 물리학자들은 겔-맨 행렬(Gell-Mann matrices)로 알려진 편리한 행렬 표현을 사용하며, 이는 강한 핵 상호 작용, 양자 색역학(quantum chromodynamics)의 현대적인 설명의 기초를 형성하는 SU(3) 게이지 그룹(gauge group)에도 사용됩니다. 카비보-고바야시-마스카와 행렬(Cabibbo–Kobayashi–Maskawa matrix)은, 차례로, 약한 상호 작용(weak interactions)에 중요한 기본 쿼크 상태가 구체적이고 구별되는 질량(masses)을 갖는 입자를 정의하는 기본 쿼크 상태와 같지 않지만 선형적으로 관련되어 있다는 사실을 나타냅니다.[96]

Linear combinations of quantum states

양자 역학의 첫 번째 모델 (하이젠베르크, 1925)은 양자 상태에 동작하는 무한-차원 행렬에 의해 이론의 연산자를 표현했습니다.[97] 이것은 역시 행렬 역학(matrix mechanics)이라고 참조됩니다. 하나의 특별한 예제는 양자 시스템의 "혼합된" 상태를 기본적인 "순수한" 고유상태(eigenstates)의 선형 조합으로 특성화하는 밀도 행렬(density matrix)입니다.[98]

또 다른 행렬은 실험적 입자 물리학의 초석을 형성하는 산란 실험을 설명하기 위한 핵심 도구 역할을 합니다: 입자 가속기(particle accelerators)에서 발생하는 것과 같은 충돌 반응은, 여기서 비-상호 작용하는 입자가 서로를 향하고 결과로써 비-상호 작용하는 입자의 집합을 갖는 작은 상호 작용 영역에서 충돌하며, 나가는 입자 상태의 스칼라 곱과 들어오는 입자 상태의 선형 조합으로 설명될 수 있습니다. 선형 조합은 입자 사이의 가능한 상호 작용에 대한 모든 정보를 인코딩하는 S-행렬(S-matrix)로 알려진 행렬에 의해 제공됩니다.[99]

Normal modes

물리학에서 행렬의 일반적인 응용은 선형 결합 조화 시스템의 설명입니다. 그러한 시스템의 운동 방정식(equations of motion)은 질량 행렬에 일반화된 속도를 곱하여 운동 항을 제공하고, 힘(force) 행렬에 변위 벡터를 곱하여 상호 작용을 특성화하는 행렬 형식에서 설명될 수 있습니다. 해를 구하는 가장 좋은 방법은 행렬 방정식을 대각화함으로써 시스템의 고유벡터(eigenvectors), 그것의 정규 모드(normal modes)를 결정하는 것입니다. 이와 같은 기술은 분자의 내부 동역학: 상호 결합된 구성 요소 원자로 구성된 시스템의 내부 진동과 관련하여 매우 중요합니다.[100] 그것들은 기계적 진동과 전기 회로에서 진동을 설명하는 데에도 필요합니다.[101]

Geometrical optics

기하 광학(Geometrical optics)은 추가 매트릭스 응용을 제공합니다. 이 근사 이론에서, 빛의 파동 본성(wave nature)은 무시됩니다. 결과는 반직선(light rays)이 실제로 기하학적 반직선(geometrical rays)인 모델입니다. 광학 원소에 의한 빛의 편향이 작으면, 주어진 반직선에 대한 렌즈 또는 반사 원소의 동작은 반직선 전송 행렬 해석(ray transfer matrix analysis)이라는 2x2 행렬과 2-성분 벡터의 곱으로 표현될 수 있습니다: 벡터의 구성 요소는 반직선의 기울기와 광축으로부터의 거리이고, 반면에 행렬은 광학 원소의 속성을 인코딩합니다. 실제로, 두 종류의 행렬이 있으며, 즉, 렌즈 표면에서의 굴절을 설명하는 굴절 매트릭스 및 또 다른 굴절 행렬이 적용되는 다음 굴절 표면에 대한 참조 평면의 변환을 설명하는 평행이동 행렬이 있습니다. 렌즈 및/또는 반사 원소의 조합으로 구성된 광학 시스템은 구성 요소 행렬의 곱으로 인한 행렬로 간단히 설명됩니다.[102]

Electronics

전자 장치의 기존 메시 해석(mesh analysis) 및 노드 해석(nodal analysis)은 행렬로 설명될 수 있는 선형 방정식의 시스템으로 이어집니다.

많은 전자 부품의 행동은 행렬을 사용하여 설명될 수 있습니다. A를 부품의 입력 전압 v1과 입력 전류 i1을 원소로 하는 2-차원 벡터라고 놓고 B를 부품의 출력 전압 v2와 출력 전류 i2를 원소로 하는 2차원 벡터라고 놓습니다. 그런-다음 전자 부품의 행동은 B = H · A로 설명될 수 있으며, 여기서 H는 하나의 임피던스 원소 (h12), 하나의 어드미턴스 원소 (h21), 및 2개의 무차원 원소 (h11 및 h22)를 포함하는 2x2 행렬입니다. 회로 계산은 이제 행렬을 곱하는 것으로 축소됩니다.

History

행렬은 선형 방정식을 푸는 데 오랫동안 적용되어 왔지만 1800년대까지 배열로 알려져 있었습니다. 기원전 10–2세기에 쓰인 중국어 텍스트 The Nine Chapters on the Mathematical Art는 행렬식(determinants)의 개념을 포함하여 연립 방정식을 풀기 위해 배열의 방법을 사용한 첫 번째 예제입니다.[103] 1545년 이탈리아의 수학자 제롤라모 카르다노(Gerolamo Cardano)는 그가 Ars Magna를 출판하면서 유럽에 그 방법을 소개했습니다.[104] 일본 수학자 세키(Seki)는 1683년에 같은 배열 방법을 연립 방정식을 풀기 위해 사용했습니다.[105] 네덜란드 수학자 한 데 비츠(Jan de Witt)는 그의 1659년 저서 Elements of Curves (1659)에서 배열을 사용하여 변환을 표현했습니다.[106] 1700년에서 1710년 사이에 고트프리트 빌헬름 라이프니츠(Gottfried Wilhelm Leibniz)는 정보 또는 해를 기록하기 위한 배열의 사용을 출판했고 50개 이상의 서로 다른 배열 시스템을 실험했습니다.[104] 크라메르(Cramer)는 1750년에 자신의 규칙을 발표했습니다.

용어 "matrix" (라틴어로 "자궁", "댐" (번식을 위해 보관된 비인간 암컷 동물), "출처", "기원", "목록", "등록", mater-어머니에서 파생됨[107])가 1850년에 제임스 조지프 실베스터(James Joseph Sylvester)에 의해 만들어졌으며,[108] 그는 행렬을 오늘날 소행렬식(minors)이라고 불리는 여러 행렬식, 즉 열과 행을 제거하여 원래 행렬에서 파생되는 더 작은 행렬의 행렬식을 발생시키는 대상으로 이해했습니다. 1851년 논문에서, 실베스터는 다음과 같이 설명합니다:[109]

나는 이전 논문에서 "Matrix"를 항의 직사각형 배열로 정의했으며, 그 중에서 공통 부모의 자궁에서와 같이 다양한 행렬식의 시스템이 생성될 수 있습니다.

아서 케일리(Arthur Cayley)는 이전에 수행되어 온 것처럼 조사 중인 계수의 회전 버전이 아닌 행렬을 사용하여 기하학적 변환에 대한 논문을 발표했습니다. 대신, 그는 덧셈, 뺄셈, 곱셈, 및 나눗셈과 같은 연산을 그것들 행렬의 변환으로 정의하고 결합과 분배 속성이 참으로 유지됨을 보여주었습니다. 케일리는 행렬 곱셈의 비교환 속성과 행렬 덧셈의 교환 속성을 조사하고 입증했습니다.[104] 초기 행렬 이론은 배열의 사용을 행렬식에만 거의 독점적으로 제한했고, 케일리의 추상 행렬 연산은 혁명적이었습니다. 그는 방정식 시스템과 독립적인 행렬 개념을 제안하는 데 중요한 역할을 했습니다. 1858년 케일리는 케일리-해밀턴 정리(Cayley–Hamilton theorem)를 제안하고 시연한[104] 그의 A memoir on the theory of matrices을 출판했습니다.[110][111]

영국의 수학자 커스버트 에드먼드 컬리스(Cuthbert Edmund Cullis)는 1913년에 행렬에 대해 현대적인 대괄호 표기법을 처음으로 사용했고 그는 동시에 행렬을 나타내기 위해 표기법 A = [ai,j]의 첫 번째 중요한 사용을 시연했으며, 여기서 ai,j는 i-번째 행과 j-번째 열을 참조합니다.[104]

행렬식에 대한 현대 연구는 여러 출처에서 비롯되었습니다.[112] 숫자-이론적 문제로 인해 가우스(Gauss)는 이차 형식, 즉, x2 + xy − 2y2와 같은 표현의 계수와 3차원에서 선형 맵(linear maps)을 행렬과 연관시켰습니다. 아인슈타인(Eisenstein)은 이들 개념을 더욱 발전시켰는데, 현대적인 용어로 행렬 곱(matrix products)은 비-교환적이라는 설명을 포함합니다. 코시(Cauchy)는 행렬 A = [ai,j]의 행렬식 정의로 다음을 사용하여 행렬식에 대한 일반적인 명제를 처음으로 입증했습니다: 다항식에서 거듭제곱 를 ajk로 대체합니다:

- ,

여기서 Π는 표시된 항의 곱(product)을 나타냅니다. 그는 역시 1829년에 대칭 행렬의 고윳값(eigenvalues)이 실수임을 보여주었습니다.[113] 야코비(Jacobi)는 나중에 실베스터에 의해 야코비 행렬식이라고 불리는 "함수형 행렬식"을 연구했으며, 이는 지역적 (또는 무한소) 수준에서 기하학적 변환을 설명하기 위해 사용될 수 있으며, 위를 참조하십시오; 1903년에 출판된 크로네커(Kronecker)의 Vorlesungen über die Theorie der Determinanten[114] 및 바이어슈트라스(Weierstrass)의 Zur Determinantentheorie는[115], 둘 다 1903년에 출판되며, 언급된 코시 공식과 같은 이전의 보다 구체적인 접근 방식과 달리 먼저 행렬식을 공리적으로 처리했습니다. 그 시점에서, 행렬식이 확고하게 확립되었습니다.

많은 정리는 작은 행렬에 대해서만 처음으로 확립되었으며, 예를 들어, 코시-해밀턴 정리(Cayley–Hamilton theorem)는 앞서 언급한 회고록에서 코시에 의해 2×2 행렬에 대해, 그리고 해밀턴에 의해 4×4 행렬에 대해 입증되었습니다. 프로베니우스(Frobenius)는, 쌍선형 형식(bilinear forms)을 연구하여, 정리를 모든 차원으로 일반화했습니다 (1898). 역시 19세기 말에 빌헬름 요르단(Wilhelm Jordan)에 의해 가우스-요르단 소거법 (현재 가우스 소거법으로 알려진 특수한 경우를 일반화함)을 확립되었습니다. 20세기 초에, 행렬은 부분적으로 이전 세기의 초복소수 시스템의 분류에 사용되었기 때문에 선형 대수에서 중심적인 역할을 했습니다.[116]

하이젠베르크(Heisenberg), 보른(Born), 및 요르단(Jordan)에 의해 행렬 역학(matrix mechanics)의 개념이 시작되면서 무한하게 많은 행과 열을 갖는 행렬을 연구하게 되었습니다.[117] 나중에 폰 노이만(von Neumann)은 힐베르트 공간 위에 선형 연산자와 같은 함수형 해석적 개념을 추가로 개발함으로써 양자 역학의 수학적 형식화를 수행했으며, 이는, 매우 대략적으로 말하면, 유클리드 공간에 해당하지만, 무한대의 독립적인 방향을 가집니다.

Other historical usages of the word "matrix" in mathematics

그 단어는 역사적으로 중요한 적어도 두 명의 저자에 의해 특이한 방식으로 사용되어 왔습니다.

버트런드 러셀(Bertrand Russell)과 알프레드 노스 화이트헤드(Alfred North Whitehead)는 그들의 Principia Mathematica (1910–1913)에서 그들의 감소가능성의 공리(axiom of reducibility)의 맥락에서 "matrix"라는 단어를 사용합니다. 그들은 이 공리를 임의의 함수를 "바닥" (0 차수)에서 함수가 확장과 동일하도록 연속적으로 더 낮은 유형 중 하나로 감소시키는 수단으로 제안했습니다:[118]

변수가 아무리 많아도 임의의 명백한 변수를 포함하지 않는 임의의 함수에 matrix라는 이름을 지정해 보겠습니다. 그런-다음 matrix 이외의 임의의 가능한 함수는 일반화를 수단으로, 즉, 문제에서 함수가 모든 가능한 값 또는 인수 중 하나의 일부 값, 다른 인수 또는 미-결정으로 남아있는 인수가 참인 명제를 고려함으로써 matrix에서 파생됩니다.

예를 들어, 두 변수 x와 y의 함수 Φ(x, y)는 "개별" ai를 변수 x의 자리에 대체하여 모든 가능한 값에 대한 함수를 "고려"함으로써, 예를 들어, 단일 변수 y의 함수의 모음으로 축소될 수 있습니다. 그런-다음 단일 변수 y의 결과 함수의 모음, 즉, ∀ai: Φ(ai, y)는 "개별" bi를 변수 y의 자리에 대체하여 모든 가능한 값에 대한 함수를 "고려"함으로써 값의 "matrix"로 축소될 수 있습니다:

- ∀bj∀ai: Φ(ai, bj).

알프레트 타르스키(Alfred Tarski)는 그의 1946년 Introduction to Logic에서 "matrix"라는 단어를 수학적 논리에서 사용되는 진리 테이블의 개념과 동의어로 사용했습니다.[119]

See also

- List of named matrices

- Algebraic multiplicity

- Geometric multiplicity

- Gram–Schmidt process

- Irregular matrix

- Matrix calculus

- Matrix function

- Matrix multiplication algorithm

- Tensor — A generalization of matrices with any number of indices

Notes

- ^ However, in the case of adjacency matrices, matrix multiplication or a variant of it allows the simultaneous computation of the number of paths between any two vertices, and of the shortest length of a path between two vertices.

- ^ Lang 2002

- ^ Fraleigh (1976, p. 209)

- ^ Nering (1970, p. 37)

- ^ a b Weisstein, Eric W. "Matrix". mathworld.wolfram.com. Retrieved 2020-08-19.

- ^ Oualline 2003, Ch. 5

- ^ a b Pop; Furdui (2017). Square Matrices of Order 2. Springer International Publishing. ISBN 978-3-319-54938-5.

- ^ "How to organize, add and multiply matrices - Bill Shillito". TED ED. Retrieved April 6, 2013.

- ^ Brown 1991, Definition I.2.1 (addition), Definition I.2.4 (scalar multiplication), and Definition I.2.33 (transpose)

- ^ Brown 1991, Theorem I.2.6

- ^ a b "How to Multiply Matrices". www.mathsisfun.com. Retrieved 2020-08-19.

- ^ Brown 1991, Definition I.2.20

- ^ Brown 1991, Theorem I.2.24

- ^ Horn & Johnson 1985, Ch. 4 and 5

- ^ Bronson (1970, p. 16)

- ^ Kreyszig (1972, p. 220)

- ^ a b Protter & Morrey (1970, p. 869)

- ^ Kreyszig (1972, pp. 241, 244)

- ^ Schneider, Hans; Barker, George Phillip (2012), Matrices and Linear Algebra, Dover Books on Mathematics, Courier Dover Corporation, p. 251, ISBN 978-0-486-13930-2.

- ^ Perlis, Sam (1991), Theory of Matrices, Dover books on advanced mathematics, Courier Dover Corporation, p. 103, ISBN 978-0-486-66810-9.

- ^ Anton, Howard (2010), Elementary Linear Algebra (10th ed.), John Wiley & Sons, p. 414, ISBN 978-0-470-45821-1.

- ^ Horn, Roger A.; Johnson, Charles R. (2012), Matrix Analysis (2nd ed.), Cambridge University Press, p. 17, ISBN 978-0-521-83940-2.

- ^ Brown 1991, I.2.21 and 22

- ^ Greub 1975, Section III.2

- ^ Brown 1991, Definition II.3.3

- ^ Greub 1975, Section III.1

- ^ Brown 1991, Theorem II.3.22

- ^ Horn & Johnson 1985, Theorem 2.5.6

- ^ Brown 1991, Definition I.2.28

- ^ Brown 1991, Definition I.5.13

- ^ Horn & Johnson 1985, Chapter 7

- ^ Horn & Johnson 1985, Theorem 7.2.1

- ^ Horn & Johnson 1985, Example 4.0.6, p. 169

- ^ "Matrix | mathematics". Encyclopedia Britannica. Retrieved 2020-08-19.

- ^ Brown 1991, Definition III.2.1

- ^ Brown 1991, Theorem III.2.12

- ^ Brown 1991, Corollary III.2.16

- ^ Mirsky 1990, Theorem 1.4.1

- ^ Brown 1991, Theorem III.3.18

- ^ Eigen means "own" in German and in Dutch.

- ^ Brown 1991, Definition III.4.1

- ^ Brown 1991, Definition III.4.9

- ^ Brown 1991, Corollary III.4.10

- ^ Householder 1975, Ch. 7

- ^ Bau III & Trefethen 1997

- ^ Golub & Van Loan 1996, Algorithm 1.3.1

- ^ Golub & Van Loan 1996, Chapters 9 and 10, esp. section 10.2

- ^ Golub & Van Loan 1996, Chapter 2.3

- ^ Grcar, Joseph F. (2011-01-01). "John von Neumann's Analysis of Gaussian Elimination and the Origins of Modern Numerical Analysis". SIAM Review. 53 (4): 607–682. doi:10.1137/080734716. ISSN 0036-1445.

- ^ For example, Mathematica, see Wolfram 2003, Ch. 3.7

- ^ Press, Flannery & Teukolsky 1992

- ^ Stoer & Bulirsch 2002, Section 4.1

- ^ Horn & Johnson 1985, Theorem 2.5.4

- ^ Horn & Johnson 1985, Ch. 3.1, 3.2

- ^ Arnold & Cooke 1992, Sections 14.5, 7, 8

- ^ Bronson 1989, Ch. 15

- ^ Coburn 1955, Ch. V

- ^ Lang 2002, Chapter XIII

- ^ Lang 2002, XVII.1, p. 643

- ^ Lang 2002, Proposition XIII.4.16

- ^ Reichl 2004, Section L.2

- ^ Greub 1975, Section III.3

- ^ Greub 1975, Section III.3.13

- ^ See any standard reference in a group.

- ^ Additionally, the group must be closed in the general linear group.

- ^ Baker 2003, Def. 1.30

- ^ Baker 2003, Theorem 1.2

- ^ Artin 1991, Chapter 4.5

- ^ Rowen 2008, Example 19.2, p. 198

- ^ See any reference in representation theory or group representation.

- ^ See the item "Matrix" in Itõ, ed. 1987

- ^ "Not much of matrix theory carries over to infinite-dimensional spaces, and what does is not so useful, but it sometimes helps." Halmos 1982, p. 23, Chapter 5

- ^ "Empty Matrix: A matrix is empty if either its row or column dimension is zero", Glossary Archived 2009-04-29 at the Wayback Machine, O-Matrix v6 User Guide

- ^ "A matrix having at least one dimension equal to zero is called an empty matrix", MATLAB Data Structures Archived 2009-12-28 at the Wayback Machine

- ^ Fudenberg & Tirole 1983, Section 1.1.1

- ^ Manning 1999, Section 15.3.4

- ^ Ward 1997, Ch. 2.8

- ^ Stinson 2005, Ch. 1.1.5 and 1.2.4

- ^ Association for Computing Machinery 1979, Ch. 7

- ^ Godsil & Royle 2004, Ch. 8.1

- ^ Punnen 2002

- ^ Lang 1987a, Ch. XVI.6

- ^ Nocedal 2006, Ch. 16

- ^ Lang 1987a, Ch. XVI.1

- ^ Lang 1987a, Ch. XVI.5. For a more advanced, and more general statement see Lang 1969, Ch. VI.2

- ^ Gilbarg & Trudinger 2001

- ^ Šolin 2005, Ch. 2.5. See also stiffness method.

- ^ Latouche & Ramaswami 1999

- ^ Mehata & Srinivasan 1978, Ch. 2.8

- ^ Healy, Michael (1986), Matrices for Statistics, Oxford University Press, ISBN 978-0-19-850702-4

- ^ Krzanowski 1988, Ch. 2.2., p. 60

- ^ Krzanowski 1988, Ch. 4.1

- ^ Conrey 2007

- ^ Zabrodin, Brezin & Kazakov et al. 2006

- ^ Itzykson & Zuber 1980, Ch. 2

- ^ see Burgess & Moore 2007, section 1.6.3. (SU(3)), section 2.4.3.2. (Kobayashi–Maskawa matrix)

- ^ Schiff 1968, Ch. 6

- ^ Bohm 2001, sections II.4 and II.8

- ^ Weinberg 1995, Ch. 3

- ^ Wherrett 1987, part II

- ^ Riley, Hobson & Bence 1997, 7.17

- ^ Guenther 1990, Ch. 5

- ^ Shen, Crossley & Lun 1999 cited by Bretscher 2005, p. 1

- ^ a b c d e Discrete Mathematics 4th Ed. Dossey, Otto, Spense, Vanden Eynden, Published by Addison Wesley, October 10, 2001 ISBN 978-0-321-07912-1, p. 564-565

- ^ Needham, Joseph; Wang Ling (1959). Science and Civilisation in China. Vol. III. Cambridge: Cambridge University Press. p. 117. ISBN 978-0-521-05801-8.

- ^ Discrete Mathematics 4th Ed. Dossey, Otto, Spense, Vanden Eynden, Published by Addison Wesley, October 10, 2001 ISBN 978-0-321-07912-1, p. 564

- ^ Merriam-Webster dictionary, Merriam-Webster, retrieved April 20, 2009

- ^ Although many sources state that J. J. Sylvester coined the mathematical term "matrix" in 1848, Sylvester published nothing in 1848. (For proof that Sylvester published nothing in 1848, see: J. J. Sylvester with H. F. Baker, ed., The Collected Mathematical Papers of James Joseph Sylvester (Cambridge, England: Cambridge University Press, 1904), vol. 1.) His earliest use of the term "matrix" occurs in 1850 in J. J. Sylvester (1850) "Additions to the articles in the September number of this journal, "On a new class of theorems," and on Pascal's theorem," The London, Edinburgh, and Dublin Philosophical Magazine and Journal of Science, 37: 363-370. From page 369: "For this purpose, we must commence, not with a square, but with an oblong arrangement of terms consisting, suppose, of m lines and n columns. This does not in itself represent a determinant, but is, as it were, a Matrix out of which we may form various systems of determinants ... "

- ^ The Collected Mathematical Papers of James Joseph Sylvester: 1837–1853, Paper 37, p. 247

- ^ Phil.Trans. 1858, vol.148, pp.17-37 Math. Papers II 475-496

- ^ Dieudonné, ed. 1978, Vol. 1, Ch. III, p. 96

- ^ Knobloch 1994

- ^ Hawkins 1975

- ^ Kronecker 1897

- ^ Weierstrass 1915, pp. 271–286

- ^ Bôcher 2004

- ^ Mehra & Rechenberg 1987

- ^ Whitehead, Alfred North; and Russell, Bertrand (1913) Principia Mathematica to *56, Cambridge at the University Press, Cambridge UK (republished 1962) cf page 162ff.

- ^ Tarski, Alfred; (1946) Introduction to Logic and the Methodology of Deductive Sciences, Dover Publications, Inc, New York NY, ISBN 0-486-28462-X.

References

- Anton, Howard (1987), Elementary Linear Algebra (5th ed.), New York: Wiley, ISBN 0-471-84819-0

- Arnold, Vladimir I.; Cooke, Roger (1992), Ordinary differential equations, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-3-540-54813-3

- Artin, Michael (1991), Algebra, Prentice Hall, ISBN 978-0-89871-510-1

- Association for Computing Machinery (1979), Computer Graphics, Tata McGraw–Hill, ISBN 978-0-07-059376-3

- Baker, Andrew J. (2003), Matrix Groups: An Introduction to Lie Group Theory, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-1-85233-470-3

- Bau III, David; Trefethen, Lloyd N. (1997), Numerical linear algebra, Philadelphia, PA: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-361-9

- Beauregard, Raymond A.; Fraleigh, John B. (1973), A First Course In Linear Algebra: with Optional Introduction to Groups, Rings, and Fields, Boston: Houghton Mifflin Co., ISBN 0-395-14017-X

- Bretscher, Otto (2005), Linear Algebra with Applications (3rd ed.), Prentice Hall

- Bronson, Richard (1970), Matrix Methods: An Introduction, New York: Academic Press, LCCN 70097490

- Bronson, Richard (1989), Schaum's outline of theory and problems of matrix operations, New York: McGraw–Hill, ISBN 978-0-07-007978-6

- Brown, William C. (1991), Matrices and vector spaces, New York, NY: Marcel Dekker, ISBN 978-0-8247-8419-5

- Coburn, Nathaniel (1955), Vector and tensor analysis, New York, NY: Macmillan, OCLC 1029828

- Conrey, J. Brian (2007), Ranks of elliptic curves and random matrix theory, Cambridge University Press, ISBN 978-0-521-69964-8

- Fraleigh, John B. (1976), A First Course In Abstract Algebra (2nd ed.), Reading: Addison-Wesley, ISBN 0-201-01984-1

- Fudenberg, Drew; Tirole, Jean (1983), Game Theory, MIT Press

- Gilbarg, David; Trudinger, Neil S. (2001), Elliptic partial differential equations of second order (2nd ed.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-3-540-41160-4

- Godsil, Chris; Royle, Gordon (2004), Algebraic Graph Theory, Graduate Texts in Mathematics, vol. 207, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-95220-8

- Golub, Gene H.; Van Loan, Charles F. (1996), Matrix Computations (3rd ed.), Johns Hopkins, ISBN 978-0-8018-5414-9

- Greub, Werner Hildbert (1975), Linear algebra, Graduate Texts in Mathematics, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-90110-7

- Halmos, Paul Richard (1982), A Hilbert space problem book, Graduate Texts in Mathematics, vol. 19 (2nd ed.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-90685-0, MR 0675952

- Horn, Roger A.; Johnson, Charles R. (1985), Matrix Analysis, Cambridge University Press, ISBN 978-0-521-38632-6

- Householder, Alston S. (1975), The theory of matrices in numerical analysis, New York, NY: Dover Publications, MR 0378371

- Kreyszig, Erwin (1972), Advanced Engineering Mathematics (3rd ed.), New York: Wiley, ISBN 0-471-50728-8.

- Krzanowski, Wojtek J. (1988), Principles of multivariate analysis, Oxford Statistical Science Series, vol. 3, The Clarendon Press Oxford University Press, ISBN 978-0-19-852211-9, MR 0969370

- Itô, Kiyosi, ed. (1987), Encyclopedic dictionary of mathematics. Vol. I-IV (2nd ed.), MIT Press, ISBN 978-0-262-09026-1, MR 0901762

- Lang, Serge (1969), Analysis II, Addison-Wesley

- Lang, Serge (1987a), Calculus of several variables (3rd ed.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-96405-8

- Lang, Serge (1987b), Linear algebra, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-96412-6

- Lang, Serge (2002), Algebra, Graduate Texts in Mathematics, vol. 211 (Revised third ed.), New York: Springer-Verlag, ISBN 978-0-387-95385-4, MR 1878556

- Latouche, Guy; Ramaswami, Vaidyanathan (1999), Introduction to matrix analytic methods in stochastic modeling (1st ed.), Philadelphia, PA: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-425-8

- Manning, Christopher D.; Schütze, Hinrich (1999), Foundations of statistical natural language processing, MIT Press, ISBN 978-0-262-13360-9

- Mehata, K. M.; Srinivasan, S. K. (1978), Stochastic processes, New York, NY: McGraw–Hill, ISBN 978-0-07-096612-3

- Mirsky, Leonid (1990), An Introduction to Linear Algebra, Courier Dover Publications, ISBN 978-0-486-66434-7

- Nering, Evar D. (1970), Linear Algebra and Matrix Theory (2nd ed.), New York: Wiley, LCCN 76-91646

- Nocedal, Jorge; Wright, Stephen J. (2006), Numerical Optimization (2nd ed.), Berlin, DE; New York, NY: Springer-Verlag, p. 449, ISBN 978-0-387-30303-1

- Oualline, Steve (2003), Practical C++ programming, O'Reilly, ISBN 978-0-596-00419-4

- Press, William H.; Flannery, Brian P.; Teukolsky, Saul A.; Vetterling, William T. (1992), "LU Decomposition and Its Applications" (PDF), Numerical Recipes in FORTRAN: The Art of Scientific Computing (2nd ed.), Cambridge University Press, pp. 34–42, archived from the original on 2009-09-06

{{citation}}: CS1 maint: unfit URL (link) - Protter, Murray H.; Morrey, Charles B. Jr. (1970), College Calculus with Analytic Geometry (2nd ed.), Reading: Addison-Wesley, LCCN 76087042

- Punnen, Abraham P.; Gutin, Gregory (2002), The traveling salesman problem and its variations, Boston, MA: Kluwer Academic Publishers, ISBN 978-1-4020-0664-7

- Reichl, Linda E. (2004), The transition to chaos: conservative classical systems and quantum manifestations, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-98788-0

- Rowen, Louis Halle (2008), Graduate Algebra: noncommutative view, Providence, RI: American Mathematical Society, ISBN 978-0-8218-4153-2

- Šolin, Pavel (2005), Partial Differential Equations and the Finite Element Method, Wiley-Interscience, ISBN 978-0-471-76409-0

- Stinson, Douglas R. (2005), Cryptography, Discrete Mathematics and its Applications, Chapman & Hall/CRC, ISBN 978-1-58488-508-5

- Stoer, Josef; Bulirsch, Roland (2002), Introduction to Numerical Analysis (3rd ed.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-95452-3

- Ward, J. P. (1997), Quaternions and Cayley numbers, Mathematics and its Applications, vol. 403, Dordrecht, NL: Kluwer Academic Publishers Group, doi:10.1007/978-94-011-5768-1, ISBN 978-0-7923-4513-8, MR 1458894

- Wolfram, Stephen (2003), The Mathematica Book (5th ed.), Champaign, IL: Wolfram Media, ISBN 978-1-57955-022-6

Physics references

- Bohm, Arno (2001), Quantum Mechanics: Foundations and Applications, Springer, ISBN 0-387-95330-2

- Burgess, Cliff; Moore, Guy (2007), The Standard Model. A Primer, Cambridge University Press, ISBN 978-0-521-86036-9

- Guenther, Robert D. (1990), Modern Optics, John Wiley, ISBN 0-471-60538-7

- Itzykson, Claude; Zuber, Jean-Bernard (1980), Quantum Field Theory, McGraw–Hill, ISBN 0-07-032071-3

- Riley, Kenneth F.; Hobson, Michael P.; Bence, Stephen J. (1997), Mathematical methods for physics and engineering, Cambridge University Press, ISBN 0-521-55506-X

- Schiff, Leonard I. (1968), Quantum Mechanics (3rd ed.), McGraw–Hill

- Weinberg, Steven (1995), The Quantum Theory of Fields. Volume I: Foundations, Cambridge University Press, ISBN 0-521-55001-7

- Wherrett, Brian S. (1987), Group Theory for Atoms, Molecules and Solids, Prentice–Hall International, ISBN 0-13-365461-3

- Zabrodin, Anton; Brezin, Édouard; Kazakov, Vladimir; Serban, Didina; Wiegmann, Paul (2006), Applications of Random Matrices in Physics (NATO Science Series II: Mathematics, Physics and Chemistry), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-1-4020-4530-1

Historical references

- A. Cayley A memoir on the theory of matrices. Phil. Trans. 148 1858 17-37; Math. Papers II 475-496

- Bôcher, Maxime (2004), Introduction to higher algebra, New York, NY: Dover Publications, ISBN 978-0-486-49570-5, reprint of the 1907 original edition

- Cayley, Arthur (1889), The collected mathematical papers of Arthur Cayley, vol. I (1841–1853), Cambridge University Press, pp. 123–126

- Dieudonné, Jean, ed. (1978), Abrégé d'histoire des mathématiques 1700-1900, Paris, FR: Hermann

- Hawkins, Thomas (1975), "Cauchy and the spectral theory of matrices", Historia Mathematica, 2: 1–29, doi:10.1016/0315-0860(75)90032-4, ISSN 0315-0860, MR 0469635

- Knobloch, Eberhard (1994), "From Gauss to Weierstrass: determinant theory and its historical evaluations", The intersection of history and mathematics, Science Networks Historical Studies, vol. 15, Basel, Boston, Berlin: Birkhäuser, pp. 51–66, MR 1308079

- Kronecker, Leopold (1897), Hensel, Kurt (ed.), Leopold Kronecker's Werke, Teubner

- Mehra, Jagdish; Rechenberg, Helmut (1987), The Historical Development of Quantum Theory (1st ed.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-96284-9

- Shen, Kangshen; Crossley, John N.; Lun, Anthony Wah-Cheung (1999), Nine Chapters of the Mathematical Art, Companion and Commentary (2nd ed.), Oxford University Press, ISBN 978-0-19-853936-0

- Weierstrass, Karl (1915), Collected works, vol. 3

Further reading

- "Matrix", Encyclopedia of Mathematics, EMS Press, 2001 [1994]

- Kaw, Autar K. (September 2008), Introduction to Matrix Algebra, ISBN 978-0-615-25126-4

- The Matrix Cookbook (PDF), retrieved 24 March 2014

- Brookes, Mike (2005), The Matrix Reference Manual, London: Imperial College, retrieved 10 Dec 2008

External links

- An excellent online matrix calculator that displays the intermediate steps

- MacTutor: Matrices and determinants

- Matrices and Linear Algebra on the Earliest Uses Pages

- Earliest Uses of Symbols for Matrices and Vectors

![{\displaystyle \mathbf {A} =\left(a_{ij}\right),\quad \left[a_{ij}\right],\quad {\text{or}}\quad \left(a_{ij}\right)_{1\leq i\leq m,\;1\leq j\leq n}}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/bfc2e9990806f2830d7a3865e6adb451a66e546c)

![{\displaystyle A[i,j]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/c1a9bfca6057f52b4e5c3844ecd704962b7e426c)

![{\displaystyle A[1,3]}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/e981f00d688ae0001b8c463f70e4ad8488002d53)

![{\displaystyle [\mathbf {AB} ]_{i,j}=a_{i,1}b_{1,j}+a_{i,2}b_{2,j}+\cdots +a_{i,n}b_{n,j}=\sum _{r=1}^{n}a_{i,r}b_{r,j},}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/c903c2c14d249005ce9ebaa47a8d6c6710c1c29e)

![{\displaystyle H(f)=\left[{\frac {\partial ^{2}f}{\partial x_{i}\,\partial x_{j}}}\right].}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/9cf91a060a82dd7a47c305e9a4c2865378fcf35f)

![{\displaystyle J(f)=\left[{\frac {\partial f_{i}}{\partial x_{j}}}\right]_{1\leq i\leq m,1\leq j\leq n}.}](https://dawoum.duckdns.org/api/rest_v1/media/math/render/svg/bdbd42114b895c82930ea1e229b566f71fd6b07d)